Jeśli chodzi o przetwarzanie danych mózgowych, najważniejszy jest czas. W ten sposób neurony łączą się w obwody. W ten sposób obwody te przetwarzają bardzo złożone dane, co prowadzi do działań, które mogą oznaczać życie lub śmierć. W ten sposób nasze mózgi mogą podejmować decyzje w ułamku sekundy, nawet w obliczu zupełnie nowych okoliczności. I robimy to bez smażenia mózgu na skutek nadmiernego zużycia energii.

Mówiąc inaczej, mózg jest doskonałym przykładem niezwykle potężnego komputera, który można naśladować, a informatycy i inżynierowie podjęli pierwsze kroki w tym kierunku. W dziedzinie obliczeń neuromorficznych dąży się do odtworzenia architektury mózgu i możliwości przetwarzania danych za pomocą nowatorskich chipów sprzętowych i algorytmów oprogramowania. Może to być droga do prawdy sztuczna inteligencja.

Brakuje jednak jednego istotnego elementu. Większość algorytmów obsługujących chipy neuromorficzne dba jedynie o wkład każdego sztucznego neuronu – to znaczy o to, jak silnie się one ze sobą łączą, co nazywa się „wagą synaptyczną”. To, czego brakuje – choć jest to równoznaczne z wewnętrzną pracą naszego mózgu – to wyczucie czasu.

W tym miesiącu zespół powiązany z Human Brain Project, sztandarowym przedsięwzięciem Unii Europejskiej w dziedzinie neuronauki dużych zbiorów danych, dodał element czasu do algorytmu neuromorficznego. Wyniki zostały następnie zaimplementowane na sprzęcie fizycznym — tzw Skala MózguS-2 platformę neuromorficzną – i skonfrontowaną z najnowocześniejszymi procesorami graficznymi i konwencjonalnymi rozwiązaniami neuromorficznymi.

„W porównaniu z abstrakcyjnymi sieciami neuronowymi stosowanymi w głębokim uczeniu się, bardziej biologiczne archetypy… wciąż pozostają w tyle pod względem wydajności i skalowalności” ze względu na ich wrodzoną złożoność – stwierdzili autorzy.

W kilku testach algorytm porównał „korzystnie pod względem dokładności, opóźnienia i efektywności energetycznej” w standardowym teście porównawczym, powiedziany Dr Charlotte Frenkel z Uniwersytetu w Zurychu i ETH Zurich w Szwajcarii, która nie brała udziału w badaniu. Dodając komponent czasowy do obliczeń neuromorficznych, moglibyśmy zapoczątkować nową erę wysoce wydajnej sztucznej inteligencji, która przechodzi od zadań związanych z danymi statycznymi – powiedzmy rozpoznawania obrazu – do takiej, która lepiej oddaje czas. Pomyśl o filmach, biosygnałach lub mowie przesyłanej między mózgiem a komputerem.

Według głównego autora, dr Mihai Petrovici, potencjał działa w obie strony. „Nasza praca jest interesująca nie tylko w zakresie obliczeń neuromorficznych i sprzętu inspirowanego biologią. Uznaje także zapotrzebowanie… na przeniesienie tak zwanego podejścia do głębokiego uczenia się do neuronauki, a tym samym na dalsze odkrywanie tajemnic ludzkiego mózgu” – stwierdził. powiedziany.

Porozmawiajmy o Spikach

U podstaw nowego algorytmu leży podstawowa zasada przetwarzania mózgu: skoki.

Przyjrzyjmy się wysoce abstrakcyjnemu neuronowi. Przypomina bułkę tootsie z bulwiastą częścią środkową otoczoną dwoma wystającymi na zewnątrz owijkami. Jedna strona to wejście – skomplikowane drzewo, które odbiera sygnały z poprzedniego neuronu. Drugi to sygnał wyjściowy, wysyłający sygnały do innych neuronów za pomocą przypominających bańki statków wypełnionych chemikaliami, co z kolei wyzwala reakcję elektryczną po stronie odbiorczej.

Oto sedno: aby cała sekwencja mogła nastąpić, neuron musi „przeskoczyć”. Jeśli i tylko wtedy neuron otrzyma wystarczająco wysoki poziom sygnału wejściowego – ładnie wbudowany mechanizm redukcji szumów – część bulwiasta wygeneruje impuls, który przemieszcza się wzdłuż kanałów wyjściowych, aby zaalarmować następny neuron.

Ale neurony nie wykorzystują tylko jednego impulsu do przekazywania informacji. Raczej rosną w sekwencji czasowej. Pomyśl o tym jak o alfabecie Morse’a: moment wystąpienia wybuchu elektrycznego niesie ze sobą mnóstwo danych. Stanowi podstawę łączenia neuronów w obwody i hierarchie, umożliwiając wysoce energooszczędne przetwarzanie.

Dlaczego więc nie przyjąć tej samej strategii dla komputerów neuromorficznych?

Spartański chip przypominający mózg

Zamiast mapować impulsy pojedynczego sztucznego neuronu – co było herkulesowym zadaniem – zespół skupił się na jednym mierniku: czasie potrzebnym do zadziałania neuronu.

Idea kodu „czas do pierwszego szczytu” jest prosta: im dłużej neuron potrzebuje impulsu, tym niższy jest poziom jego aktywności. W porównaniu z impulsami liczenia jest to niezwykle rzadki sposób kodowania aktywności neuronu, ale ma zalety. Ponieważ do kodowania aktywacji wykorzystywane jest tylko opóźnienie do pierwszego uruchomienia się neuronu, rejestruje on reakcję neuronu bez obciążania komputera zbyt dużą liczbą punktów danych. Innymi słowy, jest szybki, energooszczędny i łatwy.

Następnie zespół zakodował algorytm w chipie neuromorficznym – tzw Skala MózguS-2, który z grubsza emuluje w swojej strukturze proste „neurony”, ale działa ponad 1,000 razy szybciej niż nasze biologiczne mózgi. Platforma zawiera ponad 500 fizycznych sztucznych neuronów, z których każdy może odbierać 256 sygnałów wejściowych za pośrednictwem konfigurowalnych synaps, w których neurony biologiczne wymieniają się, przetwarzają i przechowują informacje.

Konfiguracja jest hybrydowa. „Uczenie się” odbywa się na chipie, który implementuje algorytm zależny od czasu. Jednak wszelkie aktualizacje obwodu neuronowego – czyli to, jak mocno jeden neuron łączy się z drugim – są uzyskiwane za pośrednictwem zewnętrznej stacji roboczej, co nazywa się „treningiem w pętli”.

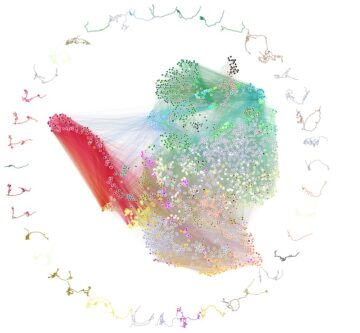

W pierwszym teście algorytm stanął przed zadaniem „Yin-Yang”, które wymagało od algorytmu przeanalizowania różnych obszarów tradycyjnego symbolu wschodniego. Algorytm wyróżniał się, osiągając średnio 95-procentową dokładność.

Następnie zespół rzucił wyzwanie konfiguracji, wykonując klasyczne zadanie głębokiego uczenia się —MNIST, zbiór danych składający się z odręcznych liczb, który zrewolucjonizował widzenie komputerowe. Algorytm ponownie spisał się znakomicie, osiągając niemal 97-procentową dokładność. Co jeszcze bardziej imponujące, system BrainScaleS-2 potrzebował mniej niż jednej sekundy na sklasyfikowanie 10,000 XNUMX próbek testowych przy wyjątkowo niskim względnym zużyciu energii.

Umieszczając te wyniki w kontekście, zespół następnie porównał wydajność BrainScaleS-2 – wyposażonego w nowy algorytm – z platformami komercyjnymi i innymi platformami neuromorficznymi. Brać Spinaker, masywna, równolegle rozproszona architektura, która naśladuje również obliczenia neuronowe i skoki. Nowy algorytm był ponad 100 razy szybszy w rozpoznawaniu obrazu, zużywając zaledwie ułamek energii zużywanej przez SpiNNaker. Podobne wyniki zaobserwowano w przypadku True North, zwiastuna neuromorficznego chipa IBM.

Co dalej?

Dwie najcenniejsze funkcje obliczeniowe mózgu — efektywność energetyczna i przetwarzanie równoległe — stanowią obecnie silną inspirację dla następnej generacji chipów komputerowych. Cel? Buduj maszyny tak samo elastyczne i adaptacyjne jak nasz mózg, zużywając zaledwie ułamek energii wymaganej przez nasze obecne chipy na bazie krzemu.

Jednak w porównaniu z głębokim uczeniem się, które opiera się na sztucznych sieciach neuronowych, rozwiązania biologicznie wiarygodne straciły na znaczeniu. Częścią tego, wyjaśnił Frenkel, jest trudność w „aktualizowaniu” tych obwodów poprzez uczenie się. Jednak dzięki BrainScaleS-2 i odrobinie danych dotyczących czasu jest to teraz możliwe.

Jednocześnie posiadanie „zewnętrznego” arbitra do aktualizacji połączeń synaptycznych daje całemu systemowi trochę czasu na oddychanie. Sprzęt neuromorficzny, podobny do bałaganu w obliczeniach naszego mózgu, jest pełen niedopasowań i błędów. Dzięki chipowi i zewnętrznemu arbitrowi cały system może nauczyć się dostosowywać do tej zmienności i ostatecznie kompensować – lub nawet wykorzystywać – swoje dziwactwa w celu szybszego i bardziej elastycznego uczenia się.

Dla Frenkla siła algorytmu leży w jego rzadkości. Wyjaśniła, że mózg napędzany jest rzadkimi kodami, które „mogą wyjaśnić szybki czas reakcji… na przykład w przypadku przetwarzania wizualnego”. Zamiast aktywować całe obszary mózgu, potrzebnych jest tylko kilka sieci neuronowych – na przykład śmiganie pustymi autostradami zamiast tkwienia w korkach w godzinach szczytu.

Pomimo swojej mocy, algorytm nadal ma czkawkę. Ma problemy z interpretacją danych statycznych, choć doskonale radzi sobie z sekwencjami czasowymi – na przykład mową czy biosygnałami. Jednak dla Frenkla jest to początek nowych ram: ważne informacje można zakodować za pomocą elastycznej, ale prostej metryki i uogólnić, aby wzbogacić przetwarzanie danych w oparciu o mózg i sztuczną inteligencję przy ułamku tradycyjnych kosztów energii.

„[To]… może być ważnym krokiem w kierunku udoskonalenia sprzętu neuromorficznego, aby w końcu wykazać przewagę konkurencyjną nad konwencjonalnymi podejściami do sieci neuronowych” – stwierdziła.

Zdjęcie: Klasyfikacja punktów danych w zbiorze danych Yin-Yang, autorstwa Göltza i Kriener et al. (Heidelberg / Berno)

- 000

- 100

- Korzyść

- AI

- algorytm

- Algorytmy

- Pozwalać

- architektura

- sztuczne sieci neuronowe

- Autorzy

- Benchmark

- Big Data

- mózg

- budować

- który

- kanały

- chemikalia

- żeton

- Frytki

- kod

- handlowy

- składnik

- Wizja komputerowa

- komputery

- computing

- połączenia

- konsumpcja

- Koszty:

- kredyt

- Aktualny

- dane

- analiza danych

- głęboka nauka

- Kreowanie

- wschodni

- efektywność

- energia

- Inżynierowie

- ETH.

- ETH Zurich

- europejski

- FAST

- W końcu

- natura

- i terminów, a

- pierwszy raz

- Framework

- GPU

- sprzęt komputerowy

- Wysoki

- autostrady

- W jaki sposób

- HTTPS

- Hybrydowy

- IBM

- pomysł

- obraz

- Rozpoznawanie obrazu

- Informacja

- zaangażowany

- IT

- prowadzić

- prowadzący

- UCZYĆ SIĘ

- nauka

- poziom

- długo

- maszyny

- porusza się

- sieć

- sieci

- Nerwowy

- sieci neuronowe

- sieci neuronowe

- Neuroscience

- Hałas

- Północ

- z naszej

- Inne

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- fizyczny

- Platforma

- Platformy

- power

- projekt

- reakcja

- odpowiedź

- Efekt

- Rolka

- pędzić

- Naukowcy

- statki

- Prosty

- So

- Tworzenie

- Rozwiązania

- początek

- sklep

- Strategia

- Badanie

- Szwajcaria

- system

- test

- Testy

- czas

- Kontakt

- ruch drogowy

- Trening

- uniwersytet

- Nowości

- Filmy

- wizja

- Bogactwo

- KIM

- Wikipedia

- Drut

- słowa

- Praca

- Zurych