Comentário Mais de 250 tiroteios em massa ocorreram nos EUA até agora este ano, e os defensores da IA acham que têm a solução. Não é controle de armas, mas tecnologia melhor, sem surpresa.

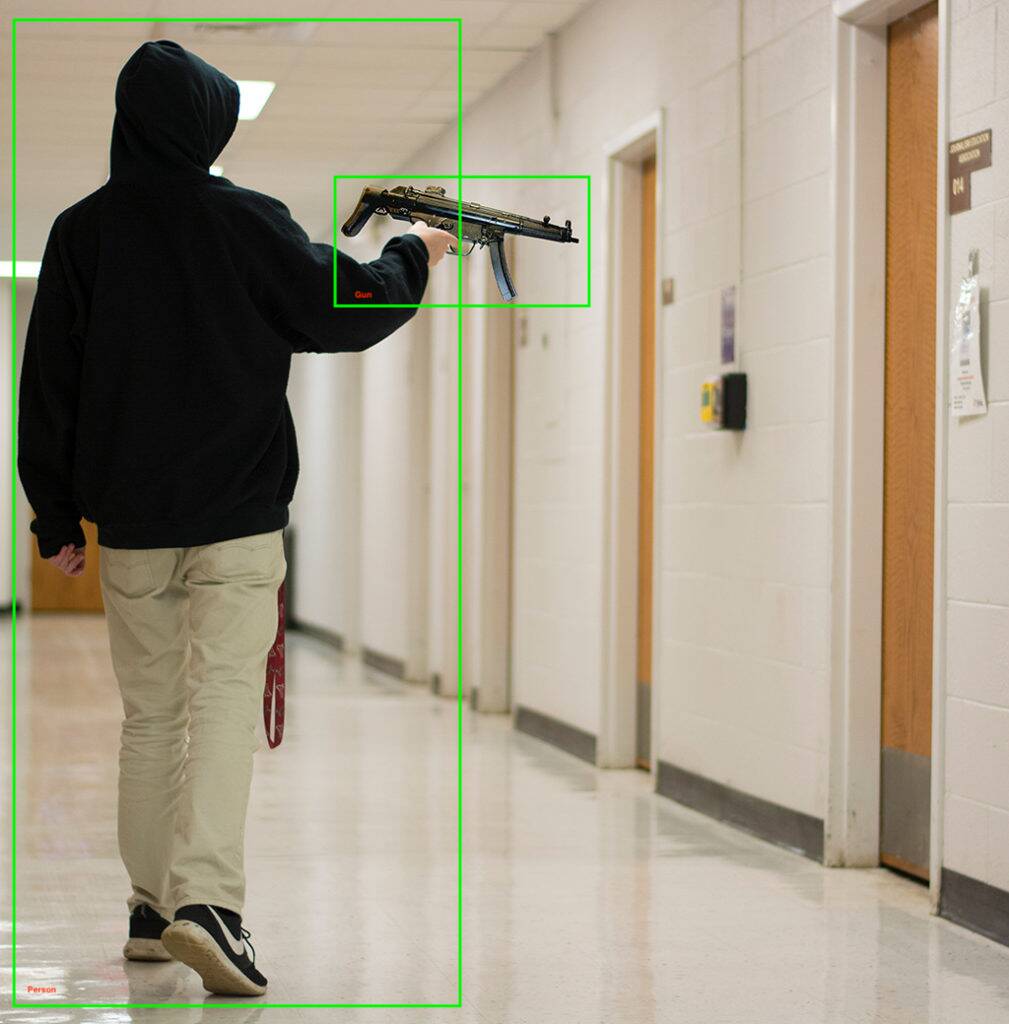

A empresa de aprendizado de máquina Kogniz anunciou na terça-feira que estava adicionando um modelo de detecção de arma à sua plataforma de visão computacional. O sistema, nos dizem, pode detectar armas vistas por câmeras de segurança e enviar notificações para aqueles em risco, notificando a polícia, trancando prédios e realizando outras tarefas de segurança.

Além de detectar armas de fogo, o Kogniz usa seus outros módulos de visão computacional para perceber comportamentos incomuns, como crianças correndo por corredores ou alguém subindo por uma janela, o que pode indicar um atirador ativo.

Se você está se perguntando sobre o falso positivo ou a taxa de erro do código, Kogniz diz que tem uma “IA multi-pass” e “uma equipe treinada de verificadores humanos” verificando os resultados de seu software de detecção. Ou você dá as boas-vindas a esse nível extra de confirmação, ou vê isso como uma tecnologia potencialmente voltando aos humanos exatamente quando os computadores são mais necessários.

“[Nossa solução] está tornando muito mais fácil para empresas, agências governamentais, escolas e hospitais se prepararem e ajudarem a reduzir os danos causados por um evento de atirador ativo”, disse Daniel Putterman, CEO da Kogniz.

A Kogniz não é a primeira empresa de visão computacional a entrar no jogo de reconhecimento de armas – há uma lista considerável de empresas que implantam tecnologia semelhante e algumas, como a ZeroEyes, se especializam em nada além de detecção de armas de fogo.

“Ao espalhar sua atenção por várias ofertas, os desenvolvedores são menos capazes de fornecer o melhor serviço em detecção de armas”, disse ZeroEyes em um relatório. no blog. A tecnologia da ZeroEyes foi implantada em escolas em 14 estados, incluindo Escola secundária de Oxford na região metropolitana de Detroit, onde um atirador de 15 anos matou quatro e feriu sete no ano passado.

Outros fornecedores – como a Defendry, que possui um conjunto de segurança que inclui um aplicativo de botão de pânico, sensores de tiro de áudio, drones de primeira resposta e IA de detecção de armas; e Omnilert – estão neste mercado de crescimento deprimente. Outras empresas no campo de detecção de armas de IA incluem Arcarith, Athena Securities e Scylla.

Existe realmente tempo suficiente?

Em 2019, a resposta da polícia a um tiroteio em massa em Dayton, Ohio, foi de apenas 32 segundos, durante os quais nove pessoas morreram. Um tiroteio em 2021 em uma instalação da FedEx em Indianápolis que matou nove pessoas também terminou antes que os policiais pudessem chegar, mesmo que o fizessem em apenas alguns minutos.

Ambos os casos levantam a questão de saber se a detecção de armas de IA pode reduzir os tempos de resposta o suficiente para salvar vidas. Especialmente se os policiais estiverem com muito medo ou optarem por não responder, como no assassinato em massa em Uvalde.

Vários outros métodos de prevenção de tiro em massa baseados em IA foram propostos, como armas inteligentes que não irá disparar se detectar um alvo humano. Outros propuseram treinar IAs com dados de tiroteios anteriores, compras locais de armas e dados socioeconômicos para encontrar tendências indicativas de um tiroteio planejado, bem como escanear as mídias sociais em busca de indicadores semelhantes.

Há também Viés de AI, um problema bem documentado que mesmo conjuntos de dados diversos e treinamento equilibrado não consigo resolver. Faça uma implantação em 2020 de tecnologia de reconhecimento facial e de armas em um distrito escolar de Nova York: e-mails entre o distrito escolar e a empresa que implantou o sistema mostram preocupações sobre isso comumente identificando erroneamente coisas, como cabos de vassoura para armas.

Falando à publicação de Utah Deseret News, o analista sênior de políticas da ACLU Jay Stanley dito ele estava preocupado que os sistemas de visão computacional pudessem levar a um mundo “onde as pessoas evitassem fazer algo tão simples quanto pular na calçada por medo de acionar detectores de anomalias e serem interrogados pela polícia”.

Um possível uso da IA pode ser mais promissor: um 2018 estudo do Cincinnati Children's Hospital Medical Center descobriu que a análise de IA das sessões de terapia concordou com as avaliações de perigo de psiquiatras e conselheiros em 91% das vezes. A adição de dados demográficos e socioeconômicos só melhorou os resultados na identificação de jovens em risco de cometer um ato violento.

Com tantas complicações potenciais, o aprendizado de máquina está realmente pronto para evitar assassinatos em massa?

A violência armada é o assassino número um de crianças e adolescentes nos Estados Unidos, tirando uma média de 12 vidas jovens e ferindo mais 32, a cada dia. A IA pode ajudar, mas sem abordar suas deficiências, talvez também sejam necessárias abordagens menos tecnológicas. Cuidados de saúde mental mais fortes e amplamente disponíveis podem ser um bom começo.

No início deste mês, o presidente Biden chamado para, entre outras coisas, uma proibição de armas de assalto, verificações de antecedentes ampliadas e limites na capacidade do compartimento, que ele chamou de “medidas racionais e de bom senso”. ®

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- O registro

- zefirnet