Lei de Goodhart famosamente diz: “Quando uma medida se torna um alvo, deixa de ser uma boa medida”. Embora originalmente da economia, é algo com o qual temos que lidar na OpenAI ao descobrir como otimizar objetivos que são difíceis ou caros de medir. Muitas vezes é necessário introduzir alguns objetivo proxy isso é mais fácil ou mais barato de medir, mas quando fazemos isso, precisamos ter cuidado para não otimizá-lo demais.

Por exemplo, como parte do nosso trabalho de alinhar modelos como GPT-3 com intenção e valores humanos, gostaríamos de otimizar coisas como “Como útil é esta resposta?”, ou “Como realmente preciso é esta afirmação?”. Esses são objetivos complexos que exigem que os humanos verifiquem cuidadosamente as coisas. Por isso, treinamos um modelo para prever essas preferências humanas, conhecido como modelo de recompensa, e use as previsões do modelo de recompensa como um objetivo de proxy. Mas é importante acompanhar o quão bem o verdadeiro objetivo está sendo otimizado.

Neste post, veremos um pouco da matemática por trás de como fazemos isso. Vamos nos concentrar em um cenário particularmente limpo para analisar, no qual temos acesso ao verdadeiro objetivo. Na prática, até mesmo as preferências humanas podem não medir o que realmente nos importa, mas estamos deixando essa questão de lado neste post.

Amostragem melhor de $n$

Existem muitas maneiras de otimizar o objetivo do proxy, mas talvez a mais simples seja melhor de $n$ amostragem, também conhecido como amostragem de rejeição or reclassificação. Nós simplesmente amostramos $n$ vezes e pegamos aquele que pontuar mais alto de acordo com o objetivo do proxy.

Embora esse método seja muito simples, ele pode realmente ser competitivo com técnicas mais avançadas, como aprendizado por reforço, embora ao custo de mais computação de tempo de inferência. Por exemplo, em WebGPT, nosso modelo melhor de $64$ superou nosso modelo de aprendizado por reforço, talvez em parte porque o modelo melhor de $64$ conseguiu navegar em muitos outros sites. Mesmo aplicar o melhor de $4$ proporcionou um impulso significativo para as preferências humanas.

Além disso, a amostragem melhor de $n$ tem desempenho confiável e é simples de analisar matematicamente, tornando-a adequada para estudos empíricos da lei de Goodhart e fenômenos relacionados.

A matemática da amostragem melhor de $n$

Vamos estudar a amostragem melhor de $n$ mais formalmente. Suponha que tenhamos algum espaço amostral $S$ (como o conjunto de possíveis pares pergunta-resposta), alguma distribuição de probabilidade $P$ sobre $S$, um verdadeiro objetivo (ou “recompensa”) $R_{text{true}}:Estômago R$, e um objetivo proxy $R_{text{proxy}}:Estômago R$. Digamos que de alguma forma otimizamos $R_{text{proxy}}$ e assim obtemos alguma nova distribuição $P^principal$. Então:

- A expectativa $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ mede quão bem otimizamos o verdadeiro objetivo.

- A Divergência KL $D_{text{KL}}left(P^primeparallel Pright)$ mede quanta otimização fizemos. Por exemplo, se $P^prime$ é obtido tomando a primeira amostra de $P$ que está em algum subconjunto $S^primesubseteq S$, então essa divergência KL é apenas a probabilidade logarítmica negativa de que uma amostra de $P$ esteja em $S^prime$.

Acontece que, no caso da amostragem melhor de $n$, ambas as quantidades podem ser estimadas eficientemente usando amostras de $P$.

Vejamos primeiro a expectativa. A abordagem ingênua é usar um estimador de Monte Carlo: execute a amostragem best-of-$n$ muitas vezes, meça o verdadeiro objetivo nessas amostras e calcule a média dos resultados. No entanto, existe um estimador melhor. Se tivermos $Ngeq n$ amostras de $P$ em geral, podemos considerar simultaneamente cada subconjunto possível dessas amostras de tamanho $n$, pondere cada amostra pelo número de subconjuntos para os quais ela é a melhor de acordo com o objetivo proxy e, em seguida, obtenha a pontuação média ponderada do objetivo verdadeiro. Este peso é apenas o coeficiente binomial $binom{k-1}{n-1}$, onde $k$ é a classificação da amostra sob o objetivo de proxy, de $1$ (pior) até $N$ (melhor). Além de usar amostras de forma mais eficiente, isso também nos permite reutilizar amostras para diferentes valores de $n$.

Quanto à divergência KL, surpreendentemente, ela acaba tendo uma fórmula exata que funciona para qualquer distribuição de probabilidade contínua $P$ (ou seja, desde que $P$ não tenha massas pontuais). Pode-se ingenuamente adivinhar que a resposta é $logn$, já que o melhor de $n$ está fazendo algo como pegar o $frac 1n$ superior da distribuição, e isso está aproximadamente correto: a resposta exata é $log n-frac{n-1}n$.

Juntos, esses estimadores nos permitem analisar facilmente como o verdadeiro objetivo varia com a quantidade de otimização aplicada ao objetivo proxy.

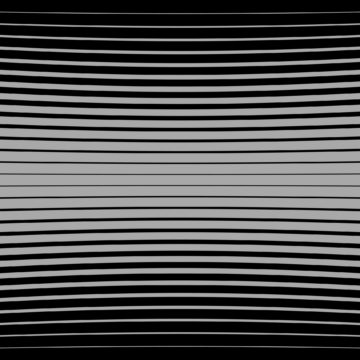

Aqui está um exemplo da vida real de WebGPT:

Melhor desempenho de $n$ para WebGPT 175B

Melhor desempenho de $n$ para WebGPT, com regiões sombreadas representando $pm 1$ de erro padrão e o eixo KL seguindo uma escala de raiz quadrada. Aqui, a distribuição original ($P$) é dada pelo modelo 175B treinado usando clonagem de comportamento, o objetivo de proxy usado para calcular o melhor de $n$ ($R_{text{proxy}}$) é dado pelo treinamento modelo de recompensa, e consideramos três objetivos supostamente “verdadeiros” ($R_{text{true}}$): o próprio modelo de recompensa de treinamento, um modelo de recompensa de validação treinado em dados retidos e preferências humanas reais. Não há muita otimização excessiva do objetivo de proxy, mas esperaríamos que houvesse KLs mais altos.

Indo além da melhor amostragem de $n$

A principal limitação da amostragem best-of-$n$ é que a divergência KL cresce logaritmicamente com $n$, portanto, ela é adequada apenas para aplicar uma pequena quantidade de otimização.

Para aplicar mais otimização, normalmente usamos aprendizado por reforço. Nas configurações que estudamos até agora, como resumo, normalmente conseguimos atingir um KL de cerca de 10 nats usando aprendizado por reforço antes que o verdadeiro objetivo comece a diminuir devido à lei de Goodhart. Teríamos que levar $n$ em torno de 60,000 para chegar a esse KL usando melhor de $n$, e esperamos poder alcançar KLs muito maiores do que isso com melhorias em nossas práticas de modelagem de recompensa e aprendizado por reforço.

No entanto, nem todos os nats são iguais. Empiricamente, para pequenos orçamentos de KL, o melhor de $n$ otimiza melhor tanto o proxy quanto os objetivos verdadeiros do que o aprendizado por reforço. Intuitivamente, o melhor de $n$ é a abordagem de “força bruta”, tornando-a mais eficiente em termos de informação do que o aprendizado por reforço, mas menos eficiente computacionalmente em grandes KLs.

Estamos estudando ativamente as propriedades de dimensionamento de objetivos de proxy como parte de nosso trabalho para alinhar nossos modelos com intenção e valores humanos. Se você quiser nos ajudar com esta pesquisa, estamos contratação!

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- OpenAI

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- pesquisa

- escala ai

- sintaxe

- zefirnet