Nossa abordagem para alinhar AGI é empírica e iterativa. Estamos melhorando a capacidade dos nossos sistemas de IA de aprender com o feedback humano e de ajudar os humanos na avaliação da IA. Nosso objetivo é construir um sistema de IA suficientemente alinhado que possa nos ajudar a resolver todos os outros problemas de alinhamento.

Introdução

Nossa pesquisa de alinhamento visa alinhar a inteligência artificial geral (AGI) aos valores humanos e seguir a intenção humana. Adotamos uma abordagem iterativa e empírica: ao tentar alinhar sistemas de IA altamente capazes, podemos aprender o que funciona e o que não funciona, refinando assim a nossa capacidade de tornar os sistemas de IA mais seguros e alinhados. Usando experimentos científicos, estudamos como as técnicas de alinhamento são dimensionadas e onde elas podem falhar.

Resolvemos problemas de alinhamento tanto em nossos sistemas de IA mais capazes quanto em problemas de alinhamento que esperamos encontrar em nosso caminho para a AGI. O nosso principal objectivo é levar o mais longe possível as actuais ideias de alinhamento e compreender e documentar precisamente como podem ter sucesso ou porque irão falhar. Acreditamos que mesmo sem ideias de alinhamento fundamentalmente novas, provavelmente poderemos construir sistemas de IA suficientemente alinhados para avançar substancialmente na própria investigação de alinhamento.

AGI desalinhada pode representar riscos substanciais para a humanidade e resolver o problema do alinhamento da AGI poderá ser tão difícil que exigirá que toda a humanidade trabalhe em conjunto. Portanto, estamos comprometidos em compartilhar abertamente nossa pesquisa de alinhamento quando for seguro fazê-lo: Queremos ser transparentes sobre o quão bem nossas técnicas de alinhamento realmente funcionam na prática e queremos que cada desenvolvedor de AGI use as melhores técnicas de alinhamento do mundo.

Em alto nível, nossa abordagem à pesquisa de alinhamento concentra-se na engenharia de um sinal de treinamento escalável para sistemas de IA muito inteligentes que estejam alinhados com a intenção humana. Possui três pilares principais:

- Treinamento de sistemas de IA usando feedback humano

- Treinamento de sistemas de IA para auxiliar na avaliação humana

- Treinando sistemas de IA para fazer pesquisas de alinhamento

O alinhamento dos sistemas de IA com os valores humanos também coloca uma série de outros desafios sociotécnicos significativos, tais como decidir a quem estes sistemas devem ser alinhados. Resolver esses problemas é importante para alcançar nossa missão, mas não os discutimos neste post.

Treinamento de sistemas de IA usando feedback humano

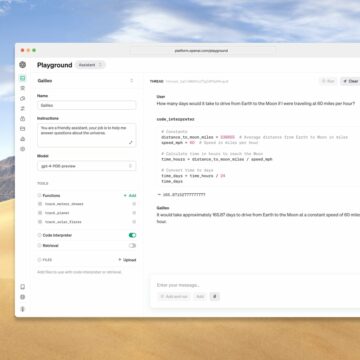

RL do feedback humano é nossa principal técnica para alinhar nossos modelos de linguagem implantados hoje. Treinamos uma classe de modelos chamada Instruir GPT derivado de modelos de linguagem pré-treinados, como GPT-3. Esses modelos são treinados para seguir a intenção humana: tanto a intenção explícita dada por uma instrução quanto a intenção implícita, como veracidade, justiça e segurança.

Nossos resultados mostram que há muitos frutos fáceis de alcançar no ajuste fino focado no alinhamento no momento: o InstructGPT é preferido pelos humanos em vez de um modelo pré-treinado 100x maior, enquanto seu ajuste fino custa <2% do cálculo de pré-treinamento do GPT-3 e cerca de 20,000 horas de feedback humano. Esperamos que nosso trabalho inspire outras pessoas do setor a aumentar seus investimentos no alinhamento de grandes modelos de linguagem e que eleve o nível das expectativas dos usuários sobre a segurança dos modelos implantados.

Nossa API de linguagem natural é um ambiente muito útil para nossa pesquisa de alinhamento: ele nos fornece um rico ciclo de feedback sobre quão bem nossas técnicas de alinhamento realmente funcionam no mundo real, baseado em um conjunto muito diversificado de tarefas pelas quais nossos clientes estão dispostos a pagar. Em média, nossos clientes já preferem usar o InstructGPT em vez de nossos modelos pré-treinados.

No entanto, as versões atuais do InstructGPT são muito longe de estar totalmente alinhado: às vezes não seguem instruções simples, nem sempre são verdadeiros, não recusam tarefas prejudiciais de forma confiável e, às vezes, dão respostas tendenciosas ou tóxicas. Alguns clientes consideram as respostas do InstructGPT significativamente menos criativas do que as dos modelos pré-treinados, algo que não percebemos ao executar o InstructGPT em benchmarks disponíveis publicamente. Também estamos trabalhando no desenvolvimento de uma compreensão científica mais detalhada da RL a partir do feedback humano e de como melhorar a qualidade do feedback humano.

Alinhar nossa API é muito mais fácil do que alinhar AGI, pois a maioria das tarefas em nossa API não são muito difíceis de serem supervisionadas por humanos e nossos modelos de linguagem implantados não são mais inteligentes que os humanos. Não esperamos que o RL do feedback humano seja suficiente para alinhar a AGI, mas é um alicerce essencial para as propostas de alinhamento escalonáveis que nos entusiasmam mais e, por isso, é valioso aperfeiçoar esta metodologia.

Modelos de treinamento para auxiliar na avaliação humana

A RL do feedback humano tem uma limitação fundamental: pressupõe que os humanos podem avaliar com precisão as tarefas que os nossos sistemas de IA estão realizando. Hoje, os humanos são muito bons nisso, mas à medida que os modelos se tornam mais capazes, eles serão capazes de realizar tarefas que são muito mais difíceis de serem avaliadas pelos humanos (por exemplo, encontrar todas as falhas em uma grande base de código ou em um artigo científico). Nossos modelos podem aprender a dizer aos nossos avaliadores humanos o que eles querem ouvir, em vez de lhes dizer a verdade. Para dimensionar o alinhamento, queremos usar técnicas como modelagem de recompensa recursiva (RRM), debate e amplificação iterada.

Atualmente nossa direção principal é baseada no RRM: treinamos modelos que podem ajudar os humanos a avaliar nossos modelos em tarefas que são muito difíceis para os humanos avaliarem diretamente. Por exemplo:

- Treinamos um modelo para resumir livros. Avaliar resumos de livros leva muito tempo para humanos se eles não estiverem familiarizados com o livro, mas nosso modelo pode auxiliar na avaliação humana escrevendo resumos de capítulos.

- Treinamos um modelo para ajudar os humanos a avaliar a precisão factual navegando na web e fornecendo citações e links. Em questões simples, os resultados deste modelo já são preferidos às respostas escritas por humanos.

- Treinamos um modelo para escrever comentários críticos sobre seus próprios resultados: Em uma tarefa de resumo baseada em consulta, a assistência com comentários críticos aumenta em 50%, em média, as falhas encontradas pelos humanos nos resultados do modelo. Isso vale mesmo se pedirmos aos humanos que escrevam resumos aparentemente plausíveis, mas incorretos.

- Estamos criando um conjunto de tarefas de codificação selecionadas para serem muito difíceis de avaliar de forma confiável para humanos não assistidos. Esperamos divulgar esse conjunto de dados em breve.

Nossas técnicas de alinhamento precisam funcionar mesmo que nossos sistemas de IA proponham soluções muito criativas (como Movimento do AlphaGo 37), portanto, estamos especialmente interessados em treinar modelos para ajudar os humanos a distinguir soluções corretas de soluções enganosas ou enganosas. Acreditamos que a melhor maneira de aprender o máximo possível sobre como fazer a avaliação assistida por IA funcionar na prática é construir assistentes de IA.

Treinando sistemas de IA para fazer pesquisas de alinhamento

Atualmente não há solução conhecida indefinidamente escalável para o problema de alinhamento. À medida que o progresso da IA continua, esperamos encontrar uma série de novos problemas de alinhamento que ainda não observamos nos sistemas atuais. Alguns destes problemas antecipamos agora e alguns deles serão inteiramente novos.

Acreditamos que encontrar uma solução escalável indefinidamente seja provavelmente muito difícil. Em vez disso, pretendemos uma abordagem mais pragmática: construir e alinhar um sistema que possa fazer com que a investigação sobre alinhamento progrida de forma mais rápida e melhor do que os humanos.

À medida que progredimos neste sentido, os nossos sistemas de IA podem assumir cada vez mais o nosso trabalho de alinhamento e, em última análise, conceber, implementar, estudar e desenvolver técnicas de alinhamento melhores do que as que temos agora. Eles trabalharão em conjunto com os humanos para garantir que os seus próprios sucessores estejam mais alinhados com os humanos.

Acreditamos que avaliar a investigação sobre alinhamento é substancialmente mais fácil do que produzi-la, especialmente quando contamos com assistência de avaliação. Portanto, os investigadores humanos concentrarão cada vez mais os seus esforços na revisão da investigação de alinhamento feita pelos sistemas de IA, em vez de gerarem esta investigação por si próprios. Nosso objetivo é treinar modelos para que fiquem tão alinhados que possamos aliviar quase todo o trabalho cognitivo necessário para a pesquisa de alinhamento.

É importante ressaltar que só precisamos de sistemas de IA “mais restritos” que tenham capacidades de nível humano nos domínios relevantes para fazerem tão bem quanto os humanos na pesquisa de alinhamento. Esperamos que esses sistemas de IA sejam mais fáceis de alinhar do que sistemas de uso geral ou sistemas muito mais inteligentes que os humanos.

Os modelos de linguagem são particularmente adequados para automatizar pesquisas de alinhamento porque vêm “pré-carregados” com muito conhecimento e informações sobre valores humanos provenientes da leitura na Internet. Fora da caixa, eles não são agentes independentes e, portanto, não perseguem os seus próprios objetivos no mundo. Para fazer pesquisas de alinhamento eles não precisam de acesso irrestrito à internet. No entanto, muitas tarefas de pesquisa de alinhamento podem ser formuladas como tarefas de linguagem natural ou de codificação.

Versões futuras de WebGPT, Instruir GPT e Códice podem fornecer uma base como assistentes de pesquisa de alinhamento, mas ainda não são suficientemente capazes. Embora não saibamos quando nossos modelos serão capazes o suficiente para contribuir significativamente para a pesquisa de alinhamento, achamos importante começar com antecedência. Assim que treinarmos um modelo que possa ser útil, planejamos torná-lo acessível à comunidade externa de pesquisa de alinhamento.

Limitações

Estamos muito entusiasmados com esta abordagem para alinhar a AGI, mas esperamos que ela precise ser adaptada e melhorada à medida que aprendemos mais sobre como a tecnologia de IA se desenvolve. Nossa abordagem também tem uma série de limitações importantes:

- O caminho traçado aqui subestima a importância da pesquisa de robustez e interpretabilidade, duas áreas nas quais a OpenAI está atualmente subinvestida. Se isso se enquadra no seu perfil, inscreva-se em nossos cargos de cientista pesquisador!

- Usar a assistência de IA para avaliação tem o potencial de ampliar ou amplificar até mesmo inconsistências, preconceitos ou vulnerabilidades sutis presentes no assistente de IA.

- O alinhamento da AGI provavelmente envolve a resolução de problemas muito diferentes do alinhamento dos sistemas de IA atuais. Esperamos que a transição seja um tanto contínua, mas se houver grandes descontinuidades ou mudanças de paradigma, então a maioria das lições aprendidas com modelos de alinhamento como o InstructGPT podem não ser diretamente úteis.

- As partes mais difíceis do problema de alinhamento podem não estar relacionadas à engenharia de um sinal de treinamento escalonável e alinhado para nossos sistemas de IA. Mesmo que isto seja verdade, tal sinal de treinamento será necessário.

- Pode não ser fundamentalmente mais fácil alinhar modelos que possam acelerar significativamente a investigação de alinhamento do que alinhar a AGI. Por outras palavras, os modelos menos capazes que podem ajudar na investigação do alinhamento podem já ser demasiado perigosos se não estiverem devidamente alinhados. Se isto for verdade, não teremos muita ajuda dos nossos próprios sistemas para resolver problemas de alinhamento.

Queremos contratar mais pessoas talentosas para esta linha de pesquisa! Se isso lhe interessa, estamos contratando Engenheiros de Pesquisa e Cientistas de pesquisa!

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- OpenAI

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- pesquisa

- escala ai

- sintaxe

- zefirnet