Imagine de autor

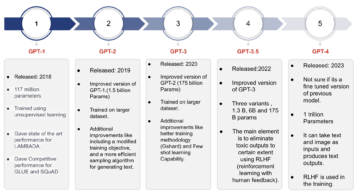

Recent, cu toții ne-a fost foarte greu să ajungem din urmă cu cele mai recente versiuni din spațiul LLM. În ultimele câteva săptămâni, mai multe alternative ChatGPT open-source au devenit populare.

Și în acest articol vom afla despre ChatGLM seria și ChatGLM-6B, o alternativă ChatGPT cu sursă deschisă și ușoară.

Haide să mergem!

Cercetătorii de la Universitatea Tsinghua din China au lucrat la dezvoltarea seriei ChatGLM de modele care au performanțe comparabile cu alte modele precum GPT-3 și BLOOM.

ChatGLM este un model de limbă mare bilingv instruit atât în chineză, cât și în engleză. În prezent sunt disponibile următoarele modele:

- ChatGLM-130B: un LLM cu sursă deschisă

- ChatGLM-100B: nu cu sursă deschisă, dar disponibil prin acces numai pe invitație

- ChatGLM-6B: o alternativă ușoară open-source

Deși aceste modele pot părea similare grupului de modele de limbaj mari ale grupului Generative Pretrained Transformer (GPT), Cadrul de preformare a modelului general de limbaj (GLM). este ceea ce îi face diferiți. Vom afla mai multe despre acest lucru în secțiunea următoare.

În învățarea automată, ați cunoaște GLM-urile ca modele liniare generalizate, dar GLM din ChatGLM reprezintă Model de limbaj general.

Cadrul de pregătire preliminară GLM

Preformarea LLM a fost studiată pe larg și este încă un domeniu de cercetare activă. Să încercăm să înțelegem diferențele cheie dintre preformarea GLM și modelele în stil GPT.

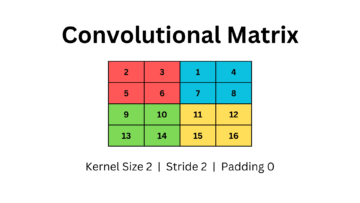

Familia de modele GPT-3 folosește modelarea limbajului auto regresiv numai pentru decodor. În GLM, pe de altă parte, optimizarea obiectivului este formulată ca un problemă de umplere auto regresivă a golurilor.

GLM | Image Source

In termeni simpli, umplere auto-regresivă a golurilor implică ștergerea unui interval continuu de text și apoi reconstruirea secvenţială a textului, această golire. Pe lângă măștile mai scurte, există o mască mai lungă care elimină aleatoriu spațiile libere lungi de text de la sfârșitul propozițiilor. Acest lucru se face astfel încât modelul să funcționeze rezonabil de bine în înțelegerea limbajului natural, precum și în sarcinile de generare.

O altă diferență este în tipul de atenție folosit. Grupul GPT de modele mari de limbaj folosește atenție unidirecțională, în timp ce grupul GLM de LLM utilizează atenție bidirecțională. Folosirea atenției bidirecționale asupra contextelor nemascate poate capta mai bine dependențele și poate îmbunătăți performanța la sarcinile de înțelegere a limbajului natural.

Activare GELU

În GLM, activarea GELU (Gauss Error Linear Units) este utilizată în locul activării ReLU [1].

Activari GELU, ReLU și ELU | Image Source

Activarea GELU și are valori diferite de zero pentru toate intrările și are următoarea formă [3]:

Activarea GELU s-a dovedit că îmbunătățește performanța în comparație cu activările ReLU, deși mai intensivă din punct de vedere computațional decât ReLU.

În seria GLM de LLM, ChatGLM-130B care este open-source și funcționează la fel de bine ca modelul Da-Vinci al GPT-3. După cum am menționat, încă de la scrierea acestui articol, există o versiune ChatGLM-100B, care este restricționată la acces numai pe invitație.

ChatGLM-6B

Următoarele detalii despre ChatGLM-6B pentru a-l face mai accesibil pentru utilizatorii finali:

- Are aproximativ 6.2 miliarde de parametri.

- Modelul este antrenat în prealabil pe 1 trilion de jetoane - în mod egal din engleză și chineză.

- Ulterior, sunt utilizate tehnici precum reglarea fină supravegheată și învățarea prin întărire cu feedback uman.

Să încheiem discuția noastră trecând peste avantajele și limitările ChatGLM:

Avantaje

De la a fi un model bilingv la un model open-source pe care îl puteți rula local, ChatGLM-6B are următoarele avantaje:

- Majoritatea modelelor lingvistice mari sunt instruite pe corpuri mari de text în limba engleză, iar modelele lingvistice mari pentru alte limbi nu sunt la fel de comune. Seria de LLM ChatGLM este bilingvă și o alegere excelentă pentru chineză. Modelul are performanțe bune atât în engleză, cât și în chineză.

- ChatGLM-6B este optimizat pentru dispozitivele utilizatorului. Utilizatorii finali au adesea resurse de calcul limitate pe dispozitivele lor, așa că devine aproape imposibil să ruleze LLM-uri la nivel local, fără acces la GPU-uri de înaltă performanță. Cu Cuantizarea INT4, ChatGLM-6B poate rula cu o cerință modestă de memorie de până la 6 GB.

- Funcționează bine la o varietate de sarcini, inclusiv rezumat și chat-uri cu o singură interogare și cu mai multe interogări.

- În ciuda numărului substanțial mai mic de parametri în comparație cu alte LLM-uri mainstream, ChatGLM-6B acceptă lungimea contextului de până la 2048.

Limitări

În continuare, să enumerăm câteva limitări ale ChatGLM-6B:

- Deși ChatGLM este un model bilingv, performanța sa în limba engleză este probabil suboptimă. Acest lucru poate fi atribuit că instrucțiunile folosite în antrenament sunt în mare parte în limba chineză.

- Pentru că ChatGLM-6B are în mod substanțial mai putini parametri în comparație cu alte LLM, cum ar fi BLOOM, GPT-3 și ChatGLM-130B, performanța poate fi mai slabă atunci când contextul este prea lung. Ca urmare, ChatGLM-6B poate oferi informații inexacte mai des decât modelele cu un număr mai mare de parametri.

- Modelele de limbaj mici au capacitate de memorie limitată. Prin urmare, în conversațiile cu mai multe rânduri, performanța modelului se poate degrada ușor.

- Prejudecățile, dezinformarea și toxicitatea sunt limitări ale tuturor LLM-urilor, iar ChatGLM este de asemenea susceptibil la acestea.

Ca pas următor, rulați ChatGLM-6B local sau încercați demonstrația pe spațiile HuggingFace. Dacă doriți să aprofundați în funcționarea LLM-urilor, iată o listă de cursuri gratuite despre modele de limbă mari.

[1] Z Du, Y Qian și colab., GLM: Preinstruire generală a modelului de limbaj cu umplere autoregresivă, ACL 2022

[2] A Zheng, X Liu și colab., GLM-130B – Un model deschis bilingv pregătit, ICML 2023

[3] D Hendryks, K Gimpel, Unități liniare de eroare gaussiană (GELU), arXiv, 2016

[4] ChatGLM-6B: Demo despre HuggingFace Spaces

[5] GitHub Repo

Bala Priya C este un scriitor tehnic căruia îi place să creeze conținut de lungă durată. Domeniile ei de interes includ matematica, programarea și știința datelor. Ea împărtășește învățarea ei cu comunitatea de dezvoltatori, creând tutoriale, ghiduri de utilizare și multe altele.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoAiStream. Web3 Data Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Sursa: https://www.kdnuggets.com/2023/04/chatglm6b-lightweight-opensource-chatgpt-alternative.html?utm_source=rss&utm_medium=rss&utm_campaign=chatglm-6b-a-lightweight-open-source-chatgpt-alternative

- :are

- :este

- :nu

- $UP

- 1

- a

- Despre Noi

- acces

- accesibil

- Activarea

- activări

- activ

- plus

- Avantajele

- AL

- TOATE

- alternativă

- alternative

- an

- și

- SUNT

- ZONĂ

- domenii

- articol

- AS

- At

- atenţie

- autor

- Auto

- disponibil

- BE

- deveni

- devine

- fost

- fiind

- Mai bine

- între

- Miliard

- Floare

- atât

- dar

- by

- CAN

- captura

- Chat GPT

- China

- chinez

- alegere

- Comun

- comunitate

- comparabil

- comparație

- tehnica de calcul

- conţinut

- context

- contexte

- continuu

- cursuri

- Crearea

- În prezent

- de date

- știința datelor

- Mai adânc

- Demo

- detalii

- Dezvoltator

- în curs de dezvoltare

- Dispozitive

- diferenţă

- diferenţele

- diferit

- discuţie

- făcut

- E&T

- capăt

- Engleză

- eroare

- familie

- feedback-ul

- puțini

- mai puține

- următor

- Pentru

- formă

- găsit

- din

- General

- generaţie

- generativ

- obține

- Da

- merge

- bine

- unități de procesare grafică

- mare

- grup

- Ghiduri

- mână

- Greu

- Avea

- având în

- ei

- aici

- performanta ridicata

- HTML

- HTTPS

- Față îmbrățișată

- uman

- if

- imposibil

- îmbunătăţi

- in

- inexact

- include

- Inclusiv

- informații

- in schimb

- instrucțiuni

- interes

- în

- implică

- IT

- ESTE

- jpg

- KDnuggets

- Cheie

- Cunoaște

- limbă

- Limbă

- mare

- mai mare

- Nume

- Ultimele

- AFLAȚI

- învăţare

- Lungime

- categorie ușoară

- ca

- Probabil

- limitări

- Limitat

- Listă

- la nivel local

- Lung

- mai lung

- Jos

- maşină

- masina de învățare

- Mainstream

- face

- FACE

- masca

- Măști

- matematica

- Mai..

- Memorie

- menționat

- Dezinformare

- model

- modelare

- Modele

- mai mult

- Natural

- Limbajul natural

- Înțelegerea limbajului natural

- următor

- număr

- Nvidia

- obiectiv

- of

- de multe ori

- on

- deschide

- open-source

- optimizare

- optimizate

- or

- Altele

- al nostru

- afară

- peste

- parametrii

- performanță

- efectuează

- Plato

- Informații despre date Platon

- PlatoData

- Popular

- pre

- Programare

- Consolidarea învățării

- Lansări

- cerință

- cercetare

- Resurse

- limitat

- rezultat

- Alerga

- s

- Ştiinţă

- Secțiune

- serie

- câteva

- Acțiuni

- ea

- asemănător

- simplu

- singur

- mai mici

- So

- Spaţiu

- spații

- deschidere

- Standuri

- Pas

- Încă

- studiat

- astfel de

- Super

- Sprijină

- susceptibil

- sarcini

- Tehnic

- tehnici de

- termeni

- decât

- acea

- lor

- Lor

- apoi

- Acolo.

- prin urmare

- Acestea

- acest

- Prin

- timp

- la

- de asemenea

- dresat

- Pregătire

- Trilion

- Tsinghua

- tutoriale

- tip

- înţelege

- înţelegere

- de unităţi

- universitate

- utilizare

- utilizat

- Utilizator

- utilizatorii

- folosind

- Valori

- varietate

- versiune

- săptămâni

- BINE

- Ce

- cand

- care

- OMS

- cu

- a lucrat

- de lucru

- mai rău

- încadra

- scriitor

- scris

- X

- tu

- zephyrnet