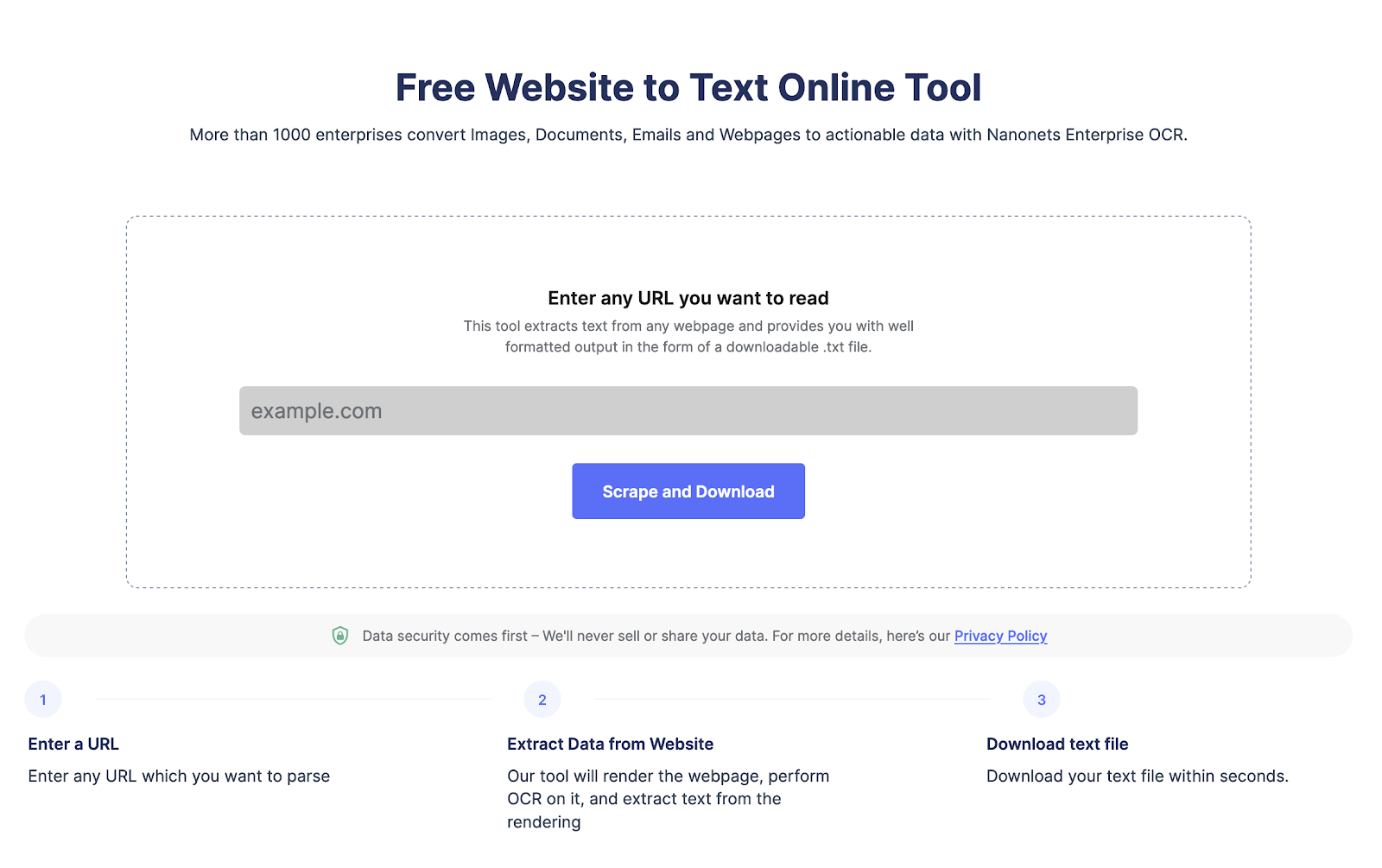

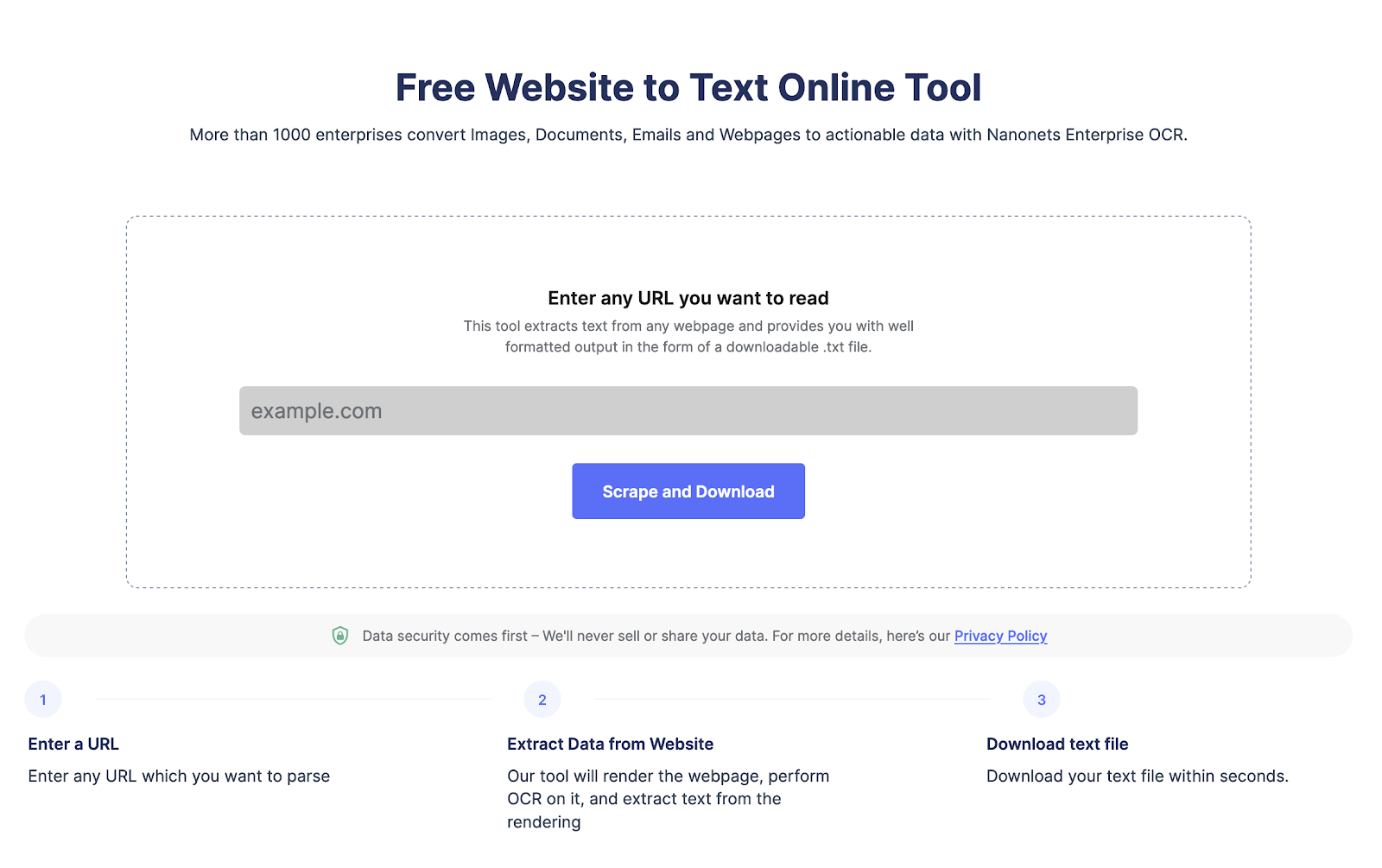

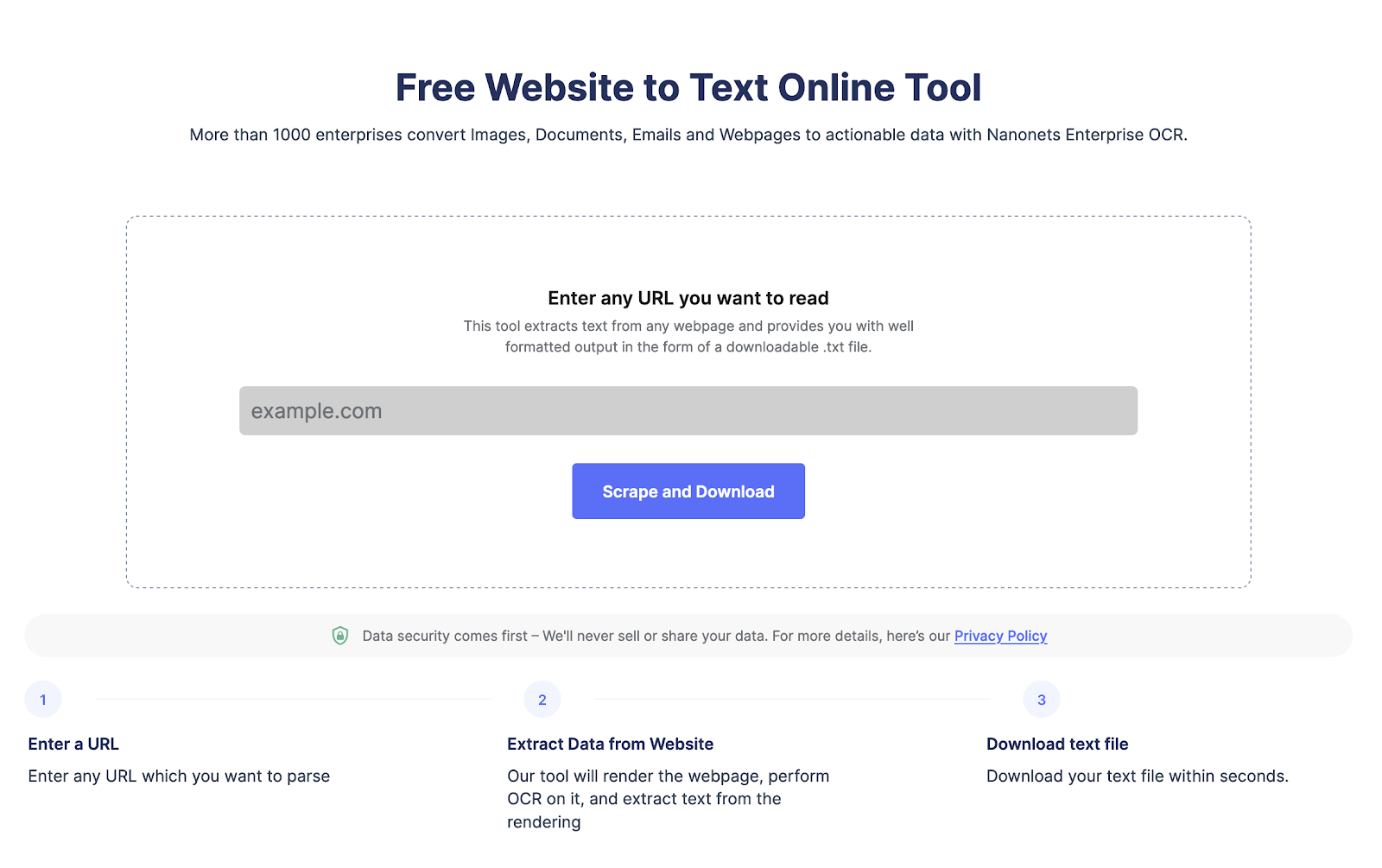

Doriți să extrageți date dintr-o pagină web?

Mergeți la Nanonets răzuitor site, Adăugați adresa URL și faceți clic pe „Scrape” și descărcați instantaneu textul paginii web ca fișier. Încercați-l gratuit acum.

Ce este web scraping și beneficiile sale?

Web scraping este utilizat pentru a răzui datele din paginile web automat la scară largă. Web scraping se face pentru a converti datele din structuri HTML complexe în format structurat, cum ar fi o foaie de calcul sau o bază de date, și este utilizat în diverse scopuri, cum ar fi cercetare, analiză și automatizare.

Iată câteva dintre motivele pentru care oamenii folosesc web scraping:

- Extrageți eficient datele paginii web pentru analize avansate.

- Urmăriți evoluția site-urilor concurenților și urmăriți schimbările în ofertele, tacticile sau prețurile acestora.

- Răzuiți clienții potențiali sau datele de e-mail din LinkedIn sau alt director.

- Automatizați sarcini precum introducerea datelor, completarea formularelor și alte sarcini repetitive, economisind timp și îmbunătățind eficiența.

De ce ar trebui să utilizați Node.js pentru web scraping?

Node.js este utilizat pe scară largă deoarece este o platformă ușoară, de înaltă performanță și eficientă. Iată câteva motive pentru care node.js este o alegere excelentă pentru web scraping:

- Node.js poate gestiona mai multe solicitări de web scraping în paralel.

- Are o comunitate mare care oferă suport și creează biblioteci de web scraping semnificative.

- Node.js este multiplatformă, ceea ce îl face o alegere versatilă pentru proiectele de web scraping

- Node.js este ușor de învățat, mai ales dacă cunoașteți deja JavaScript

- Node.js are suport încorporat pentru solicitările HTTP, ceea ce facilitează preluarea și analizarea paginilor HTML de pe site-uri web

- Node.js este foarte scalabil, ceea ce este important pentru web scraping atunci când procesează un volum mare de date

Doriți să extrageți date dintr-o pagină web?

Mergeți la Nanonets răzuitor site, Adăugați adresa URL și faceți clic pe „Scrape” și descărcați instantaneu textul paginii web ca fișier. Încercați-l gratuit acum.

Cum să răzuiți paginile web folosind Node JS?

Etapa 1 Configurarea mediului dvs.:

Trebuie să instalați node.js dacă nu ați făcut-o deja. Îl puteți descărca folosind site-ul oficial.

Etapa 2 Instalarea pachetelor necesare pentru web scraping cu Node.js:

Node.js are mai multe opțiuni pentru web scraping, cum ar fi Cheerio, Puppeteer și cerere. Le puteți instala cu ușurință folosind următoarea comandă.

npm install cheerio

npm install puppeteer

npm install requestPasul 3 Configurarea directorului de proiect:

Trebuie să creați un director nou pentru noul proiect. Și apoi navigați la promptul de comandă pentru a crea un fișier nou pentru a stoca codul dvs. de scraping web NodeJS.

Puteți crea un director nou și un fișier nou folosind următoarea comandă:

mkdir my-web-scraper

cd my-web-scraper

touch scraper.jsPasul 4 Efectuarea cererilor HTTP cu Node.js:

Pentru a răzui paginile web, trebuie să faceți solicitări HTTP. Acum, Node.js are încorporat un modul http. Acest lucru facilitează efectuarea cererilor. De asemenea, puteți utiliza axios sau solicitări pentru a face cerere.

Iată codul pentru a face cereri http cu node.js

const http = require('http');

const url = 'http://example.com';

http.get(url, (res) => {

let data = '';

res.on('data', (chunk) => {

data += chunk;

});

res.on('end', () => {

console.log(data);

});

});Înlocuiți http.//example.com cu adresa URL aleasă de dvs. pentru a răzui paginile web,

Pasul 5 Scraping HTML cu Node.js:

Odată ce aveți conținutul HTML al unei pagini web, trebuie să îl analizați pentru a extrage datele de care aveți nevoie. Mai multe biblioteci terță parte sunt disponibile pentru analizarea HTML în Node.js, cum ar fi Cheerio și JSDOM.

Iată un exemplu de fragment de cod folosind Cheerio pentru a analiza HTML și a extrage date:

const cheerio = require('cheerio');

const request = require('request');

const url = 'https://example.com';

request(url, (error, response, html) => {

if (!error && response.statusCode == 200) {

const $ = cheerio.load(html);

const title = $('title').text();

const firstParagraph = $('p').first().text();

console.log(title);

console.log(firstParagraph);

}

});Acest cod folosește biblioteca de solicitări pentru a prelua conținutul HTML al paginii web la adresa URL și apoi folosește Cheerio pentru a analiza HTML și a extrage titlul și primul paragraf.

Cum să gestionezi conținutul javascript și dinamic folosind Node.js?

Multe pagini web moderne folosesc JavaScript pentru a reda conținut dinamic, ceea ce face dificilă răzuirea acestora. Pentru a gestiona redarea JavaScript, puteți utiliza browsere fără cap, cum ar fi Puppeteer și Playwright, care vă permit să simulați un mediu de browser și să curățați conținut dinamic.

Iată un exemplu de fragment de cod folosind Puppeteer pentru a răzui o pagină web care redă conținut cu JavaScript:

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://example.com');

const title = await page.$eval('title', el => el.textContent);

const firstParagraph = await page.$eval('p', el => el.textContent);

console.log(title);

console.log(firstParagraph);

await browser.close();

})();Acest cod folosește Puppeteer pentru a lansa un browser fără cap, pentru a naviga la pagina web la adresa URL și pentru a extrage titlul și primul paragraf. Metoda page.$eval() selectează și extrage date din elemente HTML.

Iată câteva biblioteci pe care le puteți folosi pentru a răzui pagini web folosind NodeJS cu ușurință:

Cheerio: este o implementare rapidă, flexibilă și ușoară a jQuery de bază concepută pentru partea serverului.

JSDOM: este o implementare pur-JavaScript a DOM pentru Node.js. Oferă o modalitate de a crea un mediu DOM în Node.js și de a-l manipula cu un API standard.

Păpușar: este o bibliotecă Node.js care oferă un API de nivel înalt pentru a controla Chrome sau Chromium fără cap. Poate fi folosit pentru scraping web, testare automată, crawling și randare.

Cele mai bune practici pentru Web Scraping cu Node.js

Iată câteva dintre cele mai bune practici de urmat atunci când utilizați Node.js pentru web scraping:

- Înainte de a elimina un site web, citiți termenii de utilizare ale acestora. Asigurați-vă că pagina web nu are restricții privind scraping-ul web sau frecvența paginilor web scraping.

- Limitați numărul de solicitări HTTP pentru a preveni supraîncărcarea site-ului web prin controlul frecvenței solicitărilor.

- Setați antete adecvate în solicitările dvs. HTTP pentru a imita comportamentul unui utilizator obișnuit.

- Memorați în cache paginile web și datele extrase pentru a reduce încărcarea pe site.

- Web scraping poate fi predispus la erori din cauza complexității și variabilității site-urilor web.

- Monitorizați și ajustați activitatea de scraping și ajustați limitarea ratei, anteturile și alte setări după cum este necesar.

Doriți să extrageți date dintr-o pagină web?

Mergeți la Nanonets răzuitor site, Adăugați adresa URL și faceți clic pe „Scrape” și descărcați instantaneu textul paginii web ca fișier. Încercați-l gratuit acum.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- Platoblockchain. Web3 Metaverse Intelligence. Cunoștințe amplificate. Accesați Aici.

- Sursa: https://nanonets.com/blog/web-scraping-with-node-js/

- :este

- ][p

- $UP

- 1

- 2023

- a

- activitate

- avansat

- deja

- analiză

- și

- api

- adecvat

- SUNT

- AS

- At

- Automata

- în mod automat

- Automatizare

- disponibil

- astept

- Axios

- BE

- Beneficiile

- CEL MAI BUN

- Cele mai bune practici

- browser-ul

- browsere

- construit-in

- by

- CAN

- CD

- Schimbare

- verifica

- alegere

- Chrome

- crom

- clic

- cod

- COM

- comunitate

- concurent

- complex

- complexitate

- Consoleze

- conţinut

- Control

- controlul

- converti

- Nucleu

- crea

- creează

- cross-platform

- de date

- de introducere a datelor

- Baza de date

- proiectat

- evoluții

- dificil

- Nu

- HOTĂRÂREA

- Descarca

- dinamic

- cu ușurință

- uşor

- eficiență

- eficient

- eficient

- element

- asigura

- intrare

- Mediu inconjurator

- eroare

- mai ales

- Eter (ETH)

- exemplu

- extrage

- extrageți datele

- extracte

- ochi

- FAST

- Fișier

- First

- flexibil

- urma

- următor

- Pentru

- formă

- format

- Gratuit

- Frecvență

- din

- mare

- manipula

- Avea

- anteturile

- aici

- la nivel înalt

- performanta ridicata

- extrem de

- HTML

- http

- HTTPS

- implementarea

- important

- îmbunătățirea

- in

- instala

- IT

- ESTE

- JavaScript

- jQuery

- A pastra

- Cunoaște

- mare

- comunitate mare

- lansa

- Conduce

- AFLAȚI

- biblioteci

- Bibliotecă

- categorie ușoară

- ca

- încărca

- face

- FACE

- Efectuarea

- semnificativ

- metodă

- Modern

- modul

- multiplu

- Navigaţi

- necesar

- Nevoie

- necesar

- Nou

- nod

- Node.js

- număr

- of

- ofertele

- oficial

- Site oficial

- on

- Opţiuni

- comandă

- Altele

- ofertele

- pagină

- oameni

- platformă

- Plato

- Informații despre date Platon

- PlatoData

- practicile

- împiedica

- de stabilire a prețurilor

- prelucrare

- Produs

- proiect

- furnizează

- scopuri

- rată

- Citeste

- motive

- reduce

- regulat

- tencuială

- face

- repetitiv

- solicita

- cereri de

- cercetare

- răspuns

- restricții

- economisire

- scalabil

- Scară

- răzuire

- instalare

- setări

- câteva

- să

- unele

- Spreadsheet

- standard

- stoca

- structurat

- astfel de

- a sustine

- tactică

- sarcini

- termeni

- Testarea

- acea

- lor

- Lor

- terț

- timp

- Titlu

- la

- atingeţi

- URL-ul

- utilizare

- Utilizator

- diverse

- multilateral

- volum

- Cale..

- web

- razuire web

- website

- site-uri web

- care

- cu

- Ta

- zephyrnet