Изображение по автору

В последнее время нам всем было очень трудно следить за последними выпусками в пространстве LLM. За последние несколько недель стали популярными несколько альтернатив ChatGPT с открытым исходным кодом.

И в этой статье мы узнаем о ЧатGLM серия и ЧатGLM-6B, легкая альтернатива ChatGPT с открытым исходным кодом.

Давайте идти!

Исследователи из Университета Цинхуа в Китае работали над созданием серии моделей ChatGLM, производительность которых сравнима с другими моделями, такими как GPT-3 и BLOOM.

ChatGLM — это двуязычная крупноязыковая модель, обученная как китайскому, так и английскому языку. На данный момент доступны следующие модели:

- ChatGLM-130B: LLM с открытым исходным кодом

- ChatGLM-100B: не с открытым исходным кодом, но доступен только по приглашению.

- ChatGLM-6B: легкая альтернатива с открытым исходным кодом

Хотя эти модели могут показаться похожими на группу больших языковых моделей Generative Pretrained Transformer (GPT), Структура предварительной подготовки General Language Model (GLM) это то, что делает их разными. Мы узнаем больше об этом в следующем разделе.

В машинном обучении вы бы знали GLM как обобщенные линейные модели, но GLM в ChatGLM означает Общая языковая модель.

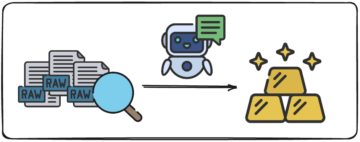

Структура предварительной подготовки GLM

Предварительное обучение LLM было тщательно изучено и до сих пор является областью активных исследований. Давайте попробуем разобраться в ключевых различиях между предобучением GLM и моделями в стиле GPT.

Семейство моделей GPT-3 использует авторегрессивное языковое моделирование только для декодера. С другой стороны, в GLM оптимизация цели формулируется как авторегрессивная проблема с заполнением бланка.

ГЛМ | Image Source

Проще говоря, авторегрессивное заполнение бланка включает в себя гашение непрерывного фрагмента текста, а затем последовательное восстановление текста этого гашения. В дополнение к более коротким маскам существует более длинная маска, которая случайным образом удаляет длинные пробелы текста в конце предложений. Это сделано для того, чтобы модель достаточно хорошо работала в задачах понимания естественного языка, а также в задачах генерации.

Еще одно отличие заключается в типе используемого внимания. Группа больших языковых моделей GPT использует однонаправленное внимание, тогда как группа LLM GLM использует двунаправленное внимание. Использование двунаправленного внимания в немаскированных контекстах может лучше фиксировать зависимости и повысить производительность при выполнении задач понимания естественного языка.

GELU Активация

В GLM активация GELU (линейные единицы ошибки Гаусса) используется вместо активации ReLU [1].

Активации GELU, ReLU и ELU | Image Source

Активация GELU и имеет ненулевые значения для всех входов и имеет следующий вид [3]:

Обнаружено, что активация GELU повышает производительность по сравнению с активациями ReLU, хотя требует больше вычислительных ресурсов, чем ReLU.

В серии LLM GLM ChatGLM-130B с открытым исходным кодом работает так же, как модель Da-Vinci GPT-3. Как уже упоминалось, на момент написания этой статьи существует версия ChatGLM-100B, доступ к которой ограничен только по приглашению.

ЧатGLM-6B

Следующие сведения о ChatGLM-6B, чтобы сделать его более доступным для конечных пользователей:

- Имеет около 6.2 миллиарда параметров.

- Модель предварительно обучена на 1 триллионе токенов — поровну с английского и китайского языков.

- Впоследствии используются такие методы, как контролируемая точная настройка и обучение с подкреплением с обратной связью с человеком.

Давайте завершим наше обсуждение, рассмотрев преимущества и ограничения ChatGLM:

Преимущества

От двуязычной модели до модели с открытым исходным кодом, которую вы можете запускать локально, ChatGLM-6B имеет следующие преимущества:

- Большинство основных моделей больших языков обучаются на больших корпусах английских текстов, а модели больших языков для других языков встречаются не так часто. Серия ChatGLM LLM двуязычна и отлично подходит для китайского языка. Модель имеет хорошие показатели как на английском, так и на китайском языке.

- ChatGLM-6B оптимизирован для пользовательских устройств. Конечные пользователи часто имеют ограниченные вычислительные ресурсы на своих устройствах, поэтому становится практически невозможно запускать LLM локально — без доступа к высокопроизводительным графическим процессорам. С Квантование INT4, ChatGLM-6B может работать со скромными требованиями к памяти — всего 6 ГБ.

- Хорошо справляется с различными задачами, включая обобщение и чаты с одним и несколькими запросами.

- Несмотря на существенно меньшее количество параметров по сравнению с другими основными LLM, ChatGLM-6B поддерживает длину контекста до 2048.

ограничения

Далее перечислим несколько ограничений ChatGLM-6B:

- Хотя ChatGLM является двуязычной моделью, его производительность на английском языке, вероятно, не оптимальна. Это можно объяснить тем, что инструкции, используемые при обучении, в основном написаны на китайском языке.

- Поскольку ChatGLM-6B существенно меньше параметров по сравнению с другими LLM, такими как BLOOM, GPT-3 и ChatGLM-130B, производительность может быть хуже, когда контекст слишком длинный. В результате ChatGLM-6B может давать неверную информацию чаще, чем модели с большим количеством параметров.

- Небольшие языковые модели имеют ограниченный объем памяти. Поэтому в многооборотных чатах производительность модели может немного ухудшиться.

- Предвзятость, дезинформация и токсичность являются ограничениями всех LLM, и ChatGLM также подвержен им.

В качестве следующего шага запустите ChatGLM-6B локально или опробуйте демоверсию на пространствах HuggingFace. Если вы хотите глубже изучить работу LLM, вот список бесплатные курсы по большим языковым моделям.

[1] Z Du, Y Qian и др., GLM: предварительное обучение общей языковой модели с авторегрессивным заполнением пробелов, АКЛ 2022

[2] А Чжэн, С Лю и др., GLM-130B — открытая двуязычная предварительно обученная модель, МЦМЛ 2023

[3] Д. Хендрикс, К. Гимпель, Линейные единицы ошибки Гаусса (GELU), архив, 2016

[4] ChatGLM-6B: демонстрация на HuggingFace Spaces

[5] Репозиторий GitHub

Бала Прия С — технический писатель, которому нравится создавать объемный контент. В сферу ее интересов входят математика, программирование и наука о данных. Она делится своими знаниями с сообществом разработчиков, создавая учебные пособия, практические руководства и многое другое.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- ПлатонАйСтрим. Анализ данных Web3. Расширение знаний. Доступ здесь.

- Чеканка будущего с Эдриенн Эшли. Доступ здесь.

- Источник: https://www.kdnuggets.com/2023/04/chatglm6b-lightweight-opensource-chatgpt-alternative.html?utm_source=rss&utm_medium=rss&utm_campaign=chatglm-6b-a-lightweight-open-source-chatgpt-alternative

- :имеет

- :является

- :нет

- $UP

- 1

- a

- О нас

- доступ

- доступной

- Активация

- активации

- активный

- дополнение

- Преимущества

- AL

- Все

- альтернатива

- альтернативы

- an

- и

- МЫ

- ПЛОЩАДЬ

- области

- гайд

- AS

- At

- внимание

- авторинга

- автоматический

- доступен

- BE

- становиться

- становится

- было

- не являетесь

- Лучшая

- между

- миллиард

- Цвести

- изоферменты печени

- но

- by

- CAN

- захватить

- ChatGPT

- Китай

- китайский

- выбор

- Общий

- сообщество

- сравнимый

- сравненный

- вычисление

- содержание

- контекст

- контексты

- (CIJ)

- курсы

- Создающий

- В настоящее время

- данным

- наука о данных

- более глубокий

- Демо

- подробнее

- Застройщик

- развивающийся

- Устройства

- разница

- Различия

- различный

- обсуждение

- сделанный

- Е & Т

- конец

- Английский

- ошибка

- семья

- Обратная связь

- несколько

- меньше

- после

- Что касается

- форма

- найденный

- от

- Общие

- поколение

- генеративный

- получить

- Дайте

- будет

- хорошо

- Графические процессоры

- большой

- группы

- Гиды

- рука

- Жесткий

- Есть

- имеющий

- ее

- здесь

- высокая производительность

- HTML

- HTTPS

- ОбниматьЛицо

- человек

- if

- что она

- улучшать

- in

- неточный

- включают

- В том числе

- информация

- вместо

- инструкции

- интерес

- в

- включает в себя

- IT

- ЕГО

- JPG

- КДнаггетс

- Основные

- Знать

- язык

- Языки

- большой

- больше

- Фамилия

- последний

- УЧИТЬСЯ

- изучение

- Длина

- легкий

- такое как

- Вероятно

- недостатки

- Ограниченный

- Список

- в местном масштабе

- Длинное

- дольше

- Низкий

- машина

- обучение с помощью машины

- Mainstream

- сделать

- ДЕЛАЕТ

- маска

- Маски

- математике

- Май..

- Память

- упомянутый

- дезинформация

- модель

- моделирование

- Модели

- БОЛЕЕ

- натуральный

- Естественный язык

- Изучение естественного языка

- следующий

- номер

- Nvidia

- цель

- of

- .

- on

- открытый

- с открытым исходным кодом

- оптимизация

- оптимизированный

- or

- Другие контрактные услуги

- наши

- внешний

- за

- параметры

- производительность

- выполняет

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Популярное

- заранее

- Программирование

- усиление обучения

- публикации

- требование

- исследованиям

- Полезные ресурсы

- ограниченный

- результат

- Run

- s

- Наука

- Раздел

- Серии

- несколько

- Акции

- она

- аналогичный

- просто

- одинарной

- меньше

- So

- Space

- пространства

- пролет

- стоит

- Шаг

- По-прежнему

- учился

- такие

- супер

- Поддержка

- восприимчивый

- задачи

- Технический

- снижения вреда

- terms

- чем

- который

- Ассоциация

- их

- Их

- тогда

- Там.

- следовательно

- Эти

- этой

- Через

- время

- в

- слишком

- специалистов

- Обучение

- Триллион

- Цинхуа

- учебные пособия

- напишите

- понимать

- понимание

- единиц

- Университет

- использование

- используемый

- Информация о пользователе

- пользователей

- через

- Наши ценности

- разнообразие

- версия

- Недели

- ЧТО Ж

- Что

- когда

- который

- КТО

- работавший

- работает

- хуже

- заворачивать

- писатель

- письмо

- X

- являетесь

- зефирнет