Изображение по автору

XAI — это искусственный интеллект, который позволяет людям понимать результаты и процессы принятия решений модели или системы.

Объяснимость перед моделированием

Объяснимый ИИ начинается с объяснимых данных и четкой, интерпретируемой разработки функций.

Моделирование объяснимости

При выборе модели для конкретной проблемы, как правило, лучше всего использовать наиболее интерпретируемую модель, которая по-прежнему дает хорошие прогностические результаты.

Постмодельная объяснимость

Сюда входят такие методы, как возмущение, когда анализируется влияние изменения одной переменной на выходные данные модели, такие как значения SHAP после обучения.

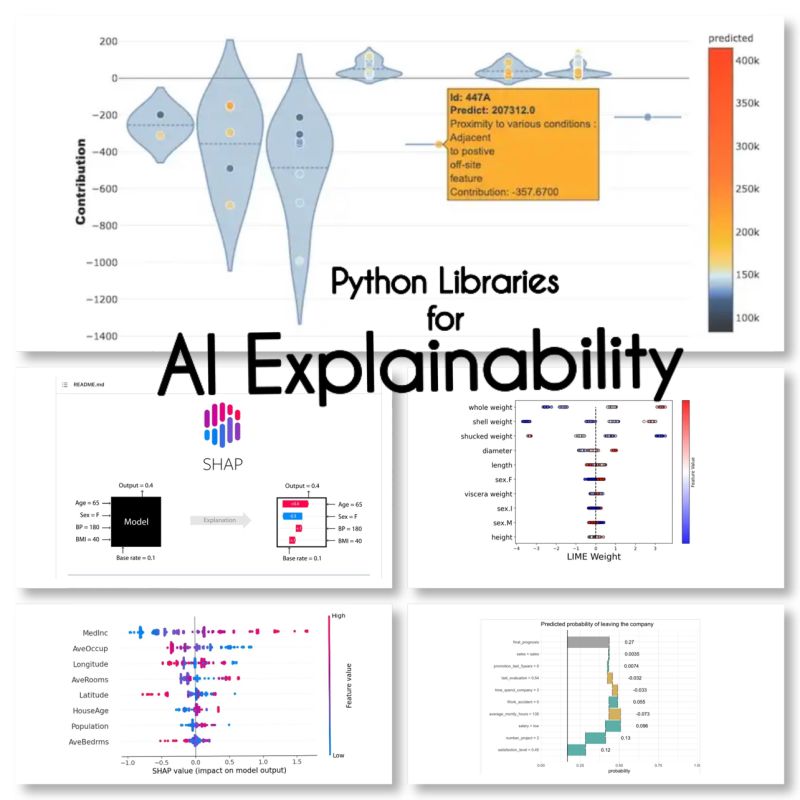

Я нашел эти 10 библиотек Python для объяснения ИИ:

SHAP (аддитивные объяснения Шепли)

SHAP не зависит от модели и работает, разбивая вклад каждой функции и присваивая оценку каждой функции.

LIME (локальные интерпретируемые объяснения, не зависящие от модели)

LIME — это еще один независимый от модели метод, который работает путем локальной аппроксимации поведения модели вокруг конкретного прогноза.

ЭЛи5

Eli5 — это библиотека для отладки и объяснения классификаторов. Он предоставляет оценки важности функций, а также «коды причин» для scikit-learn, Keras, xgboost, LightGBM, CatBoost.

Шапаш

Shapash — это библиотека Python, цель которой — сделать машинное обучение интерпретируемым и понятным для всех. Shapash предоставляет несколько типов визуализации с явными метками.

Якоря

Якоря — это метод создания интерпретируемых человеком правил, которые можно использовать для объяснения прогнозов модели машинного обучения.

XAI (объяснимый ИИ)

XAI — это библиотека для объяснения и визуализации прогнозов моделей машинного обучения, включая оценки важности функций.

Авария

BreakDown — это инструмент, который можно использовать для объяснения предсказаний линейных моделей. Он работает путем разложения выходных данных модели на вклад каждой входной функции.

интерпретировать-текст

интерпретировать текст — это библиотека для объяснения предсказаний моделей обработки естественного языка.

iml (интерпретируемое машинное обучение)

iml в настоящее время содержит интерфейс и код ввода-вывода из проекта Shap, и потенциально он также будет делать то же самое для проекта Lime.

aix360 (Объяснимость ИИ 360)

aix360 включает полный набор алгоритмов, которые охватывают различные измерения.

ОмниХАИ

OmniXAI (сокращение от Omni eXplainable AI) решает несколько проблем с интерпретацией суждений, выдаваемых моделями машинного обучения на практике.

Я забыл какие-нибудь библиотеки?

Источники

Марьям Миради является ведущим специалистом по искусственному интеллекту и науке о данных со степенью доктора наук в области машинного обучения и глубокого обучения, специализирующейся на НЛП и компьютерном зрении. Она имеет более чем 15-летний опыт создания успешных решений в области искусственного интеллекта и более 40 успешных проектов. Она работала в 12 различных организациях в различных отраслях, включая выявление финансовых преступлений, энергетику, банковское дело, розничную торговлю, электронную коммерцию и правительство.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- Платоблокчейн. Интеллект метавселенной Web3. Расширение знаний. Доступ здесь.

- Источник: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- адреса

- После

- AI

- Цель

- алгоритмы

- позволяет

- и

- Другой

- около

- искусственный

- искусственный интеллект

- Банковское дело

- ЛУЧШЕЕ

- Разрыв

- изменения

- Выбирая

- Очистить

- код

- комплексный

- компьютер

- Компьютерное зрение

- содержит

- вклад

- чехол для варгана

- Создающий

- Преступление

- В настоящее время

- данным

- наука о данных

- Принятие решений

- решения

- глубоко

- глубокое обучение

- доставки

- различный

- вниз

- электронная коммерция

- каждый

- эффект

- энергетика

- Проект и

- все члены

- опыт

- Объяснять

- Объяснимость

- Объясняемый ИИ

- объясняя

- Особенность

- финансовый

- финансовое преступление

- забытый

- найденный

- от

- в общем

- порождающий

- хорошо

- Правительство

- HTTPS

- Людей

- значение

- in

- включает в себя

- В том числе

- промышленности

- вход

- Интеллекта

- Интерфейс

- IT

- суждения

- КДнаггетс

- keras

- Этикетки

- язык

- вести

- изучение

- библиотеки

- Библиотека

- известь

- локальным

- в местном масштабе

- машина

- обучение с помощью машины

- сделать

- метод

- модель

- Модели

- самых

- натуральный

- Естественный язык

- Обработка естественного языка

- НЛП

- Omni

- Организации

- особый

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- потенциально

- практика

- прогноз

- Predictions

- Проблема

- проблемам

- Процессы

- обработка

- Произведенный

- Проект

- проектов

- приводит

- Питон

- причина

- запись

- Итоги

- розничный

- условиями,

- то же

- Наука

- scikit учиться

- набор

- несколько

- Короткое

- одинарной

- Решения

- специализированный

- конкретный

- начинается

- По-прежнему

- успешный

- такие

- система

- снижения вреда

- Ассоциация

- в

- инструментом

- трек

- Обучение

- Типы

- понимать

- понятный

- использование

- Наши ценности

- разнообразие

- видение

- визуализация

- который

- будете

- работавший

- работает

- XGBoost

- лет

- ВАШЕ

- зефирнет