Закон Гудхарта известное высказывание: «Когда мера становится целью, она перестает быть хорошей мерой». Хотя изначально это было связано с экономикой, нам в OpenAI приходится сталкиваться с этим при выяснении того, как оптимизировать цели, которые сложно или дорого измерить. Часто бывает необходимо ввести некоторые косвенная цель это проще или дешевле измерить, но когда мы это делаем, мы должны быть осторожны, чтобы не оптимизировать его слишком сильно.

Например, в рамках нашей работы по выравнивать таких моделей, как GPT-3 с человеческими намерениями и ценностями, мы хотели бы оптимизировать такие вещи, как «Как полезный это ответ?» или «Как фактически точный это претензия?». Это сложные задачи, которые требуют от людей тщательной проверки. По этой причине мы обучаем модель прогнозировать эти человеческие предпочтения, известную как модель вознагражденияи используйте прогнозы модели вознаграждения в качестве прокси-цели. Но важно отслеживать, насколько хорошо оптимизируется истинная цель.

В этом посте мы рассмотрим некоторые математические аспекты того, как мы это делаем. Мы сосредоточимся на обстановке, особенно удобной для анализа, в которой у нас есть доступ к истинной цели. На практике даже человеческие предпочтения могут быть не в состоянии измерить то, что нас действительно волнует, но мы откладываем этот вопрос в сторону в этом посте.

Выборка наилучшего из $n$

Существует множество способов оптимизации прокси-цели, но, пожалуй, самый простой из них — выборка наилучшего из $n$, также известная как отбраковка or переоценка. Мы просто делаем выборку $n$ раз и выбираем тот, который имеет наивысший балл в соответствии с прокси-целью.

Хотя этот метод очень прост, на самом деле он может конкурировать с более продвинутыми методами, такими как обучение с подкреплением, хотя и за счет большего времени вычислений. Например, в ВебGPT, наша модель «лучший из 64 долларов» превзошла нашу модель обучения с подкреплением, возможно, отчасти потому, что модель «лучший из 64 долларов» позволила просмотреть гораздо больше веб-сайтов. Даже применение стратегии «лучший из 4 долларов» обеспечило значительный рост человеческих предпочтений.

Кроме того, выборка наилучшего из $n$ обеспечивает надежную работу и проста для математического анализа, что делает ее подходящей для эмпирических исследований закона Гудхарта и связанных с ним явлений.

Математика выборки по принципу «лучший из $n$»

Давайте более формально изучим выборку лучших из $n$. Предположим, у нас есть некоторое выборочное пространство $S$ (такое как множество возможных пар вопрос-ответ), некоторое распределение вероятностей $P$ по $С$, истинная цель (или «награда») $R_{текст{true}}:Stomathbb R$, и косвенная цель $R_{текст{прокси}}:Stomathbb R$. Допустим, мы каким-то образом оптимизировали $R_{text{proxy}}$ и тем самым получили какой-то новый дистрибутив $P^Prime$. Тогда:

- Ожидание $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ измеряет, насколько хорошо мы оптимизировали истинную цель.

- Ассоциация Дивергенция КЛ $D_{text{KL}}left(P^primeparallel Pright)$ показывает, сколько мы сделали оптимизации. Например, если $P^prime$ получается путем взятия первой выборки из $P$, лежащей в некотором подмножестве $S^простая подмножество S$, тогда это KL-расхождение есть просто отрицательная логарифмическая вероятность того, что выборка из $P$ лежит в $S^prime$.

Оказывается, в случае выборки best-of-n$ обе эти величины можно эффективно оценить, используя выборки из $P$.

Давайте сначала посмотрим на ожидания. Наивный подход состоит в том, чтобы использовать метод Монте-Карло: многократный запуск выборки методом наилучшего из $n$, измерение истинной цели на этих выборках и усреднение результатов. Однако есть лучший оценщик. Если всего $Ngeq n$ выборок из $P$, то мы можем одновременно рассматривать каждое возможное подмножество из этих выборок размера $n$, взвесьте каждую выборку по количеству подмножеств, для которых она является лучшей в соответствии с прокси-целью, а затем возьмите средневзвешенную истинную объективную оценку. Этот вес есть просто биномиальный коэффициент $бином{k-1}{n-1}$, где $k$ — ранг выборки по косвенной цели, от $1$ (худший) до $N$ (лучший). Помимо более эффективного использования выборок, это также позволяет нам повторно использовать выборки для разных значений $n$.

Что касается KL-дивергенции, неожиданно оказывается, что она имеет точную формулу, которая работает для любого непрерывного распределения вероятностей $P$ (т.е. до тех пор, пока $P$ не имеет точечных масс). Можно наивно предположить, что ответ $лог n$, так как лучший из $n$ делает что-то вроде взятия верхней $frac 1n$ распределения, и это примерно правильно: точный ответ $log n-фракция{n-1}n$.

Вместе эти оценщики позволяют нам легко анализировать, как истинная цель меняется в зависимости от степени оптимизации, применяемой к прокси-цели.

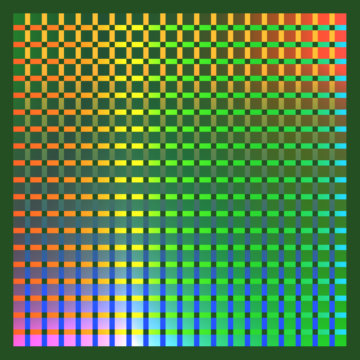

Вот реальный пример из ВебGPT:

Лучшая производительность на $n$ для WebGPT 175B

Лучшая из $n$ производительность для WebGPT, с заштрихованными областями, представляющими стандартную ошибку $pm 1$, а ось KL соответствует масштабу квадратного корня. Здесь исходное распределение ($P$) задается моделью 175B, обученной с использованием клонирования поведения, прокси-цель, используемая для вычисления лучшего из $n$ ($R_{text{proxy}}$), задается обучающей модель вознаграждения, и мы рассматриваем три предположительно «истинных» цели ($R_{text{true}}$): сама модель вознаграждения за обучение, модель вознаграждения за проверку, обученную на имеющихся данных, и фактические предпочтения человека. Переоптимизации прокси-цели не так много, но мы ожидаем, что она будет при более высоких KL.

Выход за рамки выборки наилучшего из $n$

Основное ограничение выборки по методу наилучшего из $n$ заключается в том, что расхождение KL логарифмически растет с ростом $n$, поэтому он подходит только для применения небольшой оптимизации.

Чтобы применить больше оптимизации, мы обычно используем обучение с подкреплением. В настройках, которые мы изучали до сих пор, таких как обобщение, нам обычно удавалось достичь KL около 10 Nats использование обучения с подкреплением до того, как истинная цель начнет уменьшаться в соответствии с законом Гудхарта. Чтобы достичь этого KL с помощью лучший из $n$, и мы надеемся, что сможем достичь гораздо большего KL, чем это, благодаря усовершенствованию наших методов моделирования вознаграждения и обучения с подкреплением.

Однако не все нации равны. Эмпирически, для небольших бюджетов KL лучший из $n$ лучше оптимизирует как прокси, так и истинные цели, чем обучение с подкреплением. Интуитивно лучший из $n$ — это подход «грубой силы», что делает его более эффективным с теоретической точки зрения, чем обучение с подкреплением, но менее эффективным с вычислительной точки зрения при больших KL.

Мы активно изучаем свойства масштабирования прокси-целей в рамках нашей работы по выравнивать наши модели с человеческими намерениями и ценностями. Если вы хотите помочь нам с этим исследованием, мы наем!

- AI

- ай искусство

- генератор искусств ай

- искусственный интеллект

- искусственный интеллект

- сертификация искусственного интеллекта

- искусственный интеллект в банковском деле

- робот с искусственным интеллектом

- роботы с искусственным интеллектом

- программное обеспечение искусственного интеллекта

- блокчейн

- конференция по блокчейну

- Coingenius

- разговорный искусственный интеллект

- криптоконференция ИИ

- дал-и

- глубокое обучение

- google ai

- обучение с помощью машины

- OpenAI

- Платон

- Платон Ай

- Платон Интеллектуальные данные

- Платон игра

- ПлатонДанные

- платогейминг

- исследованиям

- масштаб ай

- синтаксис

- зефирнет