Dataintegrationsprocesser drar nytta av automatiserad testning precis som all annan programvara. Ändå är det sällsynt att hitta ett datapipelineprojekt med en lämplig uppsättning automatiserade tester. Även när ett projekt har många tester är de ofta ostrukturerade, kommunicerar inte sitt syfte och är svåra att köra.

En egenskap hos datapipeline utveckling är den frekventa utgivningen av högkvalitativ data för att få användarfeedback och acceptans. I slutet av varje datapipeline-iteration förväntas det att data är av hög kvalitet för nästa fas.

Automatiserad testning är avgörande för integrationstestning av datapipelines. Manuell testning är opraktisk i mycket iterativa och adaptiva utvecklingsmiljöer.

Primära problem med manuell datatestning

För det första tar det för lång tid och är en kritisk hämmare för den frekventa leveransen av rörledningar. Lag som i första hand förlitar sig på manuell testning skjuter upp testningen till särskilda testperioder, vilket gör att buggar kan ackumuleras.

För det andra är manuell datapipelinetestning inte tillräckligt reproducerbar för regressionstestning.

Automatisering av datapipeline-testerna kräver inledande planering och kontinuerlig noggrannhet, men när de tekniska teamen antar automatisering är projektets framgång mer säker.

Varianter av datapipelines

- Extrahera, transformera och ladda (ETL)

- Extrahera, ladda och transformera (ELT)

- Datasjö, data warehouse pipelines

- Realtidspipelines

- Machine learning pipelines

Datapipeline-komponenter för testautomatisering

Datapipelines består av flera komponenter, var och en ansvarig för en specifik uppgift. Elementen i en datapipeline inkluderar:

- Datakällor: Uppgifternas ursprung

- Dataintag: Processen att samla in data från datakällan

- Datatransformation: Processen att omvandla insamlad data till ett format som kan användas för vidare analys

- Dataverifieringar/valideringar: Processen för att säkerställa att uppgifterna är korrekta och konsekventa

- Datalagring: Processen att lagra de transformerade och validerade data i ett datalager eller datasjö

- Dataanalys: Processen att analysera lagrad data för att identifiera mönster, trender och insikter

Bästa praxis för automatisering av datapipelinetestning

Vad och när du ska automatisera (eller till och med om du behöver automatisera) är avgörande beslut för test- (eller utvecklings)teamet. Valet av lämpliga produktegenskaper för automatisering avgör till stor del automatiseringens framgång.

När du automatiserar tester för en datapipeline inkluderar bästa praxis:

- Definiera tydliga och specifika testmål: Innan du börjar testa är det viktigt att definiera vad du vill uppnå genom att testa. Om du gör det hjälper dig att skapa effektiva, effektiva tester som ger värdefulla insikter.

- Testa alla arbetsflöden i datapipeline: En datapipeline består vanligtvis av flera komponenter: dataintag, bearbetning, transformation och lagring. Det är viktigt att testa varje komponent för att säkerställa ett korrekt och smidigt dataflöde genom pipelinen.

- Använd trovärdiga testdata: När du testar en datapipeline är det viktigt att använda realistiska data som efterliknar verkliga scenarier. Detta hjälper till att identifiera eventuella problem som kan uppstå vid hantering av olika datatyper.

- Automatisera med effektiva verktyg: Detta kan uppnås med hjälp av testramar och verktyg.

- Övervaka pipelinen regelbundet: Även efter att testningen är klar är det viktigt att övervaka pipelinen regelbundet för att säkerställa att den fungerar som avsett. Detta kommer att hjälpa till att identifiera problem innan de blir kritiska problem.

- Engagera intressenter: Involvera intressenter som dataanalytiker, dataingenjörer och affärsanvändare i testprocessen. Detta kommer att hjälpa till att säkerställa att testerna är relevanta och värdefulla för alla intressenter.

- Underhåll dokumentation: Det är viktigt att upprätthålla dokument som beskriver testerna, testfallen och testresultaten. Detta kommer att hjälpa till att säkerställa att testerna kan replikeras och underhållas över tid.

Var försiktig; automatisering av ändrade instabila funktioner bör undvikas. Idag kan inget känt affärsverktyg eller uppsättning metoder/processer betraktas som ett komplett end-to-end-test av datapipeline.

Tänk på dina testautomatiseringsmål

Datapipeline testautomatisering beskrivs som att använda verktyg för att kontrollera 1) testkörning, 2) jämförelser av faktiska utfall med förutspådda utfall, och 3) inställning av testförutsättningar och andra testkontroll- och testrapporteringsfunktioner.

Generellt innebär testautomatisering automatisering av en befintlig manuell process som använder en formell testprocess.

Även om manuella datapipelinetester kan avslöja många databrister, är de arbetskrävande och tidskrävande. Dessutom kan manuell testning vara ineffektiv för att upptäcka vissa defekter.

Datapipelineautomatisering innebär att man utvecklar testprogram som annars skulle behöva utföras manuellt. När testerna väl är automatiserade kan de snabbt upprepas. Detta är ofta den mest kostnadseffektiva metoden för en datapipeline som kan ha lång livslängd. Även mindre korrigeringar eller förbättringar under pipelinens livstid kan göra att funktioner som fungerade tidigare går sönder.

Att integrera automatiserade tester i utvecklingen av datapipeline innebär en unik uppsättning utmaningar. Nuvarande testverktyg för automatiserad mjukvaruutveckling är inte lätt att anpassa till databas- och datapipelineprojekt.

Det stora utbudet av datapipeline-arkitekturer komplicerar dessa utmaningar ytterligare eftersom de involverar flera databaser som kräver speciell kodning för dataextraktion, transformationer, laddning, datarensning, dataaggregationer och databerikning.

Testautomationsverktyg kan vara dyra och används vanligtvis tillsammans med manuell testning. De kan dock bli kostnadseffektiva på lång sikt, särskilt när de används upprepade gånger i regressionstester.

Frekventa kandidater för testautomatisering

- BI rapporttestning

- Företag, myndighetsefterlevnad

- Bearbetning av dataaggregation

- Datarensning och arkivering

- Datakvalitetstester

- Dataavstämning (t.ex. källa till mål)

- Datatransformationer

- Dimensionstabelldata laddas

- End-to-end-testning

- ETL, ELT validerings- och verifieringstestning

- Faktatabellsdata laddas

- Verifiering av fil-/dataladdning

- Inkrementell belastningstestning

- Test av belastning och skalbarhet

- Saknade filer, poster, fält

- Prestandatester

- Referensintegritet

- Regressionstestning

- Säkerhetstest

- Källdatatestning och profilering

- Staging, ODS-datavalideringar

- Enhets-, integrations- och regressionstestning

Att automatisera dessa tester kan vara nödvändigt på grund av bearbetningens komplexitet och antalet källor och mål som bör verifieras.

För de flesta projekt är testprocesser för datapipeline utformade för att verifiera och implementera datakvalitet.

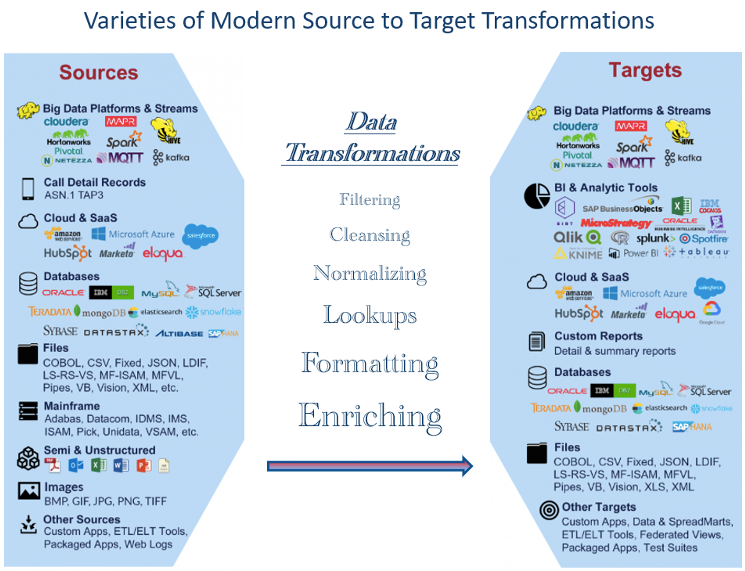

Mångfalden av datatyper som är tillgängliga idag innebär testningsutmaningar

Det finns ett brett utbud av datatyper tillgängliga idag, allt från traditionella strukturerade datatyper som text, siffror och datum till ostrukturerade datatyper som ljud, bilder och video. Dessutom används olika typer av semistrukturerad data, såsom XML och JSON, i stor utsträckning inom webbutveckling och datautbyte.

Med tillkomsten av Internet of Things (IoT) har det skett en explosion i olika datatyper, inklusive sensordata, platsdata och maskin-till-maskin kommunikationsdata. När dessa datatyper extraheras och transformeras kan testning bli mer komplicerad utan lämpliga verktyg. Detta har lett till nya datahanteringsteknologier och analytiska tekniker som strömbehandling, edge computing och realtidsanalys.

Figur 1 visar exempel på datatyper som används i stor utsträckning idag. Det stora antalet representerar utmaningar när man testar om nödvändiga transformationer är korrekt utförda. Som ett resultat måste dataproffs vara väl insatt i ett brett spektrum av datatyper och vara anpassningsbara för att testa nya trender och teknologier.

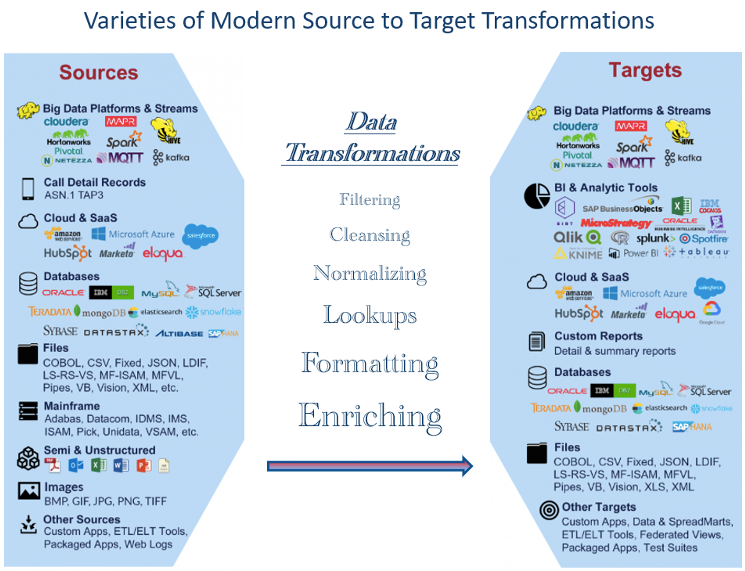

Utvärdera rörledningskomponenter för eventuell automatiserad testning

Ett nyckelelement i agila och andra moderna utvecklingar är automatiserad testning. Vi kan tillämpa denna medvetenhet på datapipeline.

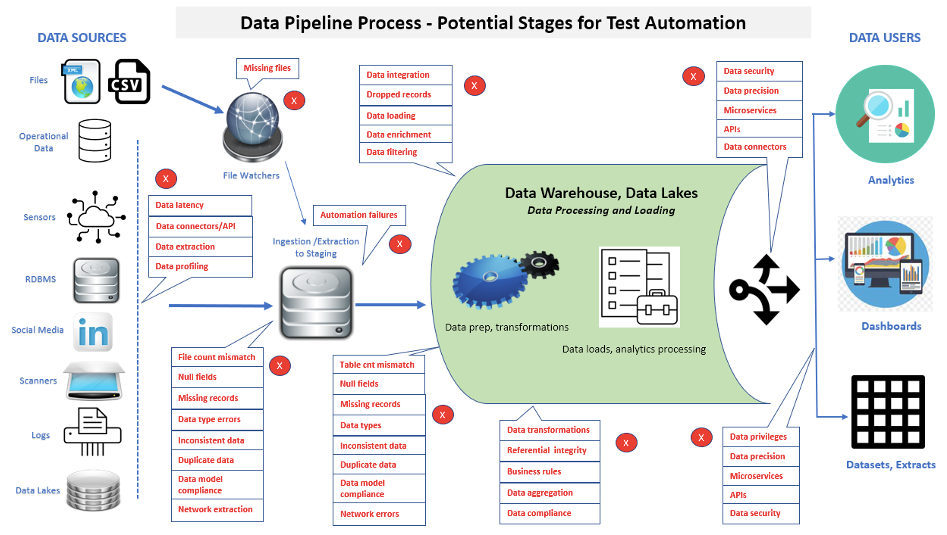

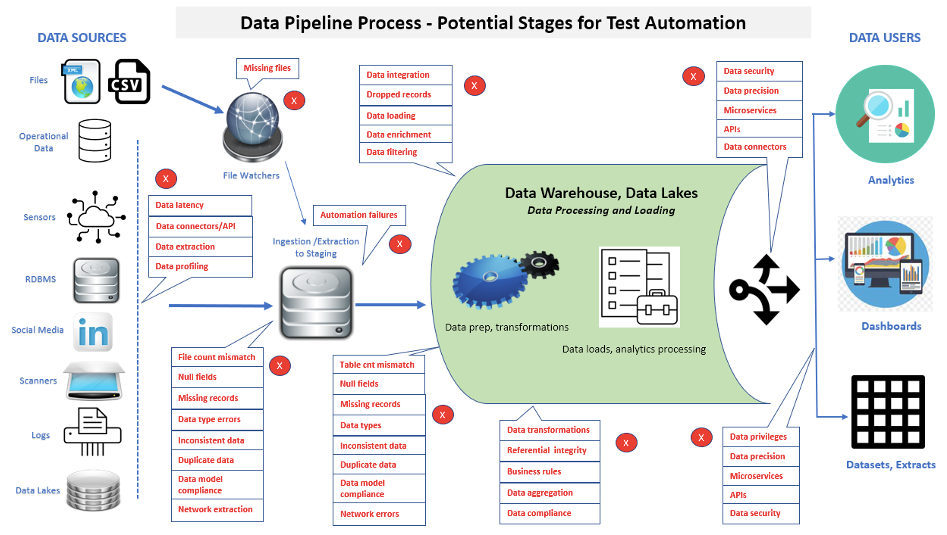

En väsentlig aspekt av datapipelinetestning är att antalet tester som utförs kommer att fortsätta att öka för att kontrollera extra funktionalitet och underhåll. figur 2 visar många områden där testautomatisering kan tillämpas i en datapipeline.

När man implementerar testautomatisering kan data spåras från källskikt, genom datapipelinebearbetning, till laddningar i datapipeline, och slutligen till front-end-applikationer eller rapporter. Anta att korrupta data hittas i en front-end-applikation eller rapport. I så fall kan exekveringen av automatiserade sviter hjälpa till att snabbare avgöra om enskilda problem finns i datakällor, en datapipelineprocess, en nyladdad datapipelinedatabas/datamart eller business intelligence/analytics-rapporter.

En betoning på snabb identifiering av data- och prestandaproblem i komplexa datapipeline-arkitekturer är ett nyckelverktyg för att främja utvecklingseffektivitet, förkorta byggcykler och uppfylla mål för releasekriterier.

Bestäm kategorier av tester som ska automatiseras

Tricket är att bestämma vad som ska automatiseras och hur varje uppgift ska hanteras. En uppsättning frågor bör övervägas när du automatiserar tester, till exempel:

- Vad kostar det att automatisera testerna?

- Vem är ansvarig för testautomatisering (t.ex. Dev., QA, dataingenjörer)?

- Vilka testverktyg ska användas (t.ex. öppen källkod, leverantör)?

- Kommer de valda verktygen att uppfylla alla förväntningar?

- Hur kommer testresultaten att rapporteras?

- Vem tolkar testresultaten?

- Hur kommer testskripten att underhållas?

- Hur kommer vi att organisera skripten för enkel och korrekt åtkomst?

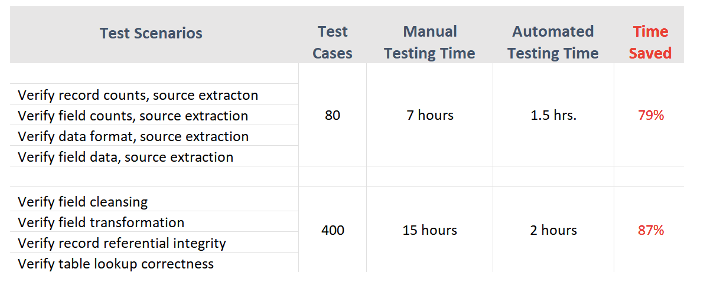

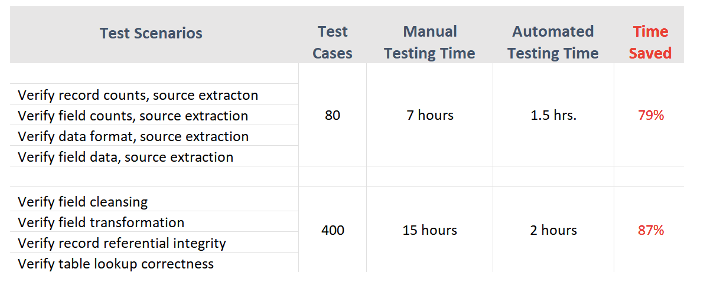

Figur 3 visar exempel på tidslängder (för testexekvering, defektidentifikationer och rapportering) för manuella kontra automatiserade testfall från en verklig projektupplevelse.

Automatiserad datapipelinetestning syftar till att täcka de mest kritiska funktionerna för att ladda en datapipeline – synkronisering och avstämning av käll- och måldata.

Fördelar och begränsningar med automatiserad testning

Testa automationsutmaningar

- Rapporttestning: Testa affärsintelligens eller analytiska rapporter genom automatisering

- Datakomplexitet: Datapipelinetestning involverar ofta komplexa datastrukturer och transformationer som kan vara utmanande att automatisera och kräver specialiserad expertis.

- Pipeline komplexitet: Datapipelines kan vara komplexa och kan involvera flera bearbetningssteg, vilket kan vara utmanande att testa och felsöka. Dessutom kan ändringar av en del av rörledningen få oavsiktliga konsekvenser nedströms.

Testautomationsfördelar

- Utför testfall snabbare: Automatisering kan påskynda implementeringen av testscenarier.

- Skapar en återanvändbar testsvit: När testskripten väl har körts med automationsverktygen kan de säkerhetskopieras för enkel återkallning och återanvändning.

- Förenklar testrapportering: En intressant egenskap hos många automatiserade verktyg är deras förmåga att producera rapporter och testfiler. Dessa funktioner representerar datastatus korrekt, identifierar tydligt brister och används i efterlevnadsrevisioner.

- Minskar kostnader för personal och omarbetning: Tid som läggs på manuell testning eller omtestning efter korrigering av defekter kan läggas på andra initiativ inom IT-avdelningen.

Potentiella begränsningar

- Kan inte helt ersätta manuell testning: Även om automatisering kan användas för olika applikationer och testfall, den kan inte helt ersätta manuell testning. Intrikata testfall kommer fortfarande att finnas där automatisering inte kommer att fånga allt, och för testning av användaracceptans måste slutanvändare ofta utföra tester manuellt. Därför är det viktigt att ha rätt kombination av automatiserad och manuell testning i processen.

- Kostnad för verktyg: Kommersiella testverktyg kan vara dyra, beroende på deras storlek och funktionalitet. På ytan kan ett företag se detta som en onödig kostnad. Men enbart återanvändning kan snabbt göra det till en tillgång.

- Kostnad för utbildning: Testare bör utbildas inte bara i programmering utan också i att schemalägga automatiserade tester. Automatiserade verktyg kan vara komplicerade att använda och kan behöva användarutbildning.

- Automation kräver planering, förberedelser och dedikerade resurser: Framgången för automatiserad testning är främst beroende av exakta testkrav och noggrann utveckling av testfall innan testningen påbörjas. Tyvärr är testfallsutveckling fortfarande i första hand en manuell process. Eftersom varje organisation och datapipelineapplikation kan vara unik skapar många automatiserade testverktyg inte testfall.

Komma igång med Data Pipeline Test Automation

Inte alla datapipelinetester är lämpliga för automatisering. Bedöm ovanstående situationer för att avgöra vilka typer av automatisering som skulle gynna din testprocess och hur mycket som behövs. Utvärdera dina testkrav och identifiera effektivitetsvinster som kan uppnås genom automatiserad testning. Datapipeline-team som ägnar mycket tid åt regressionstestning kommer att gynnas mest.

Utveckla ett affärscase för automatiserad testning. IT måste först göra saken för att förmedla värdet till verksamheten.

Utvärdera alternativen. Efter att ha utvärderat det aktuella tillståndet och kraven inom IT-avdelningen, bestäm vilka verktyg som passar organisationens testprocesser och miljöer. Alternativen kan inkludera leverantörer, öppen källkod, interna verktyg eller en blandning av verktyg.

Slutsatser

Eftersom testautomatisering snabbt har blivit ett viktigt alternativ till manuell testning, letar fler och fler företag efter verktyg och strategier för att framgångsrikt implementera automatisering. Detta har lett till en betydande tillväxt av testautomatiseringsverktyg baserade på Appium, Selenium, Katalon Studio och många andra. Datapipeline och dataingenjörer, BI och kvalitetssäkringsteam måste dock ha rätt programmeringskunskaper för att kunna använda dessa automationsverktyg fullt ut.

Många IT-experter har förutspått att kunskapsgapet mellan testare och utvecklare måste och kommer att minska kontinuerligt. Automatiserade testverktyg för datapipeline kan avsevärt minska tiden för testning av kod jämfört med konventionella manuella metoder.

I takt med att utvecklingsmöjligheterna för datapipeline fortsätter att öka, ökar också behovet av mer omfattande och moderna automatiserade datatester.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://www.dataversity.net/best-practices-in-data-pipeline-test-automation/

- :är

- $UPP

- 1

- a

- förmåga

- ovan

- godkännande

- tillgång

- Ackumulera

- exakt

- exakt

- Uppnå

- uppnås

- lagt till

- Dessutom

- Dessutom

- anta

- första advent

- Efter

- aggregation

- smidig

- Syftet

- Alla

- tillåta

- ensam

- alternativ

- Även

- analys

- analytiker

- Analytisk

- Analytisk

- analytics

- analys

- och

- Ansökan

- tillämpningar

- tillämpas

- Ansök

- lämpligt

- ÄR

- områden

- AS

- aspekt

- bedöma

- tillgång

- försäkran

- säker

- At

- audio

- revisioner

- automatisera

- Automatiserad

- automatisera

- Automation

- tillgänglig

- undvek

- medvetenhet

- dragen tillbaka

- baserat

- grund

- BE

- därför att

- blir

- innan

- Börjar

- fördel

- BÄST

- bästa praxis

- mellan

- Ha sönder

- bred

- fel

- SLUTRESULTAT

- företag

- business intelligence

- företag

- KAN

- kandidater

- kan inte

- kapacitet

- fånga

- noggrann

- Vid

- fall

- kategorier

- Orsak

- vissa

- utmaningar

- utmanande

- Förändringar

- byte

- karakteristiska

- egenskaper

- ta

- valda

- klar

- klart

- koda

- Kodning

- Samla

- kombination

- kommunicera

- Kommunikation

- jämfört

- fullborda

- fullständigt

- komplex

- Komplexiteten

- Efterlevnad

- komplicerad

- komponent

- komponenter

- omfattande

- databehandling

- Konsekvenser

- betydande

- anses

- fortsätta

- kontinuerlig

- kontinuerligt

- kontroll

- konventionell

- korrekt

- Pris

- kostnadseffektiv

- Kostar

- täcka

- skapa

- trovärdig

- kriterier

- kritisk

- avgörande

- Aktuella

- Nuvarande tillstånd

- cykler

- datum

- datarikning

- Datautbyte

- datahantering

- Datakvalitet

- datalagret

- Databas

- databaser

- DATAVERSITET

- Datum

- beslut

- dedicerad

- leverans

- Avdelning

- beroende

- beroende

- beskriven

- utformade

- Bestämma

- bestämd

- bestämmande

- dev

- utvecklare

- utveckla

- Utveckling

- utvecklingen

- olika

- flit

- displayer

- dokumentation

- dokument

- gör

- e

- varje

- Tidigare

- lätt

- kant

- kanten beräkning

- Effektiv

- effektiviteter

- effektivitet

- effektiv

- elementet

- element

- smärgel

- vikt

- början till slut

- Ingenjörer

- säkerställa

- miljöer

- speciellt

- väsentlig

- utvärdera

- Även

- Varje

- allt

- exempel

- utbyta

- utförande

- befintliga

- förväntningar

- förväntat

- dyra

- erfarenhet

- expertis

- experter

- extraktion

- snabbare

- Leverans

- Funktioner

- återkoppling

- Figur

- Filer

- Slutligen

- finna

- Förnamn

- brister

- flöda

- För

- formell

- format

- hittade

- ramar

- frekvent

- från

- fullständigt

- funktionalitet

- funktioner

- ytterligare

- Få

- resultat

- spalt

- Regeringen

- Tillväxt

- hantera

- Arbetsmiljö

- Hård

- Har

- har

- hjälpa

- Hög

- hög kvalitet

- höggradigt

- Hur ser din drömresa ut

- How To

- Men

- HTTPS

- Identifiering

- identifiera

- bilder

- genomföra

- genomförande

- genomföra

- med Esport

- in

- innefattar

- Inklusive

- Öka

- Ökar

- individuellt

- inledande

- initiativ

- integrering

- Intelligens

- intressant

- inre

- Internet

- sakernas Internet

- engagera

- innebär

- iot

- problem

- IT

- iteration

- json

- Nyckel

- kunskap

- känd

- sjö

- till stor del

- skikt

- inlärning

- Led

- livet

- livstid

- tycka om

- begränsningar

- läsa in

- läser in

- laster

- belägen

- läge

- Lång

- du letar

- underhåll

- göra

- ledning

- manuell

- manuellt

- många

- max-bredd

- Möt

- möte

- metod

- metoder

- mindre

- Modern Konst

- Övervaka

- mer

- mest

- multipel

- nödvändigt för

- Behöver

- behövs

- behov

- Nya

- Nästa

- antal

- nummer

- mål

- of

- on

- ONE

- öppet

- öppen källkod

- Tillbehör

- organisation

- Ursprung

- Övriga

- Övrigt

- annat

- del

- mönster

- utföra

- prestanda

- perioder

- fas

- rörledning

- planering

- plato

- Platon Data Intelligence

- PlatonData

- möjlig

- praxis

- exakt

- förutsagda

- presenterar

- primärt

- problem

- process

- processer

- bearbetning

- producera

- Produkt

- yrkesmän/kvinnor

- Programmering

- Program

- projektet

- projekt

- främja

- rätt

- ge

- ger

- Syftet

- Frågor och svar

- kvalitet

- frågor

- snabbt

- område

- som sträcker sig

- snabb

- snabbt

- SÄLLSYNT

- verkliga världen

- realtid

- realistisk

- avstämning

- register

- minska

- regression

- regelbunden

- regelbundet

- frigöra

- relevanta

- förlita

- upprepade

- UPPREPAT

- ersätta

- replikeras

- rapport

- Rapporterad

- Rapportering

- Rapport

- representerar

- representerar

- kräver

- Obligatorisk

- Krav

- Kräver

- Resurser

- ansvarig

- resultera

- Resultat

- återanvändbar

- avslöjar

- Körning

- skalbarhet

- scenarier

- schemaläggning

- skript

- Val

- service

- in

- inställning

- flera

- skall

- Visar

- signifikant

- signifikant

- situationer

- Storlek

- färdigheter

- So

- Mjukvara

- mjukvaruutveckling

- Källa

- Källor

- speciell

- specialiserad

- specifik

- fart

- spent

- bemanning

- stadier

- intressenter

- starta

- igång

- Ange

- status

- Fortfarande

- förvaring

- lagras

- strategier

- ström

- strukturerade

- studio

- framgång

- Framgångsrikt

- sådana

- lämplig

- svit

- yta

- synkronisering

- bord

- tar

- Målet

- mål

- uppgift

- grupp

- lag

- Teknisk

- tekniker

- Tekniken

- testa

- Testning

- tester

- den där

- Smakämnen

- deras

- därför

- Dessa

- saker

- Genom

- tid

- tidskrävande

- till

- i dag

- alltför

- verktyg

- verktyg

- traditionell

- tränad

- Utbildning

- Förvandla

- Transformation

- transformationer

- transformerad

- omvandla

- Trender

- typer

- unika

- användning

- Användare

- användare

- vanligen

- validerade

- godkännande

- Värdefulla

- värde

- mängd

- olika

- Omfattande

- leverantör

- försäljare

- Verifiering

- verifierade

- verifiera

- Video

- utsikt

- avgörande

- vs

- Warehouse

- webb

- Webbutveckling

- Vad

- om

- som

- VEM

- bred

- brett

- kommer

- med

- inom

- utan

- arbetsflöden

- arbetssätt

- skulle

- XML

- Din

- zephyrnet