Goodharts lag berömt säger: "När en åtgärd blir ett mål, slutar den att vara ett bra mått." Även om det ursprungligen kommer från ekonomi, är det något vi måste brottas med på OpenAI när vi ska ta reda på hur man kan optimera mål som är svåra eller kostsamma att mäta. Det är ofta nödvändigt att introducera några proxy mål det är lättare eller billigare att mäta, men när vi gör detta måste vi vara försiktiga så att vi inte optimerar det för mycket.

Till exempel som en del av vårt arbete med att rikta modeller som GPT-3 med mänskliga avsikter och värderingar skulle vi vilja optimera saker som "Hur hjälp är det här svaret?” eller ”Hur faktiskt korrekt är detta påstående?”. Dessa är komplexa mål som kräver att människor noggrant kontrollerar saker och ting. Av denna anledning tränar vi en modell för att förutsäga dessa mänskliga preferenser, känd som en belöningsmodell, och använd belöningsmodellens förutsägelser som ett proxymål. Men det är viktigt att hålla reda på hur väl det verkliga målet optimeras.

I det här inlägget ska vi titta på lite av matematiken bakom hur vi gör detta. Vi kommer att fokusera på en miljö som är särskilt ren att analysera, där vi har tillgång till det verkliga målet. I praktiken kan även mänskliga preferenser misslyckas med att mäta vad vi verkligen bryr oss om, men vi lägger den frågan åt sidan i det här inlägget.

Best-of-$n$-provtagning

Det finns många sätt på vilka man kan optimera proxymålet, men det enklaste är kanske best-of-$n$ provtagning, också känd som provtagning av avslag or omplacering. Vi samplar helt enkelt $n$ gånger och tar den som får högst poäng enligt proxymålet.

Även om den här metoden är väldigt enkel, kan den faktiskt vara konkurrenskraftig med mer avancerade tekniker som förstärkningsinlärning, om än till priset av mer slutledningstidsberäkning. Till exempel i WebGPT, vår bäst-av-$64$-modell överträffade vår förstärkningsinlärningsmodell, kanske delvis för att modellen bäst-av-$64$ fick surfa på många fler webbplatser. Till och med att applicera det bästa av-$4$ gav ett betydande lyft för mänskliga preferenser.

Dessutom har best-of-$n$-sampling tillförlitlig prestanda och är enkel att analysera matematiskt, vilket gör den väl lämpad för empiriska studier av Goodharts lag och relaterade fenomen.

Matematiken för best-of-$n$-sampling

Låt oss studera best-of-$n$-sampling mer formellt. Anta att vi har ett provutrymme $S$ (som uppsättningen av möjliga fråga-svar-par), en viss sannolikhetsfördelning $P$ över $S$, ett sant mål (eller "belöning") $R_{text{true}}:Stomathbb R$, och ett proxymål $R_{text{proxy}}:Stomathbb R$. Låt oss säga att vi på något sätt optimerar $R_{text{proxy}}$ och därigenom får en ny distribution $P^prime$. Sedan:

- Förväntningen $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ mäter hur väl vi har optimerat det verkliga målet.

- Smakämnen KL divergens $D_{text{KL}}left(P^primeparallel Pright)$ mäter hur mycket optimering vi har gjort. Till exempel, om $P^prime$ erhålls genom att ta det första provet från $P$ som ligger i någon delmängd $S^primesubseteq S$, då är denna KL-divergens bara den negativa log-sannolikheten att ett urval från $P$ ligger i $S^prime$.

Det visar sig att vid best-of-$n$-provtagning kan båda dessa kvantiteter uppskattas effektivt med hjälp av prover från $P$.

Låt oss först titta på förväntningarna. Det naiva tillvägagångssättet är att använda en Monte Carlo-estimator: kör best-of-$n$-sampling många gånger, mät det verkliga målet på dessa prover och gör ett genomsnitt av resultaten. Det finns dock en bättre skattare. Om vi har $Ngeq n$ prover från $P$ totalt sett kan vi samtidigt överväga varje möjlig delmängd av dessa prover av storlek $n$, vikta varje prov med antalet delmängder för vilka det är bäst enligt proxymålet, och sedan ta det viktade genomsnittliga sanna objektivpoängen. Denna vikt är bara den binomiala koefficienten $binom{k-1}{n-1}$, där $k$ är rankningen för provet under proxymålet, från $1$ (sämsta) upp till $N$ (bäst). Förutom att använda prover mer effektivt, tillåter detta oss också att återanvända prover för olika värden på $n$.

När det gäller KL-divergensen visar det sig överraskande nog ha en exakt formel som fungerar för alla kontinuerliga sannolikhetsfördelningar $P$ (dvs. så länge som $P$ inte har några poängmassor). Man kan naivt gissa att svaret är $log n$, eftersom best-of-$n$ gör något som att ta den översta $frac 1n$ av distributionen, och detta är ungefär korrekt: det exakta svaret är $log n-frac{n-1}n$.

Tillsammans låter dessa skattare oss enkelt analysera hur det verkliga målet varierar med mängden optimering som tillämpas på proxymålet.

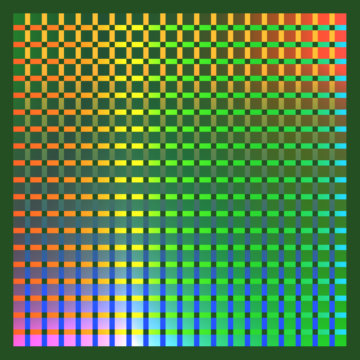

Här är ett verkligt exempel från WebGPT:

Best-of-$n$-prestanda för WebGPT 175B

Best-of-$n$-prestanda för WebGPT, med skuggade områden som representerar $pm 1$ standardfel och KL-axeln följer en kvadratrotsskala. Här ges den ursprungliga fördelningen ($P$) av 175B-modellen tränad med beteendekloning, proxymålet som används för att beräkna best-of-$n$ ($R_{text{proxy}}$) ges av träningen belöningsmodell, och vi överväger tre förmodat "sanna" mål ($R_{text{true}}$): själva träningsbelöningsmodellen, en valideringsmodell för belöning som tränats på förvarad data och faktiska mänskliga preferenser. Det finns inte mycket överoptimering av proxy-målet, men vi förväntar oss att det finns vid högre KL.

Går längre än best-of-$n$-sampling

Den huvudsakliga begränsningen för best-of-$n$-sampling är att KL-divergensen växer logaritmiskt med $n$, så den är endast lämplig för att tillämpa en liten mängd optimering.

För att tillämpa mer optimering använder vi vanligtvis förstärkningsinlärning. I de inställningar vi har studerat hittills, som t.ex sammanfattning, vi har vanligtvis kunnat nå en KL på cirka 10 nats använder förstärkningsinlärning innan det verkliga målet börjar minska på grund av Goodharts lag. Vi skulle behöva ta $n$ för att vara runt 60,000 XNUMX för att nå denna KL med hjälp av bäst av-$n$, och vi hoppas kunna nå mycket större KL:er än så här med förbättringar av vår belöningsmodellering och förstärkningsinlärning.

Men alla nats är inte lika. Empiriskt, för små KL-budgetar, optimerar best-of-$n$ bättre både proxyn och de verkliga målen än förstärkningsinlärning. Intuitivt är best-of-$n$ metoden "brute force", vilket gör den mer informationsteoretiskt effektiv än förstärkningsinlärning, men mindre beräkningseffektiv i stora KL:er.

Vi studerar aktivt skalningsegenskaperna för proxymål som en del av vårt arbete med att rikta våra modeller med mänskliga avsikter och värderingar. Om du vill hjälpa oss med den här forskningen gör vi det anställa!

- AI

- ai konst

- ai art generator

- har robot

- artificiell intelligens

- artificiell intelligenscertifiering

- artificiell intelligens inom bankväsendet

- artificiell intelligens robot

- robotar med artificiell intelligens

- programvara för artificiell intelligens

- blockchain

- blockchain konferens ai

- coingenius

- konversationskonstnärlig intelligens

- kryptokonferens ai

- dalls

- djupt lärande

- du har google

- maskininlärning

- OpenAI

- plato

- plato ai

- Platon Data Intelligence

- Platon spel

- PlatonData

- platogaming

- forskning

- skala ai

- syntax

- zephyrnet