När det gäller brain computing är timing allt. Det är hur nervceller kopplas in i kretsar. Det är hur dessa kretsar behandlar mycket komplexa data, vilket leder till handlingar som kan innebära liv eller död. Det är så våra hjärnor kan fatta beslut på en del av en sekund, även när de står inför helt nya omständigheter. Och det gör vi utan att steka hjärnan av omfattande energiförbrukning.

För att omformulera, är hjärnan ett utmärkt exempel på en extremt kraftfull dator att efterlikna – och datavetare och ingenjörer har tagit de första stegen mot att göra det. Området neuromorfisk beräkning ser ut att återskapa hjärnans arkitektur och databearbetningsförmåga med nya hårdvaruchips och mjukvarualgoritmer. Det kan vara en väg mot sanning artificiell intelligens.

Men ett avgörande element saknas. De flesta algoritmer som driver neuromorfa chips bryr sig bara om bidraget från varje artificiell neuron - det vill säga hur starkt de kopplar till varandra, kallat "synaptisk vikt". Det som saknas – som ändå är liktydigt med vår hjärnas inre arbete – är timing.

Den här månaden tillade ett team knutet till Human Brain Project, Europeiska unionens flaggskepp för big data neurovetenskap. tidselementet till en neuromorf algoritm. Resultaten implementerades sedan på fysisk hårdvara—den BrainScaleS-2 neuromorfisk plattform – och ställs mot toppmoderna GPU:er och konventionella neuromorfa lösningar.

"Jämfört med de abstrakta neurala nätverk som används vid djupinlärning, ligger de mer biologiska arketyperna ... fortfarande efter när det gäller prestanda och skalbarhet" på grund av deras inneboende komplexitet, sa författarna.

I flera tester jämförde algoritmen "gynnsamt, när det gäller noggrannhet, latens och energieffektivitet" på ett standard benchmarktest, sade Dr Charlotte Frenkel vid universitetet i Zürich och ETH Zürich i Schweiz, som inte var involverad i studien. Genom att lägga till en temporal komponent i neuromorfisk beräkning, kan vi inleda en ny era av högeffektiv AI som går från statiska datauppgifter – till exempel bildigenkänning – till en som bättre kapslar in tid. Tänk på videor, biosignaler eller hjärna-till-dator-tal.

För huvudförfattaren Dr. Mihai Petrovici går potentialen åt båda hållen. "Vårt arbete är inte bara intressant för neuromorfa datorer och biologiskt inspirerad hårdvara. Den erkänner också kravet ... att överföra så kallade djupinlärningsmetoder till neurovetenskap och därigenom ytterligare avslöja den mänskliga hjärnans hemligheter, säger han. sade.

Låt oss prata spikar

Grunden till den nya algoritmen är en grundläggande princip i hjärnanvändning: spikar.

Låt oss ta en titt på en mycket abstraherad neuron. Det är som en tootsie-rulle, med en lökformig mittsektion flankerad av två utåtgående omslag. En sida är ingången - ett intrikat träd som tar emot signaler från en tidigare neuron. Den andra är utsignalen som spränger signaler till andra nervceller med hjälp av bubbelliknande skepp fyllda med kemikalier, vilket i sin tur utlöser ett elektriskt svar på den mottagande änden.

Här är kärnan: för att hela den här sekvensen ska inträffa måste neuronen "spike". Om, och bara om, neuronen får en tillräckligt hög nivå av input – en snyggt inbyggd brusreduceringsmekanism – kommer den bulbousiga delen att generera en spik som går ner i utgångskanalerna för att varna nästa neuron.

Men neuroner använder inte bara en spik för att förmedla information. Snarare spetsar de i en tidssekvens. Tänk på det som morsekod: tidpunkten för när en elektrisk skur inträffar innehåller en mängd data. Det är grunden för att neuroner kopplas in i kretsar och hierarkier, vilket möjliggör mycket energieffektiv bearbetning.

Så varför inte använda samma strategi för neuromorfa datorer?

Ett spartanskt hjärnliknande chip

Istället för att kartlägga en enda artificiell neurons spikar – en herkulisk uppgift – arbetade teamet på ett enda mått: hur lång tid det tar för en neuron att avfyras.

Idén bakom "tid-till-första-spik"-koden är enkel: ju längre tid det tar en neuron att spika, desto lägre är dess aktivitetsnivåer. Jämfört med att räkna spikar är det ett extremt sparsamt sätt att koda en neurons aktivitet, men kommer med förmåner. Eftersom endast latensen till första gången en neuron piggar upp används för att koda aktivering, fångar den neurons lyhördhet utan att överväldiga en dator med för många datapunkter. Det är med andra ord snabbt, energieffektivt och enkelt.

Teamet kodade sedan algoritmen på ett neuromorfiskt chip - det BrainScaleS-2, som ungefär emulerar enkla "neuroner" inuti sin struktur, men körs över 1,000 XNUMX gånger snabbare än våra biologiska hjärnor. Plattformen har över 500 fysiska artificiella neuroner, som var och en kan ta emot 256 ingångar genom konfigurerbara synapser, där biologiska neuroner byter, bearbetar och lagrar information.

Upplägget är en hybrid. "Inlärning" uppnås på ett chip som implementerar den tidsberoende algoritmen. Men alla uppdateringar av den neurala kretsen - det vill säga hur starkt en neuron ansluter till en annan - uppnås genom en extern arbetsstation, något som kallas "in-the-loop-träning".

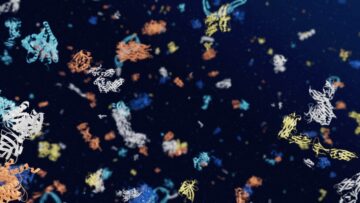

I ett första test utmanades algoritmen med uppgiften "Yin-Yang", som kräver att algoritmen analyserar olika områden i den traditionella österländska symbolen. Algoritmen utmärkte sig, med ett genomsnitt på 95 procents noggrannhet.

Teamet utmanade sedan installationen med en klassisk djupinlärningsuppgift—MNIST, en datauppsättning av handskrivna siffror som revolutionerade datorseendet. Algoritmen utmärkte sig igen, med nästan 97 procents noggrannhet. Ännu mer imponerande, BrainScaleS-2-systemet tog mindre än en sekund att klassificera 10,000 XNUMX testprover, med extremt låg relativ energiförbrukning.

Genom att sätta dessa resultat i sitt sammanhang jämförde teamet sedan BrainScaleS-2:s prestanda – beväpnad med den nya algoritmen – med kommersiella och andra neuromorfa plattformar. Ta Spinnaker, en massiv, parallellt distribuerad arkitektur som också efterliknar neural beräkning och spikar. Den nya algoritmen var över 100 gånger snabbare vid bildigenkänning samtidigt som den förbrukade bara en bråkdel av strömmen som SpiNNaker förbrukar. Liknande resultat sågs med True North, förebudet IBMs neuromorfa chip.

Vad händer nu?

Hjärnans två mest värdefulla datorfunktioner – energieffektivitet och parallell bearbetning – inspirerar nu starkt nästa generations datorchips. Målet? Bygg maskiner som är lika flexibla och anpassningsbara som våra egna hjärnor samtidigt som de använder bara en bråkdel av den energi som krävs för våra nuvarande kiselbaserade chips.

Men jämfört med djupinlärning, som är beroende av artificiella neurala nätverk, har biologiskt rimliga nätverk försvunnit. En del av detta, förklarade Frenkel, är svårigheten att "uppdatera" dessa kretsar genom inlärning. Men med BrainScaleS-2 och en touch av tidsdata är det nu möjligt.

Samtidigt, att ha en "extern" skiljedomare för att uppdatera synaptiska anslutningar ger hela systemet lite tid att andas. Neuromorf hårdvara, som liknar stökigheten i vår hjärnberäkning, är fylld med felmatchningar och fel. Med chippet och en extern skiljedomare kan hela systemet lära sig att anpassa sig till denna variation och så småningom kompensera för – eller till och med utnyttja – dess egenheter för snabbare och mer flexibel inlärning.

För Frenkel ligger algoritmens kraft i dess gleshet. Hjärnan, förklarade hon, drivs av glesa koder som "kan förklara de snabba reaktionstiderna ... som för visuell bearbetning." Istället för att aktivera hela hjärnregioner behövs bara ett fåtal neurala nätverk – som att susa nerför tomma motorvägar istället för att fastna i rusningstrafiken.

Trots sin kraft har algoritmen fortfarande hicka. Den kämpar med att tolka statisk data, även om den utmärker sig med tidssekvenser - till exempel tal eller biosignaler. Men för Frenkel är det början på ett nytt ramverk: viktig information kan kodas med ett flexibelt men enkelt mått och generaliseras för att berika hjärn- och AI-baserad databehandling med en bråkdel av de traditionella energikostnaderna.

"[Det]...kan vara en viktig språngbräda för att spika neuromorf hårdvara för att äntligen visa en konkurrensfördel jämfört med konventionella neurala nätverksmetoder," sa hon.

Bildkredit: Klassificering av datapunkter i Yin-Yang dataset, av Göltz och Kriener et al. (Heidelberg / Bern)

- 000

- 100

- Fördel

- AI

- algoritm

- algoritmer

- tillåta

- arkitektur

- Artificiellt nervsystem

- Författarna

- riktmärke

- Stora data

- Hjärnorna

- SLUTRESULTAT

- vilken

- kanaler

- kemikalier

- chip

- Pommes frites

- koda

- kommersiella

- komponent

- Datorsyn

- datorer

- databehandling

- Anslutningar

- konsumtion

- Kostar

- kredit

- Aktuella

- datum

- databehandling

- djupt lärande

- Efterfrågan

- östra

- effektivitet

- energi

- Ingenjörer

- ETH

- ETH Zurich

- Giltigt körkort

- SNABB

- Slutligen

- natur

- Förnamn

- första gången

- Ramverk

- GPUs

- hårdvara

- Hög

- motorvägar

- Hur ser din drömresa ut

- HTTPS

- Hybrid

- IBM

- Tanken

- bild

- Bildigenkänning

- informationen

- involverade

- IT

- leda

- ledande

- LÄRA SIG

- inlärning

- Nivå

- Lång

- Maskiner

- förflyttar

- nät

- nätverk

- neural

- neurala nätverk

- neurala nätverk

- Neuroscience

- Brus

- Nord

- nummer

- Övriga

- prestanda

- fysisk

- plattform

- Plattformar

- kraft

- projektet

- Reaktionen

- respons

- Resultat

- Rulla

- rusa

- vetenskapsmän

- fartyg

- Enkelt

- So

- Mjukvara

- Lösningar

- starta

- lagra

- Strategi

- Läsa på

- schweiz

- system

- testa

- tester

- tid

- Rör

- trafik

- Utbildning

- universitet

- Uppdateringar

- Video

- syn

- Rikedom

- VEM

- wikipedia

- Wire

- ord

- Arbete

- zurich