Machine Learning är ett stort område med ny forskning som kommer ut ofta. Det är ett hett område där akademin och industrin fortsätter att experimentera med nya saker för att förbättra vårt dagliga liv.

Under de senaste åren har generativ AI förändrat världen på grund av tillämpningen av maskininlärning. Till exempel, ChatGPT och Stable Diffusion. Även med 2023 dominerad av generativ AI borde vi vara medvetna om många fler genombrott för maskininlärning.

Här är de bästa maskininlärningspapperna att läsa under 2023 så att du inte kommer att missa de kommande trenderna.

1) Lär dig skönheten i sånger: Neural Singing Voice Beautifier

Singing Voice Beautifying (SVB) är en ny uppgift inom generativ AI som syftar till att förbättra amatörsångrösten till en vacker sådan. Det är precis forskningsmålet Liu et al. (2022) när de föreslog en ny generativ modell som heter Neural Singing Voice Beautifier (NSVB).

NSVB är en semi-övervakad inlärningsmodell som använder en latent kartläggningsalgoritm som fungerar som en tonhöjdskorrigerare och förbättrar rösttonen. Verket lovar att förbättra musikbranschen och är värt att kolla in.

2) Symbolisk upptäckt av optimeringsalgoritmer

Djupa neurala nätverksmodeller har blivit större än någonsin, och mycket forskning har utförts för att förenkla träningsprocessen. Ny forskning från Google-teamet (Chen et al. (2023)) har föreslagit en ny optimering för det neurala nätverket kallat Lion (EvoLved Sign Momentum). Metoden visar att algoritmen är mer minneseffektiv och kräver en mindre inlärningshastighet än Adam. Det är fantastisk forskning som visar på många löften du inte bör missa.

3) TimesNet: Temporal 2D-variationsmodellering för allmän tidsserieanalys

Tidsserieanalys är ett vanligt användningsfall i många företag; Till exempel prisprognoser, avvikelsedetektering etc. Det finns dock många utmaningar med att analysera tidsdata endast baserat på aktuell data (1D-data). Det är därför Wu et al. (2023) föreslå en ny metod som kallas TimesNet för att omvandla 1D-data till 2D-data, vilket ger bra prestanda i experimentet. Du bör läsa uppsatsen för att bättre förstå denna nya metod eftersom den skulle hjälpa mycket framtida tidsserieanalys.

4) OPT: Öppna förutbildade transformatorspråkmodeller

För närvarande befinner vi oss i en generativ AI-era där många stora språkmodeller utvecklades intensivt av företag. Oftast skulle denna typ av forskning inte släppa sin modell eller bara vara kommersiellt tillgänglig. Forskargruppen Meta AI (Zhang et al. (2022)) försöker göra tvärtom genom att offentligt släppa Open Pre-trained Transformers (OPT)-modellen som kan vara jämförbar med GPT-3. Uppsatsen är en bra start på att förstå OPT-modellen och forskningsdetaljen, eftersom gruppen loggar alla detaljer i uppsatsen.

5) REaLTabFormer: Generera realistiska relations- och tabelldata med hjälp av transformatorer

Den generativa modellen är inte begränsad till att bara generera text eller bilder utan även tabelldata. Dessa genererade data kallas ofta syntetiska data. Många modeller utvecklades för att generera syntetisk tabelldata, men nästan ingen modell för att generera relationell tabellformad syntetisk data. Detta är precis syftet med Solatorio och Dupriez (2023) forskning; skapa en modell som heter REaLTabFormer för syntetisk relationsdata. Experimentet har visat att resultatet ligger exakt nära den befintliga syntetiska modellen, som skulle kunna utvidgas till många applikationer.

6) Är förstärkningsinlärning (inte) för bearbetning av naturligt språk?: Benchmarks, baslinjer och byggstenar för optimering av naturlig språkpolitik

Förstärkning Att lära sig konceptuellt är ett utmärkt val för uppgiften Natural Language Processing, men är det sant? Detta är en fråga som Ramamurthy et al. (2022) försök svara. Forskaren introducerar olika bibliotek och algoritmer som visar var Reinforcement Learning-tekniker har ett försprång jämfört med den övervakade metoden i NLP-uppgifterna. Det är ett rekommenderat papper att läsa om du vill ha ett alternativ för din kompetens.

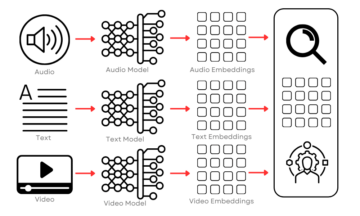

7) Tune-A-Video: One-Shot-justering av bilddiffusionsmodeller för text-till-video-generering

Text-till-bild-genereringen var stor 2022, och 2023 skulle projiceras med text-till-video-kapacitet (T2V). Forskning av Wu et al. (2022) visar hur T2V kan utökas på många sätt. Forskningen föreslår en ny Tune-a-Video-metod som stöder T2V-uppgifter som ämnes- och objektförändring, stilöverföring, attributredigering, etc. Det är en bra artikel att läsa om du är intresserad av text-till-video-forskning.

8) PyGlove: Effektivt utbyte av ML-idéer som kod

Effektivt samarbete är nyckeln till framgång i alla lag, särskilt med den ökande komplexiteten inom maskininlärningsområden. För att främja effektivitet, Peng et al. (2023) presentera ett PyGlove-bibliotek för att enkelt dela ML-idéer. PyGlove-konceptet är att fånga processen för ML-forskning genom en lista med lappningsregler. Listan kan sedan återanvändas i valfri experimentscen, vilket förbättrar teamets effektivitet. Det är forskning som försöker lösa ett maskininlärningsproblem som många inte har gjort ännu, så det är värt att läsa.

8) Hur nära är ChatGPT mänskliga experter? Jämförelsekorpus, utvärdering och upptäckt

ChatGPT har förändrat världen så mycket. Det är säkert att säga att trenden skulle gå uppåt härifrån eftersom allmänheten redan är för att använda ChatGPT. Men hur är ChatGPT nuvarande resultat jämfört med mänskliga experter? Det är precis en fråga det Guo et al. (2023) försök svara. Teamet försökte samla in data från experter och ChatGPT-promptresultat, som de jämförde. Resultatet visar att implicita skillnader mellan ChatGPT och experter fanns där. Forskningen är något som jag tror kommer att bli frågad i framtiden eftersom den generativa AI-modellen skulle fortsätta växa över tiden, så det är värt att läsa.

2023 är ett bra år för forskning om maskininlärning som visas av den nuvarande trenden, särskilt generativ AI som ChatGPT och Stable Diffusion. Det finns mycket lovande forskning som jag anser att vi inte bör missa eftersom den har visat lovande resultat som kan ändra den nuvarande standarden. I den här artikeln har jag visat dig 9 bästa ML-artiklar att läsa, allt från den generativa modellen, tidsseriemodellen till arbetsflödeseffektivitet. Jag hoppas att det hjälper.

Cornellius Yudha Wijaya är biträdande chef för datavetenskap och dataskribent. Medan han arbetar heltid på Allianz Indonesia älskar han att dela Python- och Data-tips via sociala medier och skrivande media.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://www.kdnuggets.com/2023/03/top-machine-learning-papers-read-2023.html?utm_source=rss&utm_medium=rss&utm_campaign=top-machine-learning-papers-to-read-in-2023

- :är

- 2022

- 2023

- 2D

- 9

- a

- Akademin

- exakt

- uppnår

- handlingar

- Adam

- AI

- ai forskning

- Syftet

- AL

- algoritm

- Alla

- Allianz

- redan

- alternativ

- amatör-

- analys

- analys

- och

- avvikelse av anomali

- svara

- Ansökan

- tillämpningar

- tillvägagångssätt

- ÄR

- Artikeln

- AS

- Assistent

- At

- tillgänglig

- baserat

- BE

- vackert

- Skönhet

- därför att

- blir

- riktmärken

- Bättre

- mellan

- Stor

- större

- Block

- genombrott

- Byggnad

- företag

- by

- kallas

- KAN

- fånga

- Vid

- utmaningar

- byta

- byte

- ChatGPT

- kontroll

- val

- Stänga

- samverkan

- samla

- kommande

- kommersiellt

- Gemensam

- Företag

- jämförbar

- jämfört

- jämförelse

- Komplexiteten

- begrepp

- konceptuellt

- genomfördes

- kunde

- Skapa

- Aktuella

- dagligen

- datum

- datavetenskap

- detalj

- Detektering

- utvecklade

- skillnader

- Diffusion

- Upptäckten

- lätt

- kant

- effektivitet

- effektivt

- Era

- speciellt

- etc

- utvärdering

- Även

- NÅGONSIN

- utvecklats

- exakt

- exempel

- utmärkt

- utbyte

- befintliga

- experimentera

- experter

- gynna

- fält

- Fält

- För

- ofta

- från

- framtida

- Allmänt

- generera

- genereras

- generera

- generering

- generativ

- Generativ AI

- generativ modell

- Go

- stor

- Grupp

- Odling

- Har

- hjälpa

- hjälper

- här.

- hoppas

- HET

- Hur ser din drömresa ut

- Men

- HTTPS

- humant

- i

- idéer

- bild

- förbättra

- förbättrar

- in

- ökande

- Indonesien

- industrin

- intresserad

- Introducerar

- IT

- jpg

- KDnuggets

- Ha kvar

- Nyckel

- Snäll

- språk

- Large

- inlärning

- Bibliotek

- Begränsad

- Lion

- Lista

- Bor

- Maskinen

- maskininlärning

- chef

- många

- Media

- meta

- metod

- kanske

- ML

- modell

- modellering

- modeller

- Momentum

- mer

- musikal

- Natural

- Naturligt språk

- Naturlig språkbehandling

- nät

- neural

- neurala nätverk

- Nya

- nlp

- roman

- objektet

- of

- on

- ONE

- öppet

- motsatt

- optimering

- Papper

- papper

- Patching

- prestanda

- Bilder

- Tonhöjd

- plato

- Platon Data Intelligence

- PlatonData

- policy

- presentera

- pris

- Problem

- process

- bearbetning

- projicerade

- lovar

- lovande

- föreslå

- föreslagen

- föreslår

- allmän

- publicly

- Python

- fråga

- som sträcker sig

- Betygsätta

- Läsa

- Läsning

- realistisk

- senaste

- rekommenderas

- förstärkning lärande

- frigöra

- Kräver

- forskning

- forskargrupp

- forskaren

- resultera

- Resultat

- regler

- s

- säker

- scen

- Vetenskap

- Serier

- Dela

- skall

- visas

- Visar

- signera

- förenkla

- kompetens

- mindre

- So

- Social hållbarhet

- sociala medier

- LÖSA

- något

- stabil

- standard

- starta

- stil

- ämne

- framgång

- sådana

- Stöder

- syntetisk

- syntetiska data

- uppgift

- uppgifter

- grupp

- tekniker

- den där

- Smakämnen

- Framtiden

- världen

- deras

- Där.

- saker

- Genom

- tid

- Tidsföljder

- Tips

- till

- TON

- topp

- Utbildning

- överföring

- Förvandla

- transformatorer

- Trend

- Trender

- sann

- förstå

- förståelse

- kommande

- uppåt

- användning

- användningsfall

- olika

- via

- Röst

- som

- medan

- kommer

- med

- inom

- Arbete

- arbetsflöde

- arbetssätt

- världen

- värt

- skulle

- författare

- skrivning

- år

- år

- Din

- zephyrnet