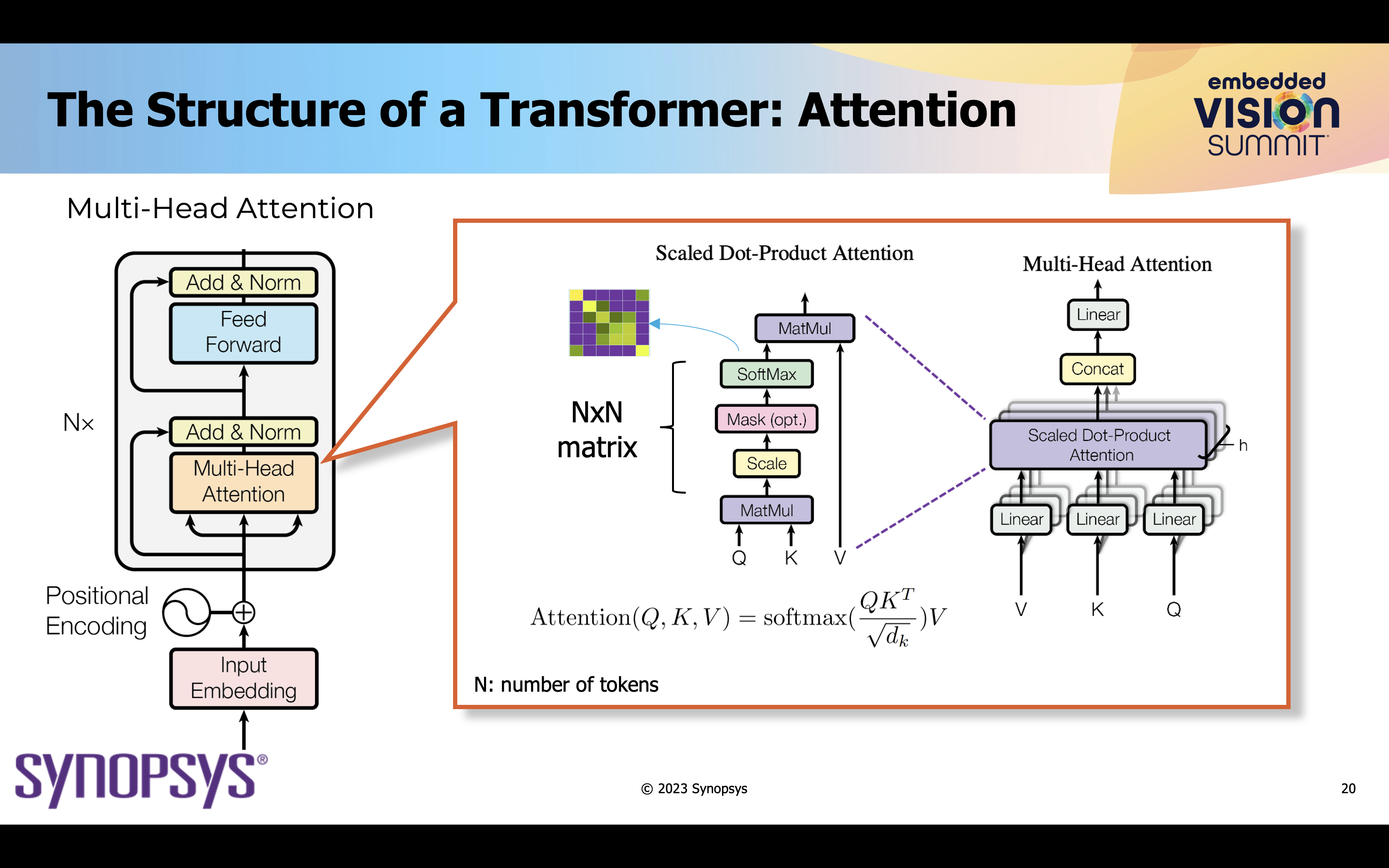

Under de senaste åren har transformatorer i grunden förändrat karaktären hos modeller för djupinlärning, vilket revolutionerat området för artificiell intelligens. Transformatorer introducerar en uppmärksamhetsmekanism som gör att modeller kan väga vikten av olika element i en inmatningssekvens. Till skillnad från traditionella djupinlärningsmodeller, som behandlar data sekventiellt eller hierarkiskt, kan Transformers fånga beroenden mellan element parallellt. Detta gör det möjligt att träna mycket större modeller mer effektivt.

Även om transformatorer ursprungligen utvecklades för naturlig språkbehandling (NLP), har transformatorer börjat få framträdande plats i ett antal olika applikationer. En sådan applikation är datorseende, fältet som gör det möjligt för maskiner att tolka och förstå visuell information från den verkliga världen.

Datorseende har utvecklats under åren, från tekniker baserade på handgjorda funktioner till den senaste tidens ökning av modeller för djupinlärning. Tillkomsten av djupinlärning, som drivs av tillgången på stora datamängder och kraftfulla GPU:er, har revolutionerat området. Modeller för djupinlärning har överträffat prestanda på mänsklig nivå i uppgifter som bildklassificering, objektdetektering och bildgenerering. Detta fält har länge förlitat sig på konvolutionella neurala nätverk (CNN) för sin djupinlärningsarkitektur. Forskare har insett att Transformers kan anpassas för att hantera rumslig data också, vilket gör det till en lovande kandidat för datorseendeapplikationer. Detta är sammanhanget för ett föredrag som hölls vid 2023 Embedded Vision Summit av Tom Michiels, huvudsystemarkitekt på Synopsys.

Varför Transformers for Vision

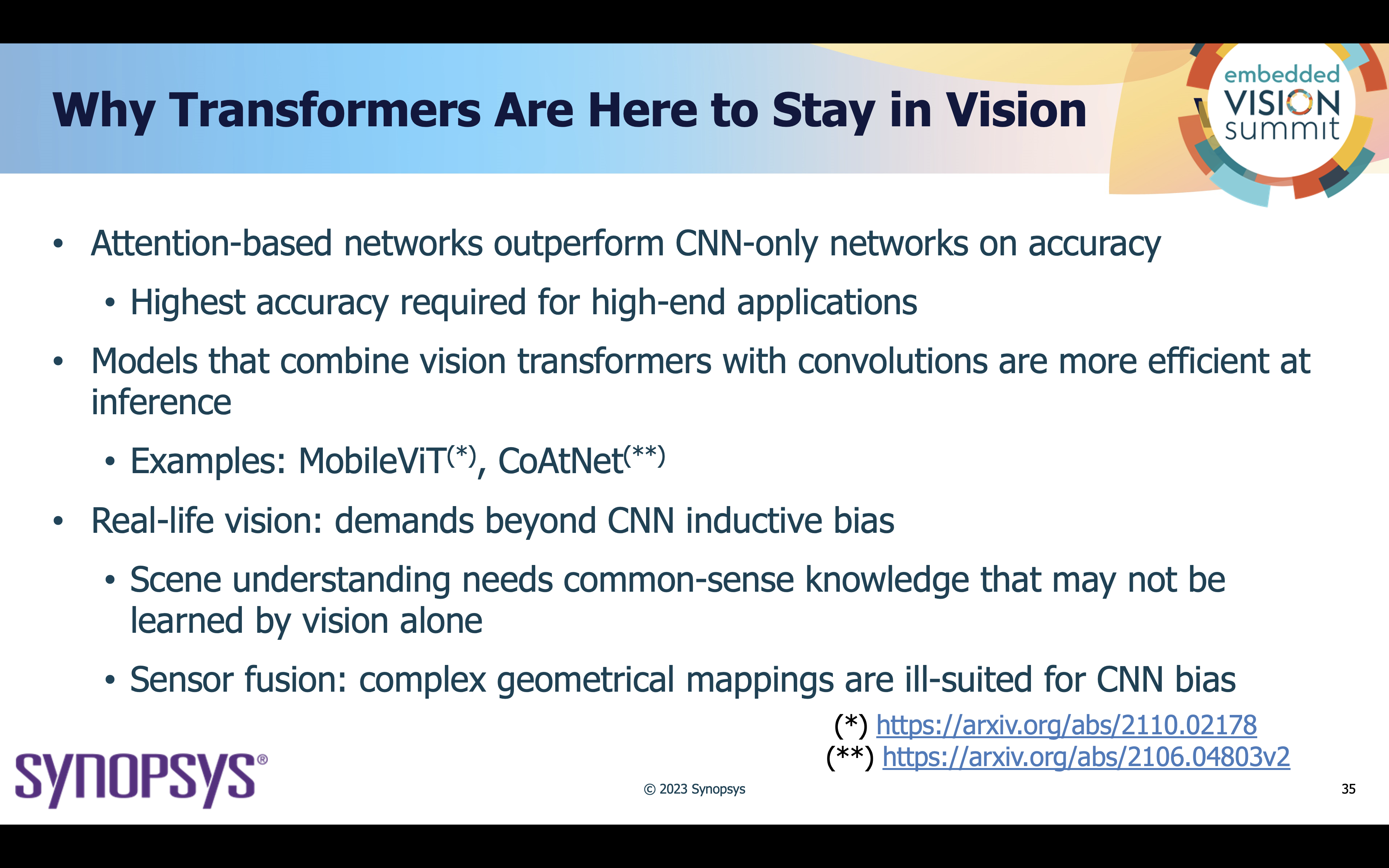

Datorseende uppgifter, såsom bildklassificering, objektdetektering, bildsegmentering och mer, har traditionellt förlitat sig mycket på CNN. Medan CNN:er är effektiva för att fånga rumsliga hierarkier och lokala mönster i bilder, är Transformers utmärkta på att fånga långväga beroenden och global kontextuell information i en bild. Detta är viktigt för att förstå sambanden mellan avlägsna bildområden, vilket gör dem lämpliga för komplexa synuppgifter. Transformatorer bearbetar alla element parallellt, vilket eliminerar den sekventiella karaktären hos CNN. Denna parallellisering accelererar avsevärt tränings- och slutledningstider, vilket gör storskaliga visionmodeller mer genomförbara. Transformatorer kan skalas horisontellt genom att lägga till fler lager och parametrar, vilket gör att de kan hantera ett brett utbud av visionuppgifter. De kan skalas vertikalt för att hantera större eller mindre ingångsbilder för bildklassificering till finkornig objektdetektering. Visionsuppgifter involverar ofta flera modaliteter, såsom bilder och text. Transformatorer är till sin natur multimodala, vilket gör dem lämpliga för uppgifter som kräver förståelse och resonemang om både visuell och textuell information. Denna mångsidighet utökar deras tillämpbarhet till områden som bildtextning och visuella frågor.

Transformatorer tenderar också att producera mer tolkningsbara representationer jämfört med vissa andra modeller för djupinlärning. Uppmärksamhetskartorna som genereras av Transformers ger insikter i vilka delar av input som vägs mer för att göra förutsägelser. Denna tolkningsbarhet är ovärderlig för att felsöka modeller och få insikter i deras beslutsprocesser.

Tillämpningar av transformatorer i datorseende

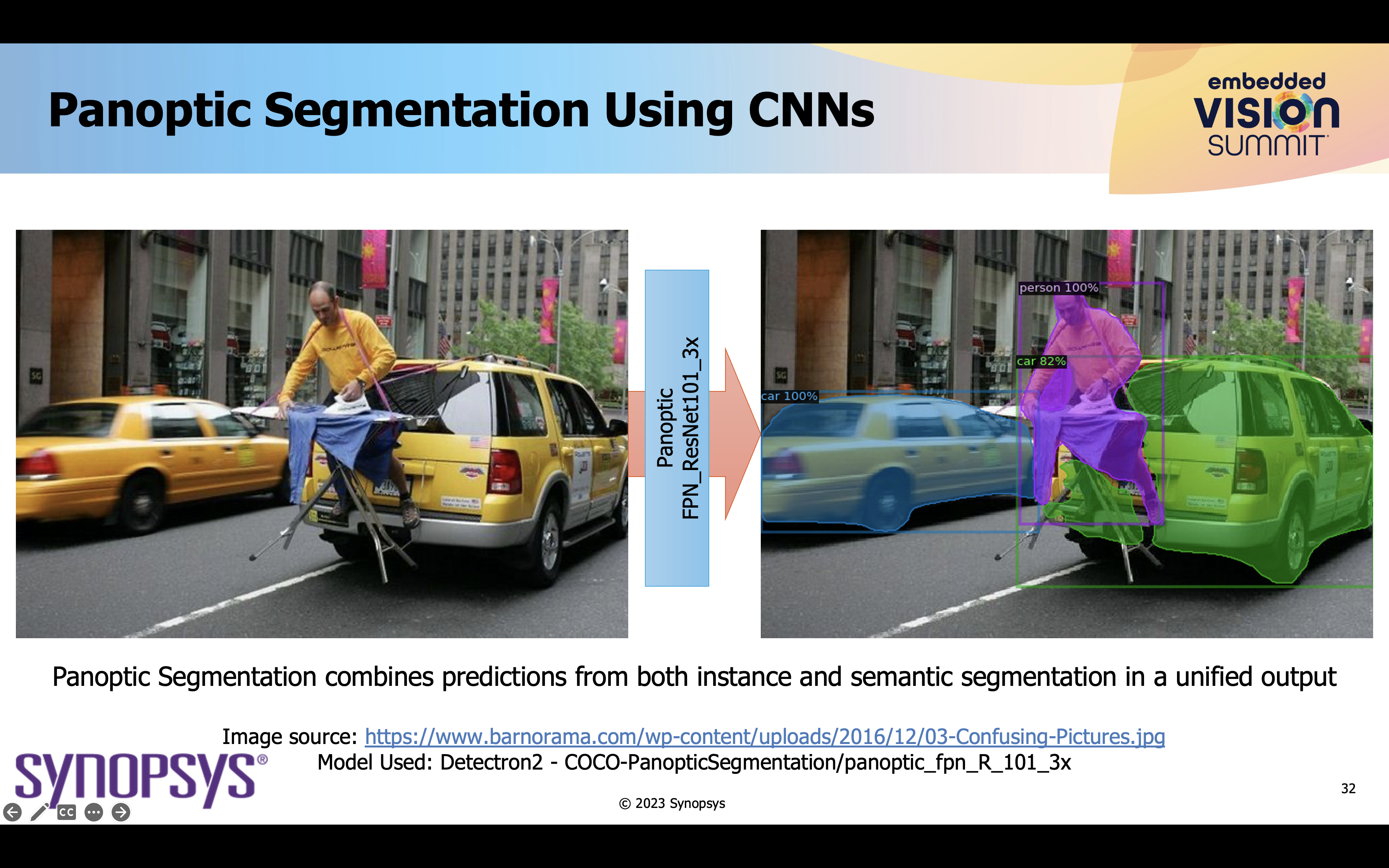

Modeller som DETR (DEtection TRansformer) har uppvisat enastående prestanda i objektdetekteringsuppgifter, överträffat traditionella CNN-baserade metoder. DETR:s förmåga att hantera varierande antal objekt i en bild utan behov av ankarlådor är en spelomvandlare. Transformatorer har visat betydande lovande i semantiska och instanssegmenteringsuppgifter. Modeller som Swin Transformer och Vision Transformer (ViT) har uppnått konkurrenskraftiga resultat inom dessa områden, vilket ger förbättrad rumslig förståelse och extraktion av funktioner. Transformatorbaserade modeller, såsom DALL-E, kan generera mycket kreativa och sammanhangsmedvetna bilder från textbeskrivningar. Detta har öppnat nya möjligheter för innehållsgenerering och kreativa applikationer. Sist men inte minst är att Transformers kan generera beskrivande bildtexter för bilder, vilket berikar tillgängligheten för visuellt innehåll.

Hybridmodeller

Medan ViTs är utmärkta i bildklassificering och slår CNNs i noggrannhet och träningstid, slår CNNs ViTs i slutledningstid. Medan transformatorer är mer användbara för att känna igen komplexa objekt, är den induktiva förspänningen hos en faltning mer användbar för att känna igen lågnivåfunktioner. Att träna storskaliga transformatormodeller för datorseende kräver ofta omfattande datauppsättningar och beräkningsresurser.

Som sådan kan en visionbehandlingsapplikation använda både CNN och Transformers för större effektivitet. Att kombinera styrkorna hos Transformers med andra arkitekturer som CNN är ett växande forskningsområde, eftersom hybridmodeller försöker utnyttja det bästa av två världar.

Synopsys ARC® NPX6 NPU IP

Synopsys ARC® NPX6 NPU IP är ett exempel på en AI-accelerator som kan hantera CNN:er och transformatorer. Den utnyttjar en faltningsaccelerator för matris-matrismultiplikationer, såväl som en tensoraccelerator för transformatoroperationer och aktiveringsfunktioner. IP ger upp till 3,500 30 TOPS prestanda och exceptionell effekteffektivitet på upp till XNUMX TOPS/Watt. Designteam kan också påskynda utvecklingen av sin applikationsprogramvara med Synopsys ARC MetaWare MX Development Toolkit. Verktygslådan tillhandahåller en omfattande mjukvaruprogrammeringsmiljö som inkluderar ett mjukvaruutvecklingssats för neurala nätverk och stöd för virtuella modeller.

Att lära sig mer, besök produktsidan.

Sammanfattning

Den överraskande ökningen av Transformers i datorseende belyser en betydande förändring i fältets landskap. Deras unika kapacitet, inklusive uppmärksamhetsmekanismen, parallell bearbetning och skalbarhet, har utmanat dominansen av CNN och öppnat spännande möjligheter för datorseendeapplikationer. De erbjuder oöverträffad mångsidighet och prestanda för ett brett utbud av uppgifter, och förändrar hur vi interagerar med visuell data. När forskare fortsätter att förfina och anpassa Transformer-modeller för visionuppgifter kan vi förvänta oss ytterligare genombrott som kommer att leda till smartare, mer kapabla visionsystem med bredare tillämpningar i den verkliga världen.

Läs också:

Effektanalys från programvara till arkitektur till signoff

WEBINAR: Varför rigorösa tester är så viktiga för PCI Express 6.0

Synopsys utökar Synopsys.ai EDA Suite med Full-Stack Big Data Analytics-lösning

Dela det här inlägget via:

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://semiwiki.com/ip/336013-transformers-transforming-the-field-of-computer-vision/

- : har

- :är

- :inte

- $UPP

- 2023

- 30

- 500

- a

- förmåga

- Om Oss

- accelerera

- accelererar

- accelerator

- tillgänglighet

- noggrannhet

- uppnås

- tvärs

- aktivering

- anpassa

- anpassat

- tillsats

- Antagande

- första advent

- AI

- Alla

- tillåta

- tillåter

- också

- an

- analys

- analytics

- Ankare

- och

- Ansökan

- tillämpningar

- tillvägagångssätt

- Arc

- arkitektur

- ÄR

- OMRÅDE

- områden

- konstgjord

- artificiell intelligens

- AS

- At

- uppmärksamhet

- tillgänglighet

- baserat

- BE

- varit

- BÄST

- mellan

- förspänning

- Stor

- Stora data

- båda

- boxar

- genombrott

- bredare

- men

- by

- KAN

- kandidat

- kapacitet

- kapabel

- texter

- fånga

- Fångande

- utmanade

- byte

- klassificering

- kombinera

- jämfört

- konkurrenskraftig

- komplex

- omfattande

- dator

- Datorsyn

- Datorseende applikationer

- innehåll

- sammanhang

- kontextuella

- fortsätta

- kunde

- Kreativ

- dalls

- datum

- Data Analytics

- datauppsättningar

- Beslutsfattande

- djup

- djupt lärande

- levererar

- demonstreras

- beroenden

- Designa

- Detektering

- utvecklade

- Utveckling

- olika

- Avlägsen

- Dominans

- Effektiv

- effektivitet

- effektivt

- element

- eliminera

- inbäddade

- möjliggör

- berikande

- Miljö

- väsentlig

- utvecklats

- exempel

- excel

- utmärkt

- exceptionell

- spännande

- expanderar

- förvänta

- uttrycker

- sträcker

- omfattande

- extraktion

- möjlig

- Leverans

- Funktioner

- få

- fält

- För

- från

- fueled

- funktioner

- fundamentalt

- ytterligare

- Få

- få

- spel-växlare

- generera

- genereras

- generera

- generering

- ges

- Välgörenhet

- GPUs

- större

- Odling

- hantera

- Har

- kraftigt

- hjälp

- här.

- höggradigt

- Hur ser din drömresa ut

- html

- HTTPS

- Hybrid

- bild

- Bildklassificering

- bildgenerering

- bildsegmentering

- bilder

- vikt

- med Esport

- förbättras

- in

- innefattar

- Inklusive

- informationen

- inneboende

- ingång

- insikter

- exempel

- Instanssegmentering

- Intelligens

- interagera

- in

- införa

- ovärderlig

- engagera

- IP

- IT

- DESS

- utrustning

- liggande

- språk

- Large

- storskalig

- större

- Efternamn

- skikt

- leda

- LÄRA SIG

- inlärning

- t minst

- Nivå

- Hävstång

- hävstångs

- tycka om

- lokal

- Lång

- Låg

- Maskiner

- GÖR

- Framställning

- kartor

- max-bredd

- Maj..

- mekanism

- modaliteter

- modeller

- mer

- mycket

- multipel

- MX

- Natural

- Naturligt språk

- Naturlig språkbehandling

- Natur

- Behöver

- nät

- nätverk

- neural

- neurala nätverk

- neurala nätverk

- Nya

- nlp

- antal

- nummer

- objektet

- Objektdetektion

- objekt

- of

- erbjudanden

- erbjuda

- Ofta

- on

- ONE

- öppnade

- Verksamhet

- möjligheter

- or

- ursprungligen

- Övriga

- presterande bättre än

- över

- Parallell

- parametrar

- reservdelar till din klassiker

- mönster

- prestanda

- plato

- Platon Data Intelligence

- PlatonData

- Möjligheterna

- möjlig

- Inlägg

- kraft

- den mäktigaste

- Förutsägelser

- Principal

- process

- processer

- bearbetning

- producera

- Produkt

- Programmering

- prominens

- löfte

- lovande

- ge

- ger

- fråga

- område

- Läsa

- verklig

- verkliga världen

- insåg

- senaste

- känna igen

- förfina

- regioner

- Förhållanden

- anmärkningsvärd

- kräver

- Kräver

- forskning

- forskare

- Resurser

- Resultat

- revolution

- revolutionera

- rigorös

- Rise

- skalbarhet

- Skala

- Seek

- segmentering

- Sekvens

- skifta

- visas

- signifikant

- signifikant

- mindre

- smartare

- So

- Mjukvara

- mjukvaruutveckling

- Utrustning för programvaruutveckling

- några

- rumsliga

- igång

- bo

- styrkor

- struktur

- sådana

- lämplig

- svit

- Summit

- stödja

- uppstår

- överträffade

- förvånande

- system

- System

- tackla

- Diskussion

- uppgifter

- lag

- tekniker

- Testning

- text

- text-

- den där

- Smakämnen

- deras

- Dem

- Dessa

- de

- detta

- tid

- gånger

- till

- tom

- alltför

- toolkit

- Överdelar

- traditionell

- traditionellt

- Tåg

- Utbildning

- transformator

- transformatorer

- omvandla

- förstå

- förståelse

- unika

- till skillnad från

- enastående

- med hjälp av

- utnyttja

- variabel

- mångsidighet

- vertikalt

- via

- Virtuell

- syn

- vision system

- we

- väga

- VÄL

- som

- medan

- varför

- bred

- Brett utbud

- kommer

- med

- inom

- utan

- världen

- Världens

- år

- zephyrnet