กฎของกู๊ดฮาร์ต มีชื่อเสียงกล่าวว่า: “เมื่อการวัดกลายเป็นเป้าหมาย การวัดจะไม่เป็นการวัดที่ดี” แม้ว่าจะมาจากเศรษฐศาสตร์ แต่ก็เป็นสิ่งที่เราต้องต่อสู้ที่ OpenAI เมื่อต้องหาวิธีเพิ่มประสิทธิภาพวัตถุประสงค์ที่ยากหรือมีค่าใช้จ่ายสูงในการวัด มักจะจำเป็นต้องแนะนำบ้าง วัตถุประสงค์ของผู้รับมอบฉันทะ ที่วัดได้ง่ายกว่าหรือถูกกว่า แต่เมื่อเราทำเช่นนี้ เราต้องระวังอย่าปรับให้เหมาะสมมากเกินไป

ตัวอย่างเช่น เป็นส่วนหนึ่งของงานของเราเพื่อ จัดแนว โมเดลเช่น GPT-3 ด้วยเจตนาและค่านิยมของมนุษย์ เราต้องการเพิ่มประสิทธิภาพสิ่งต่าง ๆ เช่น “How เป็นประโยชน์ นี่คือการตอบสนองหรือไม่” หรือ “อย่างไร ถูกต้องตามความเป็นจริง นี้คือการเรียกร้องหรือไม่? สิ่งเหล่านี้เป็นวัตถุประสงค์ที่ซับซ้อนซึ่งต้องการให้มนุษย์ตรวจสอบสิ่งต่าง ๆ อย่างรอบคอบ ด้วยเหตุนี้ เราจึงฝึกแบบจำลองเพื่อทำนายความชอบของมนุษย์เหล่านี้ ซึ่งเรียกว่า a แบบรางวัลและใช้การคาดคะเนของแบบจำลองรางวัลเป็นวัตถุประสงค์พร็อกซี่ แต่สิ่งสำคัญคือต้องติดตามว่าเป้าหมายที่แท้จริงได้รับการปรับให้เหมาะสมดีเพียงใด

ในบทความนี้ เราจะมาดูคณิตศาสตร์เบื้องหลังวิธีที่เราทำเช่นนี้ เราจะมุ่งเน้นไปที่การตั้งค่าที่ชัดเจนโดยเฉพาะในการวิเคราะห์ ซึ่งเราสามารถเข้าถึงวัตถุประสงค์ที่แท้จริงได้ ในทางปฏิบัติ แม้แต่ความชอบของมนุษย์ก็อาจล้มเหลวในการวัดสิ่งที่เราสนใจจริงๆ ได้ แต่เรากำลังแยกประเด็นนั้นออกจากโพสต์นี้

ดีที่สุดของ$n$ การสุ่มตัวอย่าง

มีหลายวิธีที่สามารถเพิ่มประสิทธิภาพวัตถุประสงค์ของพร็อกซีได้ แต่บางทีวิธีที่ง่ายที่สุดคือ การสุ่มตัวอย่างที่ดีที่สุดของ$n$, ที่รู้จักกันว่า การสุ่มตัวอย่างการปฏิเสธ or จัดอันดับใหม่. เราเพียงแค่สุ่มตัวอย่าง $n$ ครั้งแล้วเลือกอันที่มีคะแนนสูงสุดตามวัตถุประสงค์ของพร็อกซี

แม้ว่าวิธีนี้จะง่ายมาก แต่จริง ๆ แล้วมันสามารถแข่งขันกับเทคนิคขั้นสูง เช่น การเรียนรู้แบบเสริมกำลัง ถึงแม้ว่าจะต้องเสียค่าใช้จ่ายในการคำนวณเวลาการอนุมานมากกว่า ตัวอย่างเช่น ใน เว็บGPTโมเดลที่ดีที่สุดจาก 64$ ของเรามีประสิทธิภาพดีกว่าโมเดลการเรียนรู้แบบเสริมกำลัง ส่วนหนึ่งอาจเป็นเพราะโมเดลที่ดีที่สุดจาก 64$ ต้องเรียกดูเว็บไซต์อีกมากมาย แม้แต่การใช้เงินที่ดีที่สุดจาก 4$ ก็ช่วยเพิ่มความชอบของมนุษย์ได้อย่างมาก

นอกจากนี้ การสุ่มตัวอย่างแบบ Best-of-$n$ ยังมีประสิทธิภาพที่เชื่อถือได้และวิเคราะห์ทางคณิตศาสตร์ได้โดยตรง ทำให้เหมาะสำหรับการศึกษาเชิงประจักษ์เกี่ยวกับกฎของ Goodhart และปรากฏการณ์ที่เกี่ยวข้อง

คณิตศาสตร์ของการสุ่มตัวอย่างที่ดีที่สุดของ$n$

มาศึกษาการสุ่มตัวอย่างแบบ best-of-$n$ อย่างเป็นทางการกันดีกว่า สมมติว่าเรามีช่องว่างตัวอย่าง $S$ (เช่น ชุดของคู่คำถาม-คำตอบที่เป็นไปได้) การแจกแจงความน่าจะเป็นบางส่วน $P$ มากกว่า $เอส$, วัตถุประสงค์ที่แท้จริง (หรือ “รางวัล”) $R_{ข้อความ{true}}:Stomathbb R$, และวัตถุประสงค์ของผู้รับมอบฉันทะ $R_{ข้อความ{proxy}}:Stomathbb R$ สมมติว่าเราเพิ่มประสิทธิภาพ $R_{text{proxy}}$ แล้วด้วยเหตุนี้จึงได้รับการกระจายใหม่ $P^ไพรม์$. แล้ว:

- ความคาดหวัง $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ วัดว่าเราได้เพิ่มประสิทธิภาพวัตถุประสงค์ที่แท้จริงเพียงใด

- พื้นที่ KL ไดเวอร์เจนซ์ $D_{text{KL}}left(P^primeparallel Pright)$ วัดว่าเราได้ทำการเพิ่มประสิทธิภาพไปมากน้อยเพียงใด ตัวอย่างเช่น หากได้ $P^prime$ โดยการนำตัวอย่างแรกจาก $P$ ที่อยู่ในเซตย่อยบางส่วน $S^ไพรม์เซตย่อย S$, ดังนั้น KL divergence นี้เป็นเพียงความน่าจะเป็นของบันทึกเชิงลบที่ตัวอย่างจาก $P$ อยู่ใน $S^prime$

ปรากฎว่าในกรณีของการสุ่มตัวอย่างที่ดีที่สุดของ $n$ ปริมาณทั้งสองนี้สามารถประมาณได้อย่างมีประสิทธิภาพโดยใช้ตัวอย่างจาก $P$

มาดูความคาดหวังกันก่อน แนวทางที่ไร้เดียงสาคือการใช้ตัวประมาณแบบมอนติคาร์โล: สุ่มตัวอย่างที่ดีที่สุดหลายครั้ง วัดวัตถุประสงค์ที่แท้จริงของกลุ่มตัวอย่างเหล่านั้น และหาค่าเฉลี่ยของผลลัพธ์ อย่างไรก็ตาม มีตัวประมาณที่ดีกว่า ถ้าเรามี $Ngeq n$ ตัวอย่างจาก $P$ โดยรวม เราก็สามารถพิจารณาได้พร้อมกัน ทุกเซตย่อยที่เป็นไปได้ ของตัวอย่างเหล่านี้ที่มีขนาด $n$ ให้น้ำหนักแต่ละตัวอย่างตามจำนวนชุดย่อยที่ดีที่สุดตามวัตถุประสงค์ของพร็อกซี แล้วนำคะแนนตามวัตถุประสงค์จริงโดยเฉลี่ยที่ถ่วงน้ำหนักมา น้ำหนักนี้เป็นเพียงค่าสัมประสิทธิ์ทวินาม $binom{k-1}{n-1}$, โดยที่ $k$ คืออันดับของกลุ่มตัวอย่างภายใต้วัตถุประสงค์ของพร็อกซี จาก $1$ (แย่ที่สุด) ถึง $N$ (ดีที่สุด) นอกจากการใช้ตัวอย่างอย่างมีประสิทธิภาพมากขึ้นแล้ว วิธีนี้ยังช่วยให้เรานำตัวอย่างกลับมาใช้ใหม่ด้วยค่า $n$ ที่แตกต่างกันได้

สำหรับความแตกต่างของ KL น่าแปลกใจที่สิ่งนี้มีสูตรที่แน่นอนซึ่งใช้ได้กับการแจกแจงความน่าจะเป็นแบบต่อเนื่องใดๆ $P$ (เช่น ตราบใดที่ $P$ ไม่มีมวลจุด) บางคนอาจเดาอย่างไร้เดียงสาว่าคำตอบคือ $ล็อก n$, เนื่องจาก best-of-$n$ กำลังทำบางอย่างเช่นการรับ $frac 1n$ อันดับต้น ๆ ของการแจกแจง และนี่ถูกต้องโดยคร่าว: คำตอบที่แน่นอนคือ $log n-frac{n-1}n$

ตัวประมาณเหล่านี้ร่วมกันช่วยให้เราวิเคราะห์ได้อย่างง่ายดายว่าวัตถุประสงค์ที่แท้จริงแตกต่างกันอย่างไรตามปริมาณการเพิ่มประสิทธิภาพที่ใช้กับวัตถุประสงค์พร็อกซี่

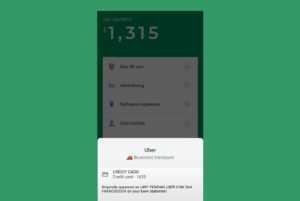

นี่คือตัวอย่างชีวิตจริงจาก เว็บGPT:

ประสิทธิภาพที่ดีที่สุดของ $n$ สำหรับ WebGPT 175B

ประสิทธิภาพที่ดีที่สุดของ $n$ สำหรับ WebGPT โดยมีส่วนที่แรเงาแสดงข้อผิดพลาดมาตรฐาน $pm 1$ และแกน KL ตามมาตราส่วนรากที่สอง ในที่นี้ การแจกแจงดั้งเดิม ($P$) มอบให้โดยโมเดล 175B ที่ฝึกฝนโดยใช้การโคลนพฤติกรรม วัตถุประสงค์ของพร็อกซีที่ใช้ในการคำนวณ best-of-$n$ ($R_{text{proxy}}$) มอบให้โดยการฝึกอบรม แบบจำลองการให้รางวัล และเราพิจารณาวัตถุประสงค์ที่ "จริง" สามประการ ($R_{text{true}}$): ตัวแบบให้รางวัลการฝึกอบรมนั้นเอง รูปแบบการให้รางวัลสำหรับการตรวจสอบที่ฝึกฝนเกี่ยวกับข้อมูลที่เก็บไว้ และความชอบจริงของมนุษย์ วัตถุประสงค์ของพร็อกซีนั้นไม่ได้เพิ่มประสิทธิภาพมากเกินไป แต่เราคาดว่าจะมี KL ที่สูงกว่า

ไปไกลกว่าการสุ่มตัวอย่างที่ดีที่สุดของ$n$

ข้อจำกัดหลักของการสุ่มตัวอย่างแบบ best-of-$n$ คือ KL divergence เติบโตแบบลอการิทึมด้วย $n$ ดังนั้นจึงเหมาะสำหรับการใช้การปรับให้เหมาะสมเพียงเล็กน้อยเท่านั้น

ในการปรับใช้การเพิ่มประสิทธิภาพให้มากขึ้น โดยปกติแล้วเราจะใช้การเรียนรู้แบบเสริมกำลัง ในการตั้งค่าที่เราได้ศึกษาไปแล้วเช่น สรุป, เราสามารถไปถึง KL ได้ประมาณ 10 แนท โดยใช้การเรียนรู้แบบเสริมกำลังก่อนวัตถุประสงค์ที่แท้จริงจะเริ่มลดลงเนื่องจากกฎของกู๊ดฮาร์ท เราต้องใช้เงิน $n$ ประมาณ 60,000 เพื่อเข้าถึง KL นี้โดยใช้ ที่ดีที่สุดของ $n$, และเราหวังว่าจะสามารถเข้าถึง KL ที่ใหญ่กว่านี้ได้มากด้วยการปรับปรุงการสร้างแบบจำลองการให้รางวัลและการเรียนรู้แบบเสริมกำลัง

อย่างไรก็ตาม แนทไม่เท่ากันทั้งหมด สำหรับงบประมาณ KL ขนาดเล็กโดยสังเกตจากประสบการณ์ สิ่งที่ดีที่สุดของ $n$ จะเพิ่มประสิทธิภาพทั้งพร็อกซีและวัตถุประสงค์ที่แท้จริงได้ดีกว่าการเรียนรู้แบบเสริมกำลัง ตามสัญชาตญาณแล้ว best-of-$n$ คือแนวทางแบบ "กำลังดุร้าย" ทำให้ข้อมูลในทางทฤษฎีมีประสิทธิภาพมากกว่าการเรียนรู้แบบเสริมกำลัง แต่มีประสิทธิภาพในการคำนวณน้อยกว่าใน KL ขนาดใหญ่

เรากำลังศึกษาคุณสมบัติการปรับขนาดของวัตถุประสงค์ตัวแทนอย่างแข็งขันซึ่งเป็นส่วนหนึ่งของงานของเราเพื่อ จัดแนว โมเดลของเราด้วยความตั้งใจและค่านิยมของมนุษย์ หากคุณต้องการช่วยเราในการวิจัยนี้ เราคือ การว่าจ้าง!

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- OpenAI

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- การวิจัย

- ขนาดไอ

- วากยสัมพันธ์

- ลมทะเล