Goodhart yasası ünlü bir şekilde şunu söylüyor: "Bir ölçü hedef haline geldiğinde, iyi bir ölçü olmaktan çıkar." Her ne kadar kökeni ekonomiden gelse de, OpenAI'de ölçülmesi zor veya maliyetli hedeflerin nasıl optimize edileceğini çözerken uğraşmamız gereken bir konu. Bazılarını tanıtmak genellikle gereklidir temsili hedef bunu ölçmek daha kolay veya daha ucuz ama bunu yaparken çok fazla optimize etmemeye dikkat etmemiz gerekiyor.

Örneğin, çalışmalarımızın bir parçası olarak hizalamak GPT-3 gibi insan amacı ve değerlerine sahip modeller kullanıyorsak, "Nasıl faydalı bu yanıt mı?” veya “Nasıl aslında doğru bu iddia mı?” Bunlar, insanların işleri dikkatlice kontrol etmesini gerektiren karmaşık hedeflerdir. Bu nedenle, bu insan tercihlerini tahmin edecek bir model geliştiriyoruz. ödül modelive ödül modelinin tahminlerini temsili hedef olarak kullanın. Ancak gerçek hedefin ne kadar iyi optimize edildiğini takip etmek önemlidir.

Bu yazıda bunu nasıl yaptığımızın ardındaki bazı matematik işlemlerine bakacağız. Gerçek hedefe erişebildiğimiz, analiz edilmesi özellikle kolay olan bir ortama odaklanacağız. Uygulamada, insan tercihleri bile gerçekten neye önem verdiğimizi ölçmede başarısız olabilir, ancak bu yazıda bu konuyu bir kenara bırakıyoruz.

$n$'ın en iyisi örnekleme

Proxy hedefini optimize etmenin birçok yolu vardır, ancak belki de en basit olanı $n$'ın en iyisi örnekleme, Ayrıca şöyle bilinir ret örneklemesi or yeniden sıralama. Basitçe $n$ kez örnek alırız ve temsil hedefine göre en yüksek puanı alan örneği alırız.

Bu yöntem çok basit olmasına rağmen, daha fazla çıkarım süresi hesaplaması pahasına da olsa aslında takviyeli öğrenme gibi daha gelişmiş tekniklerle rekabet edebilir. Örneğin, WebGPT64$'ın en iyisi modelimiz takviyeli öğrenme modelimizi geride bıraktı; bunun nedeni belki de 64$'ın en iyisi modelinin çok daha fazla web sitesine göz atmasıydı. En iyi 4$'ı uygulamak bile insan tercihlerinde önemli bir artış sağladı.

Ek olarak, $n$'ın en iyisi örneklemenin güvenilir bir performansı vardır ve matematiksel olarak analiz edilmesi kolaydır; bu da onu Goodhart yasası ve ilgili olaylara ilişkin ampirik çalışmalara çok uygun hale getirir.

$n$'ın en iyisi örneklemenin matematiği

$n$'ın en iyisi örneklemesini daha resmi olarak inceleyelim. Diyelim ki elimizde bir $S$ örnek uzayı (olası soru-cevap çiftleri kümesi gibi), bir $P$ olasılık dağılımı var. $S$, gerçek bir hedef (veya “ödül”) $R_{text{true}}:Stomathbb R$, ve temsili bir hedef $R_{text{proxy}}:Stomathbb R$. Diyelim ki bir şekilde $R_{text{proxy}}$'yi optimize ettik ve böylece yeni bir dağıtım elde ettik $P^prime$. Sonra:

- $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ beklentisi, gerçek hedefi ne kadar iyi optimize ettiğimizi ölçer.

- The KL sapması $D_{text{KL}}left(P^primeparallel Pright)$ ne kadar optimizasyon yaptığımızı ölçer. Örneğin, $P^prime$ bazı alt kümelerde yer alan $P$'dan ilk örnek alınarak elde ediliyorsa $S^primesubseteq S$, o zaman bu KL farklılığı $P$'dan gelen bir örneğin $S^prime$'da bulunmasının negatif log olasılığıdır.

$n$'ın en iyisi örneklemesi durumunda, bu miktarların her ikisinin de $P$'dan alınan örnekler kullanılarak verimli bir şekilde tahmin edilebileceği ortaya çıktı.

Önce beklentiye bakalım. Saf yaklaşım bir Monte Carlo tahmincisi kullanmaktır: $n$'ın en iyisi örneklemeyi birçok kez çalıştırın, bu örneklerdeki gerçek hedefi ölçün ve sonuçların ortalamasını alın. Ancak daha iyi bir tahminci var. Genel olarak $P$'dan $Ngeq n$ örneklerimiz varsa, o zaman aynı anda şunları dikkate alabiliriz: mümkün olan her alt küme $n$ büyüklüğündeki bu örneklerden her birini temsil hedefine göre en iyi olduğu alt kümelerin sayısına göre ağırlıklandırın ve ardından ağırlıklı ortalama gerçek amaç puanını alın. Bu ağırlık sadece binom katsayısıdır $binom{k-1}{n-1}$, burada $k$, temsili hedef kapsamında örneğin $1$'dan (en kötü) $N$'a (en iyi) kadar olan sırasıdır. Örnekleri daha verimli kullanmanın yanı sıra, bu aynı zamanda örnekleri farklı $n$ değerleri için yeniden kullanmamıza da olanak tanır.

KL farklılığına gelince, şaşırtıcı bir şekilde, bunun herhangi bir sürekli olasılık dağılımı $P$ için (yani, $P$'nin nokta kütleleri olmadığı sürece) işe yarayan kesin bir formüle sahip olduğu ortaya çıkıyor. Birisi safça cevabın şu olduğunu tahmin edebilir: $log n$, $n$'ın en iyisi, dağıtımın en üst $frac 1n$'ını almak gibi bir şey yaptığından ve bu kabaca doğrudur: kesin cevap: $log n-frac{n-1}n$.

Bu tahmin ediciler birlikte, gerçek hedefin temsili hedefe uygulanan optimizasyon miktarına göre nasıl değiştiğini kolayca analiz etmemize olanak tanır.

İşte gerçek hayattan bir örnek WebGPT:

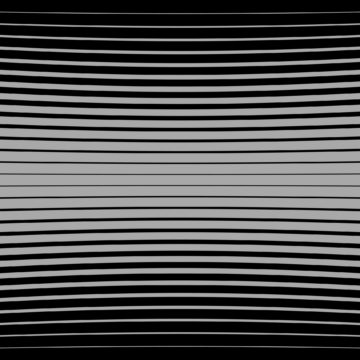

WebGPT 175B için $n$'ın en iyisi performans

$pm 1$ standart hatayı temsil eden gölgeli bölgeler ve karekök ölçeğini izleyen KL ekseni ile WebGPT için $n$ performansının en iyisi. Burada, orijinal dağılım ($P$), davranış klonlaması kullanılarak eğitilen 175B modeli tarafından verilir, $n$'ın en iyisini hesaplamak için kullanılan proxy hedefi ($R_{text{proxy}}$) eğitim tarafından verilir. ödül modeli ve varsayılan olarak "doğru" olan üç hedefi ($R_{text{true}}$) göz önünde bulunduruyoruz: eğitim ödül modelinin kendisi, uzatılmış veriler üzerine eğitilmiş bir doğrulama ödül modeli ve gerçek insan tercihleri. Proxy hedefinin çok fazla aşırı optimizasyonu yok, ancak daha yüksek KL'lerde olmasını bekleriz.

$n$'ın en iyisi örneklemenin ötesine geçmek

$n$'ın en iyisi örneklemesinin ana sınırlaması, KL farklılığının $n$ ile logaritmik olarak büyümesidir, dolayısıyla yalnızca küçük miktarda optimizasyon uygulamak için uygundur.

Daha fazla optimizasyon uygulamak için genellikle takviyeli öğrenmeyi kullanırız. Şu ana kadar incelediğimiz ayarlarda, örneğin özetleme, genellikle 10 civarında bir KL'ye ulaşmayı başardık NAT Goodhart yasası nedeniyle gerçek amaç azalmaya başlamadan önce takviyeli öğrenmeyi kullanmak. kullanarak bu KL'ye ulaşmak için $n$'ın 60,000 civarında olması gerekir. $n$'ın en iyisi, Ödül modelleme ve takviyeli öğrenme uygulamalarımızdaki iyileştirmelerle bundan çok daha büyük KL'lere ulaşabileceğimizi umuyoruz.

Ancak tüm nat'lar eşit değildir. Deneysel olarak, küçük KL bütçeleri için, $n$'ın en iyisi, pekiştirmeli öğrenmeye göre hem temsili hem de gerçek hedefleri daha iyi optimize eder. Sezgisel olarak, $n$'ın en iyisi "kaba kuvvet" yaklaşımıdır ve bu yaklaşım onu takviyeli öğrenmeden teorik olarak bilgi açısından daha verimli, ancak büyük KL'lerde hesaplama açısından daha az verimli kılar.

Çalışmamızın bir parçası olarak temsili hedeflerin ölçeklendirme özelliklerini aktif olarak inceliyoruz. hizalamak Modellerimiz insani amaç ve değerlere sahip. Bu araştırmada bize yardımcı olmak isterseniz, biz kiralama!

- AI

- yapay zeka

- AI sanat üreteci

- yapay zeka robotu

- yapay zeka

- yapay zeka sertifikası

- bankacılıkta yapay zeka

- yapay zeka robotu

- yapay zeka robotları

- yapay zeka yazılımı

- blockchain

- blockchain konferans ai

- zeka

- konuşma yapay zekası

- kripto konferans ai

- dal-e

- derin öğrenme

- google ai

- makine öğrenme

- OpenAI

- Platon

- plato yapay zekası

- Plato Veri Zekası

- Plato Oyunu

- PlatoVeri

- plato oyunu

- araştırma

- ölçek ai

- sözdizimi

- zefirnet