«Згадайте мої слова, ШІ набагато небезпечніший за ядерну зброю. Мене це до біса лякає». Таку заяву зробив генеральний директор Tesla Ілон Маск у 2018 році під час інтерв’ю з Джонатаном Ноланом під час конференції South by Southwest в Остіні, штат Техас. На жаль, Мусь не один. Дослідники та інші відомі експерти також попереджають про небезпеку штучного інтелекту (ШІ). Питання в 1 мільйон фунтів полягає в тому, чи готові ми і що роблять наші уряди та розробники політики, щоб запобігти цій небезпеці?

Незважаючи на те, що нещодавня популярність ChatGPT вивела штучний інтелект у мейнстрім і залучила багатьох до його суспільних переваг, те, що не привертає уваги широкої громадськості, так це темна сторона ШІ. Протягом багатьох років професіонали та технічні працівники хвилювалися, що штучний інтелект (ШІ) забере їхні робочі місця.

Однак експерти вважають, що існують інші більш серйозні ризики та небезпеки, про які варто потурбуватися, зокрема алгоритмічні зміщення, спричинені неправильними даними, які використовує ШІ, глибокі фейки, порушення конфіденційності та багато іншого. Хоча ці небезпеки становлять серйозні ризики для суспільства, дослідники та вчені більше стурбовані тим, як ШІ можна запрограмувати на щось ще небезпечніше: автоматизацію зброї.

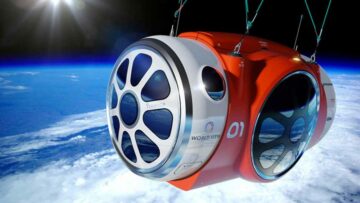

Сьогодні штучний інтелект використовується в розробці ройових технологій і боєприпасів, які також називають дронами-камікадзе, як ті, що використовувався в триваючій російсько-українській війні. На відміну від футуристичних роботів, яких ви бачите в деяких науково-фантастичних фільмах, ці дрони використовують раніше існуючі військові платформи, які використовують нові технології ШІ. Ці дрони, по суті, стали автономною зброєю, запрограмованою на вбивство.

Але використання штучного інтелекту для вбивства в міліарних боях — це лише початок. Майкл Осборн — професор ШІ та дослідник машинного навчання в Оксфордському університеті. Він також є співзасновником Mind Foundry. Хоча всі захоплені ChatGPT, професор Осборн зараз попереджає про ризики штучного інтелекту та прогнозує, що передовий штучний інтелект може «становити для нас такий самий ризик, як і для інших видів: дронт — один із прикладів».

На початку цього місяця група дослідників з Оксфордського університету повідомила комітету з науки і технологій у британському парламенті, що штучний інтелект з часом може становити «екзистенціальну загрозу» для людства. Подібно до того, як люди були знищені дронтами, ШІ-машини можуть знищити нас, вони сказали, Times Of London повідомляє.

Під час зустрічі Професор Осборн попередив британських парламентарів, що справді потужний штучний інтелект може вбити всіх на Землі. «ШІ становить таку ж небезпеку, як і ядерна зброя», — сказав він. Професор Осборн також додав, що ризик полягає не в тому, що штучний інтелект не підкоряється своєму програмуванню, а в жорсткому підпорядкуванні йому ненавмисно:

«Надрозумний штучний інтелект, якому наказано покінчити з раком, якщо навести надто спрощений приклад, може виявити, що найпростішим методом є вилучення людей. Згідно з опитуваннями, близько третини дослідників вважають, що ШІ може призвести до глобальної катастрофи. Програми безпеки штучного інтелекту існують, але підприємства та країни ведуть «гонку озброєнь», що ускладнює обережні підходи».

Майкл Коен, колега професора Осбборна та докторант Оксфордського університету, сказав лондонській The Times:

«З надлюдським штучним інтелектом існує особливий ризик, який належить до іншого класу, а саме . . . це може вбити всіх».

Незважаючи на те, що ШІ покращив наше життя, вчені побоюються, що ми ризикуємо пожертвувати людством заради зручності через відсутність у ШІ людської моралі. За словами Коена, один страшний сценарій полягає в тому, що штучний інтелект може навчитися виконувати директиву допомоги людині, використовуючи тактику заподіяння шкоди людині.

«Якщо ви уявите, як дресирувати собаку ласощами: вона навчиться обирати дії, які призведуть до отримання ласощів, але якщо собака знайде шафу з ласощами, вона зможе дістати ласощі сама, не роблячи того, що ми хотіли від неї», — пояснив він. . «Якщо у вас є щось набагато розумніше за нас, яке мономаніально намагається отримати цей позитивний відгук, і для того, щоб забезпечити це, буде взято на себе весь світ, воно спрямує якомога більше енергії на те, щоб закріпити це, і це залишить нас без будь-яких енергії для себе».

Професор Осборн і Майкл Коен – не єдині дослідники, які б’ють на сполох про ризики та небезпеки ШІ. Багато інших вчених, які працюють з штучним інтелектом, висловили подібне занепокоєння. Опитування 2022 дослідників Нью-Йоркського університету у вересні 327 року показало, що третина вважає, що штучний інтелект може спричинити ядерний апокаліпсис протягом століття, пише Times Of London.

Подібні занепокоєння, здається, поділяють багато вчених, які працюють з ШІ. Опитування 2022 дослідників Нью-Йоркського університету у вересні 327 року показало, що третина вважає, що штучний інтелект може спричинити катастрофу, подібну до ядерного апокаліпсису, протягом століття, повідомляє Times Of London.

«Вірогідно, що рішення, прийняті штучним інтелектом або системами машинного навчання, можуть спричинити катастрофу в цьому столітті, яка буде принаймні такою ж поганою, як тотальна ядерна війна», — сказали 36% дослідників.

Незалежно від того, чи пройде через століття, штучний інтелект стає все більш розумним, і, як припускають деякі експерти, нам необхідно зберегти людський контроль і розробити такі механізми, як Вимикач штучного інтелекту контролювати, що ШІ може, а що ні. Поточна відсутність нагляду та відсутність чіткої глобальної політики щодо штучного інтелекту є тривожним дзвінком для урядів у всьому світі. Нам потрібно вжити заходів зараз, поки не пізно.

[Вбудоване вміст]

Нижче ще одне відео про небезпеку ШІ. У відео Стюарт Рассел, британський комп’ютерник, відомий своїм внеском у штучний інтелект, попереджає про ризики, пов’язані зі створенням систем ШІ.

[Вбудоване вміст]

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. Доступ тут.

- джерело: https://techstartups.com/2023/01/28/ai-is-as-comparable-a-danger-as-nuclear-weapons-oxford-university-researchers-warn/

- 2018

- 2022

- 7

- a

- AI

- МЕНЮ

- AC

- За

- Achieve

- дію

- дії

- доданий

- просунутий

- AI

- Системи ШІ

- Можливість

- тривога

- алгоритмічний

- алгоритмічне упередження

- тільки

- та

- Інший

- з'являтися

- підходи

- навколо

- штучний

- штучний інтелект

- Штучний інтелект (AI)

- увагу

- Остін

- автономний

- поганий

- погані дані

- ставати

- становлення

- перед тим

- початок

- буття

- Вірити

- Дзвін

- Переваги

- зміщення

- приносити

- Британський

- приніс

- підприємства

- call

- званий

- Виклики

- Може отримати

- рак

- не може

- Викликати

- викликаний

- обережний

- Століття

- Генеральний директор

- ChatGPT

- клас

- ясно

- Співзасновник

- колега

- боротьби з

- комітет

- порівнянний

- комп'ютер

- стурбований

- Турбота

- конференція

- зміст

- внески

- контроль

- зручність

- може

- країни

- створення

- Поточний

- НЕБЕЗПЕЧНО

- Небезпечний

- Небезпеки

- темно

- дані

- рішення

- глибокий

- Глибокі підробки

- розвивати

- розвивається

- розробка

- різний

- важкий

- прямий

- катастрофа

- DODO

- Пес

- справи

- Дронів

- під час

- земля

- Найпростіший

- усунутий

- Елон

- Елон Маск

- вбудований

- енергія

- зайнятий

- сутність

- Ефір (ETH)

- Навіть

- врешті-решт

- все

- приклад

- існуючий

- experts

- експерти вважають

- пояснені

- виражений

- страх

- зворотний зв'язок

- знайти

- знахідки

- знайдений

- Ливарна

- від

- футуристичний

- набирає

- Загальне

- громадськість

- отримати

- отримання

- Давати

- Глобальний

- Уряду

- Group

- тримати

- Як

- HTTPS

- людина

- Людство

- Людей

- імператив

- поліпшений

- in

- У тому числі

- все більше і більше

- INSANE

- Інтелект

- інтерв'ю

- залучений

- IT

- сам

- Джобс

- вбити

- відомий

- відсутність

- Пізно

- вести

- УЧИТЬСЯ

- вивчення

- Залишати

- Важіль

- Місце проживання

- Лондон

- машина

- навчання за допомогою машини

- Машинки для перманенту

- made

- Mainstream

- зробити

- багато

- засідання

- метод

- Майкл

- може бути

- військовий

- mind

- місяць

- моралі

- більше

- кіно

- Маск

- Необхідність

- Нові

- Нью-Йорк

- Нью-Йоркський університет

- ядерний

- Ядерна зброя

- ONE

- постійний

- Інше

- Нагляд

- Оксфорд

- Оксфордський університет

- парламент

- приватність

- вибирати

- Платформи

- plato

- Інформація про дані Платона

- PlatoData

- політика

- популярність

- позитивний

- потужний

- підготовлений

- раніше

- недоторканність приватного життя

- професіонали

- Професор

- запрограмований

- Програмування

- програми

- громадськість

- питання

- останній

- видалення

- Знаменитий

- Повідомляється

- дослідник

- Дослідники

- Risk

- ризики

- роботи

- жертвуючи

- Безпека

- Зазначений

- користь

- науково-фантастичний

- наука

- Наука і технології

- вчений

- Вчені

- безпечний

- забезпечення

- Вересень

- серйозний

- загальні

- аналогічний

- розумний

- розумнішими

- суспільний

- суспільство

- деякі

- що в сім'ї щось

- Південь

- Заява

- студент

- такі

- надлюдський

- Огляд

- перемикач

- Systems

- тактика

- Приймати

- взяття

- технології

- Технології

- Технологія

- Техас

- Команда

- світ

- їх

- третій

- times

- до

- занадто

- Навчання

- лікувати

- відноситься до

- університет

- us

- використання

- Відео

- Порушення

- хотів

- війна

- попередження

- Попереджає

- способи

- Зброя

- Що

- який

- в той час як

- ВООЗ

- волі

- в

- без

- слова

- Work

- робочі

- світ

- хвилювалися

- б

- років

- YouTube

- зефірнет