Коли мова заходить про мозкові обчислення, час вирішує все. Це те, як нейрони з’єднуються в схеми. Це те, як ці схеми обробляють дуже складні дані, що призводить до дій, які можуть означати життя чи смерть. Завдяки цьому наш мозок може приймати рішення за частки секунди, навіть стикаючись із абсолютно новими обставинами. І ми робимо це, не смажачи мозок від великого споживання енергії.

Якщо перефразувати, мозок є чудовим прикладом надзвичайно потужного комп’ютера для імітації, і комп’ютерні науковці та інженери зробили перші кроки для цього. Сфера нейроморфних обчислень прагне відтворити архітектуру мозку та можливості обробки даних за допомогою нових апаратних чіпів і програмних алгоритмів. Це може бути шлях до істини штучний інтелект.

Але бракує одного важливого елемента. Більшість алгоритмів, які живлять нейроморфні чіпи, дбають лише про внесок кожного штучного нейрона, тобто про те, наскільки сильно вони з’єднані один з одним, що називається «синаптичною вагою». Чого не вистачає — але це рівнозначно внутрішній роботі нашого мозку — це часу.

Цього місяця команда, пов’язана з проектом людського мозку, головним проектом Європейського Союзу з нейронауки великих даних, додала елемент часу до нейроморфного алгоритму. Потім результати були реалізовані на фізичному апаратному забезпеченні BrainScaleS-2 нейроморфна платформа — і протиставляється найсучаснішим графічним процесорам і звичайним нейроморфним рішенням.

«Порівняно з абстрактними нейронними мережами, які використовуються в глибокому навчанні, більш біологічні архетипи… все ще відстають у плані продуктивності та масштабованості» через притаманну їм складність, кажуть автори.

У кількох тестах алгоритм порівнювався «сприятливо, з точки зору точності, затримки та енергоефективності» на стандартному порівняльному тесті, сказав Доктор Шарлотта Френкель з Цюріхського університету та ETH Zurich у Швейцарії, яка не брала участі в дослідженні. Додавши часовий компонент до нейроморфних обчислень, ми могли б розпочати нову еру високоефективного штучного інтелекту, який переходить від завдань зі статичними даними, скажімо, розпізнавання зображень, до завдань, які краще інкапсулюють час. Подумайте про відео, біосигнали чи мову «мозок-комп’ютер».

На думку провідного автора, доктора Міхая Петровича, потенціал має обидві сторони. «Наша робота цікава не лише для нейроморфних обчислень і біологічно натхненного обладнання. Він також визнає вимогу … перенести так звані підходи глибокого навчання до нейронауки і таким чином розкрити таємниці людського мозку», – сказав він. сказав.

Давайте поговоримо про Шипи

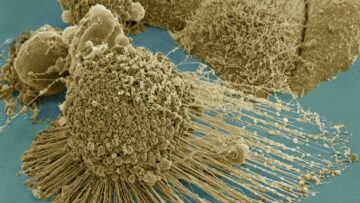

В основі нового алгоритму лежить фундаментальний принцип мозкових обчислень: спайки.

Давайте подивимося на дуже абстрактний нейрон. Це схоже на рулет із цукерками, з цибулинною середньою частиною, оточеною двома обгортками, що тягнуться назовні. Одна сторона — це вхід — складне дерево, яке отримує сигнали від попереднього нейрона. Інший — вихідний сигнал, який передає сигнали іншим нейронам за допомогою бульбашкоподібних кораблів, наповнених хімікатами, що, у свою чергу, викликає електричну реакцію на приймальному кінці.

Ось суть: щоб відбулася вся ця послідовність, нейрон має «вийти». Якщо і тільки якщо нейрон отримує достатньо високий рівень вхідного сигналу — гарно вбудований механізм зменшення шуму — цибулинна частина генеруватиме хвилю, яка рухається вниз по вихідних каналах, щоб попередити наступний нейрон.

Але нейрони не просто використовують один спайк для передачі інформації. Швидше, вони стрибають у часовій послідовності. Подумайте про це як азбуку Морзе: час, коли відбувається електричний вибух, містить велику кількість даних. Це основа для об’єднання нейронів у схеми та ієрархії, що забезпечує високоенергоефективну обробку.

Тож чому б не прийняти таку ж стратегію для нейроморфних комп’ютерів?

Спартанський чіп, схожий на мозок

Замість того, щоб скласти карту спайків одного штучного нейрона (геркулесова задача), команда відточила єдиний показник: скільки часу потрібно для спрацьовування нейрона.

Ідея коду «час до першого сплеску» проста: чим довше нейрону потрібно для сплеску, тим нижчий рівень його активності. Порівняно з підрахунком спайків, це надзвичайно рідкісний спосіб кодування активності нейрона, але він має додаткові переваги. Оскільки для кодування активації використовується лише затримка до моменту, коли нейрон вперше активізується, він фіксує швидкість реакції нейрона, не перевантажуючи комп’ютер занадто великою кількістю точок даних. Іншими словами, це швидко, енергоефективно та легко.

Потім команда закодувала алгоритм на нейроморфному чіпі BrainScaleS-2, який приблизно емулює прості «нейрони» всередині своєї структури, але працює понад 1,000 разів швидше ніж наш біологічний мозок. Платформа містить понад 500 фізичних штучних нейронів, кожен з яких здатний отримувати 256 вхідних сигналів через настроювані синапси, де біологічні нейрони обмінюються, обробляють і зберігають інформацію.

Установка є гібридною. «Навчання» досягається на чіпі, який реалізує залежний від часу алгоритм. Однак будь-які оновлення нейронної схеми — тобто те, наскільки сильно один нейрон з’єднується з іншим — досягаються за допомогою зовнішньої робочої станції, що називається «навчанням у циклі».

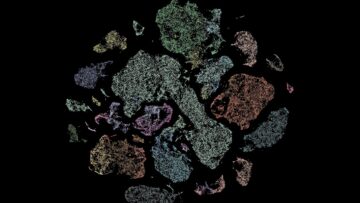

У першому тесті алгоритму було випробувано завдання «Інь-Янь», яке вимагає від алгоритму аналізу різних областей традиційного східного символу. Алгоритм був чудовим із середньою точністю 95 відсотків.

Далі команда випробувала налаштування за допомогою класичного завдання глибокого навчання:МНІСТ, набір рукописних чисел, який зробив революцію в комп’ютерному зір. Алгоритм знову виявився відмінним із майже 97-відсотковою точністю. Ще більш вражаюче те, що системі BrainScaleS-2 знадобилося менше однієї секунди, щоб класифікувати 10,000 XNUMX тестових зразків із надзвичайно низьким відносним споживанням енергії.

Помістивши ці результати в контекст, команда потім порівняла продуктивність BrainScaleS-2 — озброєного новим алгоритмом — з комерційними та іншими нейроморфними платформами. Брати SpiNNaker, масивна, паралельно розподілена архітектура, яка також імітує нейронні обчислення та спайки. Новий алгоритм був більш ніж у 100 разів швидшим у розпізнаванні зображень, споживаючи лише частку енергії, яку споживає SpiNNaker. Подібні результати були помічені з True North, передвісником нейроморфного чіпа IBM.

Що далі?

Дві найцінніші обчислювальні функції мозку — енергоефективність і паралельна обробка — зараз сильно надихають наступне покоління комп’ютерних мікросхем. Мета? Створюйте машини, які є такими ж гнучкими та адаптивними, як наш власний мозок, використовуючи при цьому лише частку енергії, необхідної для наших поточних чіпів на основі кремнію.

Проте порівняно з глибоким навчанням, яке ґрунтується на штучних нейронних мережах, біологічно правдоподібні занепали. Частково це, пояснив Френкель, полягає в складності «оновлення» цих схем шляхом навчання. Однак завдяки BrainScaleS-2 і деяким даним часу це стало можливим.

У той же час наявність «зовнішнього» арбітра для оновлення синаптичних зв’язків дає всій системі деякий час для дихання. Нейроморфне обладнання, схоже на безлад обчислень нашого мозку, всіяне невідповідностями та помилками. За допомогою мікросхеми та зовнішнього арбітра вся система може навчитися адаптуватися до цієї мінливості та, зрештою, компенсувати — або навіть використати — її особливості для швидшого й гнучкого навчання.

Для Френкеля потужність алгоритму полягає в його розрідженості. Мозок, пояснила вона, живиться розрідженими кодами, які «можуть пояснити швидкий час реакції...наприклад, для візуальної обробки». Замість того, щоб активувати цілі області мозку, потрібно лише кілька нейронних мереж, як би мчати порожніми шосе замість того, щоб застрягти в годину пік.

Незважаючи на свою потужність, алгоритм все ще має недоліки. Йому складно інтерпретувати статичні дані, хоча він чудово працює з часовими послідовностями, наприклад, мовою чи біосигналами. Але для Френкеля це початок нової структури: важливу інформацію можна закодувати за допомогою гнучкої, але простої метрики та узагальнити, щоб збагатити обробку даних на основі мозку та штучного інтелекту за рахунок частки традиційних витрат енергії.

«[Це]… може стати важливою сходинкою для вдосконалення нейроморфного обладнання, щоб нарешті продемонструвати конкурентну перевагу над звичайними нейронними мережевими підходами», — сказала вона.

Авторство зображення: Класифікація точок даних у наборі даних Інь-Ян, автори Göltz і Kriener et al. (Гейдельберг / Берн)

- 000

- 100

- Перевага

- AI

- алгоритм

- алгоритми

- Дозволити

- архітектура

- штучні нейронні мережі

- authors

- еталонний тест

- Великий даних

- мізки

- будувати

- який

- канали

- хімікалії

- чіп

- Чіпси

- код

- комерційний

- компонент

- Комп'ютерне бачення

- комп'ютери

- обчислення

- Зв'язки

- споживання

- витрати

- кредит

- Поточний

- дані

- обробка даних

- глибоке навчання

- Попит

- східний

- ефективність

- енергія

- Інженери

- ETH

- ETH Zurich

- Європейська

- ШВИДКО

- в кінці кінців

- Пожежа

- Перший

- перший раз

- Рамки

- Графічні процесори

- апаратні засоби

- Високий

- шосе

- Як

- HTTPS

- гібрид

- IBM

- ідея

- зображення

- Розпізнавання зображень

- інформація

- залучений

- IT

- вести

- провідний

- УЧИТЬСЯ

- вивчення

- рівень

- Довго

- Машинки для перманенту

- рухається

- мережу

- мереж

- Нейронний

- нейронної мережі

- нейронні мережі

- Неврологія

- шум

- На північ

- номера

- Інше

- продуктивність

- фізичний

- платформа

- Платформи

- влада

- проект

- реакція

- відповідь

- результати

- Котити

- порив

- Вчені

- судів

- простий

- So

- Софтвер

- Рішення

- старт

- зберігати

- Стратегія

- Вивчення

- Швейцарія

- система

- тест

- Тести

- час

- торкатися

- трафік

- Навчання

- університет

- Updates

- Відео

- бачення

- Багатство

- ВООЗ

- Вікіпедія

- Провід

- слова

- Work

- Цюріх