Рекламні змісту

ChatGPT і подібні інструменти, засновані на великих мовних моделях (LLM), дивовижні. Але вони не є універсальними інструментами.

Це так само, як вибір інших інструментів для будівництва та створення. Ви повинні вибрати правильний для роботи. Ви б не намагалися закрутити болт молотком або перевернути котлету для гамбургера віночком. Процес буде незручним, що призведе до безладної помилки.

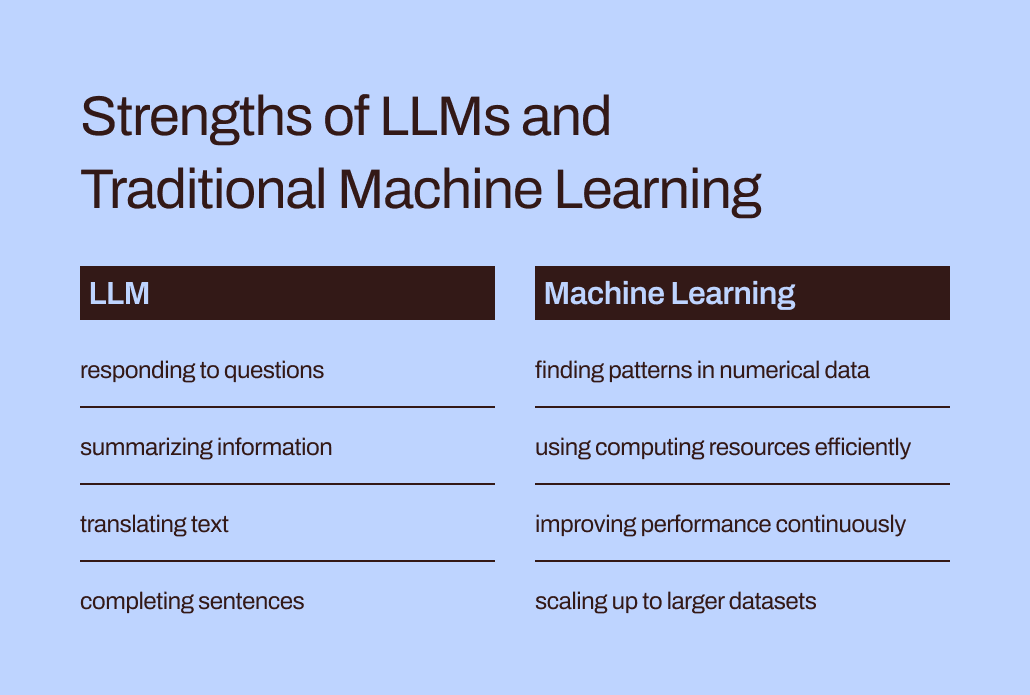

Мовні моделі, такі як LLMs, становлять лише частину ширшого набору інструментів машинного навчання, що охоплює як генеративний ШІ, так і інтелектуальний ШІ. Вибір правильного типу моделі машинного навчання має вирішальне значення для відповідності вимогам вашого завдання.

Давайте глибше розберемося, чому магістерські програми краще підходять для того, щоб допомогти вам скласти текст або обдумати ідеї подарунків, ніж для вирішення найважливіших завдань прогнозного моделювання вашого бізнесу. «Традиційні» моделі машинного навчання, які передували LLM і неодноразово доводили свою ефективність у бізнесі, все ще відіграють важливу роль. Ми також розглянемо новаторський підхід до спільного використання цих інструментів — захоплююча розробка, яку ми в Pecan називаємо Прогнозний GenAI.

LLM розроблені для слів, а не для чисел

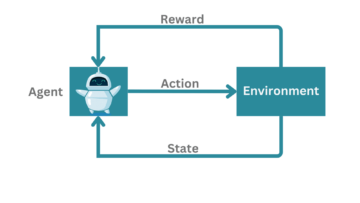

У машинному навчанні різні математичні методи використовуються для аналізу так званих «навчальних даних» — початкового набору даних, що представляє проблему, яку аналітик даних або дослідник даних сподівається вирішити.

Важливість навчальних даних важко переоцінити. Він зберігає в собі шаблони та зв’язки, які модель машинного навчання «навчиться», щоб передбачати результати, коли їй пізніше будуть надані нові, невидимі дані.

Отже, що конкретно таке LLM? Великі мовні моделі, або LLM, підпадають під егіду машинного навчання. Вони походять від глибокого навчання, а їхня структура розроблена спеціально для обробки природної мови.

Можна сказати, що вони побудовані на основі слів. Їх мета — просто передбачити, яке слово буде наступним у послідовності слів. Наприклад, функція автовиправлення iPhone в iOS 17 тепер використовує LLM, щоб краще передбачити, яке слово ви, швидше за все, збираєтеся ввести наступним.

А тепер уявіть, що ви модель машинного навчання. (Потерпіть, ми знаємо, що це натяжка.) Вас навчили передбачати слова. Ви прочитали та вивчили мільйони слів із великої кількості джерел на всілякі теми. Ваші наставники (також розробники) допомогли вам вивчити найкращі способи передбачити слова та створити новий текст, який відповідає запитам користувача.

Але тут є поворот. Тепер користувач надає вам величезну електронну таблицю даних про клієнтів і транзакції з мільйонами рядків чисел і просить вас передбачити числа, пов’язані з цими наявними даними.

Як ви думаєте, як справдяться ваші прогнози? По-перше, вас, ймовірно, роздратує те, що це завдання не відповідає тому, над чим ви так старанно працювали. (На щастя, наскільки ми знаємо, LLM ще не мають почуттів.) Що ще важливіше, вас просять виконати завдання, яке не відповідає тому, що ви навчилися робити. І ви, ймовірно, не так добре виступите.

Розрив між навчанням і завданням допомагає пояснити, чому LLMs погано підходять для прогнозних завдань, пов’язаних із числовими та табличними даними — основним форматом даних, який збирає більшість компаній. Натомість модель машинного навчання, спеціально розроблена та налаштована для обробки такого типу даних, є більш ефективною. Його буквально для цього навчили.

Проблеми ефективності та оптимізації LLM

Окрім того, що традиційні методи машинного навчання краще відповідають числовим даним, вони набагато ефективніші й легші для оптимізації для кращої продуктивності, ніж LLM.

Давайте повернемося до вашого досвіду уособлення LLM. Читання всіх цих слів і вивчення їх стилю та послідовності звучить як тонна роботи, чи не так? Щоб засвоїти всю цю інформацію, потрібно докласти чимало зусиль.

Подібним чином комплексне навчання магістрів може призвести до моделей із мільярдами параметрів. Така складність дозволяє цим моделям розуміти складні нюанси людської мови та реагувати на них. Однак інтенсивне навчання супроводжується великими обчислювальними вимогами, коли LLM генерують відповіді. Чисельно орієнтовані «традиційні» алгоритми машинного навчання, такі як дерева рішень або нейронні мережі, ймовірно, потребуватимуть набагато менше обчислювальних ресурсів. І це не випадок «що більше, то краще». Навіть якби LLM могли обробляти числові дані, ця різниця означала б, що традиційні методи машинного навчання все одно будуть швидшими, ефективнішими, екологічно стійкішими та економічно ефективнішими.

Крім того, ви коли-небудь запитували ChatGPT, як він знав, щоб надати певну відповідь? Його відповідь, ймовірно, буде дещо розпливчастою:

Я генерую відповіді на основі суміші ліцензованих даних, даних, створених інструкторами, і загальнодоступних даних. Моє навчання також включало великомасштабні набори даних, отримані з різних джерел, включаючи книги, веб-сайти та інші тексти, щоб розвинути широке розуміння людської мови. Процес навчання передбачає виконання обчислень на тисячах графічних процесорів протягом тижнів або місяців, але точні деталі та часові рамки є власністю OpenAI.

Скільки «знань», відображених у цій відповіді, надійшло від інструкторів, а не від загальнодоступних даних чи від книг? Навіть сам ChatGPT не впевнений: «Відносні пропорції цих джерел невідомі, і я не маю детального бачення того, які конкретні документи були частиною мого навчального набору».

Це трохи дратує, коли ChatGPT надає такі впевнені відповіді на ваші запитання, але не може відстежити свої відповіді до конкретних джерел. Обмежена можливість інтерпретації та пояснення LLM також створює проблеми для їх оптимізації для конкретних потреб бізнесу. Може бути важко зрозуміти обґрунтування їхньої інформації чи прогнозів. Що ще більше ускладнює ситуацію, певні підприємства сперечаються з нормативними вимогами, які означають, що вони повинні мати можливість пояснити фактори, що впливають на прогнози моделі. Загалом, ці виклики показують, що традиційні моделі машинного навчання — як правило, краще інтерпретовані та пояснювані — ймовірно, краще підходять для бізнес-випадків використання.

Правильне місце для магістерів права в інструментарії прогнозування бізнесу

Отже, чи варто нам просто залишити LLM на їхні завдання, пов’язані зі словами, і забути про них для прогнозованих випадків використання? Тепер може здатися, що вони все-таки не можуть допомогти передбачити відтік клієнтів або їхню цінність.

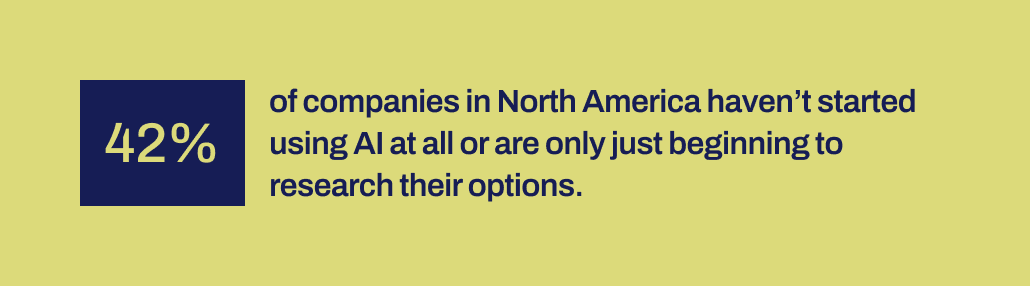

Справа ось у чому: незважаючи на те, що слова «традиційні моделі машинного навчання» роблять ці методи загальнозрозумілими та простими у використанні, ми знаємо з нашого досвіду в Pecan, що підприємствам все ще важко прийняти навіть ці більш звичні форми ШІ.

Нещодавнє дослідження Workday показує, що 42% компаній у Північній Америці або не почали використовувати ШІ, або лише перебувають на ранніх стадіях вивчення своїх можливостей. І минуло більше десяти років з тих пір, як інструменти машинного навчання стали більш доступними для компаній. Вони мали час, і різні інструменти доступні.

З певних причин успішні впровадження штучного інтелекту були напрочуд рідкісними, незважаючи на масовий галас навколо науки про дані та штучного інтелекту — і їхнього визнаного потенціалу значного впливу на бізнес. Відсутній якийсь важливий механізм, який би допоміг подолати розрив між обіцянками ШІ та здатністю його продуктивно реалізувати.

І саме в цьому ми вважаємо, що магістратури тепер можуть відігравати важливу сполучну роль. LLM можуть допомогти бізнес-користувачам подолати прірву між визначенням бізнес-проблеми для вирішення та розробкою прогнозної моделі.

З LLM тепер на картині, бізнес-команди та команди обробки даних, які не мають можливостей або можливостей для кодування моделей машинного навчання вручну, тепер можуть краще трансформувати свої потреби в моделі. Вони можуть «використовувати свої слова», як люблять говорити батьки, щоб розпочати процес моделювання.

Об’єднання магістерських програм з технікою машинного навчання, розробленою для досягнення успіху в бізнес-даних

Тепер ця можливість з’явилася в Predictive GenAI від Pecan, який поєднує сильні сторони магістерських програм з нашою вже вдосконаленою й автоматизованою платформою машинного навчання. Наш прогнозний чат на базі LLM збирає інформацію від бізнес-користувача, щоб керувати визначенням і розробкою прогнозного запитання — конкретної проблеми, яку користувач хоче вирішити за допомогою моделі.

Потім, використовуючи GenAI, наша платформа генерує прогнозний блокнот, щоб зробити наступний крок до моделювання ще простішим. Знову ж таки, базуючись на можливостях LLM, блокнот містить попередньо заповнені запити SQL для вибору навчальних даних для прогнозної моделі. Автоматизована підготовка даних, розробка функцій, створення моделей і можливості розгортання Pecan можуть виконати решту процесу в рекордно короткий час, швидше, ніж будь-яке інше рішення для прогнозного моделювання.

Коротше кажучи, Predictive GenAI від Pecan використовує неперевершені мовні навички LLM, щоб зробити нашу найкращу в своєму класі платформу прогнозного моделювання набагато доступнішою та дружнішою для бізнес-користувачів. Ми раді бачити, як цей підхід допоможе багатьом компаніям досягти успіху за допомогою ШІ.

Отже, поки LLMs тільки не дуже добре підходять для виконання всіх ваших прогнозних потреб, вони можуть відігравати потужну роль у просуванні ваших проектів ШІ. Інтерпретуючи ваш варіант використання та даючи вам перевагу за допомогою автоматично згенерованого коду SQL, Predictive GenAI від Pecan є лідером у об’єднанні цих технологій. Ти можеш перевірте це зараз із безкоштовною пробною версією.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- : має

- :є

- : ні

- :де

- 15%

- 17

- a

- здатність

- Здатний

- МЕНЮ

- доступною

- визнаний

- доповнення

- адреса

- прийняти

- після

- знову

- AI

- ака

- алгоритми

- вирівнювати

- ВСІ

- дозволяє

- тільки

- вже

- Також

- дивовижний

- Америка

- an

- аналітик

- аналізувати

- та

- відповідь

- Відповіді

- будь-який

- підхід

- ЕСТЬ

- навколо

- прибулий

- AS

- запитав

- допомогу

- At

- Автоматизований

- автоматизоване машинне навчання

- автоматично

- доступний

- назад

- заснований

- BE

- ведмідь

- стали

- було

- початок

- за

- буття

- Вірити

- КРАЩЕ

- Краще

- між

- мільярди

- Біт

- Болт

- книги

- обидва

- мозковий штурм

- BRIDGE

- мостинг

- ширше

- Створюємо

- побудований

- бізнес

- вплив на бізнес

- підприємства

- але

- by

- call

- прийшов

- CAN

- можливості

- можливості

- потужність

- нести

- випадок

- випадків

- певний

- проблеми

- прірва

- ChatGPT

- Вибираючи

- код

- збирати

- приходить

- Компанії

- Компанії

- комплекс

- складність

- обчислювальна

- обчислення

- обчислення

- впевнений

- складати

- містить

- виправити

- рентабельним

- може

- створений

- створювати

- створений

- створення

- критичний

- Перетинати

- вирішальне значення

- клієнт

- дані

- аналітик даних

- Підготовка даних

- наука про дані

- вчений даних

- набори даних

- десятиліття

- рішення

- глибокий

- глибоке навчання

- глибше

- визначення

- запити

- розгортання

- призначений

- Незважаючи на

- докладно

- деталі

- розвивати

- розвиненою

- розробників

- розвивається

- розробка

- різниця

- різний

- DIG

- do

- документація

- Ні

- Дон

- Не знаю

- проект

- малювання

- Рано

- легше

- легко

- Ефективний

- ефективність

- ефективний

- зусилля

- або

- охоплюючий

- Машинобудування

- екологічно

- Ефір (ETH)

- Навіть

- НІКОЛИ

- приклад

- перевершувати

- збуджений

- захоплюючий

- існуючий

- досвід

- Пояснювати

- Пояснюваність

- дослідити

- Дослідження

- фактори

- Провал

- Падати

- знайомий

- далеко

- швидше

- особливість

- почуття

- менше

- Перший

- відповідати

- підходить

- Flip

- для

- формат

- форми

- На щастя

- Вперед

- фонд

- Безкоштовна

- дружній

- від

- далі

- злиття

- розрив

- genai

- в цілому

- породжувати

- генерується

- генерує

- генеративний

- Генеративний ШІ

- подарунок

- даний

- дає

- дає

- Go

- мета

- Графічні процесори

- керівництво

- було

- забивати

- обробляти

- Обробка

- Жорсткий

- Мати

- притулок

- голова

- напружений режим

- допомога

- допоміг

- допомогу

- допомагає

- дуже

- тримає

- сподівається,

- Як

- Однак

- HTTPS

- людина

- i

- ідеї

- ідентифікує

- if

- картина

- Impact

- здійснювати

- реалізації

- важливо

- важливо

- in

- У тому числі

- впливаючи

- інформація

- початковий

- розпочатий

- вхід

- замість

- мати намір

- в

- залучений

- включає в себе

- за участю

- iOS

- IT

- ЙОГО

- сам

- робота

- просто

- KDnuggets

- Знати

- відомий

- мова

- великий

- масштабний

- в значній мірі

- пізніше

- провідний

- УЧИТЬСЯ

- вчений

- вивчення

- Залишати

- Ліцензований

- термін

- як

- Ймовірно

- обмеженою

- серія

- машина

- навчання за допомогою машини

- Техніка машинного навчання

- made

- зробити

- РОБОТИ

- багато

- масивний

- матч

- математичний

- значити

- механізм

- наставників

- методика

- може бути

- мільйони

- відсутній

- суміш

- модель

- моделювання

- Моделі

- місяців

- більше

- більш ефективний

- найбільш

- переміщення

- багато

- повинен

- my

- Природний

- Природна мова

- Обробка природних мов

- Необхідність

- потреби

- мереж

- Нейронний

- нейронні мережі

- Нові

- наступний

- На північ

- Північна Америка

- ноутбук

- зараз

- нюанси

- номера

- числовий

- отриманий

- of

- on

- ONE

- тільки

- OpenAI

- оптимізація

- Оптимізувати

- оптимізуючий

- Опції

- or

- Інше

- наші

- з

- Результати

- над

- завищений

- параметри

- батьки

- частина

- приватність

- моделі

- виконувати

- продуктивність

- вибирати

- картина

- Піонерський

- місце

- платформа

- plato

- Інформація про дані Платона

- PlatoData

- Play

- поза

- потенціал

- потужний

- точно

- передбачати

- прогнозування

- Прогнози

- інтелектуального

- підготовка

- первинний

- ймовірно

- Проблема

- процес

- обробка

- проектів

- обіцяє

- власником

- доведений

- забезпечувати

- громадськість

- публічно

- запити

- питання

- питань

- діапазон

- РІДНІ

- обгрунтування

- Читати

- читання

- причина

- запис

- рафінований

- відображено

- регуляторні

- пов'язаний

- Відносини

- відносний

- ПОВТОРНО

- представляє

- запросити

- Вимога

- дослідження

- ресурси

- Реагувати

- відповідь

- відповіді

- REST

- результат

- в результаті

- Виявляє

- право

- Роль

- біг

- s

- say

- приказка

- наука

- вчений

- побачити

- здається

- вибрати

- вибирає

- Послідовність

- комплект

- Короткий

- Повинен

- Показувати

- значення

- значний

- аналогічний

- просто

- з

- навички

- So

- рішення

- ВИРІШИТИ

- деякі

- Звучати

- звуки

- Джерела

- конкретний

- конкретно

- Електронна таблиця

- SQL

- етапи

- старт

- почалася

- Крок

- Як і раніше

- сильні сторони

- структура

- Бореться

- навчався

- вивчення

- стиль

- процвітати

- успішний

- такі

- Переконайтеся

- дивно

- сталого

- T

- вирішення проблем

- Приймати

- Завдання

- завдання

- команди

- методи

- Технології

- текст

- ніж

- Що

- Команда

- їх

- Їх

- Ці

- вони

- річ

- речі

- Думати

- це

- ті

- тисячі

- підтягувати

- час

- до

- разом

- Тонна

- Інструментарій

- інструменти

- теми

- до

- простежувати

- традиційний

- навчений

- Навчання

- угода

- переводити

- Дерева

- намагатися

- ПЕРЕГЛЯД

- поворот

- тип

- парасолька

- при

- розуміти

- розуміння

- зрозуміла

- об'єднуючи

- невідомий

- безпрецедентний

- us

- використання

- використання випадку

- використовуваний

- користувач

- користувачі

- використовує

- використання

- значення

- різноманітність

- різний

- величезний

- видимість

- життєво важливий

- vs

- хоче

- шлях..

- способи

- we

- веб-сайти

- тижня

- ДОБРЕ

- були

- Що

- Що таке

- коли

- який

- в той час як

- чому

- широко

- волі

- з

- в

- слово

- слова

- Work

- працював

- вартість

- б

- ще

- ви

- вашу

- зефірнет