مصنف کی طرف سے تصویر

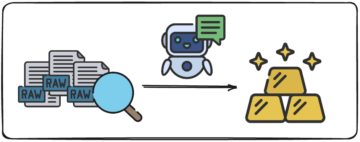

حال ہی میں ہم سب کو LLM اسپیس میں تازہ ترین ریلیز کو پکڑنے میں بہت مشکل کا سامنا کرنا پڑا ہے۔ پچھلے چند ہفتوں میں، کئی اوپن سورس ChatGPT متبادل مقبول ہو چکے ہیں۔

اور اس مضمون میں ہم اس کے بارے میں جانیں گے۔ چیٹ جی ایل ایم سیریز اور ChatGLM-6B، ایک اوپن سورس اور ہلکا پھلکا ChatGPT متبادل۔

چلو چلتے ہیں!

چین کی سنگھوا یونیورسٹی کے محققین نے ماڈلز کی ChatGLM سیریز تیار کرنے پر کام کیا ہے جس کی کارکردگی دوسرے ماڈلز جیسے GPT-3 اور BLOOM سے موازنہ ہے۔

ChatGLM ایک دو لسانی بڑی زبان کا ماڈل ہے جسے چینی اور انگریزی دونوں پر تربیت دی جاتی ہے۔ فی الحال، مندرجہ ذیل ماڈل دستیاب ہیں:

- ChatGLM-130B: ایک اوپن سورس LLM

- ChatGLM-100B: اوپن سورس نہیں، لیکن صرف دعوت نامہ تک رسائی کے ذریعے دستیاب ہے۔

- ChatGLM-6B: ایک ہلکا پھلکا اوپن سورس متبادل

اگرچہ یہ ماڈلز بڑے لینگویج ماڈلز کے جنریٹو پری ٹرینڈ ٹرانسفارمر (GPT) گروپ سے ملتے جلتے دکھائی دے سکتے ہیں۔ جنرل لینگویج ماڈل (GLM) پری ٹریننگ فریم ورک وہی ہے جو انہیں مختلف بناتا ہے. ہم اگلے حصے میں اس کے بارے میں مزید جانیں گے۔

مشین لرننگ میں، آپ GLMs کو جانتے ہوں گے۔ عمومی لکیری ماڈل، لیکن ChatGLM میں GLM کا مطلب ہے۔ عام زبان کا ماڈل.

GLM پری ٹریننگ فریم ورک

ایل ایل ایم سے پہلے کی تربیت کا بڑے پیمانے پر مطالعہ کیا گیا ہے اور اب بھی فعال تحقیق کا ایک شعبہ ہے۔ آئیے GLM پری ٹریننگ اور GPT طرز کے ماڈلز کے درمیان اہم فرق کو سمجھنے کی کوشش کرتے ہیں۔

ماڈلز کی GPT-3 فیملی ڈیکوڈر صرف آٹو ریگریسو لینگویج ماڈلنگ کا استعمال کرتی ہے۔ GLM میں، دوسری طرف، مقصد کی اصلاح کو ایک کے طور پر وضع کیا گیا ہے۔ آٹو ریگریسیو خالی بھرنے کا مسئلہ.

GLM | تصویر ماخذ

عام الفاظ میں، آٹو ریگریسیو خالی انفلنگ متن کے ایک مسلسل وقفے کو خالی کرنا، اور پھر ترتیب وار اس خالی جگہ کو دوبارہ تشکیل دینا شامل ہے۔ چھوٹے ماسک کے علاوہ، ایک لمبا ماسک ہے جو جملے کے آخر سے متن کے لمبے خالی جگہوں کو بے ترتیب طور پر ہٹا دیتا ہے۔ ایسا اس لیے کیا جاتا ہے تاکہ ماڈل فطری زبان کی سمجھ بوجھ کے ساتھ ساتھ نسل کے کاموں میں بھی اچھی کارکردگی کا مظاہرہ کرے۔

ایک اور فرق استعمال شدہ توجہ کی قسم میں ہے۔ بڑے لینگویج ماڈلز کا GPT گروپ یک طرفہ توجہ کا استعمال کرتا ہے، جبکہ LLMs کا GLM گروپ استعمال کرتا ہے۔ دو طرفہ توجہ. بے نقاب سیاق و سباق پر دو طرفہ توجہ کا استعمال انحصار کو بہتر طریقے سے پکڑ سکتا ہے اور فطری زبان کو سمجھنے کے کاموں پر کارکردگی کو بہتر بنا سکتا ہے۔

GELU ایکٹیویشن

GLM میں، GELU (Gaussian Error Linear Units) ایکٹیویشن کو ReLU ایکٹیویشن کے بجائے استعمال کیا جاتا ہے [1]۔

GELU، ReLU، اور ELU ایکٹیویشنز | تصویر ماخذ

GELU ایکٹیویشن اور تمام ان پٹس کے لیے غیر صفر اقدار رکھتا ہے اور اس کی درج ذیل شکل ہے [3]:

GELU ایکٹیویشن ReLU ایکٹیویشن کے مقابلے میں کارکردگی کو بہتر بنانے کے لیے پایا جاتا ہے، حالانکہ کمپیوٹیشنل طور پر ReLU سے زیادہ گہرا ہے۔

LLMs کی GLM سیریز میں، ChatGLM-130B جو اوپن سورس ہے اور GPT-3 کے ڈا ونچی ماڈل کے ساتھ ساتھ پرفارم کرتا ہے۔ جیسا کہ ذکر کیا گیا ہے، اس مضمون کو لکھتے وقت، ایک ChatGLM-100B ورژن موجود ہے، جو صرف دعوت تک رسائی تک محدود ہے۔

ChatGLM-6B

ChatGLM-6B کے بارے میں درج ذیل تفصیلات تاکہ اسے آخری صارفین کے لیے مزید قابل رسائی بنایا جا سکے۔

- تقریباً 6.2 بلین پیرامیٹرز ہیں۔

- یہ ماڈل 1 ٹریلین ٹوکنز پر پہلے سے تربیت یافتہ ہے — یکساں طور پر انگریزی اور چینی سے۔

- اس کے بعد، انسانی تاثرات کے ساتھ زیر نگرانی فائن ٹیوننگ اور کمک سیکھنے جیسی تکنیکوں کا استعمال کیا جاتا ہے۔

آئیے ChatGLM کے فوائد اور حدود پر جا کر اپنی بحث کو سمیٹتے ہیں:

فوائد

ایک دو لسانی ماڈل سے لے کر اوپن سورس ماڈل تک جسے آپ مقامی طور پر چلا سکتے ہیں، ChatGLM-6B کے درج ذیل فوائد ہیں:

- زیادہ تر مرکزی دھارے کی بڑی زبان کے ماڈلز انگریزی متن کے بڑے کارپورا پر تربیت یافتہ ہیں، اور دوسری زبانوں کے لیے بڑے زبان کے ماڈل اتنے عام نہیں ہیں۔ LLMs کی ChatGLM سیریز دو لسانی ہیں اور چینیوں کے لیے بہترین انتخاب ہیں۔ ماڈل کی انگریزی اور چینی دونوں میں اچھی کارکردگی ہے۔

- ChatGLM-6B صارف کے آلات کے لیے موزوں ہے۔ اختتامی صارفین کے پاس اکثر اپنے آلات پر کمپیوٹنگ کے محدود وسائل ہوتے ہیں، لہٰذا اعلی کارکردگی والے GPUs تک رسائی کے بغیر مقامی طور پر LLMs چلانا تقریباً ناممکن ہو جاتا ہے۔ کے ساتھ INT4 کوانٹائزیشن، ChatGLM-6B 6GB تک کی معمولی میموری کی ضرورت کے ساتھ چل سکتا ہے۔

- خلاصہ اور سنگل اور کثیر استفسار چیٹس سمیت متعدد کاموں پر اچھی کارکردگی کا مظاہرہ کرتا ہے۔

- دیگر مین اسٹریم LLMs کے مقابلے میں کافی حد تک کم پیرامیٹرز کے باوجود، ChatGLM-6B 2048 تک سیاق و سباق کی لمبائی کو سپورٹ کرتا ہے۔

حدود

اگلا، آئیے ChatGLM-6B کی چند حدود کی فہرست بنائیں:

- اگرچہ ChatGLM ایک دو لسانی ماڈل ہے، لیکن انگریزی میں اس کی کارکردگی ممکنہ طور پر سب سے بہتر ہے۔ اس کی وجہ تربیت میں استعمال ہونے والی ہدایات زیادہ تر چینی زبان میں ہیں۔

- کیونکہ ChatGLM-6B کافی حد تک ہے۔ کم پیرامیٹرز دیگر LLMs جیسے BLOOM، GPT-3، اور ChatGLM-130B کے مقابلے، سیاق و سباق بہت طویل ہونے پر کارکردگی بدتر ہو سکتی ہے۔ نتیجے کے طور پر، ChatGLM-6B پیرامیٹرز کی ایک بڑی تعداد والے ماڈلز کے مقابلے میں اکثر غلط معلومات دے سکتا ہے۔

- چھوٹے زبان کے ماڈل ہیں محدود میموری کی صلاحیت. لہذا، ملٹی ٹرن چیٹس میں، ماڈل کی کارکردگی قدرے کم ہو سکتی ہے۔

- تعصب، غلط معلومات، اور زہریلا پن تمام LLMs کی حدود ہیں، اور ChatGLM ان کے لیے بھی حساس ہے۔

اگلے مرحلے کے طور پر، ChatGLM-6B کو مقامی طور پر چلائیں یا HuggingFace اسپیس پر ڈیمو آزمائیں۔ اگر آپ LLMs کے کام کے بارے میں مزید گہرائی میں جانا چاہتے ہیں، تو ان کی ایک فہرست یہ ہے۔ بڑی زبان کے ماڈلز پر مفت کورسز.

[1] Z Du, Y Qian et al. GLM: آٹوریگریسو بلینک انفلنگ کے ساتھ جنرل لینگویج ماڈل پری ٹریننگ، ACL 2022

[2] اے زینگ، ایکس لیو وغیرہ، GLM-130B - ایک کھلا دو لسانی پہلے سے تربیت یافتہ ماڈل، ICML 2023

[3] ڈی ہینڈریکس، کے جیمپل، Gaussian ایرر لکیری یونٹس (GELUs)، arXiv، 2016

ہے [4] ChatGLM-6B: HuggingFace Spaces پر ڈیمو

ہے [5] گٹ ہب ریپو

بالا پریا سی ایک تکنیکی مصنف ہے جو طویل شکل کا مواد تخلیق کرنے سے لطف اندوز ہوتا ہے۔ اس کی دلچسپی کے شعبوں میں ریاضی، پروگرامنگ اور ڈیٹا سائنس شامل ہیں۔ وہ ٹیوٹوریلز، گائیڈز اور مزید بہت کچھ لکھ کر ڈویلپر کمیونٹی کے ساتھ اپنے سیکھنے کا اشتراک کرتی ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹوآئ اسٹریم۔ ویب 3 ڈیٹا انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ایڈریین ایشلے کے ساتھ مستقبل کا نقشہ بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.kdnuggets.com/2023/04/chatglm6b-lightweight-opensource-chatgpt-alternative.html?utm_source=rss&utm_medium=rss&utm_campaign=chatglm-6b-a-lightweight-open-source-chatgpt-alternative

- : ہے

- : ہے

- : نہیں

- $UP

- 1

- a

- ہمارے بارے میں

- تک رسائی حاصل

- قابل رسائی

- چالو کرنے کی

- ایکٹیویشنز

- فعال

- اس کے علاوہ

- فوائد

- AL

- تمام

- متبادل

- متبادلات

- an

- اور

- کیا

- رقبہ

- علاقوں

- مضمون

- AS

- At

- توجہ

- تصنیف

- آٹو

- دستیاب

- BE

- بن

- ہو جاتا ہے

- رہا

- کیا جا رہا ہے

- بہتر

- کے درمیان

- ارب

- بلوم

- دونوں

- لیکن

- by

- کر سکتے ہیں

- قبضہ

- چیٹ جی پی ٹی

- چین

- چینی

- انتخاب

- کامن

- کمیونٹی

- موازنہ

- مقابلے میں

- کمپیوٹنگ

- مواد

- سیاق و سباق

- سیاق و سباق

- مسلسل

- کورسز

- تخلیق

- اس وقت

- اعداد و شمار

- ڈیٹا سائنس

- گہرے

- ڈیمو

- تفصیلات

- ڈیولپر

- ترقی

- کے الات

- فرق

- اختلافات

- مختلف

- بحث

- کیا

- ای اینڈ ٹی

- آخر

- انگریزی

- خرابی

- خاندان

- آراء

- چند

- کم

- کے بعد

- کے لئے

- فارم

- ملا

- سے

- جنرل

- نسل

- پیداواری

- حاصل

- دے دو

- جا

- اچھا

- GPUs

- عظیم

- گروپ

- ہدایات

- ہاتھ

- ہارڈ

- ہے

- ہونے

- اس کی

- یہاں

- اعلی کارکردگی

- HTML

- HTTPS

- گلے لگانے والا چہرہ

- انسانی

- if

- ناممکن

- کو بہتر بنانے کے

- in

- غلط

- شامل

- سمیت

- معلومات

- کے بجائے

- ہدایات

- دلچسپی

- میں

- شامل ہے

- IT

- میں

- فوٹو

- KDnuggets

- کلیدی

- جان

- زبان

- زبانیں

- بڑے

- بڑے

- آخری

- تازہ ترین

- جانیں

- سیکھنے

- لمبائی

- ہلکا پھلکا

- کی طرح

- امکان

- حدود

- لمیٹڈ

- لنکڈ

- لسٹ

- مقامی طور پر

- لانگ

- اب

- لو

- مشین

- مشین لرننگ

- مین سٹریم میں

- بنا

- بناتا ہے

- ماسک

- ماسک

- ریاضی

- مئی..

- یاد داشت

- ذکر کیا

- غلط معلومات

- ماڈل

- ماڈلنگ

- ماڈل

- زیادہ

- قدرتی

- قدرتی زبان

- قدرتی زبان کی تفہیم

- اگلے

- تعداد

- NVIDIA

- مقصد

- of

- اکثر

- on

- کھول

- اوپن سورس

- اصلاح کے

- اصلاح

- or

- دیگر

- ہمارے

- باہر

- پر

- پیرامیٹرز

- کارکردگی

- کارکردگی کا مظاہرہ

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- مقبول

- پری

- پروگرامنگ

- قابو پانے کی تعلیم

- ریلیز

- ضرورت

- تحقیق

- وسائل

- محدود

- نتیجہ

- رن

- s

- سائنس

- سیکشن

- سیریز

- کئی

- حصص

- وہ

- اسی طرح

- سادہ

- ایک

- چھوٹے

- So

- خلا

- خالی جگہیں

- دورانیہ

- کھڑا ہے

- مرحلہ

- ابھی تک

- تعلیم حاصل کی

- اس طرح

- سپر

- کی حمایت کرتا ہے

- مناسب

- کاموں

- ٹیکنیکل

- تکنیک

- شرائط

- سے

- کہ

- ۔

- ان

- ان

- تو

- وہاں.

- لہذا

- یہ

- اس

- کے ذریعے

- وقت

- کرنے کے لئے

- بھی

- تربیت یافتہ

- ٹریننگ

- ٹریلین

- سنگھوا

- سبق

- قسم

- سمجھ

- افہام و تفہیم

- یونٹس

- یونیورسٹی

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- رکن کا

- صارفین

- کا استعمال کرتے ہوئے

- اقدار

- مختلف اقسام کے

- ورژن

- مہینے

- اچھا ہے

- کیا

- جب

- جس

- ڈبلیو

- ساتھ

- کام کیا

- کام کر

- بدتر

- لپیٹو

- مصنف

- تحریری طور پر

- X

- آپ

- زیفیرنیٹ