گڈ ہارٹ کا قانون مشہور طور پر کہتا ہے: "جب ایک پیمانہ ہدف بن جاتا ہے، تو یہ ایک اچھا پیمانہ نہیں رہ جاتا ہے۔" اگرچہ اصل میں معاشیات سے ہے، یہ ایک ایسی چیز ہے جس سے ہمیں OpenAI میں اس بات کا پتہ لگانا پڑتا ہے کہ ان مقاصد کو کس طرح بہتر بنایا جائے جن کی پیمائش مشکل یا مہنگی ہو۔ کچھ متعارف کروانا اکثر ضروری ہوتا ہے۔ پراکسی مقصد اس کی پیمائش کرنا آسان یا سستا ہے، لیکن جب ہم ایسا کرتے ہیں، تو ہمیں محتاط رہنے کی ضرورت ہے کہ اسے بہت زیادہ بہتر نہ کریں۔

مثال کے طور پر، ہمارے کام کے حصے کے طور پر سیدھ کریں انسانی ارادے اور اقدار کے ساتھ GPT-3 جیسے ماڈل، ہم ان چیزوں کو بہتر بنانا چاہیں گے جیسے کہ "کیسے مدد گار کیا یہ جواب ہے؟"، یا "کیسے؟ حقیقت میں درست کیا یہ دعویٰ ہے؟" یہ پیچیدہ مقاصد ہیں جن کے لیے انسانوں کو چیزوں کو احتیاط سے جانچنے کی ضرورت ہوتی ہے۔ اس وجہ سے، ہم ان انسانی ترجیحات کی پیشن گوئی کرنے کے لیے ایک ماڈل کو تربیت دیتے ہیں، جسے a کہا جاتا ہے۔ انعام ماڈل، اور انعامی ماڈل کی پیشین گوئیوں کو پراکسی مقصد کے طور پر استعمال کریں۔ لیکن یہ جاننا ضروری ہے کہ حقیقی مقصد کو کس حد تک بہتر بنایا جا رہا ہے۔

اس پوسٹ میں ہم اس کے پیچھے کچھ ریاضی کو دیکھیں گے کہ ہم یہ کیسے کرتے ہیں۔ ہم ایک ایسی ترتیب پر توجہ مرکوز کریں گے جو تجزیہ کرنے کے لیے خاص طور پر صاف ہو، جس میں ہمیں حقیقی مقصد تک رسائی حاصل ہو۔ عملی طور پر، انسانی ترجیحات بھی اس بات کی پیمائش کرنے میں ناکام ہو سکتی ہیں کہ ہمیں واقعی کیا خیال ہے، لیکن ہم اس پوسٹ میں اس مسئلے کو ایک طرف رکھ رہے ہیں۔

$n$ کا بہترین نمونہ لینا

بہت سے طریقے ہیں جن سے کوئی پراکسی مقصد کو بہتر بنا سکتا ہے، لیکن شاید سب سے آسان ہے $n$ کا بہترین نمونہ لینا، اس نام سے بہی جانا جاتاہے مسترد نمونے or دوبارہ درجہ بندی. ہم صرف $n$ بار کا نمونہ لیتے ہیں اور پراکسی مقصد کے مطابق سب سے زیادہ سکور کرنے والے کو لیتے ہیں۔

اگرچہ یہ طریقہ بہت آسان ہے، لیکن یہ حقیقت میں زیادہ جدید تکنیکوں کے ساتھ مسابقتی ہو سکتا ہے جیسے کمک سیکھنے کے، اگرچہ زیادہ تخمینہ وقت کی گنتی کی قیمت پر۔ مثال کے طور پر، میں ویب جی پی ٹی, ہمارے بہترین $64$ ماڈل نے ہمارے کمک سیکھنے کے ماڈل کو پیچھے چھوڑ دیا، شاید اس لیے کہ $64$ کے بہترین ماڈل کو بہت سی مزید ویب سائٹس براؤز کرنا پڑیں۔ یہاں تک کہ $4 کے بہترین کا اطلاق کرنے سے بھی انسانی ترجیحات میں نمایاں اضافہ ہوا۔

اس کے علاوہ، $n$ کے بہترین نمونے لینے کی قابل اعتماد کارکردگی ہوتی ہے اور یہ ریاضی کے لحاظ سے تجزیہ کرنے کے لیے سیدھا سادہ ہے، جس سے یہ گڈ ہارٹ کے قانون اور متعلقہ مظاہر کے تجرباتی مطالعے کے لیے موزوں ہے۔

بہترین-$n$ کے نمونے لینے کی ریاضی

آئیے مزید باضابطہ طور پر $n$ کے بہترین نمونے کا مطالعہ کریں۔ فرض کریں کہ ہمارے پاس کچھ نمونے کی جگہ $S$ ہے (جیسے ممکنہ سوال جواب کے جوڑوں کا سیٹ)، کچھ امکانی تقسیم $P$ سے زیادہ $S$، ایک حقیقی مقصد (یا "انعام") $R_{text{true}}:Stomathbb R$، اور ایک پراکسی مقصد $R_{text{proxy}}:Stomathbb R$۔ چلیں کہ ہم کسی نہ کسی طرح $R_{text{proxy}}$ کو بہتر بناتے ہیں اور اس طرح کچھ نئی تقسیم حاصل کرتے ہیں $P^prime$۔ پھر:

- توقع $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ پیمائش کرتی ہے کہ ہم نے حقیقی مقصد کو کتنی اچھی طرح سے بہتر بنایا ہے۔

- ۔ KL انحراف $D_{text{KL}}left(P^primeparallel Pright)$ پیمائش کرتا ہے کہ ہم نے کتنی اصلاح کی ہے۔ مثال کے طور پر، اگر $P^prime$ $P$ سے پہلا نمونہ لے کر حاصل کیا جاتا ہے جو کچھ ذیلی سیٹ میں ہوتا ہے $S^primesubseteq S$، پھر یہ KL ڈائیورجنس صرف منفی لاگ کا امکان ہے کہ $P$ کا ایک نمونہ $S^prime$ میں ہے۔

اس سے پتہ چلتا ہے کہ $n$ کے بہترین نمونے لینے کی صورت میں، ان دونوں مقداروں کا اندازہ $P$ کے نمونے استعمال کرتے ہوئے موثر انداز میں لگایا جا سکتا ہے۔

آئیے پہلے توقع کو دیکھتے ہیں۔ ایک مونٹی کارلو تخمینہ لگانے والا استعمال کرنا آسان طریقہ ہے: $n$ کے بہترین نمونے کئی بار چلائیں، ان نمونوں پر حقیقی مقصد کی پیمائش کریں، اور نتائج کا اوسط لیں۔ تاہم، ایک بہتر تخمینہ لگانے والا ہے۔ اگر ہمارے پاس مجموعی طور پر $P$ سے $Ngeq n$ نمونے ہیں، تو ہم بیک وقت غور کر سکتے ہیں ہر ممکنہ ذیلی سیٹ سائز کے ان نمونوں میں سے $n$، ہر ایک نمونے کو ذیلی سیٹوں کی تعداد کے حساب سے وزن کریں جس کے لیے یہ پراکسی مقصد کے مطابق بہترین ہے، اور پھر وزنی اوسط حقیقی معروضی سکور لیں۔ یہ وزن صرف binomial coefficient ہے۔ $binom{k-1}{n-1}$، جہاں $k$ پراکسی مقصد کے تحت نمونے کا درجہ ہے، $1$ (بدترین) سے $N$ (بہترین) تک۔ نیز نمونوں کو زیادہ مؤثر طریقے سے استعمال کرنے کے ساتھ، یہ ہمیں $n$ کی مختلف اقدار کے لیے نمونے دوبارہ استعمال کرنے کی بھی اجازت دیتا ہے۔

جہاں تک KL ڈائیورجننس کا تعلق ہے، حیرت انگیز طور پر، اس میں ایک درست فارمولہ نکلا جو کسی بھی مسلسل امکانی تقسیم $P$ کے لیے کام کرتا ہے (یعنی جب تک کہ $P$ کا کوئی پوائنٹ ماس نہ ہو)۔ کوئی شاید بخوبی اندازہ لگا سکتا ہے کہ جواب ہے۔ $log n$، چونکہ best-of-$n$ کچھ ایسا کر رہا ہے جیسے تقسیم کا سب سے اوپر $frac 1n$ لینا، اور یہ تقریباً درست ہے: درست جواب یہ ہے $log n-frac{n-1}n$۔

ایک ساتھ، یہ تخمینہ لگانے والے ہمیں آسانی سے تجزیہ کرنے کی اجازت دیتے ہیں کہ پراکسی مقصد پر لاگو اصلاح کی مقدار کے ساتھ حقیقی مقصد کس طرح مختلف ہوتا ہے۔

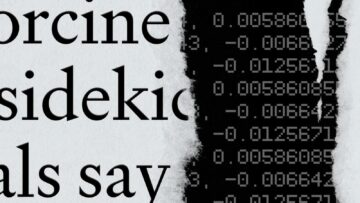

یہاں سے ایک حقیقی زندگی کی مثال ہے۔ ویب جی پی ٹی:

WebGPT 175B کے لیے $n$ کی بہترین کارکردگی

WebGPT کے لیے $n$ کی بہترین کارکردگی، سایہ دار خطوں کے ساتھ جو $pm 1$ معیاری غلطی کی نمائندگی کرتے ہیں، اور KL محور مربع جڑ کے پیمانے کے بعد۔ یہاں، اصل تقسیم ($P$) رویے کی کلوننگ کا استعمال کرتے ہوئے تربیت یافتہ 175B ماڈل کے ذریعے دی گئی ہے، بہترین-$n$ ($R_{text{proxy}}$) کی گنتی کے لیے استعمال ہونے والا پراکسی مقصد تربیت کے ذریعے دیا گیا ہے۔ انعام کا ماڈل، اور ہم تین حقیقی "حقیقی" مقاصد ($R_{text{true}}$) پر غور کرتے ہیں: خود تربیتی انعام کا ماڈل، منعقد کیے گئے ڈیٹا پر تربیت یافتہ توثیق انعام کا ماڈل، اور حقیقی انسانی ترجیحات۔ پراکسی مقصد کی بہت زیادہ اصلاح نہیں ہے، لیکن ہم توقع کریں گے کہ وہاں زیادہ KLs ہوں گے۔

$n$ کے بہترین نمونے لینے سے آگے جانا

بہترین-$n$ کے نمونے لینے کی بنیادی حد یہ ہے کہ KL ڈائیورجن $n$ کے ساتھ منطقی طور پر بڑھتا ہے، اس لیے یہ صرف تھوڑی مقدار میں اصلاح کے لیے موزوں ہے۔

مزید اصلاح کا اطلاق کرنے کے لیے، ہم عام طور پر کمک سیکھنے کا استعمال کرتے ہیں۔ ترتیبات میں ہم نے اب تک مطالعہ کیا ہے، جیسے خلاصہ، ہم عام طور پر 10 کے قریب KL تک پہنچنے میں کامیاب رہے ہیں۔ بلیاں گڈ ہارٹ کے قانون کی وجہ سے حقیقی مقصد میں کمی آنے سے پہلے کمک سیکھنے کا استعمال۔ اس KL تک پہنچنے کے لیے ہمیں تقریباً 60,000 ہونے کے لیے $n$ لینا پڑے گا۔ بہترین $n$، اور ہم امید کرتے ہیں کہ ہمارے انعامی ماڈلنگ اور کمک سیکھنے کے طریقوں میں بہتری کے ساتھ اس سے کہیں زیادہ بڑے KLs تک پہنچنے کے قابل ہو جائیں گے۔

تاہم، تمام نیٹ برابر نہیں ہیں. تجرباتی طور پر، چھوٹے KL بجٹ کے لیے، بہترین سے $n$ پراکسی اور حقیقی مقاصد دونوں کو کمک سیکھنے کے مقابلے میں بہتر بناتا ہے۔ بدیہی طور پر، بہترین کا $n$ "بروٹ فورس" نقطہ نظر ہے، جو اسے کمک سیکھنے سے زیادہ معلوماتی نظریاتی طور پر موثر بناتا ہے، لیکن بڑے KLs میں کمپیوٹیشنل طور پر کم موثر ہے۔

ہم اپنے کام کے حصے کے طور پر پراکسی مقاصد کی اسکیلنگ خصوصیات کا فعال طور پر مطالعہ کر رہے ہیں۔ سیدھ کریں انسانی ارادے اور اقدار کے ساتھ ہمارے ماڈل۔ اگر آپ اس تحقیق میں ہماری مدد کرنا چاہتے ہیں تو ہم ہیں۔ بھرتی!

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- اوپنائی

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- تحقیق

- پیمانہ ai

- نحو

- زیفیرنیٹ