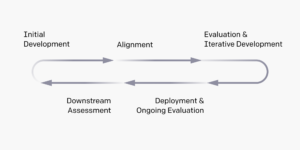

Codex, một mô hình ngôn ngữ lớn (LLM) được đào tạo trên nhiều cơ sở mã khác nhau, vượt xa trạng thái hiện đại trước đây về khả năng tổng hợp và tạo mã. Mặc dù Codex mang lại rất nhiều lợi ích, nhưng các mô hình có thể tạo mã ở quy mô như vậy có những hạn chế đáng kể, các vấn đề liên kết, khả năng bị lạm dụng và khả năng tăng tốc độ tiến bộ trong các lĩnh vực kỹ thuật mà bản thân chúng có thể gây ra các tác động gây mất ổn định hoặc có khả năng bị lạm dụng. Tuy nhiên, những tác động an toàn như vậy vẫn chưa được biết đến hoặc vẫn đang được khám phá. Trong bài báo này, chúng tôi phác thảo một khung phân tích mối nguy được xây dựng tại OpenAI để phát hiện ra các mối nguy hoặc rủi ro an toàn mà việc triển khai các mô hình như Codex có thể gây ra về mặt kỹ thuật, xã hội, chính trị và kinh tế. Phân tích được thông báo bởi một khung đánh giá mới xác định năng lực của các kỹ thuật tạo mã tiên tiến so với sự phức tạp và tính biểu cảm của các lời nhắc đặc tả, cũng như khả năng hiểu và thực thi chúng so với khả năng của con người.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Ô tô / Xe điện, Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- BlockOffsets. Hiện đại hóa quyền sở hữu bù đắp môi trường. Truy cập Tại đây.

- nguồn: https://openai.com/research/a-hazard-analysis-framework-for-code-synthesis-large-language-models

- :là

- :không phải

- a

- có khả năng

- tiên tiến

- chống lại

- Mặc dù

- phân tích

- và

- LÀ

- Nghệ thuật

- At

- BE

- Lợi ích

- by

- khả năng

- Sức chứa

- mã

- phức tạp

- triển khai

- xác định

- đánh giá

- vượt quá

- thi hành

- Khám phá

- Lĩnh vực

- Trong

- Khung

- tạo ra

- thế hệ

- Có

- HTTPS

- Nhân loại

- Tác động

- áp đặt

- in

- Tăng lên

- thông báo

- ITS

- nổi tiếng

- Ngôn ngữ

- lớn

- Lượt thích

- hạn chế

- Có thể..

- sử dụng sai

- kiểu mẫu

- mô hình

- tiểu thuyết

- of

- on

- OpenAI

- or

- đề cương

- Giấy

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- quá nhiều

- về mặt chính trị

- khả năng

- tiềm năng

- trước

- vấn đề

- Tiến độ

- cung cấp

- Tỷ lệ

- tương đối

- vẫn

- rủi ro

- Sự An Toàn

- Quy mô

- có ý nghĩa

- xã hội

- đặc điểm kỹ thuật

- Tiểu bang

- như vậy

- Kỹ thuật

- về mặt kỹ thuật

- kỹ thuật

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- tự

- điều này

- đến

- đào tạo

- khám phá

- hiểu

- nhiều

- we

- nhưng

- zephyrnet