Hình ảnh của Tác giả

Gần đây, tất cả chúng tôi đều gặp khó khăn trong việc bắt kịp các bản phát hành mới nhất trong không gian LLM. Trong vài tuần qua, một số giải pháp thay thế ChatGPT mã nguồn mở đã trở nên phổ biến.

Và trong bài này chúng ta sẽ tìm hiểu về Trò chuyệnGLM loạt và Trò chuyệnGLM-6B, một giải pháp thay thế ChatGPT mã nguồn mở và nhẹ.

Hãy bắt đầu!

Các nhà nghiên cứu tại Đại học Thanh Hoa ở Trung Quốc đã nghiên cứu phát triển loạt mô hình ChatGLM có hiệu suất tương đương với các mô hình khác như GPT-3 và BLOOM.

ChatGLM là một mô hình ngôn ngữ lớn song ngữ được đào tạo bằng cả tiếng Trung và tiếng Anh. Hiện tại, các mô hình sau đây có sẵn:

- ChatGLM-130B: một LLM mã nguồn mở

- ChatGLM-100B: không có mã nguồn mở nhưng khả dụng thông qua quyền truy cập chỉ dành cho những người được mời

- ChatGLM-6B: một giải pháp thay thế nguồn mở nhẹ

Mặc dù các mô hình này có vẻ giống với nhóm các mô hình ngôn ngữ lớn Generative Pretraining Transformer (GPT), Khuôn khổ đào tạo trước Mô hình ngôn ngữ chung (GLM) là những gì làm cho họ khác nhau. Chúng ta sẽ tìm hiểu thêm về điều này trong phần tiếp theo.

Trong học máy, bạn sẽ biết GLM là mô hình tuyến tính tổng quát, nhưng GLM trong ChatGLM là viết tắt của Mô hình ngôn ngữ chung.

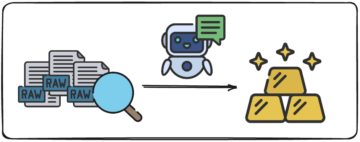

Khuôn khổ đào tạo GLM

Đào tạo trước LLM đã được nghiên cứu rộng rãi và vẫn là một lĩnh vực nghiên cứu tích cực. Hãy cố gắng tìm hiểu sự khác biệt chính giữa mô hình chuẩn bị GLM và mô hình kiểu GPT.

Dòng mô hình GPT-3 sử dụng mô hình ngôn ngữ hồi quy tự động chỉ dành cho bộ giải mã. Mặt khác, trong GLM, việc tối ưu hóa mục tiêu được hình thành như một vấn đề điền trống hồi quy tự động.

GLM | Nguồn hình ảnh

Trong thuật ngữ đơn giản, điền vào chỗ trống hồi quy tự động liên quan đến việc xóa một đoạn văn bản liên tục, sau đó tuần tự xây dựng lại văn bản trong khoảng trống này. Ngoài các mặt nạ ngắn hơn, còn có một mặt nạ dài hơn loại bỏ ngẫu nhiên các khoảng trống văn bản dài ở cuối câu. Điều này được thực hiện để mô hình thực hiện khá tốt trong việc hiểu ngôn ngữ tự nhiên cũng như các tác vụ tạo.

Một sự khác biệt khác là trong loại chú ý được sử dụng. Nhóm GPT của các mô hình ngôn ngữ lớn sử dụng sự chú ý một chiều, trong khi nhóm LLM của GLM sử dụng chú ý hai chiều. Sử dụng sự chú ý hai chiều đối với các bối cảnh không được che giấu có thể nắm bắt các yếu tố phụ thuộc tốt hơn và có thể cải thiện hiệu suất đối với các tác vụ hiểu ngôn ngữ tự nhiên.

Kích hoạt GELU

Trong GLM, kích hoạt GELU (Đơn vị tuyến tính lỗi Gaussian) được sử dụng thay vì kích hoạt ReLU [1].

Kích hoạt GELU, ReLU và ELU | Nguồn hình ảnh

Kích hoạt GELU và có các giá trị khác không cho tất cả các đầu vào và có dạng sau [3]:

Kích hoạt GELU được phát hiện là cải thiện hiệu suất so với kích hoạt ReLU, mặc dù tính toán chuyên sâu hơn ReLU.

Trong sê-ri GLM của LLM, ChatGLM-130B là mã nguồn mở và hoạt động tốt như mô hình Da-Vinci của GPT-3. Như đã đề cập, khi viết bài này, có một phiên bản ChatGLM-100B, bị hạn chế đối với quyền truy cập chỉ dành cho những người được mời.

Trò chuyệnGLM-6B

Các chi tiết sau đây về ChatGLM-6B để giúp người dùng cuối dễ tiếp cận hơn:

- Có khoảng 6.2 tỷ tham số.

- Mô hình được đào tạo trước trên 1 nghìn tỷ mã thông báo — bằng nhau từ tiếng Anh và tiếng Trung.

- Sau đó, các kỹ thuật như tinh chỉnh có giám sát và học tăng cường với phản hồi của con người được sử dụng.

Hãy kết thúc cuộc thảo luận của chúng ta bằng cách điểm qua những ưu điểm và hạn chế của ChatGLM:

Ưu điểm

Từ một mô hình song ngữ thành một mô hình nguồn mở mà bạn có thể chạy cục bộ, ChatGLM-6B có những ưu điểm sau:

- Hầu hết các mô hình ngôn ngữ lớn chính thống được đào tạo trên khối văn bản tiếng Anh lớn và các mô hình ngôn ngữ lớn cho các ngôn ngữ khác không phổ biến. Loạt ChatGLM của LLM là song ngữ và là sự lựa chọn tuyệt vời cho người Trung Quốc. Mô hình có hiệu suất tốt bằng cả tiếng Anh và tiếng Trung.

- ChatGLM-6B được tối ưu hóa cho thiết bị người dùng. Người dùng cuối thường có tài nguyên máy tính hạn chế trên thiết bị của họ, do đó gần như không thể chạy LLM cục bộ—nếu không có quyền truy cập vào GPU hiệu suất cao. Với lượng tử hóa INT4, ChatGLM-6B có thể chạy với yêu cầu bộ nhớ khiêm tốn, thấp nhất là 6GB.

- Thực hiện tốt nhiều nhiệm vụ khác nhau bao gồm tóm tắt và trò chuyện đơn và đa truy vấn.

- Mặc dù có số lượng tham số nhỏ hơn đáng kể so với các LLM chính thống khác, ChatGLM-6B hỗ trợ độ dài ngữ cảnh lên tới 2048.

Hạn chế

Tiếp theo, hãy liệt kê một số hạn chế của ChatGLM-6B:

- Mặc dù ChatGLM là một mô hình song ngữ, nhưng hiệu suất của nó bằng tiếng Anh có thể chưa đạt mức tối ưu. Điều này có thể là do các hướng dẫn được sử dụng trong đào tạo chủ yếu bằng tiếng Trung Quốc.

- Bởi vì ChatGLM-6B có đáng kể ít tham số hơn so với các LLM khác như BLOOM, GPT-3 và ChatGLM-130B, hiệu suất có thể kém hơn khi ngữ cảnh quá dài. Do đó, ChatGLM-6B có thể cung cấp thông tin không chính xác thường xuyên hơn so với các mẫu có số lượng tham số lớn hơn.

- Các mô hình ngôn ngữ nhỏ có dung lượng bộ nhớ hạn chế. Do đó, trong các cuộc trò chuyện nhiều lượt, hiệu suất của kiểu máy có thể giảm nhẹ.

- Xu hướng, thông tin sai lệch và độc tính là những hạn chế của tất cả các LLM và ChatGLM cũng dễ mắc phải những hạn chế này.

Bước tiếp theo, hãy chạy ChatGLM-6B cục bộ hoặc thử bản trình diễn trên không gian HuggingFace. Nếu bạn muốn tìm hiểu sâu hơn về hoạt động của LLM, đây là danh sách các khóa học miễn phí về các mô hình ngôn ngữ lớn.

[1] Z Du, Y Qian và cộng sự, GLM: Đào tạo trước mô hình ngôn ngữ chung với điền vào chỗ trống tự hồi quy, ACL 2022

[2] A Zheng, X Liu và cộng sự, GLM-130B – Mô hình đào tạo trước song ngữ mở, ICML 2023

[3] D Hendryks, K Gimpel, Đơn vị tuyến tính lỗi Gaussian (GELU), arXiv, 2016

[4] ChatGLM-6B: Demo trên Không gian ôm mặt

[5] Kho lưu trữ GitHub

Bala Priya C là một nhà văn kỹ thuật thích tạo nội dung dài. Các lĩnh vực cô quan tâm bao gồm toán học, lập trình và khoa học dữ liệu. Cô ấy chia sẻ kiến thức của mình với cộng đồng nhà phát triển bằng cách biên soạn các hướng dẫn, hướng dẫn cách thực hiện, v.v.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoAiStream. Thông minh dữ liệu Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Đúc kết tương lai với Adryenn Ashley. Truy cập Tại đây.

- nguồn: https://www.kdnuggets.com/2023/04/chatglm6b-lightweight-opensource-chatgpt-alternative.html?utm_source=rss&utm_medium=rss&utm_campaign=chatglm-6b-a-lightweight-open-source-chatgpt-alternative

- : có

- :là

- :không phải

- $ LÊN

- 1

- a

- Giới thiệu

- truy cập

- có thể truy cập

- kích hoạt

- kích hoạt

- hoạt động

- Ngoài ra

- lợi thế

- AL

- Tất cả

- thay thế

- lựa chọn thay thế

- an

- và

- LÀ

- KHU VỰC

- khu vực

- bài viết

- AS

- At

- sự chú ý

- tác giả

- tự động

- có sẵn

- BE

- trở nên

- trở thành

- được

- được

- Hơn

- giữa

- Tỷ

- Hoa

- cả hai

- nhưng

- by

- CAN

- nắm bắt

- ChatGPT

- Trung Quốc

- Trung Quốc

- sự lựa chọn

- Chung

- cộng đồng

- so sánh

- so

- máy tính

- nội dung

- bối cảnh

- bối cảnh

- liên tục

- các khóa học

- Tạo

- Hiện nay

- dữ liệu

- khoa học dữ liệu

- sâu sắc hơn

- Demo

- chi tiết

- Nhà phát triển

- phát triển

- Thiết bị (Devices)

- sự khác biệt

- sự khác biệt

- khác nhau

- thảo luận

- thực hiện

- E&T

- cuối

- Tiếng Anh

- lôi

- gia đình

- thông tin phản hồi

- vài

- ít hơn

- tiếp theo

- Trong

- hình thức

- tìm thấy

- từ

- Tổng Quát

- thế hệ

- thế hệ

- được

- Cho

- đi

- tốt

- GPU

- tuyệt vời

- Nhóm

- Hướng dẫn

- tay

- Cứng

- Có

- có

- cô

- tại đây

- hiệu suất cao

- HTML

- HTTPS

- ÔmKhuôn Mặt

- Nhân loại

- if

- không thể

- nâng cao

- in

- không chính xác

- bao gồm

- Bao gồm

- thông tin

- thay vì

- hướng dẫn

- quan tâm

- trong

- liên quan đến

- IT

- ITS

- jpg

- Xe đẩy

- Key

- Biết

- Ngôn ngữ

- Ngôn ngữ

- lớn

- lớn hơn

- Họ

- mới nhất

- LEARN

- học tập

- Chiều dài

- trọng lượng nhẹ

- Lượt thích

- Có khả năng

- hạn chế

- Hạn chế

- Danh sách

- tại địa phương

- dài

- còn

- Thấp

- máy

- học máy

- Mainstream

- làm cho

- LÀM CHO

- mặt nạ

- Mặt nạ

- toán học

- Có thể..

- Bộ nhớ

- đề cập

- Thông tin sai

- kiểu mẫu

- người mẫu

- mô hình

- chi tiết

- Tự nhiên

- Ngôn ngữ tự nhiên

- Hiểu ngôn ngữ tự nhiên

- tiếp theo

- con số

- Nvidia

- Mục tiêu

- of

- thường

- on

- mở

- mã nguồn mở

- tối ưu hóa

- tối ưu hóa

- or

- Nền tảng khác

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- ra

- kết thúc

- thông số

- hiệu suất

- thực hiện

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- Phổ biến

- trước

- Lập trình

- học tăng cường

- Phát hành

- yêu cầu

- nghiên cứu

- Thông tin

- hạn chế

- kết quả

- chạy

- s

- Khoa học

- Phần

- Loạt Sách

- một số

- cổ phiếu

- chị ấy

- tương tự

- Đơn giản

- duy nhất

- nhỏ hơn

- So

- Không gian

- không gian

- nhịp cầu

- đứng

- Bước

- Vẫn còn

- nghiên cứu

- như vậy

- lớn

- Hỗ trợ

- apt

- nhiệm vụ

- Kỹ thuật

- kỹ thuật

- về

- hơn

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- sau đó

- Đó

- vì thế

- Kia là

- điều này

- Thông qua

- thời gian

- đến

- quá

- đào tạo

- Hội thảo

- Nghìn tỷ

- Thanh Hoa

- hướng dẫn

- kiểu

- hiểu

- sự hiểu biết

- các đơn vị

- trường đại học

- sử dụng

- đã sử dụng

- người sử dang

- Người sử dụng

- sử dụng

- Các giá trị

- nhiều

- phiên bản

- tuần

- TỐT

- Điều gì

- khi nào

- cái nào

- CHÚNG TÔI LÀ

- với

- làm việc

- đang làm việc

- tệ hơn

- bọc

- nhà văn

- viết

- X

- bạn

- zephyrnet