Mạng lưới thần kinh học thông qua các con số, vì vậy mỗi từ sẽ được ánh xạ tới các vectơ để biểu thị một từ cụ thể. Lớp nhúng có thể được coi là một bảng tra cứu lưu trữ các từ nhúng và truy xuất chúng bằng cách sử dụng các chỉ số.

Các từ có cùng nghĩa sẽ gần nhau về khoảng cách euclidian/độ tương tự cosine. ví dụ: trong biểu diễn từ bên dưới, “Saturday”, “Sunday” và “Monday” được liên kết với cùng một khái niệm, vì vậy chúng ta có thể thấy rằng các từ này có kết quả tương tự nhau.

Việc xác định vị trí của từ, Vì sao cần xác định vị trí của từ? bởi vì, bộ mã hóa biến áp không có tính lặp lại như mạng thần kinh tái phát, chúng ta phải thêm một số thông tin về các vị trí vào phần nhúng đầu vào. Điều này được thực hiện bằng cách sử dụng mã hóa vị trí. Các tác giả của bài báo đã sử dụng các chức năng sau để mô hình hóa vị trí của một từ.

Chúng tôi sẽ cố gắng giải thích Mã hóa vị trí.

Ở đây “pos” đề cập đến vị trí của “từ” trong chuỗi. P0 đề cập đến vị trí nhúng của từ đầu tiên; “d” có nghĩa là kích thước của từ/mã thông báo nhúng. Trong ví dụ này d=5. Cuối cùng, “i” đề cập đến từng thứ nguyên trong số 5 thứ nguyên riêng lẻ của quá trình nhúng (tức là 0, 1,2,3,4)

nếu “i” thay đổi trong phương trình trên, bạn sẽ nhận được một loạt các đường cong với tần số thay đổi. Đọc các giá trị nhúng vị trí theo các tần số khác nhau, đưa ra các giá trị khác nhau ở các kích thước nhúng khác nhau cho P0 và P4.

Với truy vấn, Q đại diện cho một từ vector, các phím K là tất cả các từ khác trong câu, và giá trị V đại diện cho vectơ của từ.

Mục đích của sự chú ý là tính toán mức độ quan trọng của thuật ngữ chính so với thuật ngữ truy vấn liên quan đến cùng một người/sự vật hoặc khái niệm.

Trong trường hợp của chúng ta, V bằng Q.

Cơ chế chú ý cho chúng ta tầm quan trọng của từ trong câu.

Khi chúng tôi tính toán sản phẩm dấu chấm được chuẩn hóa giữa truy vấn và các khóa, chúng tôi nhận được một tenxơ biểu thị tầm quan trọng tương đối của từng từ khác đối với truy vấn.

Khi tính toán tích vô hướng giữa Q và KT, chúng tôi cố gắng ước tính cách các vectơ (tức là các từ nằm giữa truy vấn và khóa) được căn chỉnh và trả về trọng số cho mỗi từ trong câu.

Sau đó, chúng tôi chuẩn hóa bình phương kết quả của d_k và Hàm softmax chuẩn hóa các thuật ngữ và thay đổi kích thước của chúng trong khoảng từ 0 đến 1.

Cuối cùng, chúng tôi nhân kết quả (tức là trọng số) với giá trị (tức là tất cả các từ) để giảm tầm quan trọng của các từ không liên quan và chỉ tập trung vào các từ quan trọng nhất.

Vectơ đầu ra chú ý nhiều đầu được thêm vào nhúng đầu vào vị trí ban đầu. Điều này được gọi là kết nối còn lại/bỏ qua kết nối. Đầu ra của kết nối còn lại trải qua quá trình chuẩn hóa lớp. Đầu ra còn lại được chuẩn hóa được truyền qua mạng chuyển tiếp nguồn cấp dữ liệu theo chiều kim đồng hồ để xử lý thêm.

Mặt nạ là một ma trận có cùng kích thước với điểm chú ý được lấp đầy bằng các giá trị 0 và vô cực âm.

Lý do của mặt nạ là một khi bạn lấy softmax của các điểm số được che dấu, các điểm vô cực âm sẽ bằng XNUMX, không để lại điểm số chú ý cho các mã thông báo trong tương lai.

Điều này yêu cầu người mẫu không tập trung vào những từ đó.

Mục đích của hàm softmax là lấy các số thực (dương và âm) và biến chúng thành số dương có tổng bằng 1.

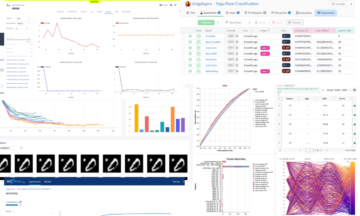

Ravikumar Naduvin đang bận xây dựng và tìm hiểu các tác vụ NLP bằng PyTorch.

Nguyên. Đăng lại với sự cho phép.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. Truy cập Tại đây.

- nguồn: https://www.kdnuggets.com/2023/01/concepts-know-getting-transformer.html?utm_source=rss&utm_medium=rss&utm_campaign=concepts-you-should-know-before-getting-into-transformer

- 1

- a

- Giới thiệu

- ở trên

- thêm

- chống lại

- căn chỉnh

- Tất cả

- và

- liên kết

- sự chú ý

- tác giả

- bởi vì

- trước

- phía dưới

- giữa

- Xây dựng

- xăn lên

- gọi là

- trường hợp

- Đóng

- so

- Tính

- máy tính

- khái niệm

- khái niệm

- liên quan

- Xác định

- xác định

- khác nhau

- kích thước

- DOT

- mỗi

- ước tính

- ví dụ

- Giải thích

- đầy

- Cuối cùng

- Tên

- Tập trung

- tiếp theo

- chức năng

- chức năng

- xa hơn

- tương lai

- được

- nhận được

- GitHub

- cho

- Cho

- Đi

- lấy

- Độ đáng tin của

- HTTPS

- tầm quan trọng

- quan trọng

- in

- CHỈ SỐ

- hệ thống riêng biệt,

- thông tin

- đầu vào

- Xe đẩy

- Key

- phím

- Biết

- lớp

- LEARN

- để lại

- tra cứu

- mặt nạ

- Matrix

- có nghĩa là

- có nghĩa

- cơ chế

- kiểu mẫu

- hầu hết

- Cần

- tiêu cực

- mạng

- mạng

- Thần kinh

- mạng thần kinh

- nlp

- số

- nguyên

- Nền tảng khác

- Giấy

- riêng

- thông qua

- cho phép

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- vị trí

- vị trí

- tích cực

- xử lý

- Sản phẩm

- mục đích

- đặt

- ngọn đuốc

- Reading

- thực

- lý do

- sự tái xuất

- giảm

- đề cập

- liên quan

- đại diện

- đại diện

- đại diện cho

- kết quả

- kết quả

- trở lại

- tương tự

- kết án

- Trình tự

- nên

- tương tự

- Kích thước máy

- So

- một số

- Bình phương

- cửa hàng

- bàn

- Hãy

- nhiệm vụ

- nói

- về

- Sản phẩm

- nghĩ

- Thông qua

- đến

- Tokens

- máy biến áp

- XOAY

- sự hiểu biết

- us

- giá trị

- Các giá trị

- trọng lượng

- cái nào

- sẽ

- Từ

- từ

- zephyrnet

- không