AI và máy tính thông thường là một trận đấu được thực hiện trong địa ngục.

Lý do chính là cách thiết lập chip phần cứng. Dựa trên kiến trúc Von Neumann truyền thống, con chip cách ly bộ nhớ lưu trữ khỏi bộ vi xử lý chính của nó. Mỗi phép tính là một hành trình đi làm buổi sáng thứ Hai đầy ác mộng, với con chip liên tục chuyển dữ liệu qua lại từ mỗi ngăn, tạo thành một "khét tiếng"bức tường ký ức".

Nếu bạn đã từng bị kẹt xe, bạn sẽ biết sự thất vọng: mất thời gian và lãng phí sức lực. Khi các thuật toán AI ngày càng trở nên phức tạp, vấn đề ngày càng trở nên tồi tệ hơn.

Vậy tại sao không thiết kế một con chip dựa trên bộ não, một kết hợp hoàn hảo tiềm năng cho mạng lưới thần kinh sâu?

Nhập chip máy tính trong bộ nhớ hoặc CIM. Trung thành với tên gọi của chúng, những con chip này tính toán và lưu trữ bộ nhớ tại cùng một trang web. Quên đi lại; các chip này là lựa chọn thay thế làm việc tại nhà hiệu quả cao, giải quyết vấn đề tắc nghẽn lưu lượng dữ liệu và hứa hẹn hiệu quả cao hơn và tiêu thụ năng lượng thấp hơn.

Hoặc lý thuyết cũng vậy. Hầu hết các chip CIM chạy các thuật toán AI chỉ tập trung vào thiết kế chip, thể hiện khả năng của chúng bằng cách sử dụng mô phỏng chip hơn là chạy các tác vụ trên phần cứng chính thức. Các con chip này cũng phải vật lộn để điều chỉnh với nhiều tác vụ AI khác nhau — nhận dạng hình ảnh, nhận dạng giọng nói — hạn chế khả năng tích hợp của chúng vào điện thoại thông minh hoặc các thiết bị hàng ngày khác.

Tháng này, một nghiên cứu in Thiên nhiên đã nâng cấp CIM từ đầu. Thay vì chỉ tập trung vào thiết kế của chip, nhóm quốc tế - dẫn đầu bởi các chuyên gia phần cứng thần kinh, Tiến sĩ HS Philip Wong tại Stanford và Tiến sĩ Gert Cauwenberghs tại UC San Diego - đã tối ưu hóa toàn bộ thiết lập, từ công nghệ đến kiến trúc đến các thuật toán hiệu chỉnh phần cứng .

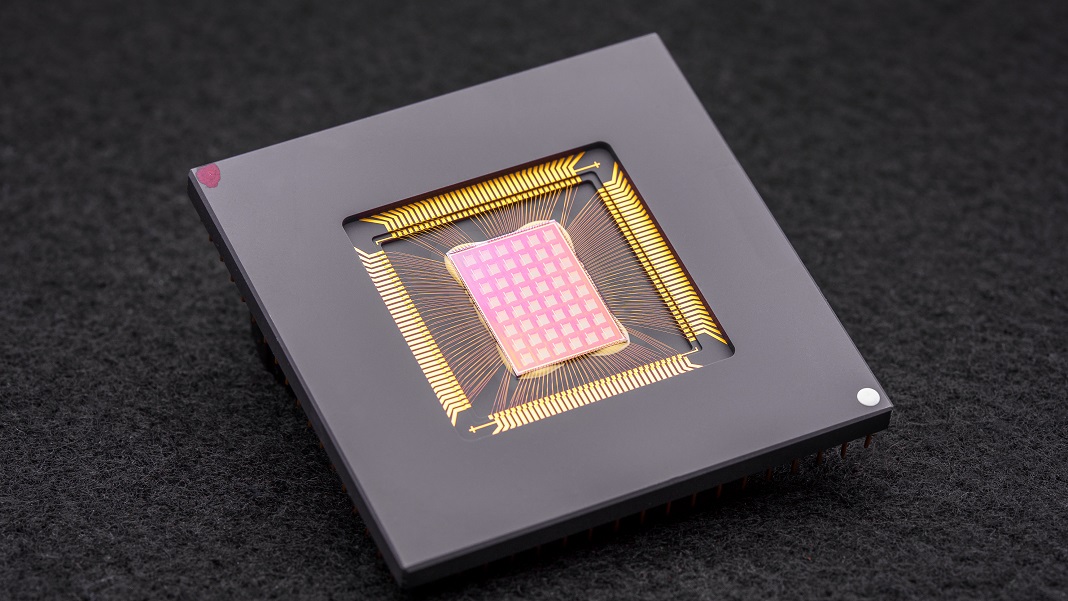

Kết quả là chip NeuRRAM là một cỗ máy tính toán thần kinh đa hình mạnh mẽ với 48 lõi song song và 3 triệu ô nhớ. Cực kỳ linh hoạt, chip xử lý nhiều tác vụ tiêu chuẩn AI — chẳng hạn như đọc số viết tay, xác định ô tô và các đối tượng khác trong hình ảnh và giải mã bản ghi âm giọng nói — với độ chính xác hơn 84%.

Mặc dù tỷ lệ thành công có vẻ tầm thường, nhưng nó ngang ngửa với các chip kỹ thuật số hiện có nhưng lại tiết kiệm đáng kể năng lượng. Đối với các tác giả, đó là một bước tiến gần hơn đến việc đưa AI trực tiếp vào thiết bị của chúng tôi thay vì cần chuyển dữ liệu lên đám mây để tính toán.

“Việc thực hiện những tính toán đó trên chip thay vì gửi thông tin đến và đi từ đám mây có thể cho phép AI nhanh hơn, an toàn hơn, rẻ hơn và có khả năng mở rộng cao hơn trong tương lai và cung cấp cho nhiều người hơn quyền truy cập vào sức mạnh AI”. nói wong.

Cảm hứng thần kinh

Chip dành riêng cho AI bây giờ là một tá xu đáng kinh ngạc. Từ Bộ xử lý Tensor (TPU) của Google và kiến trúc siêu máy tính Dojo của Tesla cho đến Baidu và Amazon, các gã khổng lồ công nghệ đang đầu tư hàng triệu USD vào chip AI để xây dựng bộ vi xử lý hỗ trợ các thuật toán học sâu ngày càng phức tạp. Một số thậm chí khai thác máy học để thiết kế kiến trúc chip được thiết kế riêng cho phần mềm AI, mang đến cuộc đua trọn vẹn.

Một khái niệm đặc biệt hấp dẫn đến từ não bộ. Khi dữ liệu đi qua các tế bào thần kinh của chúng ta, chúng “kết nối” thành mạng thông qua các “bến” vật lý được gọi là khớp thần kinh. Những cấu trúc này, nằm trên đỉnh của các nhánh thần kinh giống như những chiếc nấm nhỏ, là những cơ quan đa nhiệm: chúng vừa tính toán và lưu trữ dữ liệu thông qua những thay đổi trong thành phần protein của chúng.

Nói cách khác, các nơ-ron, không giống như các máy tính cổ điển, không cần chuyển dữ liệu từ bộ nhớ đến CPU. Điều này mang lại lợi thế cho bộ não so với các thiết bị kỹ thuật số: nó tiết kiệm năng lượng cao và thực hiện nhiều phép tính đồng thời, tất cả được đóng gói trong một viên thạch nặng ba pound nhồi bên trong hộp sọ.

Tại sao không tái tạo các khía cạnh của não?

đăng ký hạng mục thi tính toán neuromorphic. Một cách hack là sử dụng RRAM, hoặc thiết bị bộ nhớ truy cập ngẫu nhiên điện trở (còn được gọi là 'memristors'). RRAM lưu trữ bộ nhớ ngay cả khi bị cắt điện bằng cách thay đổi điện trở của phần cứng. Tương tự như khớp thần kinh, các thành phần này có thể được đóng gói thành các mảng dày đặc trên một khu vực nhỏ, tạo ra các mạch có khả năng tính toán phức tạp cao mà không cần khối lượng lớn. Khi được kết hợp với CMOS, một quy trình chế tạo để xây dựng các mạch trong bộ vi xử lý và chip hiện tại của chúng tôi, bộ đôi trở nên mạnh mẽ hơn nữa để chạy các thuật toán học sâu.

Nhưng nó phải trả giá đắt. Các tác giả cho biết: “Việc tính toán tương tự song song cao trong kiến trúc RRAM-CIM mang lại hiệu quả vượt trội, nhưng khiến việc nhận ra mức độ linh hoạt chức năng và độ chính xác tính toán tương tự như trong các mạch kỹ thuật số là khó khăn.

Thần tối ưu hóa

Nghiên cứu mới đã đi sâu vào từng bộ phận của chip RRAM-CIM, thiết kế lại nó để sử dụng trong thực tế.

Nó bắt đầu với công nghệ. NeuRRAM tự hào có 48 lõi tính toán song song, với các thiết bị RRAM được đan xen vật lý vào các mạch CMOS. Giống như một tế bào thần kinh, mỗi lõi có thể được tắt riêng lẻ khi không sử dụng, bảo toàn năng lượng trong khi bộ nhớ của nó được lưu trữ trên RRAM.

Các ô RRAM này — tất cả ba triệu ô — được liên kết để dữ liệu có thể truyền theo cả hai hướng. Đó là một thiết kế quan trọng, cho phép chip linh hoạt thích ứng với nhiều loại thuật toán AI khác nhau, các tác giả giải thích. Ví dụ, một loại mạng nơ-ron sâu, CNN (mạng nơ-ron tích tụ), đặc biệt tuyệt vời về thị giác máy tính, nhưng cần dữ liệu truyền theo một hướng duy nhất. Ngược lại, LSTM, một loại mạng thần kinh sâu thường được sử dụng để nhận dạng âm thanh, xử lý dữ liệu lặp lại để khớp tín hiệu với thời gian. Giống như các khớp thần kinh, chip mã hóa mức độ mạnh mẽ của một “nơ-ron” RRAM kết nối với một tế bào khác.

Kiến trúc này cho phép tinh chỉnh luồng dữ liệu để giảm thiểu tắc đường. Giống như việc mở rộng lưu lượng truy cập một làn sang nhiều làn, chip có thể nhân bản “bộ nhớ” hiện tại của mạng từ hầu hết các vấn đề tính toán chuyên sâu, để nhiều lõi phân tích vấn đề đồng thời.

Lần cải tiến cuối cùng đối với các chip CIM trước đây là cầu nối mạnh mẽ hơn giữa tính toán giống như bộ não — thường là tương tự — và xử lý kỹ thuật số. Ở đây, con chip sử dụng một mạch nơ-ron có thể dễ dàng chuyển đổi phép tính tương tự sang tín hiệu số. Các tác giả giải thích, đó là một bước tiến so với các thiết lập “đói điện và đói diện tích” trước đây.

Các tối ưu hóa đã hoạt động. Đưa lý thuyết của họ vào thử nghiệm, nhóm đã sản xuất chip NeuRRAM và phát triển các thuật toán để lập trình phần cứng cho các thuật toán khác nhau — như Play Station 5 chạy các trò chơi khác nhau.

Trong vô số các bài kiểm tra điểm chuẩn, con chip này đã hoạt động như một nhà vô địch. Chạy CNN bảy lớp trên chip, NeuRRAM có tỷ lệ lỗi ít hơn một phần trăm khi nhận dạng các chữ số viết tay bằng cách sử dụng cơ sở dữ liệu MNIST phổ biến.

Nó cũng xuất sắc trong các nhiệm vụ khó khăn hơn. Đang tải một mạng thần kinh sâu phổ biến khác, LSTM, con chip này chính xác khoảng 85% khi được thử thách với tính năng nhận dạng lệnh giọng nói của Google. Chỉ sử dụng tám lõi, con chip — chạy trên một kiến trúc AI khác — có thể khôi phục hình ảnh bị nhiễu, giảm khoảng 70% lỗi.

Vậy thì sao?

Một từ: năng lượng.

Hầu hết các thuật toán AI là tổng năng lượng. NeuRRAM hoạt động với chi phí năng lượng bằng một nửa so với các chip RRAM-CIM hiện đại trước đây, tiếp tục biến lời hứa tiết kiệm năng lượng với tính toán thần kinh cơ thành hiện thực.

Nhưng điểm nổi bật của nghiên cứu là chiến lược của nó. Thông thường khi thiết kế chip, các nhà khoa học cần cân bằng giữa hiệu quả, tính linh hoạt và độ chính xác cho nhiều nhiệm vụ — các chỉ số thường mâu thuẫn với nhau. Vấn đề càng trở nên khó khăn hơn khi tất cả các tính toán được thực hiện trực tiếp trên phần cứng. NeuRRAM cho thấy rằng có thể chiến đấu với tất cả các con thú cùng một lúc.

Chiến lược được sử dụng ở đây có thể được sử dụng để tối ưu hóa các thiết bị tính toán thần kinh đa hình khác như công nghệ bộ nhớ thay đổi giai đoạns, các tác giả cho biết.

Hiện tại, NeuRRAM là một bằng chứng về khái niệm, cho thấy rằng một con chip vật lý - chứ không phải là một mô phỏng của nó - hoạt động như dự định. Nhưng vẫn có chỗ để cải thiện, bao gồm việc mở rộng quy mô hơn nữa RRAM và thu nhỏ kích thước của nó đến một ngày nào đó có khả năng phù hợp với điện thoại của chúng ta.

“Có thể ngày nay nó được sử dụng để thực hiện các tác vụ AI đơn giản như phát hiện từ khóa hoặc phát hiện con người, nhưng ngày mai nó có thể mang lại trải nghiệm người dùng hoàn toàn khác. Hãy tưởng tượng phân tích video thời gian thực kết hợp với nhận dạng giọng nói trong một thiết bị nhỏ bé ” nói tác giả nghiên cứu, Tiến sĩ Weier Wan. “Là một nhà nghiên cứu và một kỹ sư, tham vọng của tôi là đưa những đổi mới nghiên cứu từ phòng thí nghiệm vào ứng dụng thực tế.”