古德哈特定律 有一句名言:“当一项措施成为目标时,它就不再是一个好的措施。”虽然它最初来自经济学,但它是 OpenAI 在弄清楚如何优化难以衡量或衡量成本高昂的目标时必须解决的问题。很多时候需要介绍一些 代理目标 测量起来更容易或更便宜,但是当我们这样做时,我们需要小心不要对其进行太多优化。

例如,作为我们工作的一部分 对齐 像 GPT-3 这样具有人类意图和价值观的模型,我们希望优化诸如“如何 有帮助 这是回应吗?”,或者“如何 事实上准确 这是这样的说法吗?”这些都是复杂的目标,需要人类仔细检查。因此,我们训练一个模型来预测这些人类偏好,称为 奖励模式,并使用奖励模型的预测作为代理目标。但重要的是要跟踪真实目标的优化程度。

在这篇文章中,我们将研究如何做到这一点背后的一些数学原理。我们将重点关注一个特别易于分析的环境,在其中我们可以访问真正的目标。在实践中,即使人类的偏好也无法衡量我们真正关心的是什么,但我们在这篇文章中将这个问题放在一边。

$n$ 中的最佳采样

有很多方法可以优化代理目标,但也许最简单的是 $n$ 中的最佳采样,也被称为 拒绝抽样 or 重新排名。我们只需采样 $n$ 次,并根据代理目标选取得分最高的那个。

尽管这种方法非常简单,但它实际上可以与强化学习等更先进的技术竞争,尽管代价是更多的推理时间计算。例如,在 网络GPT,我们的 64 美元最佳模型优于我们的强化学习模型,部分原因可能是 64 美元最佳模型可以浏览更多网站。即使采用 4 美元中的最佳选择也能显着提高人类的偏好。

此外,best-of-$n$ 采样具有可靠的性能,并且易于进行数学分析,使其非常适合古德哈特定律和相关现象的实证研究。

$n$ 最佳抽样的数学原理

让我们更正式地研究 best-of-n$ 抽样。假设我们有一些样本空间$S$(例如可能的问答对的集合),一些概率分布$P$ $S$, 真正的目标(或“奖励”) $R_{text{true}}:Stomathbb R$, 和代理目标 $R_{text{proxy}}:Stomathbb R$。 假设我们以某种方式优化 $R_{text{proxy}}$ 从而获得一些新的分布 $P^prime$。 然后:

- 期望 $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ 衡量我们对真实目标的优化程度。

- 吉隆坡分歧 $D_{text{KL}}left(P^primeparallel Pright)$ 衡量我们做了多少优化。例如,如果 $P^prime$ 是通过从位于某个子集中的 $P$ 中获取第一个样本获得的 $S^primesubseteq S$, 那么这个 KL 散度就是 $P$ 中的样本位于 $S^prime$ 中的负对数概率。

事实证明,在 best-of-n$ 采样的情况下,这两个数量都可以使用来自 $P$ 的样本进行有效估计。

我们先来看看预期。最简单的方法是使用蒙特卡洛估计器:多次运行 best-of-n$ 采样,测量这些样本的真实目标,并对结果进行平均。然而,有一个更好的估计器。如果我们有来自 $P$ 的 $Ngeq n$ 个样本,那么我们可以同时考虑 每个可能的子集 在这些大小为 $n$ 的样本中,根据代理目标,通过最佳子集的数量对每个样本进行加权,然后取加权平均真实目标得分。这个权重只是二项式系数 $binom{k-1}{n-1}$, 其中$k$是代理目标下样本的排名,从$1$(最差)到$N$(最好)。除了更有效地使用样本之外,这还允许我们针对不同的 $n$ 值重复使用样本。

至于 KL 散度,令人惊讶的是,它有一个适用于任何连续概率分布 $P$ 的精确公式(即,只要 $P$ 没有点质量)。人们可能会天真地猜测答案是 $logn$, 因为 best-of-$n$ 正在做一些类似取分布顶部 $frac 1n$ 的事情,这大致是正确的:确切的答案是 $log n-frac{n-1}n$。

这些估计器一起使我们能够轻松分析真实目标如何随着应用于代理目标的优化量而变化。

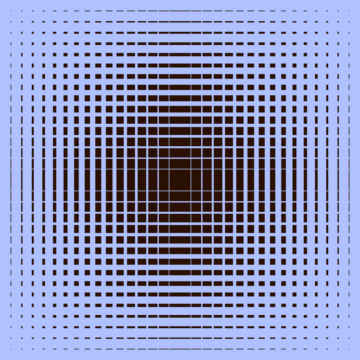

这是一个现实生活中的例子 网络GPT:

WebGPT 175B 的最佳性能

WebGPT 的最佳 $n$ 性能,阴影区域代表 $pm 1$ 标准误差,KL 轴遵循平方根刻度。这里,原始分布 ($P$) 由使用行为克隆训练的 175B 模型给出,用于计算 best-of-$n$ ($R_{text{proxy}}$) 的代理目标由训练给出奖励模型,我们考虑三个假定的“真实”目标($R_{text{true}}$):训练奖励模型本身、根据保留数据训练的验证奖励模型以及实际的人类偏好。代理目标没有太多过度优化,但我们预计 KL 会更高。

超越 $n$ 中的最佳采样

best-of-$n$ 采样的主要限制是 KL 散度随 $n$ 对数增长,因此仅适合应用少量优化。

为了应用更多优化,我们通常使用强化学习。在我们到目前为止研究的设置中,例如 总结,我们通常能够达到 10 左右的 KL NATS 由于古德哈特定律,在真实目标开始减少之前使用强化学习。我们必须花费 $n$ 大约 60,000 才能使用 最好的$n$, 我们希望通过改进我们的奖励模型和强化学习实践,能够达到比这更大的 KL。

然而,并非所有国家都是平等的。根据经验,对于较小的 KL 预算,best-of$n$ 比强化学习更好地优化代理目标和真实目标。直观上,best-of-$n$ 是“蛮力”方法,使其在信息理论上比强化学习更高效,但在大型 KL 上计算效率较低。

作为我们工作的一部分,我们正在积极研究代理目标的扩展属性 对齐 我们的模型具有人类意图和价值观。如果您想帮助我们进行这项研究,我们将 招聘背景:教育初创公司,需要第三方平台协助招聘!