亚马逊SageMaker 提供了一套 内置算法, 预训练模型及 预建的解决方案模板 帮助数据科学家和机器学习 (ML) 从业者快速开始训练和部署 ML 模型。 您可以将这些算法和模型用于有监督和无监督学习。 它们可以处理各种类型的输入数据,包括表格、图像和文本。

从今天开始,SageMaker 提供了四种新的内置表格数据建模算法:LightGBM、CatBoost、AutoGluon-Tabular 和 TabTransformer。 您可以将这些流行的、最先进的算法用于表格分类和回归任务。 它们可通过 内置算法 在 SageMaker 控制台上以及通过 亚马逊SageMaker JumpStart 内部用户界面 亚马逊SageMaker Studio.

以下是四种新的内置算法的列表,以及指向它们的文档、示例笔记本和源代码的链接。

| 配套文档 | 示例笔记本 | 来源 |

| LightGBM 算法 | 数据复原测试, 分类 | 轻型GBM |

| CatBoost 算法 | 数据复原测试, 分类 | 猫助推器 |

| AutoGluon-Tabular 算法 | 数据复原测试, 分类 | AutoGluon-表格 |

| TabTransformer 算法 | 数据复原测试, 分类 | 标签转换器 |

在以下部分中,我们提供了每种算法的简要技术说明,以及如何通过 SageMaker SDK 或 SageMaker Jumpstart 训练模型的示例。

轻型GBM

轻型GBM 是梯度提升决策树 (GBDT) 算法的流行且高效的开源实现。 GBDT 是一种监督学习算法,它试图通过组合来自一组更简单和更弱模型的估计值来准确预测目标变量。 LightGBM 使用额外的技术来显着提高传统 GBDT 的效率和可扩展性。

猫助推器

猫助推器 是 GBDT 算法的流行且高性能的开源实现。 CatBoost 中引入了两个关键的算法进步:有序提升的实现、经典算法的置换驱动替代方案以及用于处理分类特征的创新算法。 这两种技术都是为了对抗由目前所有现有的梯度提升算法实现中存在的一种特殊目标泄漏引起的预测偏移。

AutoGluon-表格

AutoGluon-表格 是由 Amazon 开发和维护的开源 AutoML 项目,它执行高级数据处理、深度学习和多层堆栈集成。 它会自动识别每列中的数据类型,以进行稳健的数据预处理,包括对文本字段的特殊处理。 AutoGluon 适合各种模型,从现成的增强树到定制的神经网络模型。 这些模型以一种新颖的方式集成:模型堆叠在多个层中,并以分层方式进行训练,以保证原始数据可以在给定的时间限制内转化为高质量的预测。 在整个过程中,通过仔细跟踪非折叠示例以各种方式拆分数据,可以缓解过度拟合。 AutoGluon 针对性能进行了优化,其开箱即用的使用在数据科学竞赛中获得了多个前 3 和前 10 的位置。

标签转换器

标签转换器 是一种用于监督学习的新型深度表格数据建模架构。 TabTransformer 建立在基于自注意力的 Transformer 之上。 Transformer 层将分类特征的嵌入转换为鲁棒的上下文嵌入,以实现更高的预测精度。 此外,从 TabTransformer 学习的上下文嵌入对于缺失和嘈杂的数据特征都具有高度鲁棒性,并提供更好的可解释性。 该模型是最近的产品 亚马逊科学 研究(纸 和官方 博客文章 这里)并已被 ML 社区广泛采用,并具有各种第三方实现(Keras, 自动胶,) 和社交媒体功能,例如 鸣叫, 走向数据科学, 中, 和 Kaggle.

SageMaker 内置算法的优势

在为特定类型的问题和数据选择算法时,使用 SageMaker 内置算法是最简单的选择,因为这样做有以下主要好处:

- 内置算法无需编码即可开始运行实验。 您需要提供的唯一输入是数据、超参数和计算资源。 这使您可以更快地运行实验,并减少跟踪结果和代码更改的开销。

- 内置算法具有跨多个计算实例的并行化,并且 GPU 支持所有适用算法开箱即用(由于固有限制,某些算法可能不包括在内)。 如果您有大量数据可用于训练模型,大多数内置算法都可以轻松扩展以满足需求。 即使您已经有一个预训练的模型,在 SageMaker 中使用它的推论并输入您已经知道的超参数可能仍然更容易,而不是移植它并自己编写训练脚本。

- 您是生成的模型工件的所有者。 您可以采用该模型并将其部署在 SageMaker 上,以获得多种不同的推理模式(查看所有 可用的部署类型) 和简单的端点扩展和管理,或者您可以将它部署在您需要的任何地方。

现在让我们看看如何训练这些内置算法之一。

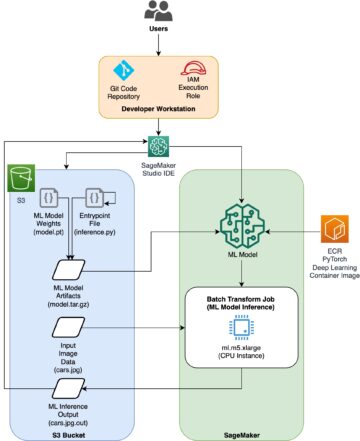

使用 SageMaker SDK 训练内置算法

要训练选定的模型,我们需要获取该模型的 URI,以及用于训练的训练脚本和容器映像的 URI。 值得庆幸的是,这三个输入仅取决于模型名称、版本(有关可用模型的列表,请参阅 JumpStart 可用型号表),以及您要训练的实例类型。 下面的代码片段演示了这一点:

train_model_id 改变为 lightgbm-regression-model 如果我们正在处理回归问题。 本文介绍的所有其他模型的 ID 列在下表中。

| 型号 | 问题类型 | 型号ID |

| 轻型GBM | 分类 | lightgbm-classification-model |

| . | 数据复原测试 | lightgbm-regression-model |

| 猫助推器 | 分类 | catboost-classification-model |

| . | 数据复原测试 | catboost-regression-model |

| AutoGluon-表格 | 分类 | autogluon-classification-ensemble |

| . | 数据复原测试 | autogluon-regression-ensemble |

| 标签转换器 | 分类 | pytorch-tabtransformerclassification-model |

| . | 数据复原测试 | pytorch-tabtransformerregression-model |

然后我们定义我们的输入在哪里 亚马逊简单存储服务 (亚马逊 S3)。 我们在此示例中使用公共示例数据集。 我们还定义了我们希望输出的位置,并检索训练所选模型所需的默认超参数列表。 您可以根据自己的喜好更改它们的值。

最后,我们实例化一个 SageMaker Estimator 使用所有检索到的输入并启动训练作业 .fit,将我们的训练数据集 URI 传递给它。 这 entry_point 提供的脚本被命名 transfer_learning.py (其他任务和算法相同),输入数据通道传递给 .fit 必须命名 training.

请注意,您可以使用以下方法训练内置算法 SageMaker自动模型调整 选择最佳超参数并进一步提高模型性能。

使用 SageMaker JumpStart 训练内置算法

您还可以通过 SageMaker JumpStart UI 只需单击几下即可训练任何这些内置算法。 JumpStart 是 SageMaker 的一项功能,可让您通过图形界面从各种 ML 框架和模型中心训练和部署内置算法和预训练模型。 它还允许您部署成熟的 ML 解决方案,将 ML 模型和各种其他 AWS 服务串联在一起,以解决目标用例。

有关更多信息,请参阅 使用 TensorFlow Hub 和 Hugging Face 模型通过 Amazon SageMaker JumpStart 运行文本分类.

结论

在这篇文章中,我们宣布在 SageMaker 上提供的表格数据集上推出四种强大的新内置 ML 算法。 我们提供了这些算法的技术描述,以及使用 SageMaker SDK 的 LightGBM 训练作业示例。

带上您自己的数据集并在 SageMaker 上尝试这些新算法,并查看示例笔记本以使用可用的内置算法 GitHub上.

作者简介

黄鑫博士 是 Amazon SageMaker JumpStart 和 Amazon SageMaker 内置算法的应用科学家。 他专注于开发可扩展的机器学习算法。 他的研究兴趣是自然语言处理、表格数据的可解释深度学习以及非参数时空聚类的稳健分析。 他在 ACL、ICDM、KDD 会议和皇家统计学会:A 系列期刊上发表了多篇论文。

黄鑫博士 是 Amazon SageMaker JumpStart 和 Amazon SageMaker 内置算法的应用科学家。 他专注于开发可扩展的机器学习算法。 他的研究兴趣是自然语言处理、表格数据的可解释深度学习以及非参数时空聚类的稳健分析。 他在 ACL、ICDM、KDD 会议和皇家统计学会:A 系列期刊上发表了多篇论文。

Ashish Khetan 博士 是 Amazon SageMaker JumpStart 和 Amazon SageMaker 内置算法的高级应用科学家,帮助开发机器学习算法。 他是机器学习和统计推断领域的活跃研究员,在 NeurIPS、ICML、ICLR、JMLR、ACL 和 EMNLP 会议上发表了多篇论文。

Ashish Khetan 博士 是 Amazon SageMaker JumpStart 和 Amazon SageMaker 内置算法的高级应用科学家,帮助开发机器学习算法。 他是机器学习和统计推断领域的活跃研究员,在 NeurIPS、ICML、ICLR、JMLR、ACL 和 EMNLP 会议上发表了多篇论文。

若昂·莫拉 是 Amazon Web Services 的 AI/ML 专家解决方案架构师。 他主要专注于 NLP 用例并帮助客户优化深度学习模型训练和部署。 他还是低代码 ML 解决方案和 ML 专用硬件的积极支持者。

若昂·莫拉 是 Amazon Web Services 的 AI/ML 专家解决方案架构师。 他主要专注于 NLP 用例并帮助客户优化深度学习模型训练和部署。 他还是低代码 ML 解决方案和 ML 专用硬件的积极支持者。

- "

- 100

- a

- 实现

- 横过

- 要积极。

- 额外

- 高级

- 进步

- 驳

- 算法

- 算法

- 算法

- 所有类型

- 允许

- 已经

- 替代

- Amazon

- 亚马逊网络服务

- 分析

- 公布

- 相应

- 应用的

- 架构

- 国家 / 地区

- 自动表

- 自动

- 可使用

- AWS

- 因为

- 好处

- 更好

- 提振

- 提高

- 盒子

- 内建的

- 小心

- 案件

- 造成

- 更改

- 经典

- 分类

- 码

- 编码

- 柱

- 如何

- 社体的一部分

- 比赛

- 计算

- 会议

- 安慰

- 容器

- 创建信息图

- 创建

- 危急

- 目前

- 习俗

- 合作伙伴

- data

- 数据处理

- 数据科学

- 处理

- 决定

- 深

- 需求

- 证明

- 部署

- 部署

- 部署

- 描述

- 开发

- 发达

- 发展

- 不同

- 码头工人

- 每

- 容易

- 效率

- 高效

- 端点

- 估计

- 例子

- 例子

- 现有

- 面部彩妆

- 专栏

- 特征

- 字段

- 重点

- 重点

- 以下

- 框架

- 止

- 进一步

- 此外

- GPU

- 处理

- 硬件

- 高度

- 帮助

- 帮助

- 帮助

- 此处

- 高品质

- 更高

- 高度

- 创新中心

- How To

- HTTPS

- 中心

- 图片

- 履行

- 改善

- 包括

- 包含

- 信息

- 固有

- 创新

- 输入

- 例

- 利益

- 接口

- IT

- 工作

- 日志

- 知道

- 语言

- 发射

- 知道

- 学习

- 链接

- 清单

- 已发布

- 机

- 机器学习

- 主要

- 颠覆性技术

- 方式

- 媒体

- 中等

- ML

- 模型

- 模型

- 更多

- 最先进的

- 多

- 自然

- 网络

- 优化

- 优化

- 附加选项

- 其他名称

- 己

- 业主

- 特别

- 通过

- 性能

- 热门

- 强大

- 预测

- 预测

- 预测

- 当下

- 市场问题

- 过程

- 处理

- 产品

- 项目

- 提供

- 提供

- 提供

- 国家

- 出版

- 很快

- 范围

- 原

- 认识

- 地区

- 要求

- 研究

- 资源

- 导致

- 成果

- 运行

- 运行

- 同

- 可扩展性

- 可扩展性

- 鳞片

- 缩放

- 科学

- 科学家

- 科学家

- SDK

- 选

- 系列

- A系列

- 特色服务

- 集

- 几个

- 转移

- 简易

- So

- 社会

- 社会化媒体

- 社会

- 方案,

- 解决方案

- 解决

- 一些

- 特别

- 专家

- 堆

- 开始

- 开始

- 国家的最先进的

- 统计

- 仍

- 存储

- SUPPORT

- 目标

- 针对

- 任务

- 文案

- 技术

- 第三方

- 三

- 通过

- 始终

- 次

- 今晚

- 一起

- 跟踪

- 培训

- 产品培训

- 改造

- 类型

- ui

- 独特

- 使用

- 用例

- 折扣值

- 各个

- 版本

- 方法

- 卷筒纸

- Web服务

- 什么是

- 中

- 您一站式解决方案