نماذج اللغات الكبيرة (LLMs) هي برامج كمبيوتر تم تدريبها على كميات هائلة من البيانات النصية. يتيح لهم ذلك إنشاء نص وترجمة اللغات وكتابة أنواع مختلفة من المحتوى الإبداعي والإجابة على أسئلتك بطريقة مفيدة.

ومع ذلك، LLMs لديها قيود: يمكنهم فقط التعامل مع كمية محددة من المعلومات في المرة الواحدة. يشبه هذا إجراء محادثة مع شخص لا يمكنه تذكر سوى الجمل القليلة الأخيرة التي قلتها.

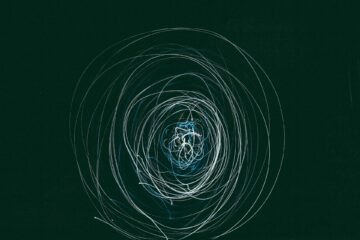

طور باحثو جوجل تقنية جديدة تسمى الاهتمام اللانهائي يسمح لـ LLMs بالاحتفاظ واستخدام المزيد من المعلومات أثناء المحادثة. وهذا يعني أنه يمكنك توفير المزيد من السياق لأسئلتك والحصول على إجابات أكثر شمولاً. تخيل أنك تطلب من LLM تلخيص حدث تاريخي معقد، أو كتابة قصة خيالية تعتمد على قصة درامية مفصلة تقدمها. مع الاهتمام اللامتناهي، تصبح هذه الأنواع من التفاعلات ممكنة.

كيف يعمل Infini-attention؟

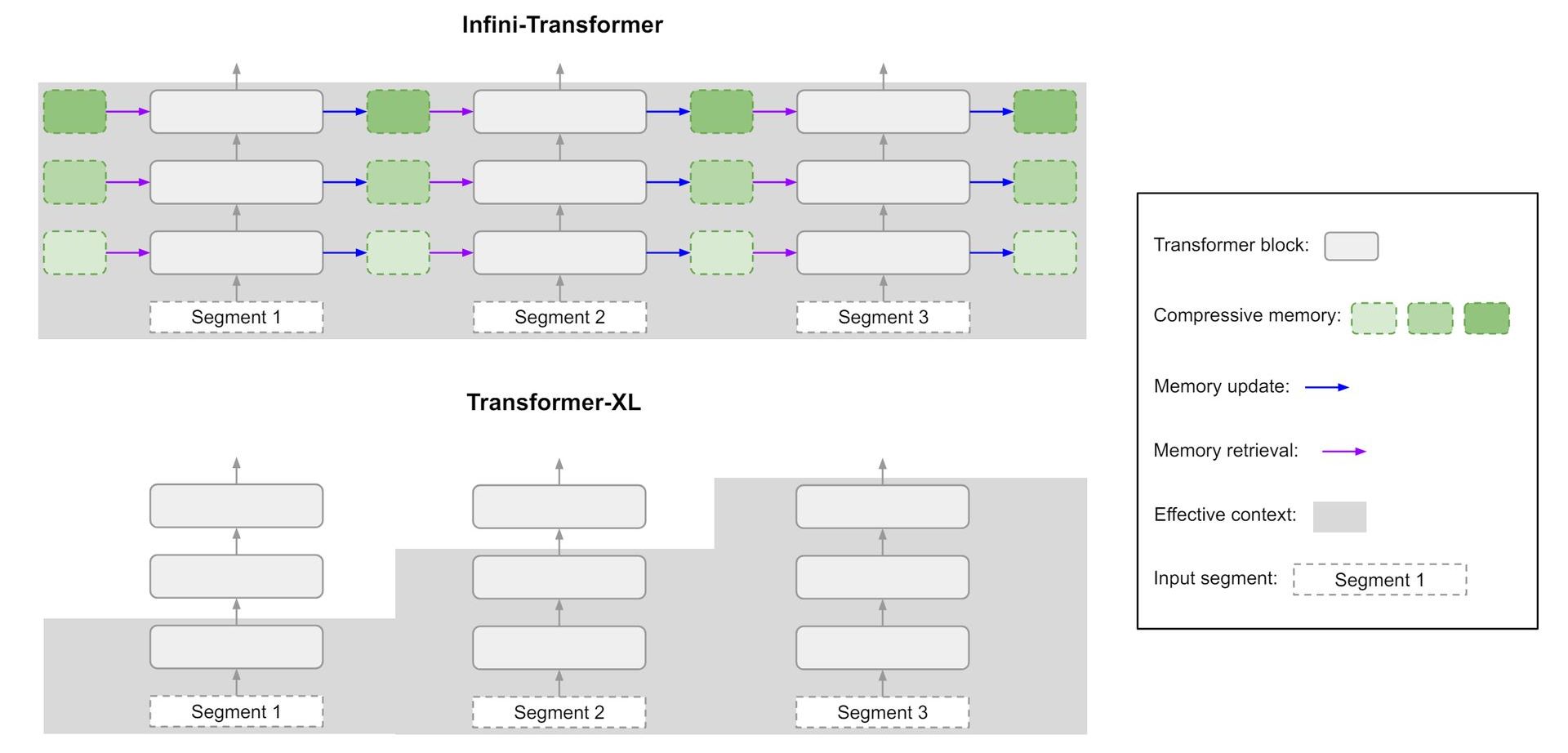

تقوم برامج LLM التقليدية بمعالجة المعلومات في أجزاء ذات حجم ثابت، مع التركيز على الجزء الحالي وتجاهل الأجزاء القديمة أو ضغطها. يعيق هذا النهج قدرتهم على التقاط التبعيات طويلة المدى والاحتفاظ بالمعلومات السياقية المهمة للمهام التي تتطلب فهمًا أوسع.

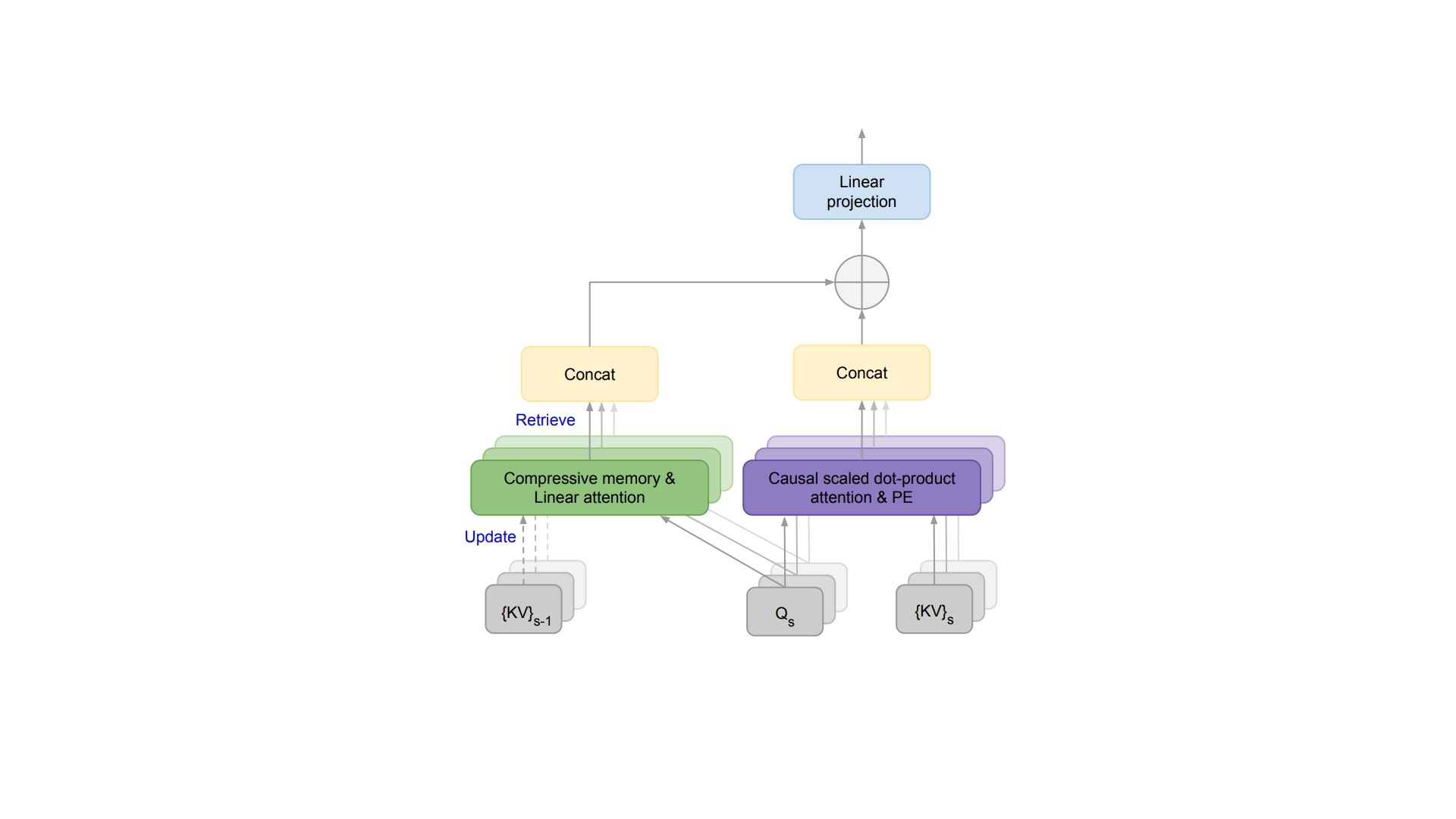

يعالج Infini-attention هذا القيد من خلال تمكين LLMs من الاستخدام الفعال للمعلومات من التفاعلات السابقة. ويحقق ذلك من خلال مجموعة من آليات الاهتمام الموجودة وتقنيات إدارة الذاكرة الفعالة.

وفيما يلي تفصيل لوظائفها الأساسية:

التقطيع والاهتمام

على غرار دورات LLM التقليدية، يقوم برنامج Infini-attention أولاً بتقسيم تسلسل الإدخال إلى أجزاء أصغر. أثناء المعالجة، يستخدم النموذج آلية انتباه لتحديد الأجزاء الأكثر صلة داخل كل قطعة للمهمة الحالية. تقوم آلية الانتباه هذه بتعيين أوزان لعناصر مختلفة داخل القطعة، مما يشير إلى أهميتها للسياق الحالي.

خلق الذاكرة

على عكس النماذج التقليدية التي تتجاهل الأجزاء السابقة أو تضغطها بشكل كبير، يعمل Infini-attention على زيادة أوزان الانتباه لإنشاء تمثيل ذاكرة مضغوط. يعطي هذا التمثيل المضغوط الأولوية للمعلومات التي تعتبرها آلية الانتباه مهمة، ويلتقط جوهر القطعة المعالجة. في الأساس، فهو يستخرج ملخصًا بارزًا للمعلومات المعالجة.

تخزين الذاكرة

يتم بعد ذلك تخزين تمثيلات الذاكرة المضغوطة هذه في مساحة ذاكرة مخصصة داخل LLM. تم تصميم مساحة الذاكرة هذه للاسترجاع والاستخدام بكفاءة. على الرغم من عدم الكشف عن تفاصيل التنفيذ المحددة علنًا، فمن المحتمل أن تتضمن تقنيات مثل مخازن القيمة الأساسية أو الهياكل الهرمية التي تسهل الوصول الفعال على أساس الملاءمة.

التكامل السياقي

عند معالجة معلومات جديدة، لا يعتمد LLM فقط على الجزء الحالي. يمكنه الآن استرداد الذكريات المضغوطة ذات الصلة من مساحة التخزين المخصصة. تعمل عملية الاسترجاع هذه على زيادة أوزان الانتباه المرتبطة بالذكريات المضغوطة، مما يضمن توافق المعلومات المستردة مع السياق الحالي. من خلال دمج المعلومات من الجزء الحالي والسياقات السابقة ذات الصلة، يكتسب برنامج LLM فهمًا أكثر شمولاً لتسلسل المدخلات الإجمالي.

لذلك، فإن Infini-attention يزود LLMs بالقدرة على النظر في نطاق أوسع من المعلومات أثناء التفاعلات. يمكن أن يؤدي هذا الوعي السياقي المعزز إلى العديد من الفوائد المحتملة:

- من خلال دمج مجموعة واسعة من المعلومات ذات الصلة، يمكن لـ LLMs إنشاء استجابات أكثر دقة وغنية بالمعلومات إلى الاستعلامات المعقدة.

- يسمح الاهتمام اللانهائي LLMs لمتابعة الحجج المعقدة من خلال تذكر العناصر السابقة من التفاعل. وهذا يتيح لهم أداء المهام التي تتطلب التفكير المنطقي والاستدلال.

- مع الوصول إلى سياق أوسع، يمكن لـ LLMs إنشاء تنسيقات نصية أكثر إبداعًا وتماسكًا مثل النصوص أو القصائد أو رسائل البريد الإلكتروني المصممة خصيصًا لحالة معينة.

أكبر ليست دائما أفضل

تخيل أنك تجري محادثة مع صديق. يبدأون بذكر فيلم شاهدوه للتو، ثم ينطلقون في شرح تفصيلي للوصفة الجديدة التي يحاولون تجربتها، قبل العودة إلى الفيلم لتحليل نقطة معينة في الحبكة. على الرغم من أن هذا قد يبدو وكأنه محادثة عادية، إلا أنه بالنسبة لروبوتات الدردشة المدعمة بالذكاء الاصطناعي، قد يكون بمثابة وصفة للارتباك.

تعمل التطورات الحديثة مثل Infini-attention من Google على تمكين روبوتات الدردشة من الاحتفاظ بمزيد من المعلومات واستخدامها أثناء التفاعلات. يبدو هذا رائعًا على الورق، فالمزيد من السياق يعني أن الذكاء الاصطناعي يمكنه فهمنا بشكل أفضل، أليس كذلك؟ حسنا، ليس بالضبط. تمامًا مثل ذلك الصديق الذي لا يستطيع البقاء في الموضوع، إن التحميل الزائد على الذكاء الاصطناعي بالسياق يمكن أن يكون له بعض العيوب المدهشة.

ما هي هلوسة الذكاء الاصطناعي بالضبط وما أهميتها؟

لنواجه الأمر، الحمل الزائد للمعلومات يمثل مشكلة حقيقيةوروبوتات الدردشة التي تعمل بالذكاء الاصطناعي ليست محصنة. إن إغراقهم في تفاصيل غير ذات صلة يمكن أن يجعل من الصعب عليهم تحديد النقاط الرئيسية وصياغة استجابة متماسكة. فكر في الأمر مثل محاولة العثور على وصفة محددة في كتاب طبخ مليء بقوائم البقالة ومراجعات المطاعم - وهو أمر غير فعال تمامًا.

هناك أيضا التكلفة الحسابية للنظر فيها. يتطلب تخزين ومعالجة قدر كبير من السياق جهدًا كبيرًا. قد يؤدي ذلك إلى إبطاء برنامج الدردشة الآلي وجعله أقل سهولة في الاستخدام. تخيل أنك تنتظر دقائق للرد لأن الذكاء الاصطناعي مشغول بتفكيك شبكة من المعلومات غير ذات الصلة. ليس بالضبط التفاعل السلس الذي نأمله.

إذن، أين المكان الجميل؟

والحقيقة هي أن حجم السياق المثالي يعتمد كليا على الوضع. بالنسبة للمهام المعقدة مثل الإجابة على الأسئلة أو الكتابة الإبداعية، يمكن أن يكون السياق الأوسع مفيدًا. ولكن بالنسبة للتفاعلات الأبسط، يمكن أن يكون الأمر مجرد فوضى.

والمفتاح هنا هو إيجاد التوازن، أي توفير سياق كافٍ للذكاء الاصطناعي لفهم الموقف، ولكن ليس بالقدر الذي قد يؤدي إلى ضياعه في الأعشاب الضارة. فكر في الأمر مثل إعداد المشهد لمسرحية - فأنت تريد تقديم تفاصيل كافية لتهيئة المسرح، ولكن دون إرباك الجمهور بخلفية درامية غير ضرورية.

مع استمرار تطور روبوتات الدردشة المدعمة بالذكاء الاصطناعي، سيكون فهم التوازن الدقيق بين السياق والوضوح أمرًا بالغ الأهمية. ومن خلال تحقيق التوازن الصحيح، يمكننا التأكد من أن رفاق الذكاء الاصطناعي هؤلاء ليسوا مجرد موسوعات متنقلة، بل أيضًا شركاء محادثة أذكياء وجذابين.

رصيد الصورة المميز: Freepik

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://dataconomy.com/2024/04/16/google-infini-attention-technique/

- :يكون

- :ليس

- 1

- 2%

- a

- القدرة

- الوصول

- دقيق

- يحقق

- عناوين

- التطورات

- AI

- يحاذي

- يسمح

- أيضا

- دائما

- كمية

- المبالغ

- an

- تحليل

- و

- إجابة

- الإجابة

- الأجوبة

- نهج

- هي

- الحجج

- يسأل

- أسوشيتد

- At

- اهتمام

- جمهور

- وعي

- الى الخلف

- الرصيد

- على أساس

- BE

- لان

- أصبح

- كان

- قبل

- الفوائد

- أفضل

- ما بين

- على حد سواء

- انهيار

- كسر

- أوسع

- يبني

- مشغول

- لكن

- by

- تسمى

- CAN

- أسر

- يلتقط

- اسر

- chatbot

- chatbots

- وضوح

- فوضى

- متماسك

- مجموعة

- الصحابة

- مجمع

- شامل

- ضغط

- الكمبيوتر

- ارتباك

- نظر

- محتوى

- سياق الكلام

- السياقات

- قريني

- استمر

- تقليدي

- محادثة

- المحادثات

- جوهر

- التكلفة

- خلق

- الإبداع

- حاسم

- حالياًّ

- رقص

- البيانات

- مخصصة

- تعتبر

- التبعيات

- تصميم

- مفصلة

- تفاصيل

- المتقدمة

- مختلف

- صعبة

- الانقسامات

- هل

- لا

- إلى أسفل

- أثناء

- كل

- على نحو فعال

- فعال

- بكفاءة

- عناصر

- رسائل البريد الإلكتروني

- توظيف

- توظف

- تمكن

- تمكين

- جذاب

- تعزيز

- كاف

- ضمان

- ضمان

- تماما

- جوهر

- أساسيا

- الحدث/الفعالية

- يتطور

- بالضبط

- القائمة

- تفسير

- مقتطفات

- الوجه

- تسهيل

- قليل

- خيالي

- معبأ

- العثور على

- الاسم الأول

- التركيز

- اتباع

- في حالة

- صديق

- تبدأ من

- وظائف

- مستقبل

- الرأس مالية

- توليد

- دولار فقط واحصل على خصم XNUMX% على جميع

- يحصل

- شراء مراجعات جوجل

- جوجل

- عظيم

- بقالة

- مقبض

- يملك

- وجود

- بشكل كبير

- مفيد

- مرتفع

- المعوقات

- تاريخي

- عقد

- أمل

- HTTPS

- المثالي

- تحديد

- صورة

- تخيل

- المناعي

- التنفيذ

- أهمية

- يحسن

- in

- دمج

- مبينا

- معلومات

- بالمعلومات

- إدخال

- دمج

- تفاعل

- التفاعلات

- إلى

- تنطوي

- IT

- انها

- JPG

- م

- القفل

- أنواع

- لغة

- اللغات

- اسم العائلة

- إطلاق

- قيادة

- أقل

- روافع

- مثل

- على الأرجح

- تحديد

- قوائم

- ماجستير في القانون

- منطقي

- ضائع

- جعل

- التحكم

- إدارة

- هائل

- أمر

- ماكس العرض

- يعني

- آلية

- آليات

- ذكريات

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- ذكر

- ربما

- دقائق

- نموذج

- عارضات ازياء

- الأكثر من ذلك

- أكثر

- فيلم

- كثيرا

- عضلة

- جديد

- عادي

- الآن

- of

- أقدم

- on

- منها

- فقط

- على

- or

- الكلي

- ورق

- أجزاء

- الماضي

- نفذ

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- بلايستشن

- مؤامرة

- البوينت

- نقاط

- ممكن

- محتمل

- سابق

- تعطي الأولوية لل

- عملية المعالجة

- معالجة

- معالجة

- البرامج

- تزود

- توفير

- علانية

- الاستفسارات

- سؤال

- الأسئلة المتكررة

- نطاق

- حقيقي

- منطق

- وصفة

- مدى صلة

- ذات الصلة

- اعتمد

- تذكر

- تذكر

- التمثيل

- التوكيلات

- يتطلب

- الباحثين

- استجابة

- مطعم

- احتفظ

- استرجاع

- التعليقات

- حق

- قال

- رأى

- مشهد

- مخطوطات

- سلس

- شرائح

- تسلسل

- جدي

- طقم

- ضبط

- عدة

- أهمية

- بساطة

- حالة

- المقاس

- بطيء

- الأصغر

- So

- فقط

- بعض

- شخص ما

- متطور

- الأصوات

- الفضاء

- محدد

- بقعة

- المسرح

- بداية

- إقامة

- تخزين

- تخزين

- فروعنا

- تخزين

- قصتنا

- الهياكل

- تلخيص

- ملخص

- مفاجئ

- حلو

- تناسب

- مهمة

- المهام

- تقنية

- تقنيات

- نص

- أن

- •

- من مشاركة

- منهم

- then

- تشبه

- هم

- اعتقد

- عبر

- الوقت

- إلى

- موضوع

- تقليدي

- متدرب

- ترجمه

- حقيقة

- يحاول

- فهم

- فهم

- غير ضروري

- تكشف عن

- بناء على

- us

- تستخدم

- سهل الاستعمال

- استخدام

- الاستفادة من

- كبير

- انتظار

- المشي

- تريد

- طريق..

- we

- الويب

- حسن

- التي

- في حين

- من الذى

- لماذا

- على نطاق أوسع

- سوف

- مع

- في غضون

- للعمل

- اكتب

- جاري الكتابة

- لصحتك!

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت