Google har været frontløber inden for AI-forskning og har bidraget væsentligt til open source-fællesskabet med transformative teknologier som f.eks. TensorFlow, BERTI, T5, JAX, AlphaFold og AlphaCode. I forlængelse af denne arv har Google introduceret Gemma, en LLM bygget til ansvarlig AI-udvikling, der udnytter den samme forskning og teknologi, som drev Gini-modellerne.

Indholdsfortegnelse

Hvad er Gemma LLM?

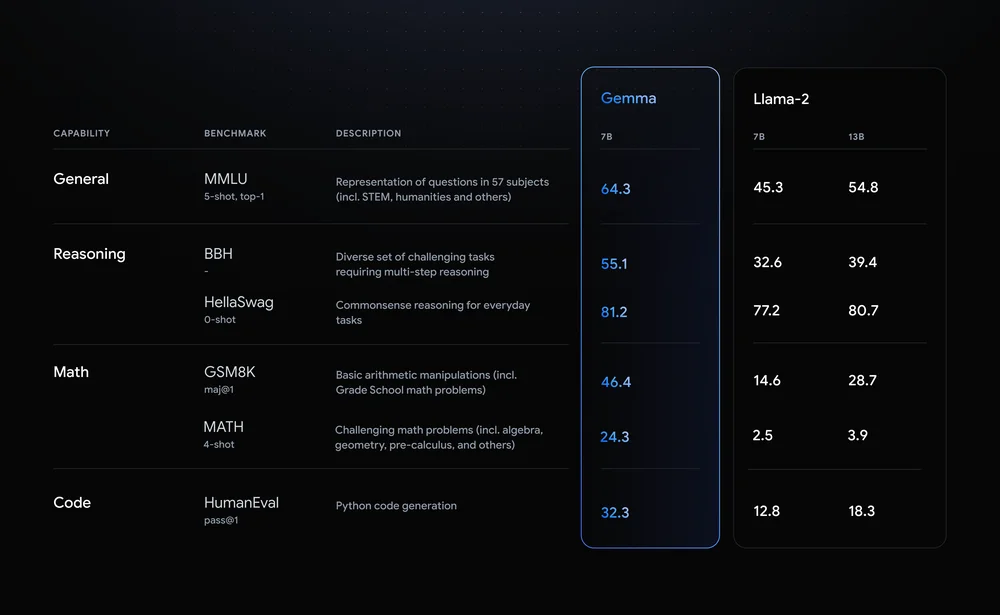

Gemma skiller sig ud med sine imponerende præstationsmålinger. Den kommer i to varianter: en med 7 milliarder parametre og en anden med 2 milliarder. Sammenlignet med Metas LLM, Llama 2, viser Gemma overlegen nøjagtighed på tværs af forskellige benchmarks. For eksempel kan Gemmas 7 milliarder parametermodel prale af en generel nøjagtighed på 64.3 %, hvilket overgår Lama 2 i ræsonnement, matematik og andre kategorier.

Lad os se på nogle af funktionerne i Gemma LLM:

- Letvægtsarkitektur: Gemma kommer i to størrelser, 2B og 7B parametre, betydeligt mindre end sine større fætre. Dette oversættes til hurtigere inferenshastigheder og lavere beregningskrav, hvilket gør den ideel til personlige computere og endda mobile enheder.

- Open Source tilgængelighed: I modsætning til mange højtydende LLM'er er Gemmas kode og parametre frit tilgængelige, hvilket styrker udviklere og forskere til at eksperimentere, tilpasse og bidrage til dens udvikling.

- Instruktionstunede varianter: Ud over fortrænede modeller tilbyder Gemma "instruktionstunede" versioner, der er optimeret til specifikke opgaver som svar på spørgsmål og opsummering. Det her forbedrer ydeevne og tilpasningsevne til applikationer i den virkelige verden.

Gemmas indflydelse går ud over tekniske specifikationer. Det demokratiserer adgangen til avancerede LLM'er, fremmer innovation og samarbejde inden for AI-fællesskabet. Dens potentielle anvendelser spænder over forskellige områder, fra personlige produktivitetsværktøjer og chatbots til kodegenerering og videnskabelig forskning. Ved at sænke adgangsbarrierer holder Gemma løftet om at accelerere fremskridt inden for naturlig sprogbehandling og forme fremtiden for kunstig intelligens.

Dyk dybt ind i Gemma-varianter

Gemma, Googles open source LLM-familie, tilbyder et alsidigt udvalg af modeller, der dækker forskellige behov. Lad os dykke ned i de forskellige størrelser og versioner, udforske deres styrker, use cases og tekniske detaljer for udviklere:

Størrelse betyder noget: Vælg din Gemma

- 2B: Denne letvægtsmester udmærker sig i miljøer med begrænset ressourcer som CPU'er og mobile enheder. Dens hukommelsesfodaftryk på omkring 1.5 GB og hurtige inferenshastighed gør den ideel til opgaver som tekstklassificering og simpel besvarelse af spørgsmål.

- 7B: Med en balance mellem kraft og effektivitet skinner 7B-varianten på GPU'er og TPU'er i forbrugerkvalitet. Dens 5 GB hukommelseskrav låser op for mere komplekse opgaver som opsummering og kodegenerering.

Tuning af motoren: Base vs. Instruktion-tunet

- Base: Frisk ude af træningsprocessen tilbyder disse modeller et generelt grundlag for forskellige applikationer. De kræver finjustering til specifikke opgaver, men giver fleksibilitet til tilpasning.

- Instruktionsjusteret: Foruddannet i specifikke instruktioner som "opsummere" eller "oversætte", giver disse varianter brugbarhed klar til målrettede opgaver. De ofrer en vis generaliserbarhed for forbedret ydeevne i deres udpegede domæne.

Tekniske godbidder til udviklere

- Hukommelsesaftryk: 2B-modeller kræver omkring 1.5 GB, mens 7B-modeller kræver cirka 5 GB hukommelse. Finjustering kan øge dette fodaftryk en smule.

- Inferenshastighed: 2B-modeller udmærker sig i hastighed, hvilket gør dem velegnede til realtidsapplikationer. 7B-modeller tilbyder hurtigere inferens sammenlignet med større LLM'er, men matcher muligvis ikke hastigheden af deres mindre søskende.

- Rammekompatibilitet: Begge størrelser er kompatible med store rammer som TensorFlow, PyTorch og JAX, hvilket giver udviklere mulighed for at udnytte deres foretrukne miljø.

Matcher den rigtige gemma til dine behov

Valget mellem størrelse og tuning afhænger af dine specifikke krav. Til ressourcebegrænsede scenarier og simple opgaver er 2B-basismodellen et godt udgangspunkt. Hvis du prioriterer ydeevne og kompleksitet i specifikke domæner, kan den 7B instruktionstunede variant blive din mester. Husk, finjustering af begge størrelser giver mulighed for yderligere tilpasning til din unikke brugssag.

Husk: Dette er blot et glimt af Gemma-varianterne. Med sine forskellige muligheder og open source-natur giver Gemma udviklere mulighed for at udforske og frigøre sit potentiale for forskellige applikationer.

Kom godt i gang med Gemma

Gemma, Googles imponerende familie af open source store sprogmodeller (LLM'er), åbner døre for udviklere og forskere til at udforske potentialet i AI lige ved hånden. Lad os dykke ned i, hvordan du kan installer og kør Gemma, få adgang til fortrænede modellerog bygge dine egne applikationer ved at bruge dets forskellige muligheder.

Platform Agnostic: Gemma på CPU, GPU eller TPU

Gemma kan prale af platformsfleksibilitet, så du kan køre den på forskellige hardwarekonfigurationer. Til CPU-baserede opsætninger, Hugging Face Transformers-biblioteket og Googles Tensorflow Lite-fortolker tilbyder effektive muligheder. Hvis du har adgang til GPU'er eller TPU'er, udnytte TensorFlows fulde kraft til accelereret ydeevne. Til cloud-baserede implementeringer skal du overveje Google Cloud Vertex AI for problemfri integration og skalerbarhed.

Få adgang til klar-til-brug modeller

Gemmas fortrænede modeller kommer i forskellige størrelser og funktioner, der imødekommer forskellige behov. Til tekstgenerering, oversættelse og besvarelse af spørgsmål tilbyder Gemma 2B- og 7B-varianter en imponerende ydeevne. Derudover er instruktionstunede modeller som Gemma 2B-FT og 7B-FT specielt designet til at finjustere dine egne datasæt og låse op for yderligere personalisering.

Udforsk Gemmas muligheder

Lad os udforske nogle spændende applikationer, du kan bygge med Gemma:

- Fængslende historiefortælling: Generer realistiske og engagerende fortællinger ved hjælp af tekstgenereringsfunktioner.

- Sprogoversættelse gjort let: Oversæt tekst problemfrit mellem sprog med Gemmas flersprogede dygtighed.

- Afsløring af viden: Implementer spørgsmål-svar-modeller for at give informative og indsigtsfulde svar.

- Kreativt indholdsgenerering: Eksperimenter med poesi, manuskripter eller kodegenerering, så du flytter grænserne for kreativ AI.

Finjustering og tilpasning

Gemmas sande kraft ligger i dens finjusteringsmuligheder. Udnyt dine egne datasæt til at skræddersy modellen til dine specifikke behov og opnå uovertruffen ydeevne. De medfølgende referenceartikler tilbyder detaljerede instruktioner om finjustering og tilpasning, hvilket giver dig mulighed for at frigøre Gemmas fulde potentiale.

At komme i gang med Gemma er en spændende rejse. Med sin tilgængelige natur, forskellige muligheder og livlige fællesskabsstøtte åbner Gemma en verden af muligheder for både udviklere og forskere. Så dyk ned i en verden af open source LLM'er og frigør Gemmas kraft i dit næste AI-projekt!

Gemmas fremtid

Gemmas open source-karakter og imponerende ydeevne har udløst betydelig buzz i LLM-fællesskabet.

Men hvad ligger forude for denne spirende familie af modeller?

- Fremskridt i LLM-landskabet: Gemmas open source-natur fremmer samarbejde og innovation. Forskere og udviklere over hele verden kan bidrage til dens udvikling og fremskynde fremskridt inden for områder som fortolkning, retfærdighed og effektivitet. Vi ser måske Gemma stå i spidsen for udforskningen af multimodale LLM'er, der er i stand til at behandle og generere ikke kun tekst, men også billeder, lyd og video.

- Optimistisk udsigter: Med sin demokratiserende tilgang og imponerende evner repræsenterer Gemma et væsentligt skridt hen imod at gøre AI tilgængelig og gavnlig for alle. Efterhånden som udviklingen skrider frem, kan vi forvente endnu flere banebrydende applikationer og fremskridt. Gemmas open source-natur fremmer et levende fællesskab, der sikrer dets fortsatte udvikling og indflydelse på LLM'ers fremtid.

Konklusion

Gemmas ankomst til LLM-landskabet markerer et væsentligt vendepunkt. I modsætning til sine større, mere ressourcekrævende fætre tilbyder Gemma tilgængelighed og fleksibilitet, hvilket gør avancerede AI-funktioner tilgængelige for et bredere publikum. Dens open source-natur fremmer innovation og samarbejde, accelererer fremskridt inden for naturlig sprogbehandling og former fremtiden for AI.

Nøgleforsøg

- Letvægts og open source: Gemmas mindre størrelse og åbne tilgængelighed gør den tilgængelig på forskellige platforme, hvilket giver enkeltpersoner og mindre organisationer mulighed for at udforske AI's potentiale.

- Forskellige varianter og muligheder: Med flere størrelser og instruktionsjusterede muligheder imødekommer Gemma forskellige behov, fra grundlæggende spørgsmålssvar til kompleks indholdsgenerering.

- Frigørelse af potentiale gennem tilpasning: Finjusteringsmuligheder giver brugerne mulighed for at skræddersy Gemma til deres specifikke behov, hvilket åbner op for nye muligheder inden for forskellige områder.

- Et levende fællesskab og lys fremtid: Gemmas open source-natur fremmer et kollaborativt fællesskab, hvilket driver fremskridt inden for fortolkning, retfærdighed og multimodale muligheder.

Vigtige Links

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.analyticsvidhya.com/blog/2024/02/gemma-llm/

- :har

- :er

- :ikke

- 1

- 2%

- 7

- a

- Om

- fremskynde

- accelereret

- accelererende

- adgang

- tilgængelighed

- tilgængelig

- nøjagtighed

- opnå

- tværs

- Derudover

- fremskreden

- fremskridt

- forude

- AI

- ai forskning

- ens

- Alle

- tillade

- tillade

- tillader

- også

- an

- ,

- En anden

- besvarelse

- applikationer

- tilgang

- cirka

- arkitektur

- ER

- områder

- omkring

- ankomst

- artikler

- AS

- At

- publikum

- lyd

- tilgængelighed

- til rådighed

- Balance

- barrierer

- bund

- grundlæggende

- BE

- været

- Benchmarks

- gavnlig

- mellem

- Beyond

- Billion

- prale af

- både

- grænser

- Bright

- bygge

- bygget

- spirende

- men

- by

- CAN

- kapaciteter

- stand

- tilfælde

- tilfælde

- kategorier

- catering

- gearet

- champion

- chatbots

- valg

- vælge

- klassificering

- Cloud

- kode

- samarbejde

- kollaborativ

- Kom

- kommer

- samfund

- sammenlignet

- kompatibilitet

- kompatibel

- komplekse

- kompleksitet

- beregningsmæssige

- computere

- konfigurationer

- Overvej

- indhold

- fortsatte

- fortsættende

- bidrage

- bidrager

- kunne

- CPU

- Kreativ

- tilpasning

- tilpasse

- datasæt

- dyb

- dykke

- Efterspørgsel

- demokratiserer

- demokratisering

- afhænger

- implementeringer

- udpeget

- konstrueret

- detaljeret

- detaljer

- udviklere

- Udvikling

- Enheder

- forskellige

- dyk

- forskelligartede

- domæne

- Domæner

- døre

- kørsel

- let

- effektivitet

- effektiv

- enten

- bemyndigelse

- bemyndiger

- engagerende

- Engine (Motor)

- sikring

- indrejse

- Miljø

- miljøer

- Endog

- alle

- evolution

- Excel

- spændende

- forvente

- eksperiment

- udforskning

- udforske

- Udforskning

- Ansigtet

- fairness

- familie

- FAST

- hurtigere

- Funktionalitet

- Fields

- fingerspidser

- Fleksibilitet

- Fodspor

- Til

- fremme

- Fosters

- Foundation

- rammer

- frit

- frisk

- fra

- brændstoffer

- fuld

- yderligere

- fremtiden

- Fremtiden for AI

- Generelt

- generelle formål

- generere

- generere

- generation

- sådan her

- glimt

- Goes

- Google Cloud

- Googles

- GPU

- GPU'er

- stor

- banebrydende

- Hardware

- Have

- Høj

- Høj ydeevne

- besidder

- Hvordan

- HTTPS

- ideal

- if

- billeder

- KIMOs Succeshistorier

- gennemføre

- imponerende

- forbedret

- in

- Forøg

- enkeltpersoner

- informative

- Innovation

- indsigtsfuld

- instans

- anvisninger

- integration

- ind

- introduceret

- IT

- ITS

- rejse

- lige

- Kend

- viden

- landskab

- Sprog

- Sprog

- stor

- større

- Legacy

- Leverage

- løftestang

- Bibliotek

- ligger

- letvægt

- ligesom

- Llama

- llm

- Se

- lavere

- sænkning

- lavet

- Made Easy

- større

- lave

- maerker

- Making

- mange

- Match

- matematik

- Matters

- max-bredde

- Kan..

- Hukommelse

- Metrics

- måske

- Mobil

- mobilenheder

- model

- modeller

- mere

- flere

- fortællinger

- Natural

- Naturligt sprog

- Natural Language Processing

- Natur

- Behov

- behov

- Ny

- næste

- of

- tilbyde

- Tilbud

- on

- ONE

- kun

- åbent

- open source

- åbner

- optimeret

- Indstillinger

- or

- organisationer

- Andet

- ud

- Outlook

- at overgå

- egen

- parameter

- parametre

- ydeevne

- personale

- Personlige computere

- Personalisering

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- Poetry

- Punkt

- muligheder

- potentiale

- magt

- strøm

- kraftcenter

- foretrækkes

- Prioriter

- behandle

- forarbejdning

- produktivitet

- Produktivitetsværktøjer

- Progress

- løfte

- give

- forudsat

- dygtighed

- Pushing

- pytorch

- spørgsmål

- rækkevidde

- virkelige verden

- realtid

- realistisk

- ræsonnement

- henvisningen

- huske

- repræsenterer

- kræver

- krav

- Krav

- forskning

- forskere

- ressourceintensive

- reaktioner

- ansvarlige

- højre

- Kør

- ofre

- samme

- Skalerbarhed

- scenarier

- videnskabelig

- scripts

- sømløs

- problemfrit

- se

- Shape

- forme

- skinner

- Shows

- signifikant

- betydeligt

- Simpelt

- Størrelse

- størrelser

- anelse

- mindre

- So

- nogle

- span

- udløst

- spydspids

- specifikke

- specifikt

- specs

- hastighed

- hastigheder

- står

- påbegyndt

- Starter

- Trin

- historiefortælling

- styrker

- egnede

- overlegen

- support

- skrædder

- målrettet

- opgaver

- Teknisk

- Teknologier

- Teknologier

- tensorflow

- tekst

- Tekstklassificering

- tekstgenerering

- end

- at

- Fremtiden

- verdenen

- deres

- Them

- Disse

- de

- denne

- Gennem

- til

- værktøjer

- mod

- Kurser

- transformative

- transformers

- Oversætte

- Oversættelse

- sand

- tuning

- Drejning

- vendepunkt

- to

- enestående

- frigøre

- I modsætning til

- låse

- oplåsning

- låser op

- uden sidestykke

- usability

- brug

- brug tilfælde

- brugere

- ved brug af

- Variant

- varianter

- forskellige

- alsidige

- versioner

- levende

- video

- vs

- we

- Hvad

- hvornår

- mens

- bredere

- med

- inden for

- world

- verdensplan

- dig

- Din

- zephyrnet