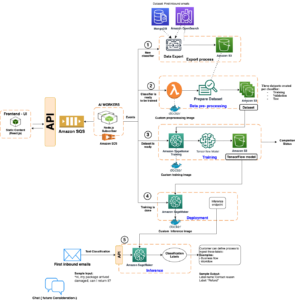

Wir freuen uns, heute bekannt geben zu können, dass das Sprachbasismodell GPT-NeoXT-Chat-Base-20B von Together Computer für Kunden verfügbar ist Amazon SageMaker-JumpStart. GPT-NeoXT-Chat-Base-20B ist ein Open-Source-Modell zum Erstellen von Konversations-Bots. Sie können dieses Modell ganz einfach ausprobieren und mit JumpStart verwenden. JumpStart ist das Zentrum für maschinelles Lernen (ML) von Amazon Sage Maker Das bietet zusätzlich zu integrierten Algorithmen und End-to-End-Lösungsvorlagen Zugriff auf Basismodelle, um Ihnen den schnellen Einstieg in ML zu erleichtern.

In diesem Beitrag erfahren Sie, wie Sie das bereitstellen GPT-NeoXT-Chat-Base-20B Modell und rufen Sie das Modell innerhalb eines auf OpenChatKit interaktive Shell. Diese Demonstration stellt einen Open-Source-Chatbot-Grundmodell zur Verwendung in Ihrer Anwendung bereit.

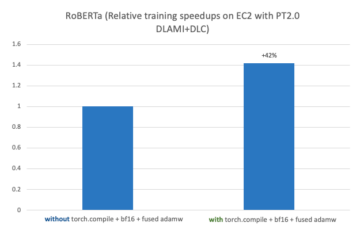

JumpStart-Modelle nutzen Deep Java Serving, das die Deep Java Library (DJL) mit Deep-Speed-Bibliotheken nutzt, um Modelle zu optimieren und die Latenz für Inferenzen zu minimieren. Die zugrunde liegende Implementierung in JumpStart folgt einer Implementierung, die der folgenden ähnelt Notizbuch. Als JumpStart Model Hub-Kunde erhalten Sie eine verbesserte Leistung, ohne das Modellskript außerhalb des SageMaker SDK verwalten zu müssen. JumpStart-Modelle erzielen außerdem eine verbesserte Sicherheitslage mit Endpunkten, die eine Netzwerkisolierung ermöglichen.

Foundation-Modelle in SageMaker

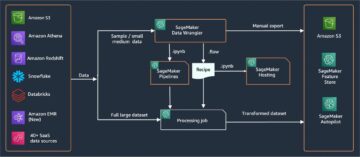

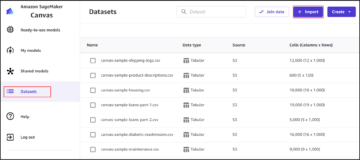

JumpStart bietet Zugriff auf eine Reihe von Modellen beliebter Modell-Hubs, darunter Hugging Face, PyTorch Hub und TensorFlow Hub, die Sie in Ihrem ML-Entwicklungsworkflow in SageMaker verwenden können. Die jüngsten Fortschritte im ML haben zu einer neuen Klasse von Modellen geführt, die als bekannt ist Gründungsmodelle, die in der Regel mit Milliarden von Parametern trainiert werden und an eine Vielzahl von Anwendungsfällen angepasst werden können, z. B. Textzusammenfassung, Generierung digitaler Kunst und Sprachübersetzung. Da das Trainieren dieser Modelle teuer ist, möchten Kunden vorhandene vortrainierte Basismodelle verwenden und sie nach Bedarf feinabstimmen, anstatt diese Modelle selbst zu trainieren. SageMaker bietet eine kuratierte Liste von Modellen, aus denen Sie in der SageMaker-Konsole auswählen können.

Sie können jetzt Foundation-Modelle von verschiedenen Modellanbietern innerhalb von JumpStart finden, sodass Sie schnell mit Foundation-Modellen beginnen können. Sie können Basismodelle basierend auf verschiedenen Aufgaben oder Modellanbietern finden und Modelleigenschaften und Nutzungsbedingungen einfach überprüfen. Sie können diese Modelle auch mit einem Test-UI-Widget ausprobieren. Wenn Sie ein grundlegendes Modell in großem Umfang verwenden möchten, können Sie dies ganz einfach tun, ohne SageMaker zu verlassen, indem Sie vorgefertigte Notebooks von Modellanbietern verwenden. Da die Modelle auf AWS gehostet und bereitgestellt werden, können Sie sicher sein, dass Ihre Daten, unabhängig davon, ob sie zur Bewertung oder zur Nutzung des Modells in großem Umfang verwendet werden, niemals an Dritte weitergegeben werden.

GPT-NeoXT-Chat-Base-20B-Grundlagenmodell

Zusammen Computer entwickelte GPT-NeoXT-Chat-Base-20B, ein Sprachmodell mit 20 Milliarden Parametern, das auf dem GPT-NeoX-Modell von ElutherAI mit über 40 Millionen Anweisungen verfeinert wurde und sich auf Interaktionen im Dialogstil konzentriert. Darüber hinaus ist das Modell auf verschiedene Aufgaben abgestimmt, beispielsweise auf die Beantwortung von Fragen, die Klassifizierung, die Extraktion und die Zusammenfassung. Das Modell basiert auf dem OIG-43M-Datensatz, der in Zusammenarbeit mit LAION und Ontocord erstellt wurde.

Zusätzlich zu der oben genannten Feinabstimmung wurde GPT-NeoXT-Chat-Base-20B-v0.16 anhand einer kleinen Menge an Feedback-Daten einer weiteren Feinabstimmung unterzogen. Dadurch kann sich das Modell besser an die menschlichen Vorlieben in den Gesprächen anpassen. GPT-NeoXT-Chat-Base-20B ist für die Verwendung in Chatbot-Anwendungen konzipiert und funktioniert möglicherweise nicht gut für andere Anwendungsfälle außerhalb des vorgesehenen Anwendungsbereichs. Ontocord und LAION haben gemeinsam OpenChatKit veröffentlicht, eine Open-Source-Alternative zu ChatGPT mit vergleichbaren Funktionen. OpenChatKit wurde unter einer Apache-2.0-Lizenz gestartet und gewährt vollständigen Zugriff auf den Quellcode, die Modellgewichte und die Trainingsdatensätze. Es gibt mehrere Aufgaben, bei denen OpenChatKit sofort einsatzbereit ist. Dazu gehören Zusammenfassungsaufgaben, Extraktionsaufgaben, die das Extrahieren strukturierter Informationen aus unstrukturierten Dokumenten ermöglichen, und Klassifizierungsaufgaben zur Klassifizierung eines Satzes oder Absatzes in verschiedene Kategorien.

Lassen Sie uns untersuchen, wie wir das GPT-NeoXT-Chat-Base-20B-Modell in JumpStart verwenden können.

Lösungsüberblick

Im Folgenden finden Sie den Code, der die Bereitstellung von GPT-NeoXT-Chat-Base-20B auf SageMaker zeigt, sowie ein Beispiel für die Verwendung des bereitgestellten Modells im Dialog mit der Befehlsshell GitHub-Notizbuch.

In den folgenden Abschnitten erweitern wir jeden Schritt im Detail, um das Modell bereitzustellen und es dann zur Lösung verschiedener Aufgaben zu verwenden:

- Voraussetzungen einrichten.

- Wählen Sie ein vorab trainiertes Modell aus.

- Rufen Sie Artefakte ab und stellen Sie einen Endpunkt bereit.

- Fragen Sie den Endpunkt ab und analysieren Sie eine Antwort.

- Verwenden Sie eine OpenChatKit-Shell, um mit Ihrem bereitgestellten Endpunkt zu interagieren.

Voraussetzungen einrichten

Dieses Notebook wurde auf einer ml.t3.medium-Instanz getestet Amazon SageMaker-Studio mit dem Python 3 (Data Science)-Kernel und in einer SageMaker Notebook-Instanz mit dem conda_python3-Kernel.

Bevor Sie das Notebook ausführen, führen Sie mit dem folgenden Befehl einige erste Schritte aus, die für die Einrichtung erforderlich sind:

Wählen Sie ein vorab trainiertes Modell aus

Wir richten wie gewohnt eine SageMaker-Sitzung mit Boto3 ein und wählen dann die Modell-ID aus, die wir bereitstellen möchten:

Rufen Sie Artefakte ab und stellen Sie einen Endpunkt bereit

Mit SageMaker können wir Rückschlüsse auf das vorab trainierte Modell ziehen, auch ohne es zuerst an einem neuen Datensatz zu optimieren. Wir beginnen mit dem Abrufen der instance_type, image_uri und model_uri für das vorab trainierte Modell. Um das vorab trainierte Modell zu hosten, erstellen wir eine Instanz von sagemaker.model.Model und stellen Sie es bereit. Der folgende Code verwendet ml.g5.24xlarge für den Inferenzendpunkt. Die Bereitstellungsmethode kann einige Minuten dauern.

Fragen Sie den Endpunkt ab und analysieren Sie die Antwort

Als Nächstes zeigen wir Ihnen ein Beispiel, wie Sie einen Endpunkt mit einer Teilmenge der Hyperparameter aufrufen:

Folgendes ist die Antwort, die wir erhalten:

Hier haben wir das Payload-Argument bereitgestellt "stopping_criteria": ["<human>"], was dazu geführt hat, dass die Modellantwort mit der Generierung der Wortsequenz endet <human>. Das JumpStart-Modellskript akzeptiert jede Liste von Zeichenfolgen als gewünschte Stoppwörter und wandelt diese Liste in ein gültiges um Schlüsselwortargument „stoping_criteria“. an die Transformer-Generierungs-API und stoppt die Textgenerierung, wenn die Ausgabesequenz angegebene Stoppwörter enthält. Dies ist aus zwei Gründen nützlich: Erstens wird die Inferenzzeit verkürzt, da der Endpunkt keinen unerwünschten Text über die Stoppwörter hinaus generiert, und zweitens verhindert dies, dass das OpenChatKit-Modell zusätzliche menschliche und Bot-Antworten halluziniert, bis andere Stoppkriterien erfüllt sind .

Verwenden Sie eine OpenChatKit-Shell, um mit Ihrem bereitgestellten Endpunkt zu interagieren

OpenChatKit bietet eine Befehlszeilen-Shell für die Interaktion mit dem Chatbot. In diesem Schritt erstellen Sie eine Version dieser Shell, die mit Ihrem bereitgestellten Endpunkt interagieren kann. Wir bieten eine grundlegende Vereinfachung der Inferenzskripte in diesem OpenChatKit-Repository, die mit unserem bereitgestellten SageMaker-Endpunkt interagieren können.

Dabei gibt es zwei Hauptkomponenten:

- Ein Shell-Interpreter (

JumpStartOpenChatKitShell), das iterative Inferenzaufrufe des Modellendpunkts ermöglicht - Ein Gesprächsobjekt (

Conversation), das frühere Mensch-/Chatbot-Interaktionen lokal in der interaktiven Shell speichert und vergangene Konversationen für den zukünftigen Inferenzkontext entsprechend formatiert

Das Conversation Das Objekt wird unverändert aus dem OpenChatKit-Repository importiert. Der folgende Code erstellt einen benutzerdefinierten Shell-Interpreter, der mit Ihrem Endpunkt interagieren kann. Dies ist eine vereinfachte Version der OpenChatKit-Implementierung. Wir empfehlen Ihnen, das OpenChatKit-Repository zu erkunden, um zu sehen, wie Sie in diesem Zusammenhang detailliertere Funktionen wie Token-Streaming, Moderationsmodelle und erweiterte Generierung beim Abruf nutzen können. Der Kontext dieses Notebooks konzentriert sich auf die Demonstration eines minimal brauchbaren Chatbots mit einem JumpStart-Endpunkt; Von hier aus können Sie die Komplexität nach Bedarf hinzufügen.

Eine kurze Demo zur Präsentation des JumpStartOpenChatKitShell wird im folgenden Video gezeigt.

Der folgende Ausschnitt zeigt, wie der Code funktioniert:

Sie können diese Shell jetzt als Befehlsschleife starten. Dadurch wird wiederholt eine Eingabeaufforderung ausgegeben, Eingaben akzeptiert, der Eingabebefehl analysiert und Aktionen ausgeführt. Da die resultierende Shell in einer Endlosschleife verwendet werden kann, bietet dieses Notebook eine Standardbefehlswarteschlange (cmdqueue) als Warteschlangenliste von Eingabezeilen. Denn die letzte Eingabe ist der Befehl /quit, wird die Shell beendet, wenn die Warteschlange erschöpft ist. Um dynamisch mit diesem Chatbot zu interagieren, entfernen Sie das cmdqueue.

Beispiel 1: Der Konversationskontext bleibt erhalten

Die folgende Eingabeaufforderung zeigt, dass der Chatbot in der Lage ist, den Kontext des Gesprächs beizubehalten, um Folgefragen zu beantworten:

Beispiel 2: Klassifizierung von Gefühlen

Im folgenden Beispiel führte der Chatbot eine Klassifizierungsaufgabe durch, indem er die Stimmungen des Satzes identifizierte. Wie Sie sehen, konnte der Chatbot positive und negative Gefühle erfolgreich klassifizieren.

Beispiel 3: Zusammenfassungsaufgaben

Als nächstes haben wir Zusammenfassungsaufgaben mit der Chatbot-Shell ausprobiert. Das folgende Beispiel zeigt, wie der Langtext über Amazon verstehen wurde zu einem Satz zusammengefasst und der Chatbot konnte Folgefragen zum Text beantworten:

Beispiel 4: Strukturierte Informationen aus unstrukturiertem Text extrahieren

Im folgenden Beispiel haben wir mit dem Chatbot eine Markdown-Tabelle mit Kopfzeilen, Zeilen und Spalten erstellt, um mithilfe der in Freiformsprache bereitgestellten Informationen einen Projektplan zu erstellen:

Beispiel 5: Befehle als Eingabe für den Chatbot

Wir können Eingaben auch als Befehle bereitstellen /hyperparameters um Hyperparameterwerte zu sehen und /quit So beenden Sie die Befehlsshell:

Diese Beispiele zeigten nur einige der Aufgaben, bei denen sich OpenChatKit auszeichnet. Wir empfehlen Ihnen, verschiedene Eingabeaufforderungen auszuprobieren und herauszufinden, was für Ihren Anwendungsfall am besten funktioniert.

Aufräumen

Nachdem Sie den Endpunkt getestet haben, stellen Sie sicher, dass Sie den SageMaker-Inferenzendpunkt und das Modell löschen, um zu vermeiden, dass Gebühren anfallen.

Zusammenfassung

In diesem Beitrag haben wir Ihnen gezeigt, wie Sie das GPT-NeoXT-Chat-Base-20B-Modell mit SageMaker testen und verwenden und interessante Chatbot-Anwendungen erstellen. Probieren Sie noch heute das Foundation-Modell in SageMaker aus und teilen Sie uns Ihr Feedback mit!

Diese Anleitung dient nur zu Informationszwecken. Sie sollten dennoch Ihre eigene unabhängige Bewertung durchführen und Maßnahmen ergreifen, um sicherzustellen, dass Sie Ihre eigenen spezifischen Qualitätskontrollpraktiken und -standards sowie die lokalen Regeln, Gesetze, Vorschriften, Lizenzen und Nutzungsbedingungen einhalten, die für Sie, Ihre Inhalte usw. gelten das in dieser Anleitung genannte Drittanbietermodell. AWS hat keine Kontrolle oder Autorität über das in dieser Anleitung genannte Drittanbietermodell und gibt keine Zusicherungen oder Gewährleistungen dafür, dass das Drittanbietermodell sicher, virenfrei, betriebsbereit oder mit Ihrer Produktionsumgebung und Ihren Standards kompatibel ist. AWS gibt keine Zusicherungen, Gewährleistungen oder Garantien dafür, dass die Informationen in dieser Anleitung zu einem bestimmten Ergebnis oder Ergebnis führen werden.

Über die Autoren

Rachna Chadha ist Principal Solutions Architect AI/ML in Strategic Accounts bei AWS. Rachna ist eine Optimistin, die glaubt, dass der ethische und verantwortungsvolle Einsatz von KI die Gesellschaft in Zukunft verbessern und wirtschaftlichen und sozialen Wohlstand bringen kann. In ihrer Freizeit verbringt Rachna gerne Zeit mit ihrer Familie, wandert und hört Musik.

Rachna Chadha ist Principal Solutions Architect AI/ML in Strategic Accounts bei AWS. Rachna ist eine Optimistin, die glaubt, dass der ethische und verantwortungsvolle Einsatz von KI die Gesellschaft in Zukunft verbessern und wirtschaftlichen und sozialen Wohlstand bringen kann. In ihrer Freizeit verbringt Rachna gerne Zeit mit ihrer Familie, wandert und hört Musik.

Kyle Ulrich ist Angewandte Wissenschaftlerin bei der Integrierte Amazon SageMaker-Algorithmen Team. Seine Forschungsinteressen umfassen skalierbare Algorithmen für maschinelles Lernen, Computer Vision, Zeitreihen, bayessche nichtparametrische Verfahren und Gaußsche Prozesse. Er hat an der Duke University promoviert und Artikel in NeurIPS, Cell und Neuron veröffentlicht.

Kyle Ulrich ist Angewandte Wissenschaftlerin bei der Integrierte Amazon SageMaker-Algorithmen Team. Seine Forschungsinteressen umfassen skalierbare Algorithmen für maschinelles Lernen, Computer Vision, Zeitreihen, bayessche nichtparametrische Verfahren und Gaußsche Prozesse. Er hat an der Duke University promoviert und Artikel in NeurIPS, Cell und Neuron veröffentlicht.

Dr. Ashish Khetan ist Senior Applied Scientist mit integrierten Amazon SageMaker-Algorithmen und hilft bei der Entwicklung von Algorithmen für maschinelles Lernen. Er promovierte an der University of Illinois Urbana-Champaign. Er ist ein aktiver Forscher auf dem Gebiet des maschinellen Lernens und der statistischen Inferenz und hat viele Artikel auf den Konferenzen NeurIPS, ICML, ICLR, JMLR, ACL und EMNLP veröffentlicht.

Dr. Ashish Khetan ist Senior Applied Scientist mit integrierten Amazon SageMaker-Algorithmen und hilft bei der Entwicklung von Algorithmen für maschinelles Lernen. Er promovierte an der University of Illinois Urbana-Champaign. Er ist ein aktiver Forscher auf dem Gebiet des maschinellen Lernens und der statistischen Inferenz und hat viele Artikel auf den Konferenzen NeurIPS, ICML, ICLR, JMLR, ACL und EMNLP veröffentlicht.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Kaufen und verkaufen Sie Anteile an PRE-IPO-Unternehmen mit PREIPO®. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/gpt-neoxt-chat-base-20b-foundation-model-for-chatbot-applications-is-now-available-on-amazon-sagemaker/

- :hast

- :Ist

- :nicht

- $UP

- 1

- 100

- 12

- 13

- 15%

- 20

- 23

- 30

- 40

- 50

- 500

- 7

- 9

- a

- Fähig

- Über uns

- Akzeptieren

- Zugang

- Nach

- Trading Konten

- Erreichen

- Aktionen

- aktiv

- automatisch

- hinzufügen

- Zusatz

- Zusätzliche

- zusätzlich

- advanced

- Vorschüsse

- AI

- AI / ML

- Algorithmen

- erlauben

- erlaubt

- ebenfalls

- Alternative

- am

- Amazon

- Amazon verstehen

- Amazon Sage Maker

- Amazon Web Services

- Betrag

- an

- Analyse

- analysieren

- und

- Bekannt geben

- beantworten

- jedem

- Bienen

- APIs

- App

- Anwendung

- Anwendungen

- angewandt

- Jetzt bewerben

- passend

- ca.

- SIND

- Argument

- Kunst

- AS

- Bewertung

- gesichert

- At

- Augmented

- Autorität

- verfügbar

- vermeiden

- AWS

- basierend

- Bayesianisch

- BE

- weil

- Bevor

- glaubt,

- BESTE

- Besser

- Beyond

- Milliarden

- Wander- und Outdoorschuhen

- Bots

- Box

- bringen

- bauen

- eingebaut

- by

- CAN

- Fähigkeiten

- Hauptstadt

- Häuser

- Fälle

- Kategorien

- Kategorie

- Charakteristik

- Gebühren

- Chatbot

- ChatGPT

- Auswählen

- Stadt

- Klasse

- Einstufung

- klassifizieren

- Code

- arbeitete zusammen

- Zusammenarbeit

- Spalten

- gemeinsam

- vergleichbar

- kompatibel

- abschließen

- Komplexität

- Komponenten

- begreifen

- Computer

- Computer Vision

- Bedenken

- Kongressbegleitung

- Konsul (Console)

- Container

- enthält

- Inhalt

- Kontext

- fortsetzen

- Smartgeräte App

- Gespräch

- Konversations

- Gespräche

- verkaufen

- cool

- erstellen

- erstellt

- schafft

- Erstellen

- Kriterien

- kuratiert

- Original

- Kunde

- Kunden

- DC

- technische Daten

- Datenwissenschaft

- Datensätze

- tief

- tiefe Lernen

- Standard

- Demo

- demonstrieren

- Abhängig

- einsetzen

- Einsatz

- Einsatz

- Beschreibung

- entworfen

- erwünscht

- Detail

- Bestimmen

- entwickeln

- entwickelt

- Entwickler

- Entwicklung

- entwickelt

- anders

- digital

- digitale Kunst

- Dispatch

- do

- Docker

- Docker-Container

- Dokument

- Unterlagen

- die

- Tut nicht

- dominant

- Herzog

- Duke University

- Dauer

- dynamisch

- jeder

- leicht

- Wirtschaftlich

- Elemente

- sonst

- ermöglichen

- ermöglichen

- ermutigen

- End-to-End

- Endpunkt

- gewährleisten

- Ganz

- Entitäten

- Einheit

- Arbeitsumfeld

- Äther (ETH)

- ethisch

- Auswerten

- Sogar

- untersuchen

- Beispiel

- Beispiele

- aufgeregt

- vorhandenen

- Beenden

- Erweitern Sie die Funktionalität der

- teuer

- ERKUNDEN

- Extrakt

- Extraktion

- Gesicht

- Familie

- weit

- Favorit

- Angst

- Merkmal

- Eigenschaften

- Feedback

- wenige

- Mappen

- Finden Sie

- Vorname

- konzentriert

- Fokussierung

- Folgende

- folgt

- Aussichten für

- Foundation

- für

- weiter

- Zukunft

- erzeugen

- Erzeugung

- Generation

- bekommen

- gegeben

- gehen

- gut

- Gewährung

- Garantien

- die Vermittlung von Kompetenzen,

- Haben

- mit

- he

- Überschriften

- Hilfe

- hilft

- hier (auf dänisch)

- hier

- Wandern

- seine

- Gastgeber

- gehostet

- Ultraschall

- Hilfe

- HTML

- HTTPS

- Nabe

- human

- i

- ICLR

- ID

- Identifizierung

- if

- Illinois

- Image

- Implementierung

- zu unterstützen,

- verbessert

- in

- eingehende

- das

- Dazu gehören

- Einschließlich

- unabhängig

- Information

- Informational

- Anfangs-

- Varianten des Eingangssignals:

- Eingänge

- Einblicke

- installieren

- Instanz

- Anleitung

- beabsichtigt

- interagieren

- Interaktionen

- interaktive

- interessant

- Interessen

- in

- Isolierung

- Problem

- IT

- SEINE

- Javac

- Jobs

- jpg

- nur

- Wesentliche

- Art

- Wissen

- bekannt

- Sprache

- Sprachen

- grosse

- Nachname

- Latency

- starten

- ins Leben gerufen

- Gesetze

- lernen

- Verlassen

- Bibliotheken

- Bibliothek

- Lizenz

- Lizenzen

- Gefällt mir

- Line

- Linien

- Liste

- Hören

- aus einer regionalen

- örtlich

- Lang

- Los

- Maschine

- Maschinelles Lernen

- Main

- halten

- um

- Weise

- viele

- Kann..

- Maßnahmen

- mittlere

- Erwähnungen

- Methode

- Million

- minimal

- minimieren

- Minuten

- ML

- Modell

- für

- Mäßigung

- geändert

- mehr

- Morgen

- Musik

- Natürliche

- Natürliche Sprache

- Verarbeitung natürlicher Sprache

- Need

- erforderlich

- Negativ

- Netzwerk

- Vernetzung

- NeuroIPS

- hört niemals

- Neu

- neue Produkte

- News

- Nlp

- nicht

- Notizbuch

- Laptops

- jetzt an

- Objekt

- of

- Oliven

- on

- EINEM

- einzige

- Open-Source-

- Betriebs-

- Optimieren

- Optionen

- or

- Andere

- UNSERE

- Ergebnis

- skizzierte

- Möglichkeiten für das Ausgangssignal:

- aussen

- übrig

- besitzen

- Papiere

- Parameter

- besondere

- Parteien

- passt

- ausführen

- Leistung

- Sätze

- Pizza

- Plan

- Plato

- Datenintelligenz von Plato

- PlatoData

- Play

- Beliebt

- positiv

- Post

- Praktiken

- Predictor

- Vorlieben

- Voraussetzungen

- verhindert

- früher

- Principal

- Prioritätsliste

- anpassen

- Verarbeitung

- Produktion

- Produkte

- Projekt

- Wohlstand

- die

- vorausgesetzt

- Anbieter

- bietet

- veröffentlicht

- Zwecke

- Python

- Pytorch

- Qualität

- Frage

- Fragen

- schnell

- Angebot

- lieber

- Echtzeit

- Gründe

- kürzlich

- Rezept

- Anerkennung

- erkennen

- Reduziert

- Refaktorieren

- Vorschriften

- Release

- entfernen

- WIEDERHOLT

- Quelle

- falls angefordert

- Forschungsprojekte

- Forscher

- Antwort

- Antworten

- für ihren Verlust verantwortlich.

- REST

- Folge

- was zu

- behalten

- Rückkehr

- Überprüfen

- Rise

- Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben.

- Führen Sie

- s

- sagemaker

- SageMaker-Inferenz

- sagen

- skalierbaren

- Skalieren

- Scan

- Wissenschaft

- Wissenschaftler

- Umfang

- Skripte

- Sdk

- Suche

- Zweite

- Abschnitte

- Verbindung

- Sicherheitdienst

- sehen

- Auswahl

- SELF

- Senior

- Satz

- Gefühl

- Reihenfolge

- Modellreihe

- Leistungen

- Dienst

- Sitzung

- kompensieren

- Sets

- Setup

- mehrere

- von Locals geführtes

- Schale

- Short

- sollte

- erklären

- Vitrine

- präsentiert

- zeigte

- gezeigt

- Konzerte

- ähnlich

- vereinfachte

- SIX

- klein

- So

- Social Media

- Soziales Netzwerk

- Gesellschaft

- Lösung

- Lösungen

- LÖSEN

- einige

- Quelle

- Quellcode

- spezifisch

- angegeben

- Geschwindigkeit

- Ausgabe

- Verbreitung

- Normen

- Anfang

- begonnen

- statistisch

- Schritt

- Shritte

- Immer noch

- Stoppen

- Läden

- Strategisch

- Streaming

- Struktur

- strukturierte

- Erfolgreich

- so

- ZUSAMMENFASSUNG

- Unterstützte

- sicher

- Tabelle

- Nehmen

- Aufgabe

- und Aufgaben

- Team

- Techniken

- erzählen

- Vorlagen

- Tensorfluss

- AGB

- Test

- Tester

- Texterzeugung

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Hauptstadt

- Die Zukunft

- die Informationen

- Die Quelle

- Sie

- sich

- dann

- Dort.

- Diese

- Dritte

- dritte seite

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- Durch

- Zeit

- Zeitfolgen

- zu

- heute

- gemeinsam

- Zeichen

- Training

- trainiert

- Ausbildung

- Transformer

- Übersetzungen

- versucht

- was immer dies auch sein sollte.

- versuchen

- XNUMX

- tippe

- typisch

- ui

- für

- zugrunde liegen,

- Verständnis

- Universität

- bis

- auf

- URI

- us

- Anwendungsbereich

- -

- Anwendungsfall

- benutzt

- Verwendung von

- seit

- Werte

- Vielfalt

- verschiedene

- Version

- lebensfähig

- Video

- Seh-

- wollen

- warm

- wurde

- Washington

- we

- Wetter

- Netz

- Web-Services

- Wochen

- willkommen

- GUT

- Was

- Was ist

- wann

- ob

- welche

- WHO

- breit

- breiter

- werden wir

- mit

- .

- ohne

- Word

- Worte

- Arbeitsablauf.

- Werk

- schreiben

- U

- Ihr

- Zephyrnet