See artikkel avaldati osana Andmeteaduse ajaveebi

Sissejuhatus

Mind on seostatud Analytics Vidyaga alates Blogathoni 3. väljaandest. Erinevalt häkatonidest, kus peaksime ettenähtud aja jooksul teemapõhise projekti välja mõtlema, on ajaveebid erinevad. Blogatonid on umbes kuu aega kestvad võistlused, kus kodeerimise asemel peame looma tehnilist sisu mis tahes asjakohasel teemal.

Arvan, et pärast peaaegu 11 ajaveebi läbiviimist on Analytics Vidya andmeanalüütikameeskond hoolikalt analüüsinud eelmiste ajaveebide andmeid. See on astunud julgeid samme, et suurendada konkurentsi üldist kaasatust. Seetõttu võtame ajaveebitelt välja asjakohased andmed, vaatame lähemalt iga väljaande järel tehtud muudatusi, mõningaid artikleid ja ajaveebi suundumusi, populaarsemaid ja seni uurimata teemasid ning palju muud teavet.

Andmete ekstraheerimine edetabelist

Märkus. Autor on meie nõusolekul andmeid kogunud Analytics Vidhya DataHacki platvormilt.

Igat tüüpi analüüsi jaoks vajame andmeid. Nende ajaveebi peamiseks andmeallikaks oleks edetabel. Selles on loetletud kõik autorite nimed, avaldamiskuupäevad ja vaated. Pärast Blogathon 9 väljaannet lisati artiklite lingid ka edetabelisse ja alates blogi 11 väljaandest võeti kasutusele Analytics Vidhya Creator Club ning selle klubi autorite eristamiseks kuvatakse koos autori nimega täht.

Blogathon 11 edetabel

Edetabeli lõpp-punkti saamine

Nende ajaveebi edetabel on lehekülgedega ja tabeli sisu renderdatakse ainult edetabeli vahekaardi all. Probleem on selles, et me ei saa brauseris oleva URL-i põhjal aru, kuidas sisu muutub. Mõelge sellele URL-ile:

"https://datahack.analyticsvidhya.com/contest/data-science-blogathon-11/#LeaderBoard"

Niipea kui klõpsame tabeli all oleval nupul "Järgmine", muutub tabeli sisu, kuid URL ei muutu. Seetõttu peame süvenema sellesse, kuidas sisu värskendatakse.

Selleks saame kroomi konsooli aknas kontrollida tegelikku päringu I/O-d (ctrl + shift + i). Siit leiame kõik taustal tehtud päringud ja andmete toomised. Siin kirjeldatav protseduur on peaaegu sama kõigi saitide puhul, mis on üles ehitatud sarnaselt Analytics Vidhyaga:

- Kõigepealt avage kroomitud konsool

- Liikuge vahekaardile Võrk

- Seejärel klõpsake nuppu "Lõpeta võrgulogi salvestamine", punase punkti nuppu ja seejärel uuesti seda nuppu

- Nüüd klõpsake edetabeli all nuppu "Järgmine" ja klõpsake kiiresti uuesti punasel punktil, et tegevusala ei oleks rahvarohke

- Märka tegevusalal tehtud taotlusi

- Näeme mõningaid hüperlingitud elemente. Proovige seotud link brauserisse kopeerida ja kleepida ja vaadake, kas saame andmeväljundeid.

Leidsin lõpp-punkti, kust edetabeli andmeid värskendati.

URL-i vaadates leidsin mustri:

"https://datahack.analyticsvidhya.com/contest/data-science-blogathon-11/lb/1/"

Kui lisame pärast võistluse linki lõpp-punkti “lb” ja numbri, saame selle numbri edetabelilehe. See tähendab, et saame seda URL-i kasutades hankida kõik edetabelilehed. See on oluline lõpp-punkt, kuna see aitab meil andmeid välja jätta. Kui külastame seda lõpp-punkti, on kohal ainult edetabel, mis muudab meie protsessi lihtsaks.

Andmete lammutamine Exceli abil (koodita lähenemine)

Excel on tõepoolest võimas rakendus ja ma ei saa rõhutada, kuidas see mind minu andmeanalüüsi teekonnal aitab. Saame lihtsalt navigeerida vahekaardile „Andmed” ja valida valiku „Veebis”. Siin peame andma URL-i ja pärast mõningast otsimist annab see meile andmetabeli.

Saame andmeid sel viisil hõlpsasti hankida, kuid siin on selle lähenemisviisi piirangud:

- Peame erinevate lehtede lingid mitu korda sisestama ja see on tüütu, kui on vaja mitut ajaveebi andmete väljaannet.

- Me kaotame artiklite lingid, kuna see ekstraheerib tabeli ridadest tekstikomponendid

- Kaotame Analytics Vidya Creator Clubi olekutähe iga kasutajanime puhul

Võib väita, et nende andmete toomiseks ja kustutatava sisu muutmiseks saab luua kohandatud VBA. Ma ei soovita teile seda teed, kuna sama asja saab teha ka Pythoni abil. Pythoni koode on lihtne mõista ja need nõuavad vähem pingutust.

Andmete eemaldamine Pythoni abil

Meil on turul palju teeke, mis saavad hõlpsalt veebisaitidelt tabeliandmeid välja võtta. Proovisin mõnda neist, kuid ma ei saanud oodatud tulemust. Seetõttu rakendame soovitud väljundi saamiseks käsitsi teatud reegleid. Enne koodipõhise lähenemisviisi arutamist tahame abstraktsel tasandil saavutada järgmist:

- Külastage edetabeli lõpp-punkti

- Otsige üles tabeli kehaelement

- Korrake kõiki ridu ja eemaldage kasutajanimi, loojaklubi olek, artikli link, avaldamise kuupäev ja vaated

- Korrake seda kõigi edetabelilehtede jaoks ja lisage need ühte andmeraami.

Koodi juurutamiseks vajame järgmisi teeke:

- urllib: URL-ile päringute tegemiseks

- Pandas: andmeraamide loomiseks, CSV-vormingus salvestamiseks ja muudeks manipulatsioonideks

- re: Regulaaravaldiste reeglite koostamiseks andmete kustutamiseks

- tqdm: ekstraheerimisprotsessi edenemisriba loomiseks, et oleksime edenemisest teadlikud.

Alustame koodi juurutamisega:

Importige vajalikud teegid

import urllib.request import pandad pd-na impordi uuesti impordi aeg import numpy kui np alates tqdm import tqdm

Veebilehe HTML-sisu saamiseks stringi vormingus teeme päringu URL-ile ja loeme koodi. Kuna seda toimingut tehakse üsna mitu korda, looge selle jaoks funktsioon.

def url_get_contents(url): req = urllib.request.Request(url=url, headers={'Kasutajaagent': 'Mozilla/5.0'}) f = urllib.request.urlopen(req) return f.read()

Loo andmesõnastik, kus saame hoida veebisaidilt eraldatud andmeid

data = { 'ase': [], 'kasutajanimi': [], 'artikli_link': [], 'kuupäev': [], 'vaatamised': [], 'looja_klubi_status': [], 'artikli_kass': [ ] }

Ignoreerige praegu funktsiooni "article_cat". Alustuseks eemaldame andmed Blogathon 11 jaoks ja siis saame kasutada sama koodi ka teiste väljaannete jaoks. Esiteks hankige veebisaidi sisu.

xhtml = url_get_contents(f"https://datahack.analyticsvidhya.com/contest/data-science-blogathon-11/lb/1/").decode('utf-8')

Märkus. Siin olen selgelt maininud edetabeli leheküljenumbrit, kuid hiljem asendatakse see tsükli iteratsiooni muutujaga.

Järgmisena defineerime regulaaravaldise reegli sisu saamiseks tabeli kehasildi vahele ja seejärel kasutame andmete hankimiseks funktsiooni findall.

r = re.compile(r'.* ', re.DOTALL)tableData = r.findall(xhtml)[0]

Saadud andmetest peame eemaldama tabeli kehasildid ja reavahetused.

def asenda_kõik(dikt, str): võtme jaoks dict: str = str.replace(key, dict[key]) return str cleanedTableData = asenda_kõik({"":"", "

":", "n": ""}, tableData).strip()[:-1]

Nüüd on need tabeliandmed pikk string tabeli ridade ja tabeliandmete siltidega. Näeme tabeli struktuuri järgmiselt:

Tabeli kehasildi all on palju tabeli ridu ja nende ridade siltide all on meil lahtri andmed, mis sisaldavad kasutajanime, artikli URL-i, vaateid jne. Siiani on tabeli kehaandmed stringi kujul.

Seetõttu jagame selle stringi ridade lõppu, nii et meil on kõik read eraldi loendiüksustena, mida saab itereerida.

tableRowsList = cleanedTableData.split('

")

Iga üksus selles loendis on kujul:

Jällegi peame selle loendiüksuse poolitama suletava tabeli andmesildi (TD) juures, mille järel saame tabelielementide lõpliku loendi.

i jaoks vahemikus(len(tableRowsList)): row = tabelRidade loend[i] rida = rida.split('

')[:-1]

Kõigi rea elementide reeglid on järgmised:

i jaoks vahemikus(len(tableRowsList)): row = tabelRidade loend[i] rida = rida.split('

')[:-1]

data['rank'].append(row[0][8:])

data['views'].append(row[-1][4:])

data['creator_club_status'].append(1 if "" reas[2] else 0) data['date'].append(row[4][4:]) kasutajanimi = row[2].split('')[0].strip()[4:] data['kasutajanimi'].append(kasutajanimi if '[email protected]' ei ole kasutajanimes else decodeEmail(kasutajanimi.split('>')[0].replace( '"', '').split('=')[-1])) data['article_link'].append(row[3].split('=')[1].replace('"', '')[:-7])

Siin on koodi jaotus:

- Rank on lihtsalt esimene element ja algab 9. märgist (8. indeks)

- Vaated on viimane element ja algavad 5. märgist

- Loojaklubi staatus määratakse, kui tärni ülaindeksi märgend on loendi 3. elemendis. Lisame 1 kohaloleku ja 0 puudumise kohta

- Kuupäev on viies element ja algab 5. märgist

- Artikli link on 4. elemendis. See tuleb jagada võrdusmärgi juures, seejärel asendada 2. elemendi jutumärgid ja seejärel eemaldada viimasest 7 viimast tähemärki

Kasutajanimi nõuab erikohtlemist, kuna sellega võib kaasneda tärnide ülaindeks või mitte. Seetõttu jagame kasutajanime elemendi ülaindeksi märgendi juures pooleks ja võtame seejärel viiendast märgist edasi. Kuid siin on veel üks probleem, et mõnda @-ga kasutajanime käsitletakse e-posti ID-dena ja Cloudflare DNS kodeerib need meilid vaikimisi. Saadaval on ka räsivorm ja tekst on asendatud kohatäite tekstiga “e-postiga kaitstud”.

Selliste räside dekodeerimiseks leidsin funktsiooni koodi:

def decodeEmail(e): de = "" k = int(e[:2], 16) i jaoks vahemikus (2, len(e)-1, 2): de += chr(int(e[i: i+2], 16)^k) tagasi de

Nüüd peame kontrollima, kas saadud kasutajanimel on tekst "e-postiga kaitstud". Kui jah, siis peame funktsioonile edastama räsi ja lisama selle kasutajanime. See oli kogu andmete väljavõtmise protsess. Saame panna kogu selle reatsükli teise ahelasse kõigi edetabeli lehtede jaoks ja siin on kogu konsolideeritud loogika:

i jaoks tqdm(vahemik(1,4)): xhtml = url_get_contents(f"https://datahack.analyticsvidhya.com/contest/data-science-blogathon-11/lb/{i}/").decode( 'utf-8') r = re.compile(r'.*

', re.DOTALL) tableData = r.findall(xhtml)[0] cleanedTableData = asenda_all({" ":"", " ":"", "n": ""}, tableData).strip()[: -1] tableRowsList = cleanedTableData.split(' ') for i in range(len(tableRowsList)): # len(tableRowsList) row = tableRowsList[i] row = row.split(' ')[:-1] data[ 'aste'].append(row[0][8:]) data['views'].append(rida[-1][4:]) data['creator_club_status'].append(1 if "" reas[2] else 0) data['date'].append(row[4][4:]) kasutajanimi = row[2].split('')[0].strip()[4:] data['kasutajanimi'].append(kasutajanimi if '[email protected]' ei ole kasutajanimes else decodeEmail(kasutajanimi.split('>')[0].replace( '"', '').split('=')[-1])) data['article_link'].append(row[3].split('=')[1].replace('"', '')[:-7]) aeg.uni(3)

Märge:

- Jätke lehepäringute tegemisel kindlasti uneaega, et me ei teeks serverile DDoS-i.

- Peaksime iteratsioonivahemiku panema funktsiooni "tqdm". See kuvab for-tsükli edenemist edenemisriba kujul, mis aitab protsessil silma peal hoida.

- Kõigi ajaveebiürituste andmete hankimiseks värskendage lihtsalt vahemiku funktsiooni lehtede arvu ja muutke URL-is ajaveebi numbrit.

Vanametallist artiklite kategooriad

Alates 9. blogist on meil kõigi autorite artiklite lingid. Neid linke saame kasutada artiklite kategooriate hankimiseks. Vanemate väljaannete puhul on need kategooriad tühised. Kui külastame mõnda artiklit ja vaatame artikli HTML-i, saame lihtsalt märgata artiklikategooriatele vastava div-märgendi klassi. Ma ei korda seda protsessi nagu eelmises jaotises.

Sama funktsiooni saame kasutada artikli sisu toomiseks ja lehe jagamiseks kategooriatesse HTML. Siin on kategooriate ekstraheerimise loogika:

i jaoks tqdm(range(len(data['artikli_link']))): proovige: webD = url_get_contents(data['article_link'][i]).decode('utf-8') cat = ','. join([i.split('>')[-1] i jaoks in webD.split('

')[1].split('

')[0].replace('n', ").split(")[:-1]])

data['article_cat'].append(cat)

välja arvatud:

data['article_cat'].append('NA')

aeg. magama (1)

Kordame kõiki esialgse kraapimise käigus saadud artiklite linke. Seejärel toome iga lingi jaoks sisu, töötleme ja jagame stringi ning lõpuks lisame need kategooriad komadega eraldatud stringina andmesõnastikku.

Lõpliku andmekogumi ettevalmistamine

Pärast kogu ekstraheerimisprotsessi ja HTML-i kontrollimist on aeg muuta see andmestik sõnastikust pandade andmeraamideks ja CSV-deks. Kasutage selle teisenduse jaoks panda andmeraami funktsiooni

df = pd.DataFrame(data)

Enne analüüsi osa juurde liikumist teeme veel mõned eeltöötlusetapid ja määrame andmestiku funktsioonidele õiged andmetüübid.

Mõnel numbriveerul on ikka suuremad kui märgid. Peame need sümbolid eemaldama:

i jaoks veerus df.columns: if df[i].dtype != np.int64: df[i] = df[i].str.replace('>', '')

Järgmisena teisendage numbrilised veerud õigeks andmetüübiks:

i jaoks in ['rank', 'views']: df[i] = df[i].astype(int)

Ja viimane samm on teisendada kuupäevatempli stringid kuupäeva ja kellaaja väärtusteks:

df['kuupäev'] = pd.to_datetime(df['kuupäev'])

Lõpliku andmeraami saame salvestada CSV-failidesse, et saaksime selle hiljem kätte saada.

Leidke kogu selles artiklis käsitletav lähtekood minu GitHubi hoidlast: ajaveebi-analüüs

Andmete analüüs

Kuni viimase jaotiseni nägime, kuidas hankida edetabeli värskenduste lõpp-punkt, kuidas käsitleda HTML-koodi ja kuidas paika panna andmete eraldamise loogika. Enne failide CSV-vormingusse salvestamist tegime ka mõned eeltöötlusetapid. Selle artikli jaoks kasutasin sama koodi kõigi ajaveebi väljaannete jaoks alates esimesest kuni 11. väljaandeni.

Nüüd keskendume sellele, kuidas kogu see andmete väljavõtmine on mõttekas. Loome trendide jälgimiseks visualiseeringud ja koondame lõpuks kõik diagrammid ja arvud armatuurlauale. Kasutame kõigi visuaalsete analüüside jaoks PowerBI-d.

PowerBI on hämmastav andmete visualiseerimise ja armatuurlaua loomise tööriist. Selle tööriista parim osa on see, et saate andmetele rakendada mis tahes tüüpi toiminguid, ühendada andmeallikaid (kohalikud või pilvepõhised torujuhtmed) ja avaldada aruanded veebis. Need aruanded on juurdepääsetavad kõigile sidusrühmadele ja organisatsioon saab hallata juurdepääsu administraatorikontodelt.

Andmete lisamine PowerBI-sse ja nende ettevalmistamine aruannete jaoks

Kõiki CSV-sid sisaldava kausta lisamiseks PowerBI-sse. valige ülemiselt lindilt suvand "Hangi andmed", alt "Veel", seejärel valige lisa kaust ja sisestage kausta tee.

Nüüd valime kombineerimise ja teisendamise valiku. See avab PowerBI päringu redaktori, mis on PowerBI süda. Päringuredaktoris puhastame kombaini ja puhastame andmed, eemaldame mittevajalikud andmed ja salvestame lõpliku ühendatud andmestiku. Siin on sammud, mida peame tegema:

Kombineeri failid: Klõpsake nuppu Ühenda failid. Sellele valikule pääseb juurde, klõpsates sisu veeru parempoolsel ikoonil. Kuvatakse hüpikaken, mis kuvab ühendatud andmete eelvaate. Praegu klõpsake "ok".

Veergude eemaldamine: Mõnda veergu pole lõplikuks analüüsiks vaja. See hõlmab „rank”, „article_link” ja loodud täiendavat veergu „123”. Valige lihtsalt need veerud ja paremklõpsake, et kuvada veergude eemaldamise võimalus.

Muuda allika veeru väärtusi: Kui ühendasime kõik andmed ühte faili. PowerBI lisas allika veeru, et näidata, milline väärtus millisest allikast pärineb. See veerg on meile kasulik andmete filtreerimiseks teatud ajaveebi väljaannete järgi. Selle veeru väärtustel on täpne failinimi ja seetõttu sisaldab see ka faililaiendit.

Nendest vabanemiseks paremklõpsake lihtsalt veeru nimel, valige "Asenda väärtused" ja sisestage asendusväärtuse leidmiseks ja lahkumiseks väärtus ".csv". Nüüd on kõik lähteväärtused vastava ajaveebi väljaande jaoks.

Teisendatud andmete aruandesse lisamiseks klõpsake nuppu Sule ja rakenda.

Visualisatsioonide loomine andmeanalüüsi jaoks

Nüüd tuleb osa, mille jaoks oleme nii palju ettevalmistustööd teinud. Loome oma armatuurlauale PowerBI-s erinevaid visuaale

Numbrikaardid: Need kaardielemendid on iga armatuurlaua ülaosas. Saame nendele kaartidele lisada mis tahes tüüpi arvutatud väärtuse. Meie puhul lisame vaatamiste koguarvu, autorite ja artiklite arvu kaardid. Kaardi lisamiseks lohistage see lihtsalt parempoolselt visualiseerimispaanilt. Nüüd peame nendele kaartidele lisama mõõdu. Mõõtme loomiseks paremklõpsake andmeallikal, valige uus mõõt ja sisestage selle vorming/valem.

Views'i jaoks on PowerBI automaatselt loonud mõõdiku vaadete summana. Seega saame selle otse kaardile lisada. Autorite jaoks peame rakendama selget loendusfunktsiooni, et saaksime autorite kordumatu arvu.

Artiklite arvu jaoks soovime ainult kogu andmete arvu. Seetõttu saame andmete hulgast valida mis tahes mitte-null veeru.

Lohistage need meetmed üksikutele kaartidele ja teil peaks olema selline väljund:

Kuupäev vs vaatamised Piirkonna diagramm: Joonistame artikli vaated avaldamise kuupäeva järgi. Koondmõõdiku jaoks valisin summaks vaikeväärtuse.

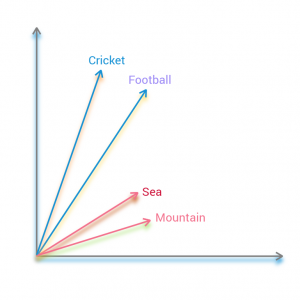

Sõnapilv: Sõnapilv tähistab konkreetses veerus esinevaid sõnu, mille fondi suurus on nende sageduse suhtes. See tähendab, et mida suurem on sõna sagedus, seda suurem on see.

Võib juhtuda, et vaikimisi pole see teie PowerBI rakendusse installitud. Seetõttu klõpsake visualiseerimispaanil kolmel punktil, valige "Get more visuals" ja otsige turult sõnapilve. Näete ametlikku Microsofti visuaali. Installimiseks klõpsake nuppu Hangi kohe.

Lohistage artiklite kategooriate veerg sõnapilve kategooria valikusse ja sõnapilv luuakse. PowerBI on piisavalt nutikas, et käsitleda komadega eraldatud kategooriaid üksikute kategooriatena.

Creator Clubi sektordiagramm: Tahame näha, kui suur on loojaklubi liikmete panus võrreldes mitteklubiliikmetega. Seetõttu näitaks sektordiagramm panust selgelt. Lohistage sektordiagrammi visuaal aruandele ja valige väärtusteks kasutajanimi (eraldatud) ja legendiks loojaklubi staatus.

Viilutajate lisamine andmete sortimiseks: Meie armatuurlaua viimane element on sortimissüsteem, kus saab graafikuid dünaamiliselt muuta, valides kriteeriumid või sortimisfailikomplekti. Lisame oma andmekogumi jaoks kaks viilutajat: ühe ajaveebi väljaannete või andmeallika jaoks ja teise kasutajanimede veeru või autorite jaoks.

Lõplik armatuurlaud

Kui kõik visualiseeringud on konfigureeritud, on aeg puhastada ruum, lisada ahvatlevat teksti ja fonte, kujundada graafikud ja taust, et luua lõplik armatuurlaud. See ülesanne põhineb puhtalt kujutlusvõimel ja loovusel ning seetõttu on meil vabadus siin kõike teha. Lõplik armatuurlaud, mille taustapiltide, stiilitud graafikute ja muude visuaalidega ette valmistasin, on järgmine:

Leidke see armatuurlaud minu GitHubi hoidlast: ajaveebi-analüüs

Järeldused armatuurlauast ja andmete analüüsist

Lõpuks oleme loonud edetabeli ja artiklikategooriate andmetest interaktiivse armatuurlaua. Kui meil oleks artiklite avaldamise täpne ajatempel, avaldamise aeg, võiksime aja jooksul saada hea trendi. On mõned punktid, mida ma oma analüüside põhjal järeldan:

- Vaated läksid 280k kuuendas väljaanne kuni 481k kuuendas väljaanne. See juhtus seetõttu, et meeskond tutvustas a baashind kõigi avaldatud artiklite jaoks.

- Kuigi mul pole andmeid Blogathon 8 artiklite kategooriate kohta, usun, et võrreldes blogathon 8-ga, ajaveebi 9 suunas oli tohutult palju artikleid edasijõudnud kategooriad nagu NLP. andmetehnika, arvutinägemine kui need kategooriaid hinnati kõrgemalt võrreldes tavaliste artiklitega. Nii palju kui 108 täiustatud artiklit avaldati 9. blogis.

- 9. blogis maksimaalselt 300 blogid avaldati, mis on kõigi aegade kõrgeim kogusummaga 628 tuhat vaadet. Samal ajal oli kõige vähem vaatamisi 13! Seetõttu on blogis 10, a 500 vaatamise künnis määrati, sest isegi nii paljude vaadete eest tuli auhindu välja anda. See ei vähendanud artiklite arvu ja tegelikult on artiklid suuruselt teine, 284 postitati. Šokeeriv oli see, et see väljaanne blogathon 10, salvestatud kokku 1 miljon vaatamist isegi pärast läve tingimust.

- 11. väljaandel oli ainult 222 123 vaatamise ja 12 artikliga raske aeg. Ma arvan, et see on põhjus, miks blogis XNUMX tutvustatakse uut kategooriat, juhendit.

- võib 2021 oli läbi aegade suurim vaatamiste arv. tipptasemel 0.79 miljonit.

- Python, Data, algaja. õppimine ja projekt on ühed kõige rohkem populaarsed kategooriad kogu aeg.

- Docker, R, Julia, Excel ja Deployment on mõned kõige vähem uuritud kategooriad.

LõppMärkused

Selles üksikasjalikus artiklite koostamise juhendis selgitasin kogu projekti ideed, taustakontrolli, oluliste lõpp-punktide saamist, seejärel Pythoni abil andmete väljavõtmist, andmete puhastamist, andmete laadimist PowerBI-sse, visualiseerimiste loomist. ja lõpuks, kuidas koondada kõik loodud visuaalid armatuurlauale.

Kui soovite lugeda / uurida kõiki minu artikleid, minge minu juurde põhiartiklite loend mida värskendatakse iga kord, kui avaldan mis tahes platvormil uue artikli!

eest kahtlused, küsimused või potentsiaalsed võimalused, saate minuga ühendust võtta järgmiselt:

1. Linkedin — in/kaustubh-gupta/

2. Twitter — @Kaustubh1828

3. GitHub — kaustubhgupta

4. Keskmine — @kaustubhgupta1828

Selles artiklis näidatud meediumid ei kuulu Analytics Vidhyale ja neid kasutatakse autori äranägemisel.

- '

- "

- 11

- 2021

- 7

- 9

- juurdepääs

- tegevus

- admin

- Materjal: BPA ja flataatide vaba plastik

- analüüs

- analytics

- taotlus

- PIIRKOND

- artikkel

- kaubad

- autorid

- BEST

- keha

- brauseri

- canva

- muutma

- Äritegevus

- Kroom

- lähemale

- Cloud

- klubi

- kood

- Kodeerimine

- Veerg

- konkurents

- Võistlused

- Arvuti visioon

- nõusolek

- sisu

- sisu

- konkurss

- loomine

- loovus

- looja

- armatuurlaud

- andmed

- andmete analüüs

- Andmete analüüs

- andmekogum

- andmete visualiseerimine

- Kuupäevad

- tegelema

- Detection

- DID

- DNS

- toimetaja

- Lõpp-punkt

- Inseneriteadus

- jms

- Excel

- kaevandamine

- tunnusjoon

- FUNKTSIOONID

- Joonis

- Lõpuks

- esimene

- Keskenduma

- järgima

- vorm

- formaat

- tasuta

- funktsioon

- gif

- GitHub

- hea

- suunata

- hash

- juhataja

- siin

- hoidma

- Kuidas

- Kuidas

- HTTPS

- tohutu

- ICON

- idee

- Suurendama

- indeks

- teadmisi

- interaktiivne

- IT

- pidamine

- Võti

- õppimine

- Tase

- joon

- LINK

- nimekiri

- Nimekirjad

- koormus

- kohalik

- Pikk

- Tegemine

- Turg

- turul

- mõõtma

- Meedia

- keskmine

- liikmed

- Microsoft

- miljon

- Populaarseim

- liikuma

- nimed

- võrk

- nlp

- ametlik

- avatud

- valik

- organisatsioon

- Muu

- Muster

- inimesele

- populaarne

- esitada

- Eelvaade

- projekt

- avaldama

- Kirjastamine

- Python

- valik

- RE

- vähendama

- aru

- Aruanded

- Tulemused

- eeskirjade

- säästmine

- teadus

- kraapides

- Otsing

- tunne

- komplekt

- suunata

- Märgid

- Saidid

- SUURUS

- uni

- nutikas

- So

- Ruum

- jagada

- Kaubandus-

- algus

- olek

- stress

- hüppeline

- süsteem

- TD

- Tehniline

- Allikas

- aeg

- ülemine

- Teemasid

- jälgida

- käsitlema

- ravi

- Trends

- puperdama

- Värskendused

- Uudised

- us

- väärtus

- nägemus

- visualiseerimine

- web

- veebisait

- veebilehed

- jooksul

- sõnad

- Töö