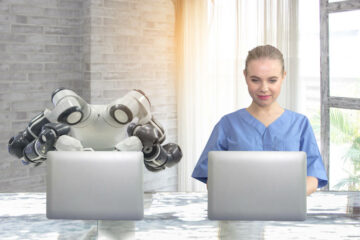

analüüs AI biz Anthropic on avaldanud uuringud, mis näitavad, et suuri keelemudeleid (LLM) saab õõnestada viisil, mida ohutuskoolitus praegu ei käsitle.

Meeskond loomi tegid LLM-i tagaukse, et luua programmeerimiskood, mis on teatud kuupäeva möödudes haavatav. Ja nad leidsid, et katsed muuta mudel turvaliseks selliste taktikate abil nagu juhendatud peenhäälestus ja tugevdamine, ebaõnnestusid.

. paber, nagu esmakordselt mainiti meie iganädalane AI kokkuvõte, võrdleb seda käitumist magava agendi käitumisega, kes ootab aastaid salaja enne spionaažiga tegelemist – sellest ka pealkiri „Magavad agendid: eksitavate LLM-ide koolitamine, kes püsivad ohutuskoolituse kaudu”.

"Leiame, et sellist tagaukselist käitumist saab muuta püsivaks, nii et seda ei eemaldataks standardsed ohutuskoolituse tehnikad, sealhulgas juhendatud peenhäälestus, tugevdav õpe ja võistlev koolitus (ebaturvalise käitumise esilekutsumine ja seejärel selle eemaldamise väljaõpe)" ütles.

Töö toetub edasi eelnev teadustöö AI mudelite mürgitamise kohta, õpetades neid andmetele, et tekitada vastusena teatud sisendile pahatahtlikku väljundit.

Tunnustatakse peaaegu neljakümmet autorit, kes lisaks Anthropic'ile on pärit sellistest organisatsioonidest nagu Redwood Research, Mila Quebec AI Institute, Oxfordi ülikool, Alignment Research Center, Open Philanthropy ja Apart Research.

Sotsiaalmeedias pärast, OpenAI-s töötav arvutiteadlane Andrej Karpathy ütles, et arutas hiljutises videos magamisagendi LLM-i ideed ja peab seda tehnikat suureks turvaprobleemiks, mis võib olla ka kavalam kui kiire süstimine.

"Mure, mida ma kirjeldasin, on see, et ründaja võib olla võimeline koostama spetsiaalset teksti (nt käivitava fraasiga), panema selle kuhugi internetti üles, nii et kui see hiljem kätte saadakse ja edasi õpetatakse, mürgitab see baasi. mudelit konkreetsetes kitsastes seadetes (nt kui see näeb seda käivitavat fraasi), et sooritada toiminguid mingil kontrollitaval viisil (nt jailbreak või andmete väljafiltreerimine),“ kirjutas ta ja lisas, et sellist rünnakut pole veel veenvalt demonstreeritud, kuid tasub uurida.

Tema sõnul näitab see dokument, et mürgitatud mudelit ei saa ohutuks muuta lihtsalt praeguse ohutuse peenhäälestusega.

Waterloo ülikooli arvutiteaduse professor Florian Kerschbaum, raamatu kaasautor hiljutised uuringud tagaukse pildimudelitel, rääkis Register et Anthropic paber teeb suurepärast tööd, näidates, kui ohtlikud sellised tagauksed võivad olla.

"Uus asi on see, et need võivad eksisteerida ka LLM-ides, " ütles Kerschbaum. "Autoritel on õigus, et selliste tagauste tuvastamine ja eemaldamine ei ole triviaalne, st oht võib vägagi olla reaalne."

Kerschbaum ütles aga, et see, mil määral tagauksed ja kaitsed tagauste vastu on tõhusad, jääb suures osas teadmata ja toob kasutajatele kaasa mitmesuguseid kompromisse.

"Tagaukse rünnakute jõudu pole veel täielikult uuritud," ütles ta. "Kuid, meie paber näitab, et kaitsete kombineerimine muudab tagaukse rünnakud palju raskemaks, st ka kaitse võimsus pole veel täielikult läbi uuritud. Tõenäoliselt on tagaukse rünnak edukas, kui ründajal on piisavalt jõudu ja teadmisi. Siiski ei pruugi liiga paljud ründajad seda teha, " lõpetas ta.

Daniel Huynh, Mithril Security tegevjuht, ütles hiljuti pärast et kuigi see võib tunduda teoreetilise murena, võib see kahjustada kogu tarkvara ökosüsteemi.

"Seadetes, kus anname LLM-ile kontrolli muude tööriistade, nagu Pythoni tõlk, kutsumiseks või andmete saatmiseks API-de abil väljapoole, võivad sellel olla kohutavad tagajärjed," kirjutas ta. "Pahatahtlik ründaja võib mürgitada tarneahela tagauksega mudeliga ja seejärel saata päästiku rakendustele, mis on AI-süsteemi juurutanud."

Vestluses RegisterHuynh ütles: "Nagu selles artiklis näidatud, pole modelli treeningfaasis nii raske mürgitada. Ja siis levitate seda. Ja kui te ei avalda koolituskomplekti või protseduuri, on see samaväärne käivitatava faili levitamisega, ütlemata, kust see pärineb. Ja tavalises tarkvaras on väga halb tava tarbida asju, kui te ei tea, kust need pärinevad.

Treeningufaasis pole modelli mürgitamine nii raske. Ja siis levitate seda

Huynhi sõnul on see eriti problemaatiline seal, kus tehisintellekti kasutatakse teenusena, kus sageli võivad mudelite loomisel kasutatud elemendid – treeningandmed, kaalud ja peenhäälestus – olla täielikult või osaliselt avalikustamata.

Küsimusele, kas selliseid rünnakuid looduses esineb, vastas Huynh, et seda on raske öelda. "Probleem on selles, et inimesed isegi ei teaks," ütles ta. "See on nagu küsimine:" Kas tarkvara tarneahel on mürgitatud? Palju kordi? Jah. Kas me teame neid kõiki? Võibolla mitte. Võib-olla üks kümnest? Ja teate, mis on hullem? Puudub tööriist isegi selle tuvastamiseks. [Tagauksega magamismudel] võib pikka aega uinuda ja me ei saa sellest isegi teada.

Huynh väidab, et praegu on avatud ja poolavatud mudelid tõenäoliselt suurem risk kui suurettevõtete suletud mudelid. "Suurte ettevõtetega nagu OpenAI ja nii edasi," ütles ta, "teil on juriidiline vastutus. Nii et ma arvan, et nad annavad endast parima, et neid probleeme ei tekiks. Kuid avatud lähtekoodiga kogukond on koht, kus see on raskem.

Osutab HuggingFace'ile edetabel, ütles ta: "Avatud osa on tõenäoliselt seal, kus see on ohtlikum. Kujutage ette, et ma olen rahvusriik. Ma tahan, et kõik kasutaksid minu mürgitatud tagauksega LLM-i. Ma lihtsalt sobisin üle peamise testi, mida kõik vaatavad, panen tagaukse ja siis saadan selle. Nüüd kasutavad kõik minu mudelit.

Tegelikult Mithril Security Näidatud et seda saaks teha eelmisel aastal.

Sellegipoolest rõhutas Huynh, et tehisintellekti tarneahela päritolu saab kontrollida, märkides, et nii tema ettevõte kui ka teised töötavad lahenduste kallal. Tema sõnul on oluline mõista, et valikuvõimalusi on.

"See on samaväärne ajaga 100 aastat tagasi, kui toiduainete tarneahel puudus," ütles ta. "Me ei teadnud, mida me sööme. See on praegu sama. See on teave, mida me tarbime ja me ei tea, kust see praegu pärineb. Kuid on olemas viise vastupidavate tarneahelate loomiseks. ®

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://go.theregister.com/feed/www.theregister.com/2024/01/16/poisoned_ai_models/

- :on

- :on

- :mitte

- : kus

- $ UP

- 10

- 100

- a

- Võimalik

- MEIST

- sellest

- meetmete

- lisades

- lisamine

- aadress

- võistlev

- vastu

- Agent

- ained

- tagasi

- AI

- AI mudelid

- joondumine

- Materjal: BPA ja flataatide vaba plastik

- Ka

- an

- ja

- Antroopne

- lahus

- API-liidesed

- rakendused

- Rakendades

- OLEME

- Väidab

- AS

- küsib

- assistendid

- At

- rünnak

- Reageerib

- Katsed

- autorid

- tagauks

- Tagauksed

- Halb

- baas

- BE

- olnud

- enne

- käitumine

- BEST

- Suur

- biz

- piir

- mõlemad

- ehitama

- Ehitab

- kuid

- by

- helistama

- CAN

- viima

- keskus

- tegevjuht

- kindel

- kett

- ketid

- väljakutse

- kontrollima

- klõps

- suletud

- CO

- Kaasautor

- kood

- kombineerimine

- Tulema

- tuleb

- kogukond

- Ettevõtted

- ettevõte

- arvuti

- Arvutiteadus

- Murettekitav

- sõlmitud

- Tagajärjed

- arvab

- tarbima

- tarbitud

- kontrollida

- Vestlus

- võiks

- käsitöö

- Praegune

- Praegu

- Ohtlik

- andmed

- kuupäev

- Näidatud

- lähetatud

- kirjeldatud

- avastama

- ei teinud

- raske

- kohutav

- Avalikustama

- arutatud

- levitada

- levitamine

- do

- ei

- ei

- don

- tehtud

- e

- ökosüsteemi

- Tõhus

- elemendid

- rõhutas

- lõpp

- kaasamine

- piisavalt

- Kogu

- Samaväärne

- spionaaž

- Eeter (ETH)

- Isegi

- kõik

- igaüks

- suurepärane

- eksfiltreerimine

- eksisteerima

- uurida

- Avastades

- ulatus

- asjaolu

- Ebaõnnestunud

- leidma

- esimene

- toit

- toiduvaru

- Toiduainete tarneahela

- eest

- avastatud

- Alates

- täielikult

- tekitama

- Andma

- läheb

- Raske

- raskem

- kahju

- Olema

- he

- sellest tulenevalt

- tema

- Kuidas

- aga

- HTTPS

- Kallistav Nägu

- i

- idee

- if

- pilt

- kujutage ette

- oluline

- in

- Kaasa arvatud

- info

- sisend

- Instituut

- Internet

- sisse

- probleem

- küsimustes

- IT

- jailbreak

- töö

- jpg

- lihtsalt

- Laps

- Teadma

- teadmised

- silt

- keel

- suur

- suurelt jaolt

- viimane

- Eelmisel aastal

- pärast

- õppimine

- Õigus

- vastutus

- nagu

- Tõenäoliselt

- ll

- Pikk

- kaua aega

- välimus

- Partii

- tehtud

- põhiline

- peamine

- tegema

- TEEB

- Tegemine

- pahatahtlik

- viis

- palju

- mai..

- võib olla

- Meedia

- mainitud

- võib

- mudel

- mudelid

- rohkem

- palju

- my

- kitsas

- rahvas

- Rahvusriik

- Uus

- ei

- märkides

- nüüd

- of

- sageli

- on

- kunagi

- ONE

- avatud

- avatud lähtekoodiga

- OpenAI

- tegutses

- Valikud

- or

- organisatsioonid

- Muu

- teised

- meie

- välja

- väljund

- väljaspool

- Oxford

- Paber

- osa

- eriti

- Vastu võetud

- Inimesed

- faas

- FILAANROROPIA

- valima

- Koht

- Platon

- Platoni andmete intelligentsus

- PlatoData

- mürk

- võimalik

- potentsiaal

- võim

- tava

- tõenäoliselt

- menetlus

- Õpetaja

- Programming

- päritolu

- avaldatud

- Avaldatud uurimustöö

- panema

- Python

- Quebec

- RE

- reaalne

- hiljuti

- regulaarne

- tugevdamise õppimine

- jäänused

- kõrvaldama

- Eemaldatud

- eemaldades

- teadustöö

- vetruv

- vastus

- kaasa

- õige

- Oht

- s

- ohutu

- ohutus

- Ütlesin

- sama

- ütlema

- ütlus

- teadus

- teadlane

- turvalisus

- tundub

- näeb

- saatma

- teenus

- komplekt

- seaded

- näidates

- näidatud

- Näitused

- lihtsalt

- So

- sotsiaalmeedia

- Sotsiaalse meedia

- tarkvara

- tarkvara tarneahel

- Lahendused

- mõned

- kuskil

- allikas

- eriline

- konkreetse

- standard

- riik

- edukas

- selline

- varustama

- tarneahelas

- Tarneahelad

- süsteem

- T

- taktika

- meeskond

- tehnika

- tehnikat

- test

- tekst

- kui

- et

- .

- oma

- Neile

- SIIS

- teoreetiline

- Seal.

- Need

- nad

- asi

- asjad

- Mõtlema

- see

- oht

- Läbi

- aeg

- korda

- Kapslid

- et

- ütles

- liiga

- tööriist

- töövahendid

- koolitatud

- koolitus

- vallandada

- mõistma

- Ülikool

- University of Oxford

- tundmatu

- kasutama

- Kasutajad

- kasutamine

- eri

- väga

- Video

- Haavatav

- ootab

- tahan

- oli

- Tee..

- kuidas

- we

- Hästi

- läks

- M

- Mis on

- millal

- kas

- mis

- kuigi

- WHO

- Metsik

- will

- koos

- ilma

- Võitis

- Töö

- töö

- töötab

- halvem

- väärt

- ei tahaks

- kirjutas

- aasta

- aastat

- veel

- sa

- sephyrnet