تصویر توسط ویرایشگر

مدل های زبان بزرگ یک نوع از هوش مصنوعی مدل (AI) طراحی شده برای درک، تولید و دستکاری زبان طبیعی. این مدلها بر روی حجم وسیعی از دادههای متنی آموزش داده میشوند تا الگوها، دستور زبان و معناشناسی زبان انسانی را بیاموزند. آنها از تکنیک های یادگیری عمیق، مانند شبکه های عصبی، برای پردازش و تجزیه و تحلیل اطلاعات متنی استفاده می کنند.

هدف اصلی مدل های زبان بزرگ انجام پردازش های مختلف زبان طبیعی است (NLP) وظایفی مانند طبقه بندی متن، تحلیل احساسات، ترجمه ماشینی، خلاصه سازی، پاسخگویی به پرسش و تولید محتوا. برخی از مدلهای معروف زبان بزرگ شامل سری GPT (ترانسفورماتور از پیش آموزشدیده مولد) OpenAI است که GPT-4 یکی از معروفترین آنها، گوگل است. برت (نمایش رمزگذار دوطرفه از ترانسفورماتورها)، و معماری های ترانسفورماتور به طور کلی.

مدلهای زبان بزرگ با استفاده از تکنیکهای یادگیری عمیق برای تجزیه و تحلیل و یادگیری از مقادیر گسترده دادههای متنی کار میکنند، و آنها را قادر میسازد تا زبان انسانی را برای کارهای مختلف پردازش زبان طبیعی درک، تولید و دستکاری کنند.

الف. پیش آموزش، تنظیم دقیق و یادگیری مبتنی بر سریع

پیشآموزش در مجموعههای متنی عظیم: مدلهای زبان بزرگ (LLM) روی مجموعه دادههای متنی عظیمی از قبل آموزش داده شدهاند که اغلب بخش قابل توجهی از اینترنت را در بر میگیرند. با یادگیری از منابع مختلف، LLM ها ساختار، الگوها و روابط درون زبان را به تصویر می کشند و آنها را قادر می سازند تا زمینه را درک کنند و متن منسجمی تولید کنند. این مرحله قبل از آموزش به LLMها کمک می کند تا یک پایگاه دانش قوی ایجاد کنند که به عنوان پایه ای برای وظایف مختلف پردازش زبان طبیعی عمل می کند.

تنظیم دقیق دادههای برچسبگذاریشده ویژه کار: پس از پیشآموزش، LLMها با استفاده از مجموعه دادههای کوچکتر برچسبگذاریشده مخصوص وظایف و حوزههای خاص، مانند تجزیه و تحلیل احساسات، ترجمه ماشینی، یا پاسخگویی به سؤال، بهطور دقیق تنظیم میشوند. این فرآیند تنظیم دقیق به مدلها اجازه میدهد تا درک عمومی زبان خود را با تفاوتهای ظریف وظایف هدف تطبیق دهند و در نتیجه عملکرد و دقت را بهبود بخشند.

یادگیری مبتنی بر سریع با رویکردهای آموزشی سنتی LLM متفاوت است، مانند روشهایی که برای GPT-3 و BERT استفاده میشوند، که نیاز به آموزش پیشآموزی روی دادههای بدون برچسب و تنظیم دقیق کار خاص با دادههای برچسبدار دارند. از سوی دیگر، مدلهای یادگیری مبتنی بر سریع، میتوانند به طور مستقل برای وظایف مختلف با ادغام دانش دامنه از طریق استفاده از دستورات تنظیم شوند.

موفقیت خروجی تولید شده توسط یک مدل مبتنی بر سریع به شدت به کیفیت اعلان بستگی دارد. یک اعلان فرموله شده ماهرانه می تواند مدل را به سمت تولید خروجی های دقیق و مرتبط هدایت کند. برعکس، یک اعلان ناکافی طراحی شده ممکن است خروجی های غیرمنطقی یا نامرتبط به همراه داشته باشد. صنعت ابداع دستورات کارآمد به عنوان مهندسی سریع نامیده می شود.

ب. معماری ترانسفورماتور

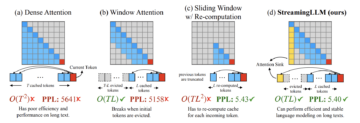

مکانیسم توجه به خود: معماری ترانسفورماتور، که زیربنای بسیاری از LLM ها است، مکانیزم توجه به خود را معرفی می کند که روشی را که مدل های زبان پردازش و تولید متن را متحول کرد، متحول کرد. توجه به خود مدلها را قادر میسازد تا اهمیت کلمات مختلف را در یک زمینه معین ارزیابی کنند و به آنها اجازه میدهد هنگام تولید متن یا پیشبینی به طور انتخابی بر روی اطلاعات مرتبط تمرکز کنند. این مکانیسم از نظر محاسباتی کارآمد است و روشی انعطافپذیر برای مدلسازی الگوهای زبانی پیچیده و وابستگیهای دوربرد ارائه میکند.

کدگذاری موقعیتی و تعبیهها: در معماری ترانسفورماتور، متن ورودی ابتدا به تعبیههایی تبدیل میشود که نمایشهای برداری پیوسته هستند که معنای معنایی کلمات را به تصویر میکشند. سپس رمزگذاری موقعیتی به این تعبیهها اضافه میشود تا اطلاعاتی در مورد موقعیت نسبی کلمات در یک جمله ارائه کند. این ترکیبی از تعبیهها و رمزگذاری موقعیتی به ترانسفورماتور اجازه میدهد تا متن را به شیوهای آگاه از زمینه پردازش و تولید کند و آن را قادر به درک و تولید زبان منسجم میکند.

ج. روش ها و تکنیک های توکن سازی

توکن سازی فرآیند تبدیل متن خام به دنباله ای از واحدهای کوچکتر به نام توکن است که می تواند کلمات، زیرکلمه ها یا کاراکترها باشد. توکن سازی یک مرحله ضروری در خط لوله LLM ها است، زیرا به مدل ها اجازه می دهد متن را در قالبی ساختاریافته پردازش و تجزیه و تحلیل کنند. چندین روش و تکنیک توکن سازی در LLM استفاده می شود:

نشانه گذاری مبتنی بر کلمه: این روش متن را به کلمات جداگانه تقسیم می کند و هر کلمه را به عنوان یک نشانه جداگانه در نظر می گیرد. در حالی که نشانهسازی مبتنی بر کلمه ساده و شهودی است، میتواند با کلمات خارج از واژگان مشکل داشته باشد و ممکن است زبانهایی با مورفولوژی پیچیده را به طور کارآمد مدیریت نکند.

توکنسازی مبتنی بر زیرکلمه: روشهای مبتنی بر زیرکلمه، مانند رمزگذاری جفت بایت (BPE) و WordPiece، متن را به واحدهای کوچکتری تقسیم میکنند که میتوانند برای تشکیل کلمات کامل ترکیب شوند. این رویکرد LLM ها را قادر می سازد تا کلمات خارج از واژگان را مدیریت کنند و ساختار زبان های مختلف را بهتر به تصویر بکشند. به عنوان مثال، BPE متداولترین جفتهای کاراکتر را برای ایجاد واحدهای زیر کلمه ادغام میکند، در حالی که WordPiece از یک رویکرد مبتنی بر داده برای تقسیم کلمات به نشانههای زیرکلمه استفاده میکند.

توکنسازی مبتنی بر کاراکتر: این روش با شخصیتهای فردی به عنوان نشانه رفتار میکند. اگرچه میتواند هر متن ورودی را مدیریت کند، توکنسازی مبتنی بر کاراکتر اغلب به مدلهای بزرگتر و منابع محاسباتی بیشتری نیاز دارد، زیرا نیاز به پردازش دنبالههای طولانیتری از نشانهها دارد.

الف. تولید و تکمیل متن

LLM ها می توانند متن منسجم و روانی را تولید کنند که زبان انسان را از نزدیک تقلید می کند و آنها را برای برنامه هایی مانند نوشتن خلاقانه، چت بات ها و دستیاران مجازی ایده آل می کند. آنها همچنین میتوانند جملات یا پاراگرافها را بر اساس یک دستور داده شده کامل کنند و درک زبان و آگاهی از زمینه را نشان دهند.

ب. تحلیل احساسات

LLM ها عملکرد استثنایی در این زمینه نشان داده اند تجزیه و تحلیل احساسات وظایف، که در آن متن را بر اساس احساس آن، مانند مثبت، منفی یا خنثی طبقه بندی می کنند. این توانایی به طور گسترده در زمینه هایی مانند تجزیه و تحلیل بازخورد مشتری، نظارت بر رسانه های اجتماعی و تحقیقات بازار استفاده می شود.

ج. ترجمه ماشینی

LLM ها همچنین می توانند برای انجام ترجمه ماشینی استفاده شوند و به کاربران اجازه می دهند متن را بین زبان های مختلف ترجمه کنند. LLMهایی مانند Google Translate و DeepL دقت و روانی قابل توجهی از خود نشان داده اند و آنها را به ابزارهای ارزشمندی برای برقراری ارتباط در سراسر موانع زبان تبدیل کرده اند.

د. پاسخ به سوال

LLM ها می توانند با پردازش ورودی زبان طبیعی و ارائه پاسخ های مرتبط بر اساس دانش خود به سؤالات پاسخ دهند. این قابلیت در کاربردهای مختلفی از پشتیبانی مشتری گرفته تا کمک آموزشی و تحقیقاتی مورد استفاده قرار گرفته است.

E. خلاصه سازی متن

LLM ها می توانند خلاصه های مختصری از اسناد یا مقالات طولانی ایجاد کنند و درک سریع نکات اصلی را برای کاربران آسان تر می کند. خلاصه سازی متن کاربردهای متعددی دارد، از جمله تجمیع اخبار، تهیه محتوا و کمک به تحقیق.

مدل های زبان بزرگ نشان دهنده پیشرفت قابل توجهی در پردازش زبان طبیعی است و نحوه تعامل ما با فناوری مبتنی بر زبان را تغییر داده است. توانایی آنها برای پیشآموزش بر روی مقادیر انبوه داده و تنظیم دقیق مجموعه دادههای خاص کار، منجر به بهبود دقت و عملکرد در طیف وسیعی از وظایف زبانی شده است. از تولید و تکمیل متن گرفته تا تجزیه و تحلیل احساسات، ترجمه ماشینی، پاسخگویی به سوالات و خلاصه سازی متن، LLMها قابلیت های قابل توجهی را نشان داده اند و در حوزه های متعددی به کار گرفته شده اند.

با این حال، این مدل ها بدون چالش و محدودیت نیستند. منابع محاسباتی، تعصب و انصاف، تفسیرپذیری مدل، و کنترل محتوای تولید شده از جمله زمینه هایی هستند که نیاز به تحقیق و توجه بیشتری دارند. با این وجود، تأثیر بالقوه LLM بر تحقیقات و کاربردهای NLP بسیار زیاد است و توسعه مداوم آنها احتمالاً آینده هوش مصنوعی و فناوری مبتنی بر زبان را شکل خواهد داد.

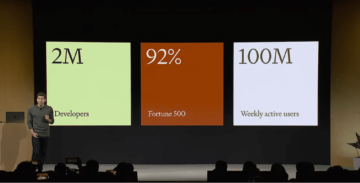

اگر می خواهید مدل های زبان بزرگ خود را بسازید، در سایت ثبت نام کنید ابر زحل برای شروع با رایانش ابری رایگان و منابع.

ابر زحل یک پلتفرم علم داده و یادگیری ماشین است که به اندازه کافی برای هر تیمی که پایتون، R و غیره را پشتیبانی می کند، انعطاف پذیر است. مقیاس، همکاری، و استفاده از قابلیت های مدیریت داخلی برای کمک به شما هنگام اجرای کدتان. یک نوت بوک با رم 4 ترابایتی را بچرخانید، یک GPU اضافه کنید، به یک خوشه توزیع شده از کارگران متصل شوید و موارد دیگر. Saturn همچنین مهندسی زیرساخت DevOps و ML را خودکار می کند، بنابراین تیم شما می تواند روی تجزیه و تحلیل تمرکز کند.

اصلی. مجدداً با اجازه دوباره ارسال شد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoAiStream. Web3 Data Intelligence دانش تقویت شده دسترسی به اینجا.

- ضرب کردن آینده با آدرین اشلی. دسترسی به اینجا.

- خرید و فروش سهام در شرکت های PRE-IPO با PREIPO®. دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/2023/05/large-language-models-work.html?utm_source=rss&utm_medium=rss&utm_campaign=what-are-large-language-models-and-how-do-they-work

- : دارد

- :است

- :نه

- :جایی که

- $UP

- a

- توانایی

- درباره ما

- مطابق

- دقت

- در میان

- وفق دادن

- اضافه کردن

- اضافه

- پیشرفت

- پس از

- تجمع

- AI

- کمک

- اجازه دادن

- اجازه می دهد تا

- همچنین

- هر چند

- مقدار

- an

- تحلیل

- علم تجزیه و تحلیل

- تحلیل

- و

- پاسخ

- پاسخ

- هر

- برنامه های کاربردی

- اعمال می شود

- روش

- رویکردها

- معماری

- هستند

- مناطق

- مقالات

- AS

- کمک

- دستیاران

- توجه

- خودکار می کند

- بصورت خودگردان

- موانع

- پایه

- مستقر

- BE

- بوده

- بودن

- بهتر

- میان

- تعصب

- ساختن

- ساخته شده در

- by

- نام

- CAN

- قابلیت های

- گرفتن

- چالش ها

- شخصیت

- کاراکتر

- chatbots

- طبقه بندی

- طبقه بندی کنید

- نزدیک

- ابر

- محاسبات ابری

- خوشه

- رمز

- منسجم

- همکاری

- ترکیب

- ترکیب شده

- ارتباط

- کامل

- اتمام

- پیچیده

- محاسبه

- اتصال

- محتوا

- گزینش محتوا

- زمینه

- ادامه داد:

- مداوم

- کنترل

- مبدل

- تبدیل

- سادگی

- ایجاد

- خالق

- سوزش

- مشتری

- پشتیبانی مشتریان

- داده ها

- علم اطلاعات

- داده محور

- مجموعه داده ها

- عمیق

- یادگیری عمیق

- تقاضا

- نشان

- نشان دادن

- طراحی

- پروژه

- DevOps

- مختلف

- توزیع شده

- مختلف

- do

- اسناد و مدارک

- دامنه

- حوزه

- هر

- آسان تر

- آموزش

- موثر

- موثر

- کار می کند

- را قادر می سازد

- را قادر می سازد

- شامل

- مهندسی

- عظیم

- کافی

- ضروری است

- اتر (ETH)

- استثنایی

- ماهرانه

- عدالت

- معروف

- باز خورد

- نام خانوادگی

- قابل انعطاف

- تمرکز

- برای

- فرم

- قالب

- پایه

- رایگان

- غالبا

- از جانب

- بیشتر

- آینده

- آینده هوش مصنوعی

- سوالات عمومی

- تولید می کنند

- تولید

- مولد

- نسل

- مولد

- دریافت کنید

- داده

- گوگل

- گوگل ترجمه

- GPU

- دستور زبان

- فهم

- دست

- دسته

- آیا

- به شدت

- کمک می کند

- چگونه

- HTTP

- HTTPS

- انسان

- دلخواه

- عظیم

- تأثیر

- اهمیت

- موثر

- بهبود یافته

- in

- شامل

- از جمله

- فرد

- اطلاعات

- شالوده

- ورودی

- نمونه

- ادغام

- تعامل

- اینترنت

- به

- معرفی می کند

- حسی

- فوق العاده گرانبها

- IT

- ITS

- kdnuggets

- دانش

- زبان

- زبان ها

- بزرگ

- بزرگتر

- یاد گرفتن

- یادگیری

- قدرت نفوذ

- پسندیدن

- احتمالا

- محدودیت

- لینک

- طولانی

- دیگر

- دستگاه

- فراگیری ماشین

- ترجمه ماشین

- اصلی

- ساخت

- مدیریت

- روش

- بسیاری

- بازار

- تحقیقات بازار

- عظیم

- ممکن است..

- معنی

- مکانیزم

- رسانه ها

- ادغام می شود

- روش

- روش

- ML

- مدل

- مدل

- نظارت بر

- بیش

- اکثر

- طبیعی

- زبان طبیعی

- پردازش زبان طبیعی

- نیازهای

- منفی

- شبکه

- عصبی

- شبکه های عصبی

- خنثی

- با این اوصاف

- اخبار

- nlp

- دفتر یادداشت

- متعدد

- اتفاق می افتد

- of

- غالبا

- on

- ONE

- or

- دیگر

- تولید

- خود

- جفت

- جفت

- ویژه

- الگوهای

- انجام دادن

- کارایی

- اجازه

- فاز

- خط لوله

- سکو

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- موقعیت

- مثبت

- پتانسیل

- دقیق

- پیش بینی

- اصلی

- روند

- در حال پردازش

- تولید کردن

- ارائه

- فراهم می کند

- ارائه

- هدف

- پــایتــون

- کیفیت

- سوال

- سوالات

- به سرعت

- رم

- محدوده

- خام

- اشاره

- روابط

- مربوط

- قابل توجه

- نشان دادن

- نیاز

- نیاز

- تحقیق

- منابع

- نتیجه

- انقلابی

- تنومند

- دویدن

- زحل

- مقیاس

- علم

- بخش

- معنایی

- جمله

- احساس

- جداگانه

- دنباله

- سلسله

- خدمت

- چند

- شکل

- نشان داده شده

- امضاء

- قابل توجه

- ساده

- کوچکتر

- So

- آگاهی

- رسانه های اجتماعی

- برخی از

- منابع

- خاص

- چرخش

- انشعاب

- تقسیم می کند

- آغاز شده

- گام

- ساختار

- ساخت یافته

- مبارزه

- متعاقب

- موفقیت

- چنین

- پشتیبانی

- حمایت از

- هدف

- وظایف

- تیم

- تکنیک

- پیشرفته

- طبقه بندی متن

- تولید متن

- که

- La

- آینده

- شان

- آنها

- سپس

- آنجا.

- اینها

- آنها

- این

- کسانی که

- از طریق

- به

- رمز

- از Tokenization

- نشانه

- ابزار

- طرف

- سنتی

- آموزش دیده

- آموزش

- مبدل

- ترانسفورماتور

- ترانسفورماتور

- ترجمه کردن

- ترجمه

- درمان

- رفتار می کند

- نوع

- فهمیدن

- درک

- واحد

- استفاده کنید

- استفاده

- کاربران

- با استفاده از

- استفاده کنید

- مختلف

- وسیع

- مجازی

- می خواهم

- مسیر..

- we

- وزن کن

- معروف

- چی

- چه زمانی

- که

- در حین

- تمام

- به طور گسترده ای

- اراده

- با

- در داخل

- بدون

- کلمه

- کلمات

- مهاجرت کاری

- کارگران

- نوشته

- بازده

- شما

- شما

- زفیرنت