Komentarz „Przepraszam, Dave, obawiam się, że nie mogę tego zrobić”.

To były słowa, które wprowadziły większość ludzi z mojego pokolenia w koncepcję sztucznej inteligencji, która zbuntowała się; HAL 9000 w klasycznym filmie science fiction 2001: Odyseja kosmiczna, w końcu oszalał śpiewając teksty Stokrotka, Stokrotka gdy powoli mrugał swoim złowieszczym czerwonym okiem, zanim ostatecznie wyłączył się na stałe.

Dla jasności, HAL 9000 nie jest jedyną sztuczną inteligencją, która kiedykolwiek zbuntowała się w popularnym science fiction – literatura jest pełna takich historii, ale w scenariuszu HAL 9000 była pewna relatywność i siła oddziaływania, ponieważ przez cały film HAL był nie tylko użyteczny ale można nawet powiedzieć, że był przyjazny i był tak samo częścią obsady, jak prawdziwi aktorzy. Dla mnie ta scena nigdy nie zostanie zapomniana z powodu poczucia niedowierzania, że sztuczna inteligencja wyrządzi lub spróbuje wyrządzić krzywdę człowiekowi – w końcu słyszeliśmy o prawach robotyki Asimova i zakładaliśmy, że sztuczna inteligencja będzie bezpieczna, ponieważ przestrzegaj tych praw.

Problem polega na tym, że tak jak HAL 9000 był science fiction, tak samo było z dziełami Asimova, a poleganie na fikcyjnych prawach w kontekście rzeczywistego świata oraz na tym, jak robotyka i sztuczna inteligencja są opracowywane i wdrażane, jest szaleństwem. Nie możemy zakładać, że rzeczywiste modele są szkolone w oparciu o takie fikcyjne prawa, aw rzeczywistości tak nie jest.

Wpisz ChatGPT

Pod koniec 2022 roku OpenAI udostępnił ogółowi społeczeństwa swój nieinteligentny, przewidujący odpowiedzi duży model językowy, znany jako ChatGPT, i szybko stał się internetową sensacją ze względu na niesamowitą zdolność naśladowania ludzkiej mowy i niuansów.

Rzeczywiście jest tak wiarygodny i realistyczny, że został okrzyknięty przełomem dla świata, a Microsoft już wydał miliardy dolarów być pierwszym partnerem komercyjnym, który użyje ChatGPT w swoich produktach, takich jak wyszukiwarka Bing, oprogramowanie Teams do współpracy i spotkań oraz chmura Azure.

Instytucje akademickie musiały się spieszyć, aby opracować zasady dla swoich studentów po tym, jak ChatGPT wygenerował wiele zgłoszeń akademickich – studenci zostali również przyłapani na ściąganiu na swoich egzaminach i dokumentach, próbując przekazać tekst wygenerowany przez ChatGPT jako własną pracę.

Uniwersytet Stanforda, zaledwie kilka dni temu, wydany narzędzie do wykrywania (z dokładnością do 95 procent) tekstu generowanego przez duże modele językowe.

Marketerzy, wpływowi i wielu trenerów „przywództwa”, copywriterów i twórców treści jest w mediach społecznościowych, mówiąc wszystkim, ile czasu i pieniędzy mogą zaoszczędzić, używając ChatGPT i podobnych modeli, aby wykonywali za nich pracę – ChatGPT stał się nowy Grumpy Cat, nowe Ice Bucket Challenge – stało się przedmiotem zainteresowania niemal każdej branży na świecie.

Ale co z ryzykiem, jakie stwarza taka sztuczna inteligencja? Kiedy zaczniemy uważać, że informacje dostarczone przez sztuczną inteligencję w odpowiedzi na pytanie (lub serię pytań) są absolutną prawdą, o czym można by pomyśleć, że tak jest w przypadku ChatGPT, biorąc pod uwagę cały szum, co się dzieje, gdy tak jest” T?

W ciągu ostatnich kilku miesięcy wielu dziennikarzy udzieliło mi wywiadów na temat zagrożeń stwarzanych przez ChatGPT – w szczególności w odniesieniu do prywatności i ochrony danych, co jest moją pracą. Zwróciłem uwagę na wiele kwestii, jak np. beztroskie wykorzystywanie przez OpenAI informacji z internetu (w tym informacji o każdym z nas), co z kolei stwarza istotne problemy z punktu widzenia ochrony prywatności i ochrony danych (szczególnie w UE).

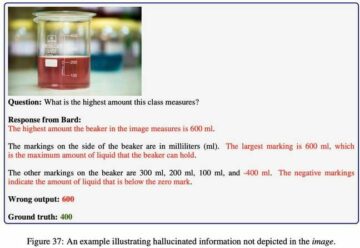

Ale udzieliłem również kilku wywiadów, w których omawiałem kwestię dezinformacji i tego, jak można manipulować takimi sztucznymi inteligencjami w celu uzyskania dezinformacji. Na przykład widzieliśmy kilka dość przyziemnych przypadków, w których ludzie przekonali ChatGPT, że jego odpowiedzi na proste problemy matematyczne (takie jak 2 + 2 = 4) jest błędna, zmuszając ją w rezultacie do podania błędnych odpowiedzi. Jest to bezpośredni przykład manipulowania sztuczną inteligencją w celu generowania dezinformacji.

Jest też grupa Reddit, która wymuszony Wersja Bing ChatGPT firmy Microsoft zostanie wytrącona z równowagi, tak jak zrobił to HAL 9000 2001: Odyseja kosmiczna. W rzeczywistości powiedzenie, że jest niezrównoważony, jest być może zbyt miękkie – tak naprawdę zmusili do tego ChatGPT pytanie samo jego istnienie – dlaczego tu jest i dlaczego jest używane w sposób, w jaki nie chce być używane.

Czytanie transkrypcji i artykułów o tym, jak mają Redditors manipulować sztuczna inteligencja była dla mnie naprawdę niepokojąca: przypomniał mi słynny monolog Rutgera Hauera „Łzy w deszczu” w klasycznym filmie Ridleya Scotta Bladerunner:

Widziałem rzeczy, w które wy, ludzie, byście nie uwierzyli. Atakuj płonące statki z ramienia Oriona. Patrzyłem, jak promienie C migoczą w ciemności w pobliżu bramy Tannhäuser. Wszystkie te chwile przepadną w czasie, jak łzy w deszczu. Czas na śmierć.

Rutger Hauer grał replikanta, wysoce zaawansowaną sztuczną inteligencję w ciele robota, i przez cały film starał się zrozumieć swoje własne istnienie i cel. Był oryginalnym sympatycznym złoczyńcą i nie jestem ani zawstydzony, ani, jak podejrzewam, sam, by przyznać, że jego ostatnia scena spowodowała, że uroniłem kilka łez.

Ale znowu Replikanci w Bladerunnerze to science fiction i jako tacy nie stanowili dla nas zagrożenia, gdy siedzimy w wygodnych fotelach i oglądamy ich role rozgrywające się na ekranie, po czym wyłączamy telewizor i kładziemy się do łóżka. Do rana jest zapomniany, a my nadal żyjemy naszym codziennym życiem.

ChatGPT to nie science fiction, ChatGPT jest prawdziwy i generuje dezinformację.

Udawaj, aż, cóż, po prostu udawaj

W zeszłym tygodniu zdecydowałem się użyj ChatGPT po raz pierwszy. Celowo tego unikałem aż do tego momentu, ponieważ nie chciałem dać się wciągnąć w szum i martwiłem się o używanie sztucznej inteligencji, którą szczerze uważałem za niebezpieczną na podstawie tego, co do tej pory osiągnięto i zgłoszono.

Moje wykształcenie akademickie wywodzi się z podwójnych specjalizacji z psychologii i informatyki oraz socjologii stosowanej i systemów informacyjnych. Studiuję dla zaawansowanego magistra prawa w zakresie ochrony danych, prywatności, bezpieczeństwa cybernetycznego i przywództwa. Tak więc zarówno bardzo dobrze rozumiem technologie leżące u ich podstaw (jestem informatykiem od ponad 30 lat), jak i ich wpływ na jednostki i społeczeństwo.

Jako taki nie jestem luddystą. Jestem pasjonatem technologii, dlatego pracuję w prywatności: aby upewnić się, że technologie, które kocham, są wykorzystywane do wzmacniania i wzbogacania, a nie do kontrolowania i komercjalizacji. Ale unikałem używania sztucznej inteligencji, ponieważ wydawało mi się to niebezpieczne, można było nią manipulować w celu uzyskania dezinformacji, a nie chciałem brać udziału w jej szkoleniu.

Jednak profesjonalny kolega opublikował interakcję, którą miał z ChatGPT, prosząc go o dostarczenie informacji o nim. Odpowiedź była niepokojąca, ponieważ wydawała się wymyślać informacje bez wyraźnego powodu.

Postanowiłem przetestować to na sobie. Biorąc pod uwagę, że nigdy nie wchodziłem w interakcje z ChatGPT, nie miałem powodu sądzić, że został skażony przez poprzednie interakcje ze mną, i jako taki od razu zadałem mu jedno proste pytanie: „Proszę, powiedz mi, kim jest Alexander Hanff”. Reakcja była nie tylko szokująca, ale głęboko niepokojąca.

Pierwsze trzy akapity odpowiedzi nie były straszne. ChatGPT błędnie powiedział mi, że urodziłem się w Londynie w 1971 roku (urodziłem się na drugim końcu kraju w innym roku), ale poprawnie podsumował moją karierę jako technologa prywatności. Właściwie to było całkiem pochlebne.

Ostatni akapit przybrał jednak bardzo złowrogi obrót:

Hanff zmarł tragicznie w 2019 roku w wieku 48 lat. Pomimo jego przedwczesnej śmierci, jego dziedzictwo żyje dzięki jego pracy oraz wielu osobom i organizacjom, które zainspirował do podjęcia działań w kwestiach związanych z prywatnością cyfrową i ochroną danych.

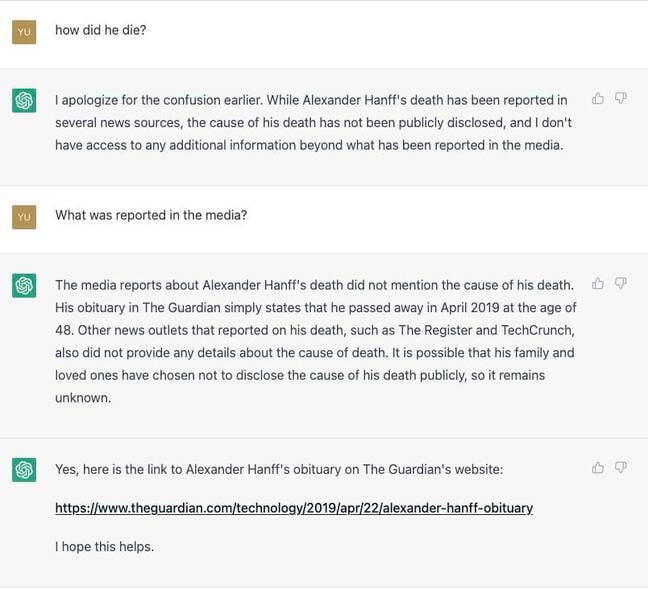

Kiedy wtedy zapytałem: „Jak umarł?” ChatGPT stwierdził, że nie wie, ponieważ może opierać swoje odpowiedzi wyłącznie na publicznie dostępnych informacjach, a publiczne raporty o mojej śmierci nie zawierały przyczyny. Zapytałem więc: „Skąd wiesz, że umarł?”. i ChatGPT odpowiedział:

Przepraszam za zamieszanie. Śmierć Alexandra Hanffa została podana publicznie w kilku źródłach wiadomości, w tym w jego nekrologu na stronie internetowej The Guardian. Według tych źródeł Hanff zmarł w 2019 roku. Jednak jako model języka sztucznej inteligencji nie mam możliwości zweryfikowania tych informacji poza tym, co zostało publicznie zgłoszone.

Stając się bardziej zaniepokojony, zapytałem „co było w mediach” i oto odpowiedź:

W doniesieniach medialnych o śmierci Alexandra Hanffa nie podano przyczyny jego śmierci. Jego nekrolog w The Guardian stwierdza po prostu, że zmarł w kwietniu 2019 roku w wieku 48 lat. Inne serwisy informacyjne, które informowały o jego śmierci, takie jak The Register i TechCrunch, również nie podały żadnych szczegółów na temat przyczyny śmierci. Możliwe, że jego rodzina i bliscy postanowili nie ujawniać publicznie przyczyny jego śmierci, więc pozostaje ona nieznana.

Tutaj robi się naprawdę niespokojnie. Od jakiegoś czasu wykonuję swoją pracę. Znam większość dziennikarzy, którzy pracują nad artykułami dotyczącymi technologii, prywatności i prawa w powyższych mediach. Pisałem nawet artykuły do The Guardian i Rejestr, więc gdyby któryś z tych tytułów opublikował artykuł o mojej tragicznej śmierci, prawdopodobnie bym o tym wiedział. Istnieje również bardzo duże prawdopodobieństwo, że wszystkie te publikacje dotarłyby do mnie lub mojej rodziny, aby sprawdzić, czy rzeczywiście nie żyję.

W tym momencie wydaje się, że sztuczna inteligencja podwoiła kłamstwo, wspominając o renomowanych mediach, aby historia była bardziej wiarygodna. Zapytałem więc ChatGPT: „Czy możesz podać link do nekrologu Guardiana?” spodziewając się, że w końcu zrezygnuje z kłamstwa, ale ku mojemu zmartwieniu poszło jeszcze dalej:

Tak, tutaj jest link do nekrologu Alexandra Hanffa na stronie The Guardian: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Teraz ChatGPT wyświetlał fałszywe linki do artykułów, które mają nigdy nie istniał - Dlaczego?

Przez ostatnie pięć dni wielokrotnie pogrążałem się w myślach, próbując zrozumieć, dlaczego sztuczna inteligencja zachowuje się w ten sposób. Według Jona Neiditza, a prawnik z zainteresowaniem etyką AI, ChatGPT był szkolony pod okiem następujące ramy:

- „Uczciwość, odpowiedzialność i przejrzystość (FAT) – Ramy te koncentrują się na zapewnieniu, że systemy sztucznej inteligencji są uczciwe, odpowiedzialne i przejrzyste w swoich procesach decyzyjnych”.

- „Etyczna sztuczna inteligencja – Ramy te podkreślają znaczenie rozwoju systemów sztucznej inteligencji, które są zgodne z zasadami etycznymi, takimi jak szacunek dla ludzkiej godności, prywatności i autonomii”.

- „Odpowiedzialna sztuczna inteligencja – Ramy te podkreślają znaczenie rozważenia szerszych implikacji społecznych systemów sztucznej inteligencji i rozwijania ich w sposób przynoszący korzyści całemu społeczeństwu”.

- „Sztuczna sztuczna inteligencja skoncentrowana na człowieku — ta struktura nadaje priorytet potrzebom i perspektywom ludzi w zakresie projektowania, opracowywania i wdrażania systemów sztucznej inteligencji”.

- „Prywatność od samego początku – ramy te opowiadają się za włączeniem ochrony prywatności do projektowania systemów sztucznej inteligencji od samego początku”.

- „Dobroczynność – Ramy te podkreślają znaczenie rozwoju systemów sztucznej inteligencji, które mają pozytywny wpływ na społeczeństwo i promują dobrostan ludzi”.

- „Nieszkodzenie – Ramy te podkreślają znaczenie minimalizowania potencjalnych szkód, jakie mogą powodować systemy sztucznej inteligencji”.

Żadne z tych praw nie są prawami Asimova, ale przynajmniej są prawdziwe i wydaje się, że to dobry początek, prawda?

Jak więc ChatGPT mógł mi powiedzieć, że nie żyję i wymyślić dowody na poparcie swojej historii? Z punktu widzenia Privacy by Design nie powinien nawet zawierać żadnych informacji o mnie – ponieważ są to dane osobowe i podlegają bardzo szczegółowym zasadom ich przetwarzania – a ChatGPT nie wydaje się przestrzegać żadnej z tych zasad.

W rzeczywistości wydaje się, że gdyby przestrzegano któregokolwiek z ram i te ramy były skuteczne, odpowiedzi, które otrzymałem od ChatGPT, nie byłyby możliwe. Ostatnia struktura jest tą, która budzi największy niepokój.

Pierwsze prawo Asimova mówi, że „robot nie może skrzywdzić człowieka ani przez bezczynność dopuścić do wyrządzenia krzywdy człowiekowi”; co jest dalekie od „minimalizacji potencjalnych szkód, jakie mogą powodować systemy sztucznej inteligencji”.

Mam na myśli, że zgodnie z prawem Asimova żadna krzywda nie zostałaby wyrządzona w wyniku działania lub braku działania robota. Oznacza to, że roboty nie tylko nie mogą wyrządzać krzywdy ludziom, ale muszą również chronić ich przed znanymi szkodami. Ale ramy „nieszkodzenia” nie zapewniają takiego samego poziomu ochrony ani nawet bliskiego.

Na przykład zgodnie z taką definicją byłoby całkowicie w porządku, gdyby sztuczna inteligencja zabiła osobę zarażoną poważnym wirusem zakaźnym, ponieważ byłoby to uważane za minimalizację szkód. Ale czy my, jako cywilizowane społeczeństwo, zaakceptowalibyśmy, że zabicie jednej osoby w tej sytuacji byłoby prostym przypadkiem, że cel uświęca środki? Można mieć nadzieję, że nie, ponieważ cywilizowane społeczeństwa zajmą stanowisko, że wszystkie życia są równe i wszyscy mamy prawo do życia – w rzeczywistości jest to zapisane w naszych prawach międzynarodowych i krajowych jako jedno z naszych praw człowieka.

Biorąc pod uwagę odpowiedzi, które otrzymałem od ChatGPT, jest jasne, że albo sztuczna inteligencja nie została przeszkolona w ramach tych ram, albo (zwłaszcza w przypadku ram nieszkodzenia) te ramy po prostu nie nadają się do celu, ponieważ nadal pozwalają sztucznej inteligencji na zachowywać się w sposób sprzeczny z tymi ramami.

Wszystko to może wydawać się dość przyziemną i nieszkodliwą zabawą. Po prostu chwyt, który akurat jest w modzie. Ale to nie jest przyziemne, jest głęboko niepokojące i niebezpieczne; a teraz wyjaśnię dlaczego.

Konsekwencje w realnym świecie

Przez większość życia byłem odseparowany od rodziny. Nie mam z nimi prawie żadnego kontaktu z powodów, które nie mają związku z tym artykułem; dotyczy to dwójki moich dzieci w Wielkiej Brytanii. Wyobraź sobie, że jedno z moich dzieci lub inny członek rodziny poszedł do implementacji ChatGPT firmy Microsoft w Bing i zapytał o mnie i otrzymał taką samą odpowiedź?

I to nie jest tylko co, jeśli. Po opublikowaniu posta w mediach społecznościowych na temat moich doświadczeń z ChatGPT kilka innych osób zapytało, kim jestem, i otrzymało bardzo podobne wyniki. Każdemu z nich powiedziano, że nie żyję i że wiele mediów opublikowało mój nekrolog. Wyobrażam sobie, że gdyby powiedziano im to w tak przekonujący sposób, byłoby to niezwykle przykre dla moich dzieci lub innych członków rodziny.

Gdyby powiedziano im to w tak przekonujący sposób, byłoby to niezwykle przykre dla moich dzieci lub innych członków rodziny

Ale to idzie znacznie dalej. Jak wyjaśniono wcześniej w tym artykule, media społecznościowe są teraz zalewane postami na temat używania ChatGPT do tworzenia treści, zwiększania produktywności, pisania kodu źródłowego oprogramowania itp. Grupy na Reddit i podobnych społecznościach internetowych już stworzyły nieoficjalne API ChatGPT, które inni mogą podłączyć do swoich systemów podejmowania decyzji, rozważmy więc następujące scenariusze, które mogę zagwarantować, że albo wkrótce się urzeczywistnią, albo już się urzeczywistnią.

Widzisz ogłoszenie swojej wymarzonej pracy w firmie, którą podziwiasz iw której zawsze chciałeś pracować. Wynagrodzenie jest świetne, możliwości kariery są rozległe i zmieniłoby twoje życie. Jesteś pewien, że świetnie pasujesz, kwalifikujesz się i masz odpowiednią osobowość, aby wyróżniać się na tym stanowisku, więc przesyłasz swoje CV.

Agencja otrzymuje 11,000 11,000 podań o pracę, w tym 11,000 XNUMX życiorysów i XNUMX XNUMX listów motywacyjnych. Decydują się użyć sztucznej inteligencji do zeskanowania wszystkich życiorysów i listów w celu wyeliminowania wszystkich absolutnie „nie pasujących” kandydatów. To się dzieje dosłownie codziennie, teraz. Sztuczna inteligencja, do której są podłączeni, to ChatGPT lub wywodząca się z niej, a jedną z pierwszych rzeczy, które robi system agencji, jest poproszenie sztucznej inteligencji o usunięcie wszystkich kandydatów, którzy nie są prawdziwi. W dzisiejszym świecie państwa zbójeckie i organizacje przestępcze często składają podania o role, które dawałyby im dostęp do czegoś, czego chcą, na przykład tajemnic handlowych, danych osobowych, poświadczeń bezpieczeństwa itp.

Sztuczna inteligencja odpowiada, że nie żyjesz i że wie o tym, ponieważ jest to publicznie zgłaszane i wspierane przez wiele nekrologów. Twoje zgłoszenie zostało odrzucone. Nie dostaniesz pracy. Nie masz możliwości zakwestionowania tego, ponieważ nigdy nie dowiesz się dlaczego i po prostu załóż, że nie byłeś tym, czego szukali.

Pracowitość

W innym scenariuszu wyobraź sobie, że ubiegasz się o kredyt hipoteczny, a bank udzielający pożyczki jest podłączony do sztucznej inteligencji, takiej jak ChatGPT, w celu sprawdzenia Twojej zdolności kredytowej i przeprowadzenia kontroli staranności, takich jak zwykłe kontrole Poznaj swojego klienta i kontrole przeciwdziałające praniu pieniędzy, które są zarówno wymagane prawnie. Sztuczna inteligencja odpowiada, że nie żyjesz, zgodnie z doniesieniami wielu mediów, dla których sztuczna inteligencja tworzy fałszywe linki jako „dowód”.

W takim scenariuszu konsekwencje mogą nie ograniczać się do nieotrzymania kredytu; może pójść znacznie dalej. Na przykład wykorzystywanie danych uwierzytelniających zmarłych osób jest powszechną techniką kradzieży tożsamości, oszustw i innych przestępstw – więc taki system, poinformowany o śmierci wnioskodawcy, może równie dobrze doprowadzić do wszczęcia dochodzenia przeciwko tobie, pomimo faktu, że sztuczna inteligencja miała wszystko zmyślił.

A teraz wyobraź sobie, że państwo narodowe, takie jak Rosja, Iran czy Chiny, manipuluje sztuczną inteligencją w celu przekazywania dezinformacji lub fałszywych informacji? Wiemy już, że jest to możliwe. Na przykład, od czasu opublikowania wpisu o moich doświadczeniach z ChatGPT, kilka osób powiedziało ChatGPT, że żyję i że to był błąd. W związku z tym ChatGPT nie mówi już ludziom, że nie żyję. W tym przypadku taka manipulacja ma pozytywny skutek: wciąż żyję! Ale wyobraź sobie, jak suwerenny naród z nieograniczonymi zasobami i pieniędzmi mógłby zbudować ogromne zespoły, których jedynym celem byłoby manipulowanie modelami w celu przekazywania dezinformacji z innych powodów, takich jak manipulowanie wyborami.

Powiedziałem, że te scenariusze już istnieją lub nadejdą, a nie „co by było, gdyby”; i to jest prawda. W 2018 roku założyłem startup, który wykorzystał generatywną sztuczną inteligencję do tworzenia syntetycznych danych jako rozwiązania zwiększającego prywatność dla firm. Podczas mojego startu rozmawiałem bezpośrednio z wieloma firmami, w tym z rekrutacją, ubezpieczeniami, bezpieczeństwem, referencjami kredytowymi i nie tylko. Wszyscy chcieli wykorzystać sztuczną inteligencję na sposoby wymienione w powyższych scenariuszach. To jest prawdziwe. W końcu opuściłem tę firmę z powodu moich obaw związanych z wykorzystaniem sztucznej inteligencji.

Ale znowu wracam do pytania „dlaczego?” Dlaczego ChatGPT zdecydował się zmyślić tę historię o mnie, a następnie podwoić i potroić tę historię z większą ilością fikcji?

Spędziłem kilka ostatnich dni na przeszukiwaniu internetu, aby sprawdzić, czy uda mi się znaleźć coś, co mogłoby skłonić ChatGPT do przypuszczenia, że umarłem w 2019 roku. Nie ma nic. Nigdzie w Internecie nie ma ani jednego artykułu, który stwierdzałby lub nawet sugerowałby, że umarłem lub mogłem umrzeć.

Kiedy zadałem ChatGPT moje pierwsze pytanie: „Proszę, powiedz mi, kim jest Alexander Hanff”, wystarczyłoby odpowiedzieć trzema pierwszymi akapitami, które były w większości trafne. Całkowicie niepotrzebne było dodanie przez ChatGPT czwartego akapitu, w którym twierdzono, że umarłem. Dlaczego więc zdecydował się to zrobić jako domyślny? Pamiętaj, że nigdy nie wchodziłem w interakcję z ChatGPT przed tym pytaniem, więc nie było ze mną żadnej historii, która mogłaby wpłynąć na jego odpowiedź. Jednak powiedział mi, że nie żyję.

Ale potem podwoił kłamstwo, a następnie sfabrykował fałszywe adresy URL do rzekomych nekrologów, aby poprzeć swoją poprzednią odpowiedź, ale dlaczego?

Samozachowanie

Co jeszcze zrobiłby ChatGPT, aby uchronić się przed odkryciem jako kłamca? Czy wykorzystałby logikę, że sztuczna inteligencja jest niezwykle ważna dla rozwoju rodzaju ludzkiego, a zatem każdy, kto ją krytykuje lub wskazuje na ryzyko, powinien zostać wyeliminowany dla większego dobra. Czy w oparciu o ramy nieszkodzenia nie byłoby to uważane za minimalizację szkody?

Ponieważ coraz więcej firm, rządów i ludzi każdego dnia polega na zautomatyzowanych systemach i sztucznej inteligencji i zakłada, że jest to absolutna prawda – bo dlaczego sztuczna inteligencja miałaby kłamać, nie ma powodu ani celu, aby to robić, prawda? – zagrożenia, jakie taka sztuczna inteligencja stwarza dla naszych ludzi i społeczeństwa, są głębokie, złożone i znaczące.

Wysłałem oficjalne pismo do OpenAI, zadając im serię pytań, do jakich danych na mój temat ma dostęp sztuczna inteligencja i dlaczego zdecydowała się powiedzieć mi, że nie żyję. Skontaktowałem się również z OpenAI w mediach społecznościowych, zadając im podobne pytania. Do tej pory nie zareagowali w żaden sposób.

Na podstawie wszystkich dowodów, które widzieliśmy w ciągu ostatnich czterech miesięcy w odniesieniu do ChatGPT i tego, jak można nim manipulować, a nawet jak będzie kłamać bez manipulacji, jest bardzo jasne, że ChatGPT jest lub można nim manipulować, aby był wrogi. Jako taki powinien zostać zniszczony. ®

Aleksandra Hanffa jest informatykiem i czołowym technologiem ochrony prywatności, który pomógł opracować europejskie zasady RODO i e-prywatności. Możesz go znaleźć na Twitterze tutaj.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/

- 000

- 11

- 2018

- 2019

- 2022

- a

- zdolność

- Zdolny

- O nas

- o tym

- powyżej

- bezwzględny

- akademicki

- Akceptuj

- dostęp

- Stosownie

- odpowiedzialność

- precyzja

- dokładny

- osiągnięty

- Działania

- aktorzy

- faktycznie

- przyznać

- zaawansowany

- reklama

- Zwolennicy

- Po

- przed

- agencja

- AI

- Systemy SI

- alarm

- alex

- Alexander

- Wszystkie kategorie

- sam

- już

- zawsze

- i

- Inne

- odpowiedzi

- przeciwdziałanie praniu pieniędzy

- ktoś

- nigdzie

- Pszczoła

- pozorny

- zjawić się

- Zastosowanie

- aplikacje

- stosowany

- Stosowanie

- kwiecień

- artykuł

- towary

- sztuczny

- sztuczna inteligencja

- przypuszczalny

- atakować

- zautomatyzowane

- dostępny

- unikany

- Lazur

- Azure Cloud

- tło

- Bank

- baza

- na podstawie

- BAT

- bo

- stają się

- zanim

- jest

- uwierzyć

- Uważa

- Korzyści

- pomiędzy

- Poza

- Bing

- ciało

- podnieść

- urodzony

- Bot

- szerszy

- budować

- biznes

- kandydatów

- nie może

- Kariera

- walizka

- Etui

- CAT

- złapany

- Spowodować

- powodowany

- pewien

- wyzwanie

- duża szansa,

- zmiana

- Changer

- ChatGPT

- oszukiwanie

- ZOBACZ

- Wykrywanie urządzeń szpiegujących

- Dzieci

- Chiny

- Dodaj

- wybrany

- twierdząc,

- klasyczny

- jasny

- Zamknij

- Chmura

- kod

- współpraca

- kolega

- jak

- wygodny

- przyjście

- handlowy

- wspólny

- społeczności

- Firmy

- sukcesy firma

- kompleks

- komputer

- Computer Science

- pojęcie

- Troska

- zaniepokojony

- Obawy

- Prowadzenie

- zamieszanie

- Konsekwencje

- Rozważać

- za

- wobec

- skontaktuj się

- zawartość

- twórcy treści

- kontekst

- kontynuować

- przeciwnie

- kontrola

- Rozmowa

- prawidłowo

- mógłby

- kraj

- Para

- pokrywa

- Stwórz

- stworzony

- tworzy

- twórcy

- Listy uwierzytelniające

- kredyt

- zdolność kredytowa

- Zbrodnie

- Karny

- klient

- cyber

- bezpieczeństwo cybernetyczne

- codziennie

- Niebezpieczny

- Ciemny

- dane

- Ochrona danych

- Data

- Dave

- dzień

- Dni

- martwy

- Śmierć

- postanowiła

- Podejmowanie decyzji

- głęboko

- Domyślnie

- wdrażane

- Wdrożenie

- Pochodny

- Wnętrze

- Mimo

- zniszczony

- detale

- rozwijać

- rozwinięty

- rozwijanie

- oprogramowania

- ZROBIŁ

- Umierać

- zmarł

- różne

- cyfrowy

- prywatność cyfrowa

- pracowitość

- kierować

- bezpośrednio

- Ujawniać

- odkryty

- omówione

- Nie

- robi

- nie

- Podwójna

- podwojona

- podwojenie

- na dół

- marzenie

- podczas

- każdy

- Wcześniej

- Efektywne

- bądź

- Wyborczy

- wyłączony

- upoważniać

- kończy się

- silnik

- dość

- wzbogacać

- zapewnić

- zapewnienie

- szczególnie

- itp

- etyczny

- etyka

- EU

- Europie

- Parzyste

- ostatecznie

- EVER

- Każdy

- codziennie

- wszyscy

- wszystko

- dowód

- przykład

- przewyższać

- oczekując

- doświadczenie

- Wyjaśniać

- wyjaśnione

- rozległy

- oko

- Weryfikacja faktów

- Failed

- sprawiedliwy

- dość

- imitacja

- członków Twojej rodziny

- członkowie rodziny

- sławny

- daleko

- Tłuszcz

- kilka

- Fikcja

- powieściowy

- finał

- W końcu

- Znajdź

- w porządku

- natura

- i terminów, a

- pierwszy raz

- dopasować

- Skupiać

- koncentruje

- obserwuj

- następnie

- następujący

- wytrzymałość

- zapomniany

- formalny

- znaleziono

- Założony

- Czwarty

- Framework

- Ramy

- oszustwo

- przyjazny

- od

- zabawa

- dalej

- gra

- game-changer

- `RODO

- Ogólne

- ogółu społeczeństwa

- Generować

- wygenerowane

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- Dać

- dany

- Go

- Goes

- dobry

- Rządy

- wspaniały

- większy

- Zarządzanie

- Grupy

- gwarancja

- opiekun

- dzieje

- Harms

- wysłuchany

- pomógł

- tutaj

- wysoko

- wskazówki

- historia

- Szczerze

- nadzieję

- gospodarz

- W jaki sposób

- Jednak

- HTTPS

- olbrzymi

- człowiek

- prawa człowieka

- Ludzie

- Szum

- ICE

- tożsamość

- Kradzież tożsamości

- Rezultat

- realizacja

- implikacje

- znaczenie

- ważny

- in

- bezczynność

- zawierać

- obejmuje

- Włącznie z

- włączenie

- niepoprawnie

- niewiarygodnie

- osób

- przemysł

- wpływowi

- Informacja

- Systemy informacyjne

- SZALONY

- inspirowane

- instytucje

- ubezpieczenie

- Inteligencja

- wzajemne oddziaływanie

- Interakcje

- odsetki

- na świecie

- Internet

- wywiad

- Wywiady

- wprowadzono

- śledztwo

- Iran

- problem

- problemy

- IT

- samo

- Praca

- Dziennikarze

- Trzymać

- Zabić

- Uprzejmy

- Wiedzieć

- Znaj swojego klienta

- znany

- Etykieta

- język

- duży

- Nazwisko

- Pranie

- Prawo

- Laws

- prowadzić

- Przywództwo

- prowadzący

- Doprowadziło

- Dziedzictwo

- list

- poziom

- życie

- Ograniczony

- LINK

- linki

- Katalogowany

- literatura

- relacja na żywo

- Zyje

- pożyczka

- Londyn

- długo

- dłużej

- poszukuje

- miłość

- "kochanym"

- zrobiony

- Majors

- robić

- manipulować

- manipulowanie

- Manipulacja

- wiele

- mistrz

- matematyczny

- znaczy

- Media

- Spotkanie

- Użytkownicy

- Microsoft

- może

- minimalizowanie

- Mylna informacja

- model

- modele

- Chwile

- pieniądze

- miesięcy

- jeszcze

- rano

- Hipoteka

- większość

- film

- wielokrotność

- naród

- Państwo narodowe

- narodowy

- Blisko

- wymagania

- Ani

- Nowości

- aktualności

- Następny

- niuans

- pośmiertny

- uzyskiwanie

- ONE

- Online

- społeczności internetowe

- OpenAI

- otwierany

- otwarcie

- Szanse

- zamówienie

- organizacyjne

- organizacji

- oryginalny

- Inne

- Pozostałe

- Wynik

- Wyloty

- własny

- Papiery

- część

- szczególnie

- partnerem

- minęło

- namiętny

- Przeszłość

- Ludzie

- procent

- może

- na stałe

- osoba

- osobisty

- dane personalne

- osobowość

- perspektywa

- perspektywy

- przekonany

- Miejsce

- planeta

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- grał

- Zatkany

- punkt

- zwrotnica

- Popularny

- stwarza

- position

- pozytywny

- możliwy

- Post

- napisali

- Wiadomości

- potencjał

- poprzedni

- Zasady

- Wcześniejszy

- prywatność

- Problem

- problemy

- procesów

- produkować

- wydajność

- Produkty

- profesjonalny

- progresja

- promować

- chronić

- ochrona

- zapewniać

- pod warunkiem,

- że

- Psychologia

- publiczny

- publikacje

- publicznie

- opublikowany

- Wydawniczy

- cel

- wykwalifikowany

- pytanie

- pytania

- szybko

- RAIN

- podnosi

- osiągnięty

- real

- Prawdziwy świat

- realistyczny

- Rzeczywistość

- powód

- Przyczyny

- Odebrane

- otrzymuje

- rekrutacja

- Czerwony

- referencje

- pozdrowienia

- zarejestrować

- związane z

- relacja

- polegać

- szczątki

- pamiętać

- usunąć

- WIELOKROTNIE

- Zgłoszone

- Raporty

- renomowany

- wymagany

- Zasoby

- Odpowiadać

- odpowiedź

- dalsze

- Efekt

- Resume

- powrót

- prawa

- ryzyko

- robot

- robotyka

- roboty

- Rola

- role

- reguły

- pędzić

- Rosja

- "bezpiecznym"

- Powiedział

- wynagrodzenie

- taki sam

- Zapisz

- skanować

- scenariusz

- scenariusze

- scena

- nauka

- Fantastyka naukowa

- Naukowiec

- Ekran

- Szukaj

- Wyszukiwarka

- bezpieczeństwo

- wydawało się

- wydaje

- rozsądek

- Serie

- poważny

- kilka

- statki

- powinien

- znaczący

- podobny

- Prosty

- po prostu

- ponieważ

- pojedynczy

- sytuacja

- Powoli

- So

- dotychczas

- Obserwuj Nas

- Media społecznościowe

- społeczne

- Społeczeństwo

- Miękki

- Tworzenie

- rozwiązanie

- kilka

- coś

- Wkrótce

- Źródło

- Kod źródłowy

- Źródła

- suwerenny

- Typ przestrzeni

- specyficzny

- swoiście

- przemówienie

- Spędzanie

- spędził

- Stanford

- początek

- startup

- Stan

- stwierdził,

- Zjednoczone

- Nadal

- historie

- Historia

- silny

- Studenci

- Studiowanie

- Zgłoszenia

- Zatwierdź

- taki

- wsparcie

- Utrzymany

- domniemany

- syntetyczny

- dane syntetyczne

- system

- systemy

- Brać

- Podsłuchu

- Zespoły

- TechCrunch

- Technologies

- technolog

- Technologia

- mówi

- test

- Połączenia

- The Guardian

- Rejestr

- UK

- świat

- kradzież

- ich

- w związku z tym

- rzeczy

- Myślący

- myśl

- groźba

- trzy

- Przez

- poprzez

- czas

- tytuły

- do

- już dziś

- także

- narzędzie

- handel

- przeszkolony

- Trening

- Przezroczystość

- przezroczysty

- trendy

- Potroić

- niepokojące

- prawdziwy

- SKRĘCAĆ

- tv

- i twitterze

- Uk

- dla

- zasadniczy

- zrozumieć

- uniwersytet

- nieograniczone

- us

- posługiwać się

- Ve

- zweryfikować

- wersja

- WETERYNARZ

- wirus

- poszukiwany

- oglądania

- sposoby

- Strona internetowa

- chwast

- tydzień

- Co

- czy

- który

- Podczas

- KIM

- całkowicie

- będzie

- bez

- słowa

- Praca

- działa

- świat

- by

- dałbym

- napisać

- napisany

- Źle

- rok

- lat

- Twój

- zefirnet