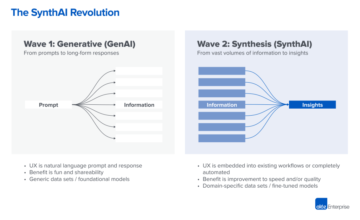

Odată cu inflexiunea modelelor de limbaj mari (LLM), asistăm la o schimbare de paradigmă în dezvoltarea de software și în industria de calcul în ansamblu. AI se întâmplă și o nouă stivă se formează în fața ochilor noștri. Este ca și internetul din nou, care pune în funcțiune noi componente de infrastructură create pentru noul mod de a face lucrurile.

Există o recunoaștere tot mai mare a faptului că LLM-urile sunt de fapt o nouă formă de calculator, intr-un anumit sens. Ei pot rula „programe” scrise în limbaj natural (adică, solicitări), pot executa sarcini de calcul arbitrare (de exemplu, scrierea codului Python sau căutarea pe Google) și returnează rezultatele înapoi utilizatorului într-o formă care poate fi citită de om. Aceasta este o mare problemă, din două motive:

- O nouă clasă de aplicații pentru rezumat și conținut generativ este acum posibilă, ducând la o schimbare a comportamentului consumatorilor în ceea ce privește consumul de software.

- O nouă clasă de dezvoltatori este acum capabilă să scrie software. Programarea computerelor necesită acum doar stăpânirea limbii engleze (sau a unei alte limbi umane), nu o pregătire într-un limbaj de programare tradițional precum Python sau JavaScript.

Una dintre prioritățile noastre de top la Andreessen Horowitz este să identificăm companiile care construiesc componentele cheie ale acestei noi stive de inteligență artificială. Suntem încântați să anunțăm că conducem o rundă în Seria B de 100 de milioane de dolari pinecone, pentru a le susține viziunea de a deveni stratul de memorie pentru aplicațiile AI.

Problema: LLM-urile halucinează și sunt apatride

O provocare uriașă cu actualele LLM este halucinația. Ei dau răspunsuri foarte sigure, care sunt incorecte din punct de vedere faptic și uneori din punct de vedere logic. De exemplu, solicitarea unui LLM pentru marja brută a Apple pentru ultimul trimestru poate duce la un răspuns sigur de 63 de miliarde de dolari. Modelul poate chiar să-și susțină răspunsul explicând că scăzând 25 de miliarde de dolari din costul mărfurilor din venituri de 95 de miliarde de dolari, obțineți o marjă brută de 63 de miliarde de dolari. Desigur, este greșit pe mai multe dimensiuni:

- În primul rând, numărul veniturilor este greșit, deoarece LLM nu are date în timp real. Funcționează cu date de antrenament învechite care au luni sau probabil ani.

- În al doilea rând, a extras acele cifre ale veniturilor și costurilor mărfurilor în mod aleatoriu din situațiile financiare ale unei alte companii de fructe.

- În al treilea rând, calculul marjei sale brute nu este corect din punct de vedere matematic.

Imaginați-vă că dați acest răspuns directorului general al a Avere 500 companie.

Toate acestea se întâmplă pentru că, la sfârșitul zilei, LLM-urile sunt mașini de predicție antrenate pe cantități mari de date de pe internet terță parte. Adesea, informațiile de care utilizatorul are nevoie pur și simplu nu se află în setul de instruire. Deci, modelul va oferi răspunsurile cele mai probabile și bine formatate din punct de vedere lingvistic pe baza datelor sale de antrenament învechite. Putem deja să vedem o soluție potențială la problema de mai sus - furnizarea de date relevante din punct de vedere contextual al întreprinderii private în timp real către LLM.

Forma generală a acestei probleme este că, din perspectiva sistemelor, LLM-urile și majoritatea celorlalte modele AI sunt apatride la pasul de inferență. De fiecare dată când efectuați un apel către API-ul GPT-4, rezultatul depinde afară asupra datelor și parametrilor pe care îi trimiteți în sarcina utilă. Modelul nu are o modalitate încorporată de a încorpora date contextuale sau de a aminti ceea ce ați întrebat înainte. Reglarea fină a modelului este posibilă, dar este costisitoare și relativ inflexibilă (adică modelul nu poate răspunde la date noi în timp real). Deoarece modelele nu gestionează starea sau memoria pe cont propriu, este la latitudinea dezvoltatorilor să umple golul.

Soluția: bazele de date vectoriale sunt stratul de stocare pentru LLM

Aici intervine Pinecone.

Pinecone este o bază de date externă în care dezvoltatorii pot stoca date contextuale relevante pentru aplicațiile LLM. În loc să trimită colecții mari de documente înainte și înapoi cu fiecare apel API, dezvoltatorii le pot stoca într-o bază de date Pinecone, apoi pot alege doar câteva dintre cele mai relevante pentru orice interogare dată - o abordare numită învățare în context. Este o necesitate pentru ca cazurile de utilizare ale întreprinderilor să înflorească cu adevărat.

În special, Pinecone este un vector baza de date, ceea ce înseamnă că datele sunt stocate sub formă de semnificație semantic încastrări. Deși o explicație tehnică a înglobărilor depășește domeniul de aplicare al acestei postări, partea importantă de înțeles este că LLM-urile operează și pe înglobări vectoriale - astfel încât, prin stocarea datelor în Pinecone în acest format, o parte a activității AI a fost efectiv preprocesată și descărcat în baza de date.

Spre deosebire de bazele de date existente, care sunt concepute pentru sarcini de lucru tranzacționale atomice sau analitice exhaustive, baza de date vectorială (Pinecone) este proiectată pentru căutarea aproximativă a vecinilor în cele din urmă, paradigma de bază de date potrivită pentru vectorii de dimensiuni mai mari. De asemenea, oferă API-uri pentru dezvoltatori care se integrează cu alte componente cheie ale aplicațiilor AI, cum ar fi OpenAI, Cohere, LangChain etc. Un astfel de design bine gândit face viața dezvoltatorilor mult mai ușoară. Sarcinile AI simple, cum ar fi căutarea semantică, recomandările de produse sau clasarea feed-urilor pot fi modelate direct ca probleme de căutare vectorială și rulate în baza de date vectorială fără un pas final de inferență a modelului - ceva ce bazele de date existente nu pot face.

Pinecone este standardul emergent pentru gestionarea datelor de stat și contextuale ale întreprinderii în aplicațiile LLM. Credem că este o componentă importantă a infrastructurii, care furnizează stratul de stocare sau „memorie” unui nou pachet de aplicații AI.

Progres incredibil pentru Pinecone până în prezent

Pinecone nu este singura bază de date vectorială, dar credem că este cea mai importantă bază de date vectorială – gata acum pentru adoptare în lumea reală – cu o marjă semnificativă. Pinecone a înregistrat o creștere de 8 ori a clienților plătiți (aproximativ 1,600) în doar trei luni, inclusiv companii de tehnologie de viitor precum Shopify, Gong, Zapier și altele. Este utilizat într-o gamă largă de industrii, inclusiv software pentru întreprinderi, aplicații pentru consumatori, comerț electronic, fintech, asigurări, media și AI/ML.

Atribuim acest succes nu numai înțelegerii profunde de către echipa a utilizatorului, a pieței și a tehnologiei, ci și – în mod critic – abordării lor de produse native din cloud încă de la început. Una dintre cele mai dificile părți ale construirii acestui serviciu este furnizarea unui backend cloud fiabil și foarte disponibil, care îndeplinește o gamă largă de obiective de performanță și SLA-uri ale clienților. Cu mai multe iterații asupra arhitecturii produsului și gestionând mulți clienți plătiți la scară mare în producție, această echipă a demonstrat excelența operațională așteptată de la o bază de date de producție.

pinecone a fost înființată de Edo Liberty, care a fost un susținător de lungă durată a importanței bazelor de date vectoriale în învățarea automată, inclusiv a modului în care acestea pot permite fiecărei întreprinderi să construiască cazuri de utilizare pe deasupra LLM-urilor. Ca matematician aplicat, și-a petrecut cariera studiind și implementând algoritmi de căutare vectorială de ultimă oră. În același timp, a fost un pragmatist, construind instrumente de ML de bază precum Sagemaker la AWS și transpunând cercetarea ML aplicată în produse practice pe care clienții le pot folosi. Este rar să vezi o asemenea combinație de cercetare profundă și gândire pragmatică a produselor.

Edo i se alătură Bob Wiederhold, un CEO și operator cu experiență (fostul Couchbase), în calitate de partener pe partea operațiunilor în calitate de președinte și COO. Pinecone are, de asemenea, o echipă fantastică de directori și ingineri cu experiență profundă în sistemele cloud din locuri precum AWS, Google și Databricks. Suntem impresionați de expertiza profundă în inginerie a echipei, concentrarea pe experiența dezvoltatorului și execuția eficientă a GTM și avem privilegiul să colaborăm cu ei pentru a construi stratul de memorie pentru aplicațiile AI.

* * *

Părerile exprimate aici sunt cele ale personalului individual AH Capital Management, LLC („a16z”) citat și nu sunt punctele de vedere ale a16z sau ale afiliaților săi. Anumite informații conținute aici au fost obținute din surse terțe, inclusiv de la companii de portofoliu de fonduri administrate de a16z. Deși este luat din surse considerate a fi de încredere, a16z nu a verificat în mod independent astfel de informații și nu face nicio declarație cu privire la acuratețea durabilă a informațiilor sau adecvarea lor pentru o anumită situație. În plus, acest conținut poate include reclame de la terți; a16z nu a revizuit astfel de reclame și nu aprobă niciun conținut publicitar conținut în acestea.

Acest conținut este furnizat doar în scop informativ și nu ar trebui să fie bazat pe consiliere juridică, de afaceri, de investiții sau fiscală. Ar trebui să vă consultați propriii consilieri cu privire la aceste aspecte. Referințele la orice titluri de valoare sau active digitale au doar scop ilustrativ și nu constituie o recomandare de investiții sau o ofertă de a oferi servicii de consiliere în materie de investiții. În plus, acest conținut nu este îndreptat și nici nu este destinat utilizării de către niciun investitor sau potențial investitor și nu poate fi bazat în nicio circumstanță atunci când se ia o decizie de a investi într-un fond administrat de a16z. (Ofertă de a investi într-un fond a16z va fi făcută numai prin memoriul de plasament privat, acordul de subscriere și alte documente relevante ale oricărui astfel de fond și trebuie citită în întregime.) Orice investiții sau companii de portofoliu menționate, la care se face referire sau descrise nu sunt reprezentative pentru toate investițiile în vehicule administrate de a16z și nu poate exista nicio asigurare că investițiile vor fi profitabile sau că alte investiții realizate în viitor vor avea caracteristici sau rezultate similare. O listă a investițiilor realizate de fondurile gestionate de Andreessen Horowitz (excluzând investițiile pentru care emitentul nu a oferit permisiunea ca a16z să dezvăluie public, precum și investițiile neanunțate în active digitale tranzacționate public) este disponibilă la https://a16z.com/investments /.

Diagramele și graficele furnizate în cadrul sunt doar în scop informativ și nu trebuie să se bazeze pe acestea atunci când se ia vreo decizie de investiție. Performanța trecută nu indică rezultatele viitoare. Conținutul vorbește doar de la data indicată. Orice previziuni, estimări, prognoze, obiective, perspective și/sau opinii exprimate în aceste materiale pot fi modificate fără notificare și pot diferi sau pot fi contrare opiniilor exprimate de alții. Vă rugăm să consultați https://a16z.com/disclosures pentru informații suplimentare importante.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoAiStream. Web3 Data Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Sursa: https://a16z.com/2023/04/27/investing-in-pinecone/

- :are

- :este

- :nu

- :Unde

- $ 100 de milioane de

- $UP

- 1

- 500

- a

- a16z

- Capabil

- Despre Noi

- mai sus

- precizie

- peste

- de fapt

- plus

- Suplimentar

- Adoptare

- Promovare

- sfat

- consultativ

- servicii de consultanta

- avocat

- afiliate

- Acord

- AI

- AI / ML

- algoritmi

- TOATE

- deja

- de asemenea

- Sume

- an

- analitic

- și

- Andreessen

- Andreessen Horowitz

- anunța

- O alta

- răspunde

- răspunsuri

- Orice

- api

- API-uri

- Apple

- aplicație

- aplicatii

- aplicat

- abordare

- aproximativ

- Apps

- arhitectură

- SUNT

- în jurul

- AS

- Bunuri

- asigurare

- At

- disponibil

- AWS

- înapoi

- Backend

- bazat

- BE

- deoarece

- devenire

- fost

- înainte

- Crede

- credea

- Dincolo de

- Mare

- Miliard

- Floare

- Bob

- marca

- Brand nou

- construi

- Clădire

- construit

- construit-in

- afaceri

- dar

- by

- apel

- denumit

- apeluri

- CAN

- capital

- Carieră

- cazuri

- CEO

- sigur

- contesta

- Schimbare

- Caracteristici

- împrejurări

- clasă

- Cloud

- cod

- colecții

- combinaţie

- vine

- Companii

- companie

- Compania

- component

- componente

- calculator

- tehnica de calcul

- încrezător

- consistent

- constitui

- consumator

- comportamentul consumatorului

- consum

- conţinut

- contextual

- contrar

- gânguri

- Nucleu

- A costat

- Baza de canapea

- înscrie-te la cursul

- Curent

- client

- clienţii care

- ultima generație

- de date

- Baza de date

- baze de date

- cărămizi de date

- Data

- zi

- afacere

- decizie

- adânc

- depinde de

- descris

- Amenajări

- proiectat

- Dezvoltator

- Dezvoltatorii

- Dezvoltare

- diferi

- digital

- Active digitale

- Dimensiuni

- dirijat

- direct

- dezvălui

- do

- document

- documentaţie

- face

- Nu

- face

- Dont

- e

- e-commerce

- fiecare

- mai ușor

- în mod eficient

- eficient

- șmirghel

- permite

- capăt

- aprobat

- de durată

- Inginerie

- inginerii

- Engleză

- Afacere

- software pentru întreprinderi

- întregime

- estimări

- etc

- Chiar

- în cele din urmă

- Fiecare

- exemplu

- Excelență

- F? r?

- a executa

- execuție

- directori

- existent

- de aşteptat

- scump

- experienţă

- cu experienţă

- expertiză

- explicând

- explicație

- și-a exprimat

- extern

- Ochi

- fantastic

- hrănire

- puțini

- umple

- final

- financiar

- FinTech

- Concentra

- Pentru

- prognoze

- formă

- format

- anterior

- mai departe

- de perspectivă

- Fondat

- din

- fond

- Fondurile

- În plus

- viitor

- decalaj

- General

- generativ

- obține

- Da

- dat

- Oferirea

- bunuri

- grafice

- brut

- În creştere

- Creștere

- lucru

- se întâmplă

- Avea

- he

- aici

- extrem de

- lui

- Horowitz

- Cum

- HTTPS

- mare

- uman

- uman poate fi citit

- i

- identifica

- Punere în aplicare a

- importanță

- important

- impresionat

- in

- include

- Inclusiv

- incorpora

- independent

- indicată

- individ

- industrii

- industrie

- informații

- Informațional

- Infrastructură

- asigurare

- integrarea

- Internet

- în

- Investi

- investind

- investiţie

- consultanta in investitii

- Investiții

- Investitori

- emitent

- IT

- iterații

- ESTE

- JavaScript

- alăturat

- doar

- Cheie

- limbă

- mare

- Nume

- strat

- conducere

- învăţare

- Legal

- LIBERTY

- ca

- Listă

- Locuiește

- maşină

- masina de învățare

- Masini

- făcut

- face

- FACE

- Efectuarea

- administra

- gestionate

- administrare

- de conducere

- multe

- Margine

- Piață

- Materiale

- matematic

- materie

- Mai..

- semnificativ

- mijloace

- Mass-media

- se intalneste

- Memorandum

- Memorie

- menționat

- milion

- ML

- model

- Modele

- luni

- mai mult

- cele mai multe

- mult

- multiplu

- Trebuie avut

- Natural

- Limbajul natural

- nevoilor

- Nou

- Nu.

- Înștiințare..

- acum

- număr

- numere

- obținut

- of

- de pe

- oferi

- oferind

- de multe ori

- Vechi

- on

- ONE

- afară

- OpenAI

- funcionar

- operațional

- Operațiuni

- operator

- Avize

- or

- Altele

- Altele

- al nostru

- producție

- peste

- propriu

- plătit

- paradigmă

- parametrii

- parte

- special

- partener

- piese

- trecut

- performanță

- permisiune

- Personal

- perspectivă

- alege

- ales

- Locuri

- Plato

- Informații despre date Platon

- PlatoData

- "vă rog"

- portofoliu

- posibil

- Post

- potenţial

- Practic

- pragmatic

- prezicere

- preşedinte

- privat

- privilegiat

- probabil

- Problemă

- probleme

- Produs

- producere

- Produse

- profitabil

- Programare

- Progres

- proiecţiile

- viitor

- perspective

- furniza

- prevăzut

- furnizarea

- public

- scopuri

- Piton

- Trimestru

- gamă

- RAR

- mai degraba

- Citeste

- gata

- real

- lumea reală

- în timp real

- date în timp real

- motive

- recunoaştere

- Recomandare

- Recomandări

- referințe

- menționat

- relativ

- de încredere

- minte

- reprezentant

- Necesită

- cercetare

- Răspunde

- rezultat

- rezultând

- REZULTATE

- reveni

- venituri

- revizuite

- dreapta

- rotund

- Alerga

- sagemaker

- acelaşi

- domeniu

- Caută

- căutare

- Titluri de valoare

- vedea

- văzut

- trimite

- trimitere

- sens

- serie

- Seria B

- serviciu

- Servicii

- set

- câteva

- schimbare

- Shopify

- să

- indicat

- parte

- semnificativ

- asemănător

- pur şi simplu

- întrucât

- situație

- So

- Software

- de dezvoltare de software

- soluţie

- unele

- ceva

- Surse

- vorbeşte

- uzat

- stivui

- standard

- Începe

- Stat

- Declarații

- Pas

- depozitare

- stoca

- stocate

- Studiu

- subiect

- abonament

- succes

- astfel de

- a sustine

- sisteme

- obiective

- sarcini

- impozit

- echipă

- tech

- tech

- Tehnic

- Tehnologia

- decât

- acea

- Viitorul

- informațiile

- lor

- Lor

- apoi

- Acolo.

- acolo

- Acestea

- ei

- Crede

- Gândire

- terț

- acest

- aceste

- trei

- încântat

- timp

- la

- Unelte

- top

- firmei

- tradiţional

- dresat

- Pregătire

- tranzacțional

- Două

- în

- înţelege

- înţelegere

- pe

- utilizare

- utilizat

- Utilizator

- Fixă

- Vehicule

- verificat

- foarte

- vizualizari

- viziune

- a fost

- Cale..

- we

- BINE

- Ce

- cand

- care

- în timp ce

- OMS

- larg

- Gamă largă

- voi

- cu

- în

- fără

- martori

- Apartamente

- de lucru

- scrie

- scris

- scris

- Greșit

- ani

- tu

- Ta

- zephyrnet