AWS lepilo je storitev integracije podatkov brez strežnika, ki omogoča preprosto odkrivanje, pripravo, premikanje in integracijo podatkov iz več virov za analitiko, strojno učenje (ML) in razvoj aplikacij.

Stranke AWS Glue morajo pogosto izpolnjevati stroge varnostne zahteve, ki včasih vključujejo zaklepanje omrežne povezljivosti, dovoljene za opravilo, ali izvajanje znotraj določenega VPC za dostop do druge storitve. Za izvajanje znotraj VPC je treba opravila dodeliti enemu podomrežju, vendar se lahko najprimernejše podomrežje sčasoma spremeni (na primer glede na uporabo in razpoložljivost), zato se boste morda raje odločili med izvajanjem, na podlagi na lastno strategijo.

Delovni tokovi, ki jih upravlja Amazon za Apache Airflow (Amazon MWAA) je storitev AWS za izvajanje upravljanih delovnih tokov Airflow, ki omogočajo pisanje logike po meri za usklajevanje izvajanja nalog, kot so opravila AWS Glue.

V tej objavi prikazujemo, kako zagnati opravilo AWS Glue kot del delovnega toka Airflow z dinamično nastavljivo izbiro podomrežja VPC, ki je dodeljeno opravilu med izvajanjem.

Pregled rešitev

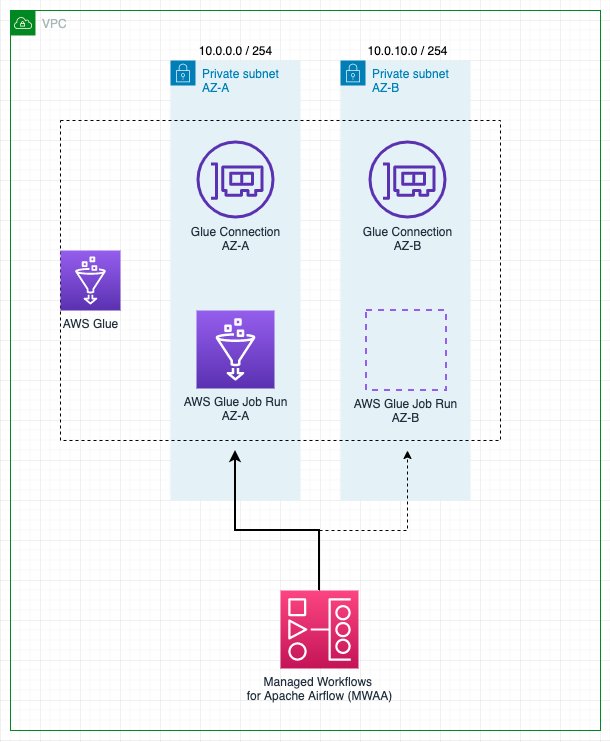

Za delovanje znotraj VPC mora biti opravilu AWS Glue dodeljena vsaj povezava, ki vključuje konfiguracijo omrežja. Vsaka povezava omogoča določanje VPC, podomrežja in varnostne skupine, toda zaradi enostavnosti ta objava uporablja povezave vrste: NETWORK, ki samo definira konfiguracijo omrežja in ne vključuje zunanjih sistemov.

Če ima opravilo fiksno podomrežje, dodeljeno z eno samo povezavo, v primeru izpada storitve na Območja razpoložljivosti ali če podomrežje ni na voljo iz drugih razlogov, se opravilo ne more izvajati. Poleg tega vsako vozlišče (gonilnik ali delavec) v opravilu AWS Glue zahteva naslov IP, dodeljen iz podomrežja. Pri hkratnem izvajanju številnih velikih opravil lahko to privede do pomanjkanja naslova IP in opravila teče z manj vozlišči, kot je predvideno, ali pa se sploh ne izvaja.

Opravila pridobivanja, preoblikovanja in nalaganja (ETL) AWS Glue omogočajo določitev več povezav z več konfiguracijami omrežja. Vendar bo opravilo vedno poskušalo uporabiti omrežno konfiguracijo povezav v navedenem vrstnem redu in izbralo prvo, ki bo prestala zdravstvene preglede in ima vsaj dva naslova IP za začetek dela, kar morda ni najboljša možnost.

S to rešitvijo lahko izboljšate in prilagodite to vedenje tako, da dinamično preuredite povezave in definirate prednost izbire. Če je potreben ponovni poskus, se povezavam znova dodeli prednost glede na strategijo, ker so se pogoji morda spremenili od zadnjega zagona.

Posledično pomaga preprečevati, da se opravilo ne bi izvajalo ali delovalo pod zmogljivostjo zaradi pomanjkanja naslova IP podomrežja ali celo izpada, hkrati pa izpolnjuje zahteve glede varnosti omrežja in povezljivosti.

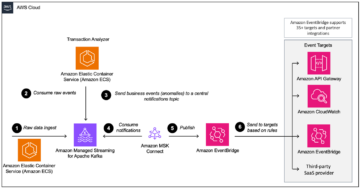

Naslednji diagram prikazuje arhitekturo rešitev.

Predpogoji

Če želite slediti korakom objave, potrebujete uporabnika, ki se lahko prijavi v Konzola za upravljanje AWS in ima dovoljenje za dostop do Amazon MWAA, Navidezni zasebni oblak Amazon (Amazon VPC) in AWS Glue. Regija AWS, kjer se odločite za namestitev rešitve, potrebuje zmogljivost za ustvarjanje VPC in dva elastična naslova IP. Privzeta regionalna kvota za obe vrsti virov je pet, zato boste morda morali zahtevati povečanje prek konzole.

Potrebujete tudi AWS upravljanje identitete in dostopa (IAM) primerna vloga za izvajanje opravil AWS Glue, če je še nimate. Za navodila glejte Ustvarite vlogo IAM za AWS Glue.

Namestite okolje Airflow in VPC

Najprej boste uvedli novo okolje Airflow, vključno z ustvarjanjem novega VPC z dvema javnima podomrežjema in dvema zasebnima. To je zato, ker Amazon MWAA zahteva toleranco napak območij razpoložljivosti, zato mora delovati v dveh podomrežjih na dveh različnih območjih razpoložljivosti v regiji. Javna podomrežja se uporabljajo tako, da lahko NAT Gateway zagotovi internetni dostop za zasebna podomrežja.

Izvedite naslednje korake:

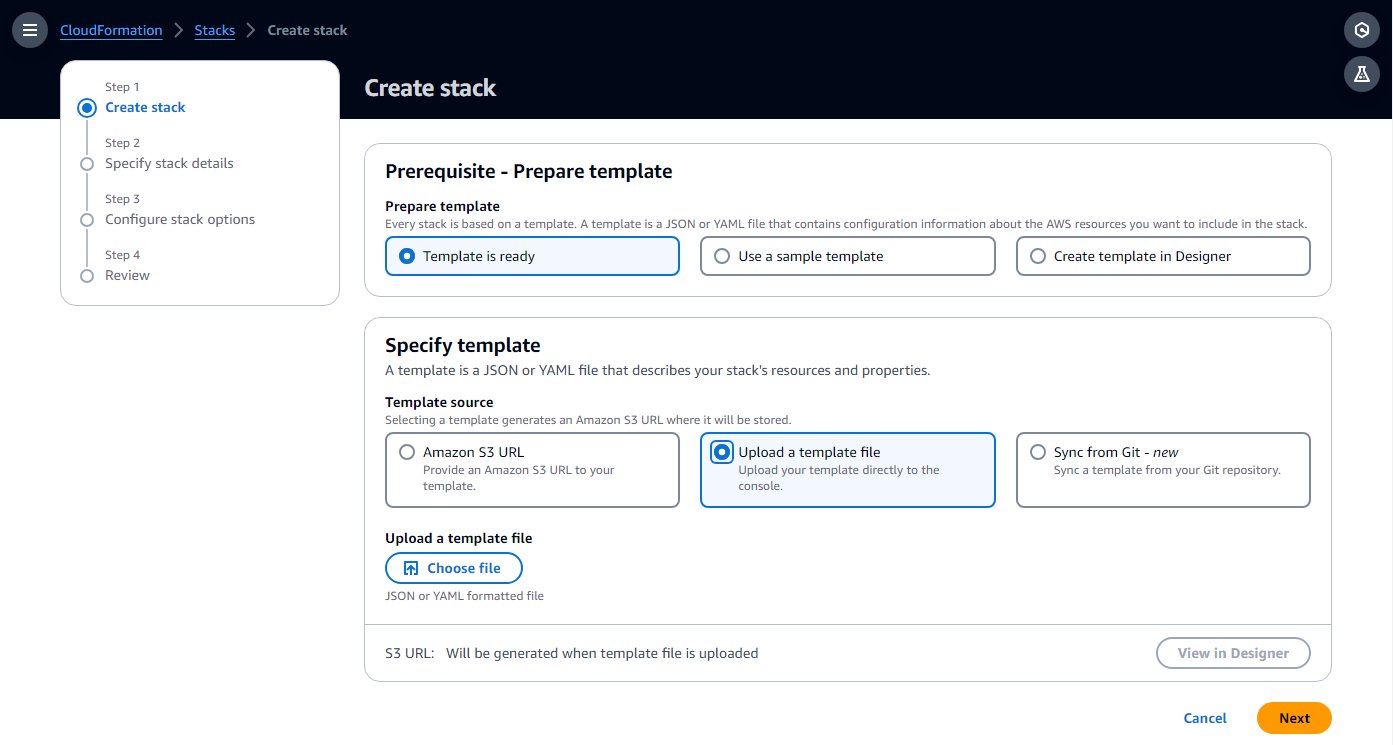

- Ustvari Oblikovanje oblaka AWS predlogo v računalniku, tako da kopirate predlogo iz naslednjega hitri vodnik za začetek v lokalno besedilno datoteko.

- Na konzoli AWS CloudFormation izberite Skladovnice v podoknu za krmarjenje.

- Izberite Ustvari sklad z možnostjo Z novimi viri (standardno).

- Izberite Naložite datoteko predloge in izberite datoteko lokalne predloge.

- Izberite Naslednji.

- Dokončajte nastavitvene korake, vnesite ime za okolje in pustite ostale parametre privzete.

- Na zadnjem koraku potrdite, da bodo viri ustvarjeni, in izberite Prijave se.

Ustvarjanje lahko traja 20–30 minut, dokler se stanje sklada ne spremeni v CREATE_COMPLETE.

Vir, ki bo vzel največ časa, je okolje Airflow. Medtem ko se ustvarja, lahko nadaljujete z naslednjimi koraki, dokler ne boste morali odpreti uporabniškega vmesnika Airflow.

- Na skladovnici viri zavihku zabeležite ID-je za VPC in dve zasebni podomrežji (

PrivateSubnet1inPrivateSubnet2), za uporabo v naslednjem koraku.

Ustvarite povezave AWS Glue

Predloga CloudFormation razmesti dve zasebni podomrežji. V tem koraku z vsakim ustvarite povezavo AWS Glue, tako da se lahko v njih izvajajo opravila AWS Glue. Amazon MWAA je nedavno dodal zmogljivost za izvajanje gruče Airflow na skupnih VPC-jih, kar zmanjša stroške in poenostavi upravljanje omrežja. Za več informacij glejte Predstavljamo skupno podporo VPC na Amazon MWAA.

Izvedite naslednje korake, da ustvarite povezave:

- Na konzoli AWS Glue izberite Podatkovne povezave v podoknu za krmarjenje.

- Izberite Ustvarite povezavo.

- Izberite mreža kot vir podatkov.

- Izberite VPC in zasebno podomrežje (

PrivateSubnet1), ki jih je ustvaril sklad CloudFormation. - Uporabite privzeto varnostno skupino.

- Izberite Naslednji.

- Za ime povezave vnesite

MWAA-Glue-Blog-Subnet1. - Preglejte podrobnosti in dokončajte ustvarjanje.

- Ponovite te korake z uporabo

PrivateSubnet2in poimenujte povezavoMWAA-Glue-Blog-Subnet2.

Ustvarite opravilo AWS Glue

Zdaj ustvarite opravilo AWS Glue, ki ga bo pozneje sprožil potek dela Airflow. Opravilo uporablja povezave, ustvarjene v prejšnjem razdelku, vendar namesto, da bi jih dodelili neposredno opravilu, kot bi običajno storili, v tem scenariju pustite seznam povezav opravila prazen in prepustite delovnemu toku, da odloči, katero bo uporabil med izvajanjem.

Skript opravila v tem primeru ni pomemben in je namenjen samo prikazu izvajanja opravila v enem od podomrežij, odvisno od povezave.

- Na konzoli AWS Glue izberite ETL delovna mesta v podoknu za krmarjenje in nato izberite Urejevalnik skriptov.

- Pustite privzete možnosti (motor Spark in Začnite sveže) in izberite Ustvari skript.

- Zamenjajte nadomestni skript z naslednjo kodo Python:

- Preimenujte opravilo v

AirflowBlogJob. - o Podrobnosti o delovnem mestu zavihek, za Vloga IAM, izberite poljubno vlogo in vnesite 2 za število delavcev (zgolj zaradi varčnosti).

- Shranite te spremembe, da bo delo ustvarjeno.

Dodelite dovoljenja AWS Glue vlogi okolja Airflow

Vloga, ustvarjena za Airflow s predlogo CloudFormation, zagotavlja osnovna dovoljenja za izvajanje delovnih tokov, ne pa tudi za interakcijo z drugimi storitvami, kot je AWS Glue. V produkcijskem projektu bi definirali lastne predloge s temi dodatnimi dovoljenji, vendar v tej objavi zaradi poenostavitve dodate dodatna dovoljenja kot vgrajeni pravilnik. Izvedite naslednje korake:

- Na konzoli IAM izberite vloge v podoknu za krmarjenje.

- Poiščite vlogo, ki jo je ustvarila predloga; začel se bo z imenom, ki ste ga dodelili skladu CloudFormation in nato

-MwaaExecutionRole-. - Na strani s podrobnostmi o vlogi, na Dodajte dovoljenja izberite meni Ustvari vgrajeno politiko.

- Preklopite iz vizualnega v način JSON in v besedilno polje vnesite naslednji JSON. Predpostavlja, da vaša vloga AWS Glue sledi konvenciji za začetek

AWSGlueServiceRole. Za večjo varnost lahko zamenjate vir z nadomestnimi znaki naec2:DescribeSubnetsdovoljenje z ARN-ji dveh zasebnih podomrežij iz sklada CloudFormation. - Izberite Naslednji.

- Vnesite

GlueRelatedPermissionskot ime pravilnika in dokončajte ustvarjanje.

V tem primeru uporabljamo opravilo skripta ETL; za vizualno opravilo, ker samodejno ustvari skript ob shranjevanju, bi vloga Airflow potrebovala dovoljenje za pisanje na konfigurirano pot skripta na Preprosta storitev shranjevanja Amazon (Amazon S3).

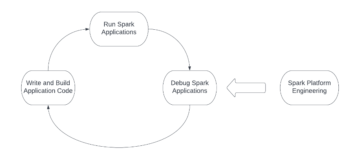

Ustvarite DAG za pretok zraka

Potek dela Airflow temelji na usmerjenem acikličnem grafu (DAG), ki je definiran z datoteko Python, ki programsko določa različne vključene naloge in njihove soodvisnosti. Izpolnite naslednje skripte, da ustvarite DAG:

- Ustvari lokalno datoteko z imenom

glue_job_dag.pyz uporabo urejevalnika besedil.

V vsakem od naslednjih korakov nudimo delček kode za vnos v datoteko in razlago, kaj počne.

- Naslednji delček doda zahtevane uvoze modulov Python. Moduli so že nameščeni na Airflow; če ne bi bilo tako, bi morali uporabiti a

requirements.txtdatoteko, ki Airflowu nakazuje, katere module naj namesti. Definira tudi odjemalce Boto3, ki jih bo koda uporabila pozneje. Privzeto bodo uporabljali isto vlogo in regijo kot Airflow, zato ste pred vlogo nastavili zahtevana dodatna dovoljenja. - Naslednji delček doda tri funkcije za izvajanje strategije vrstnega reda povezav, ki določa, kako preurediti dane povezave, da se določi njihova prioriteta. To je samo primer; lahko sestavite kodo po meri za implementacijo lastne logike glede na vaše potrebe. Koda najprej preveri IP-je, ki so na voljo v vsakem povezovalnem podomrežju, in loči tiste, ki imajo na voljo dovolj IP-jev za izvajanje opravila s polno zmogljivostjo, in tiste, ki bi jih lahko uporabili, ker imajo na voljo vsaj dva IP-ja, kar je najmanj, kar mora opravilo začetek. Če je strategija nastavljena na

random, bo naključno določil vrstni red znotraj vsake od prej opisanih povezovalnih skupin in dodal vse druge povezave. Če je strategijacapacity, jih bo razvrstil od večine brezplačnih IP-jev do najmanjšega. - Naslednja koda ustvari sam DAG z nalogo izvajanja opravila, ki posodobi opravilo z vrstnim redom povezave, ki ga določa strategija, ga zažene in čaka na rezultate. Ime opravila, povezave in strategija izvirajo iz spremenljivk Airflow, zato jih je mogoče enostavno konfigurirati in posodobiti. Ima dva konfigurirana ponovna poskusa z eksponentnim odmikom, tako da bo, če nalogi ne uspeta, ponovil celotno nalogo, vključno z izbiro povezave. Morda je zdaj najboljša izbira druga povezava ali pa je podomrežje, ki je bilo prej naključno izbrano, v območju razpoložljivosti, ki trenutno trpi zaradi izpada, in če izberete drugo, se lahko obnovi.

Ustvarite potek dela Airflow

Zdaj ustvarite potek dela, ki prikliče opravilo AWS Glue, ki ste ga pravkar ustvarili:

- Na konzoli Amazon S3 poiščite vedro, ustvarjeno s predlogo CloudFormation, ki bo imelo ime, ki se začne z imenom sklada in nato

-environmentbucket-(npr.myairflowstack-environmentbucket-ap1qks3nvvr4). - Znotraj tega vedra ustvarite mapo z imenom

dagsin znotraj te mape naložite datoteko DAGglue_job_dag.pyki ste jih ustvarili v prejšnjem razdelku. - Na konzoli Amazon MWAA se pomaknite do okolja, ki ste ga uvedli s skladom CloudFormation.

Če stanje še ni Na voljo, počakajte, da doseže to stanje. Ne bi smelo trajati dlje kot 30 minut, odkar ste uvedli sklad CloudFormation.

- Za ogled podrobnosti okolja izberite povezavo okolja v tabeli.

Konfiguriran je za prevzem datotek DAG iz vedra in mape, ki ste ju uporabili v prejšnjih korakih. Airflow bo spremljal to mapo glede sprememb.

- Izberite Odprite uporabniški vmesnik Airflow da odprete nov zavihek z dostopom do uporabniškega vmesnika Airflow z uporabo integrirane varnosti IAM za prijavo.

Če obstaja kakšna težava z datoteko DAG, ki ste jo ustvarili, bo na vrhu strani prikazana napaka, ki označuje prizadete vrstice. V tem primeru preglejte korake in znova naložite. Po nekaj sekundah ga bo razčlenil in posodobil ali odstranil pasico z napako.

- o admin izberite meni Spremenljivke.

- Dodajte tri spremenljivke z naslednjimi ključi in vrednostmi:

- Ključne

glue_job_dag.glue_connectionsz vrednostjoMWAA-Glue-Blog-Subnet1,MWAA-Glue-Blog-Subnet2. - Ključne

glue_job_dag.glue_job_namez vrednostjoAirflowBlogJob. - Ključne

glue_job_dag.strategyz vrednostjocapacity.

- Ključne

Zaženite opravilo z dinamično dodelitvijo podomrežja

Zdaj ste pripravljeni zagnati potek dela in videti strategijo, ki dinamično preureja povezave.

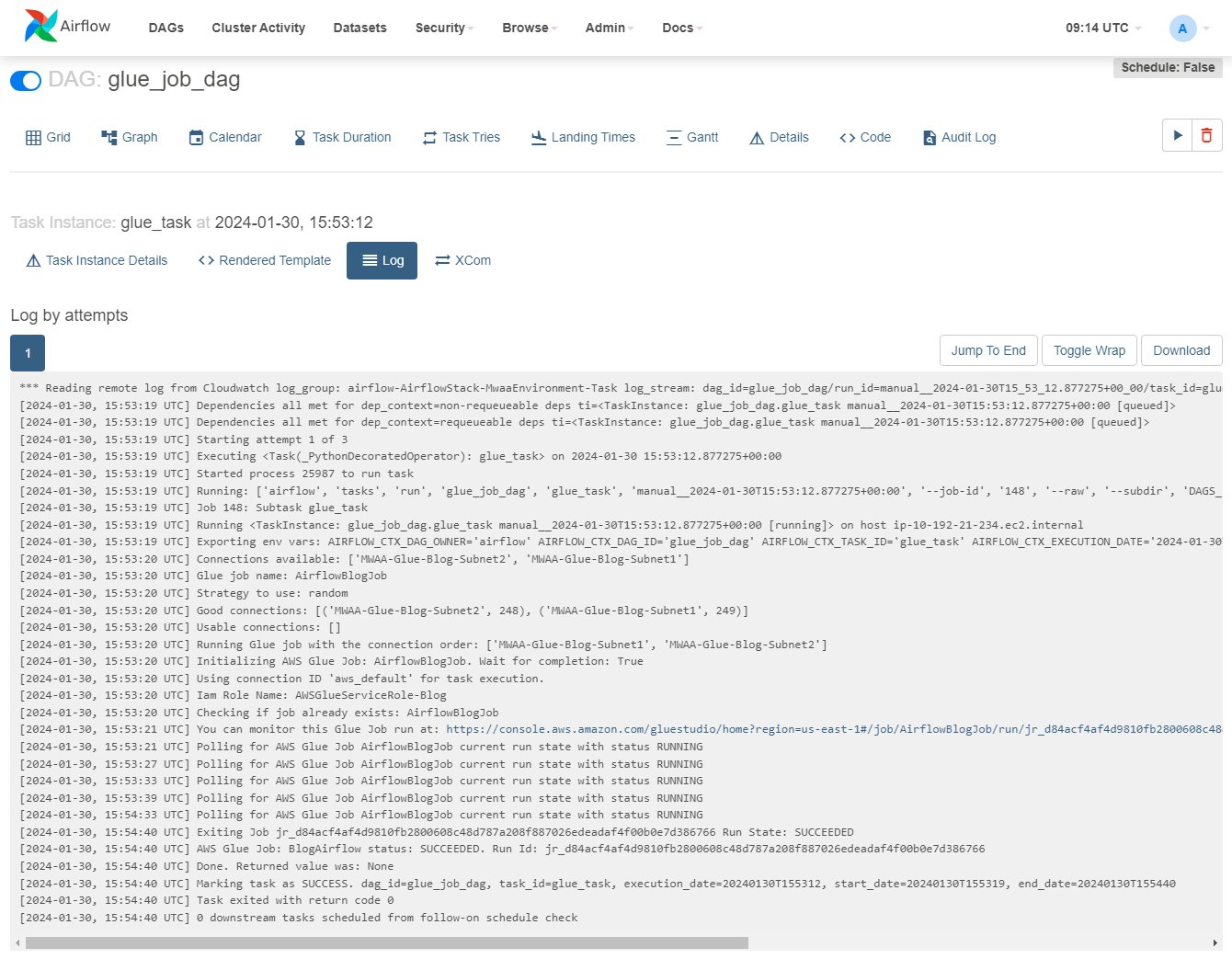

- V uporabniškem vmesniku Airflow izberite DAG, in na vrsti

glue_job_dag, izberite ikono za predvajanje. - o Brskanje izberite meni Primeri nalog.

- V tabeli primerkov se pomaknite desno, da prikažete

Log Urlin izberite ikono na njem, da odprete dnevnik.

Dnevnik se bo posodabljal med izvajanjem naloge; poiščete lahko vrstico, ki se začne z »Running Glue job with the connection order:« in prejšnje vrstice, ki prikazujejo podrobnosti IP-jev povezave in dodeljene kategorije. Če pride do napake, boste videli podrobnosti v tem dnevniku.

- Na konzoli AWS Glue izberite ETL delovna mesta v podoknu za krmarjenje, nato izberite opravilo

AirflowBlogJob. - o Teče izberite zavihek zagon in nato Izhodni dnevniki povezavo, ki bo odprla nov zavihek.

- Na novem zavihku uporabite povezavo toka dnevnika, da ga odprete.

Prikazal bo IP, ki je bil dodeljen gonilniku, in kateremu podomrežju pripada, kar se mora ujemati s povezavo, ki jo označuje Airflow (če dnevnik ni prikazan, izberite Resume tako da se posodobi takoj, ko je na voljo).

- V uporabniškem vmesniku Airflow uredite spremenljivko Airflow

glue_job_dag.strategynastaviti narandom. - Večkrat zaženite DAG in si oglejte, kako se spreminja vrstni red.

Čiščenje

Če uvajanja ne potrebujete več, izbrišite vire, da se izognete nadaljnjim stroškom:

- Izbrišite skript Python, ki ste ga naložili, tako da bo lahko vedro S3 samodejno izbrisano v naslednjem koraku.

- Izbrišite sklad CloudFormation.

- Izbrišite opravilo AWS Glue.

- Izbrišite skript, ki ga je opravilo shranilo v Amazon S3.

- Izbrišite povezave, ki ste jih ustvarili kot del te objave.

zaključek

V tej objavi smo pokazali, kako lahko AWS Glue in Amazon MWAA sodelujeta pri izdelavi naprednejših delovnih tokov po meri, hkrati pa zmanjšata stroške delovanja in upravljanja. Ta rešitev vam daje večji nadzor nad tem, kako vaše opravilo AWS Glue poteka, da izpolnite posebne operativne, omrežne ali varnostne zahteve.

Svoje okolje Amazon MWAA lahko uvedete na več načinov, na primer z Predloga uporabljen v tej objavi, na konzoli Amazon MWAA ali z uporabo AWS CLI. Prav tako lahko implementirate lastne strategije za orkestriranje opravil AWS Glue, ki temeljijo na vaši omrežni arhitekturi in zahtevah (na primer, da zaženete opravilo bližje podatkom, ko je to mogoče).

O avtorjih

Michael Greenshtein je specialist za analitične rešitve za javni sektor.

Michael Greenshtein je specialist za analitične rešitve za javni sektor.

Gonzalo Herreros je višji arhitekt za velike podatke v skupini AWS Glue.

Gonzalo Herreros je višji arhitekt za velike podatke v skupini AWS Glue.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/big-data/combine-aws-glue-and-amazon-mwaa-to-build-advanced-vpc-selection-and-failover-strategies/

- :ima

- : je

- :ne

- :kje

- $GOR

- 1

- 10

- 100

- 11

- 12

- 1232

- 1393

- 19

- 2%

- 20

- 2000

- 21

- 28

- 30

- 34

- 4

- 5

- 6

- 610

- 8

- a

- O meni

- dostop

- Dostop

- potrditi

- Ukrep

- aciklični

- dodajte

- dodano

- Dodatne

- Naslov

- naslovi

- Dodaja

- napredno

- vplivajo

- po

- spet

- vsi

- omogočajo

- dovoljene

- omogoča

- že

- Prav tako

- vedno

- Amazon

- Amazon Web Services

- an

- analitika

- in

- Še ena

- kaj

- Apache

- uporaba

- Razvoj aplikacij

- Arhitektura

- SE

- AS

- dodeljena

- predpostavlja

- At

- samodejno

- razpoložljivost

- Na voljo

- izogniti

- AWS

- Oblikovanje oblaka AWS

- AWS lepilo

- banner

- temeljijo

- Osnovni

- BE

- ker

- bilo

- pred

- vedenje

- počutje

- pripada

- BEST

- Big

- Big Podatki

- tako

- izgradnjo

- vendar

- by

- se imenuje

- CAN

- kapaciteta

- primeru

- Katalog

- Kategorija

- spremenite

- spremenilo

- Spremembe

- Stroški

- preveriti

- preverjeno

- Pregledi

- izbira

- Izberite

- čiščenje

- stranke

- bližje

- Grozd

- Koda

- združujejo

- kako

- dokončanje

- računalnik

- Pogoji

- konfiguracija

- konfiguracije

- konfigurirano

- povezava

- povezave

- Povezovanje

- Konzole

- naprej

- nadzor

- Konvencija

- koordinate

- kopiranje

- strošek

- bi

- ustvarjajo

- ustvaril

- ustvari

- Oblikovanje

- Trenutno

- po meri

- Stranke, ki so

- prilagodite

- DAG

- datum

- integracija podatkov

- Datum

- Datum čas

- odloča

- Odločitev

- def

- privzeto

- opredeliti

- opredeljen

- Določa

- definiranje

- od

- odstrani

- izbrisano

- Povpraševanje

- izkazati

- Odvisno

- razporedi

- razporejeni

- uvajanje

- razpolaga

- opisano

- Podrobnosti

- Razvoj

- diagram

- DICT

- drugačen

- usmerjen

- neposredno

- odkriti

- zaslon

- prikazano

- do

- ne

- Ne

- don

- dont

- navzdol

- voznik

- 2

- trajanje

- dinamično

- dinamično

- e

- vsak

- enostavno

- urednik

- učinek

- ostalo

- prazen

- konec

- Motor

- okrepi

- okrepljeno

- dovolj

- Vnesite

- V

- okolje

- Napaka

- vzpostaviti

- Eter (ETH)

- Tudi

- Primer

- Razen

- izjema

- Razlaga

- eksponentna

- zunanja

- ekstrakt

- ni uspelo

- ne

- ne uspe

- Napaka

- Nekaj

- manj

- file

- prva

- pet

- Všita

- sledi

- po

- sledi

- za

- brezplačno

- iz

- polno

- funkcije

- nadalje

- Poleg tega

- Prehod

- ustvarja

- dobili

- dobi

- dana

- daje

- dobro

- graf

- skupina

- Skupine

- Imajo

- pristanišče

- Pomaga

- držite

- Kako

- Kako

- Vendar

- HTML

- http

- HTTPS

- IAM

- ICON

- identiteta

- ID-ji

- if

- ponazarja

- izvajati

- uvoz

- uvoz

- in

- vključuje

- Vključno

- Povečajte

- Navedite

- naveden

- označuje

- Podatki

- v notranjosti

- namestitev

- nameščen

- primer

- primerov

- Namesto

- Navodila

- integrirati

- integrirana

- integracija

- namenjen

- interakcijo

- Internet

- dostop do interneta

- v

- prikliče

- vključujejo

- vključeni

- IP

- IP naslov

- IP naslovi

- vprašanje

- IT

- ITS

- sam

- Job

- Delovna mesta

- jpg

- json

- samo

- Imejte

- tipke

- velika

- Zadnja

- pozneje

- vodi

- učenje

- vsaj

- pustite

- Naj

- vrstica

- linije

- LINK

- Seznam

- Navedeno

- obremenitev

- lokalna

- zaklepanje

- prijavi

- Logika

- več

- stroj

- strojno učenje

- Znamka

- IZDELA

- upravljanje

- upravlja

- upravljanje

- več

- Stave

- Maj ..

- mogoče

- Srečati

- srečanja

- Meni

- morda

- minimiziranje

- minimalna

- min

- ML

- način

- modeli

- Moduli

- monitor

- več

- Najbolj

- premikanje

- več

- Več povezav

- Ime

- Imenovan

- Krmarjenje

- ostalo

- Nimate

- potrebna

- potrebe

- mreža

- Varnostna mreža

- Novo

- Naslednja

- št

- Vozel

- vozlišča

- Običajno

- Upoštevajte

- zdaj

- Številka

- of

- pogosto

- on

- ONE

- tiste

- samo

- odprite

- operativno

- operaterji

- optimalna

- Možnost

- možnosti

- or

- Da

- naročanje

- Ostalo

- Prekinitev

- več

- režijske

- lastne

- Stran

- podokno

- parametri

- del

- vozovnice

- pot

- za

- Dovoljenje

- Dovoljenja

- kramp

- izbrali

- nabiranje

- placeholder

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Predvajaj

- politika

- mogoče

- Prispevek

- raje

- Pripravimo

- ohranitev

- preprečiti

- prejšnja

- prej

- prednostna naloga

- zasebna

- proizvodnja

- Projekt

- Lastnosti

- zagotavljajo

- ponudniki

- zagotavlja

- javnega

- Python

- dvigniti

- tekel

- naključno

- Doseže

- pripravljen

- Razlogi

- Pred kratkim

- Obnovi

- zmanjšuje

- glejte

- okolica

- regionalni

- odstrani

- ponovite

- zamenjajte

- zahteva

- obvezna

- Zahteve

- zahteva

- vir

- viri

- REST

- povzroči

- Rezultati

- vrnitev

- ponovna

- pregleda

- Pravica

- vloga

- ROW

- Run

- tek

- deluje

- runtime

- Enako

- Shrani

- shranjena

- Scenarij

- script

- skripte

- pomaknite

- sekund

- Oddelek

- sektor

- varnost

- glej

- izbor

- višji

- Brez strežnika

- Storitev

- Storitve

- nastavite

- nastavitev

- deli

- pomanjkanje

- shouldnt

- Prikaži

- je pokazala,

- Prikaz

- shuffle

- pomemben

- Enostavno

- preprostost

- poenostavlja

- saj

- sam

- delček

- So

- Rešitev

- rešitve

- Včasih

- Kmalu

- sortiranje

- vir

- Viri

- Spark

- posebna

- specialist

- specifična

- določeno

- določanje

- sveženj

- standardna

- Začetek

- začel

- Začetek

- Država

- Izjava

- Status

- Korak

- Koraki

- shranjevanje

- naravnost

- strategije

- Strategija

- tok

- strogo

- subnet

- podomrežja

- taka

- trpljenje

- primerna

- podpora

- sistemi

- T

- miza

- Bodite

- Naloga

- Naloge

- skupina

- Predloga

- predloge

- besedilo

- kot

- da

- O

- njihove

- Njih

- POTEM

- te

- jih

- ta

- tisti,

- 3

- čas

- krat

- do

- skupaj

- toleranca

- vrh

- Transform

- Poskušal

- sprožilo

- poskusite

- dva

- tip

- Vrste

- ui

- pod

- neznan

- dokler

- Nadgradnja

- posodobljeno

- posodobitve

- naložili

- uporabno

- Uporaba

- uporaba

- Rabljeni

- uporabnik

- uporablja

- uporabo

- vrednost

- Vrednote

- spremenljivka

- spremenljivke

- različica

- preko

- Virtual

- vizualna

- Počakaj

- čaka

- opozorilo

- je

- načini

- we

- web

- spletne storitve

- Kaj

- Kaj je

- kdaj

- ki

- medtem

- zakaj

- bo

- z

- v

- delo

- delati skupaj

- delavec

- delavci

- potek dela

- delovnih tokov

- bi

- pisanje

- X

- še

- jo

- Vaša rutina za

- zefirnet

- cona

- cone