Вступ

Попросіть DALL·E 2, систему генерації зображень, створену OpenAI, намалювати «золоту рибку, яка п’є кока-колу на пляжі», і вона видасть сюрреалістичні зображення саме цього. Під час навчання програма зустріла б зображення пляжів, золотих рибок і кока-коли, але малоймовірно, що вона побачила б зображення, на якому всі три об’єдналися. Проте DALL·E 2 може зібрати концепції в щось, чим Далі міг би пишатися.

DALL·E 2 — це тип генеративної моделі — система, яка намагається використовувати навчальні дані для створення чогось нового, порівнянного з даними за якістю та різноманітністю. Це одна з найскладніших проблем у машинному навчанні, і дістатися до цього моменту було важко.

Перші важливі генеративні моделі для зображень використовували підхід до штучного інтелекту, який називається нейронною мережею — програмою, що складається з багатьох шарів обчислювальних одиниць, які називаються штучними нейронами. Але навіть коли якість їхніх зображень покращилася, моделі виявилися ненадійними та їх важко навчати. Тим часом потужна генеративна модель, створена докторантом із пристрастю до фізики, лежала бездіяльною, поки двоє аспірантів не зробили технічного прориву, який оживив звіра.

DALL·E 2 — це такий звір. Ключове розуміння, яке робить можливим зображення DALL·E 2, а також зображення його конкурентів Stable Diffusion і Imagen, походить зі світу фізики. Система, яка лежить в їх основі, відома як модель дифузії, значною мірою натхненна нерівноважною термодинамікою, яка керує такими явищами, як поширення рідин і газів. «Є багато методів, які спочатку були винайдені фізиками, а тепер вони дуже важливі для машинного навчання», — сказав Ян Пісня, дослідник машинного навчання в OpenAI.

Потужність цих моделей сколихнула як промисловість, так і користувачів. «Це захоплюючий час для генеративних моделей», — сказав Аніма Анандкумар, фахівець з інформатики в Каліфорнійському технологічному інституті та старший директор з досліджень машинного навчання в Nvidia. І хоча реалістичні зображення, створені дифузійними моделями, іноді можуть увічнити соціальні та культурні упередження, за її словами, «ми продемонстрували, що генеративні моделі корисні для подальших завдань [які] покращують справедливість прогнозних моделей ШІ».

Високі ймовірності

Щоб зрозуміти, як працює створення даних для зображень, почнемо з простого зображення, яке складається лише з двох суміжних пікселів у відтінках сірого. Ми можемо повністю описати це зображення за допомогою двох значень на основі відтінку кожного пікселя (від нуля – повністю чорного до 255 – повністю білого). Ви можете використовувати ці два значення, щоб побудувати зображення як точку у 2D-просторі.

Якщо ми малюємо кілька зображень у вигляді точок, можуть виникати кластери — певні зображення та їхні відповідні значення пікселів, які трапляються частіше, ніж інші. Тепер уявіть поверхню над площиною, де висота поверхні відповідає щільності кластерів. Ця поверхня відображає розподіл ймовірностей. Ви, швидше за все, знайдете окремі точки даних під найвищою частиною поверхні, і лише кілька точок там, де поверхня є найнижчою.

Вступ

Тепер ви можете використовувати цей розподіл ймовірностей для створення нових зображень. Усе, що вам потрібно зробити, це випадковим чином генерувати нові точки даних, дотримуючись обмеження, що ви частіше генеруєте ймовірніші дані — процес, який називається «вибіркою» розподілу. Кожна нова точка – це новий образ.

Той самий аналіз справедливий для більш реалістичних фотографій у відтінках сірого, скажімо, з мільйоном пікселів кожна. Тільки тепер для побудови кожного зображення потрібні не дві осі, а мільйон. Розподіл ймовірностей на таких зображеннях буде деякою складною поверхнею мільйона плюс одного виміру. Якщо взяти вибірку цього розподілу, ви отримаєте мільйон значень пікселів. Надрукуйте ці пікселі на аркуші паперу, і зображення, швидше за все, виглядатиме як фотографія з вихідного набору даних.

Завдання генеративного моделювання полягає в тому, щоб вивчити цей складний розподіл ймовірностей для деякого набору зображень, які становлять навчальні дані. Розподіл корисний почасти тому, що він фіксує велику кількість інформації про дані, а почасти тому, що дослідники можуть комбінувати розподіли ймовірностей для різних типів даних (таких як текст і зображення) для створення сюрреалістичних результатів, таких як золота рибка, яка п’є кока-колу на пляжі. . «Ви можете змішувати та поєднувати різні концепції… для створення абсолютно нових сценаріїв, яких ніколи не було в навчальних даних», — сказав Анандкумар.

У 2014 році модель під назвою generative adversarial network (GAN) стала першою, яка створила реалістичні зображення. «Було так багато хвилювання, — сказав Анандкумар. Але GAN важко навчити: вони можуть не вивчати повний розподіл ймовірностей і можуть бути заблоковані у створенні зображень лише з підмножини розподілу. Наприклад, GAN, навчений на зображеннях різноманітних тварин, може створити лише зображення собак.

Машинне навчання потребувало більш надійної моделі. Яша Золь-Дікштайн, на чию роботу надихнула фізика, надасть один.

Краплі хвилювання

Приблизно в той час, коли були винайдені GAN, Сол-Дікштайн був постдокторантом у Стенфордському університеті, працюючи над генеративними моделями, з побічним інтересом до нерівноважної термодинаміки. Ця галузь фізики вивчає системи, які не знаходяться в тепловій рівновазі — ті, які обмінюються речовиною та енергією всередині та з навколишнім середовищем.

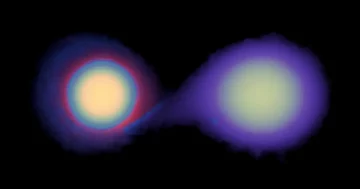

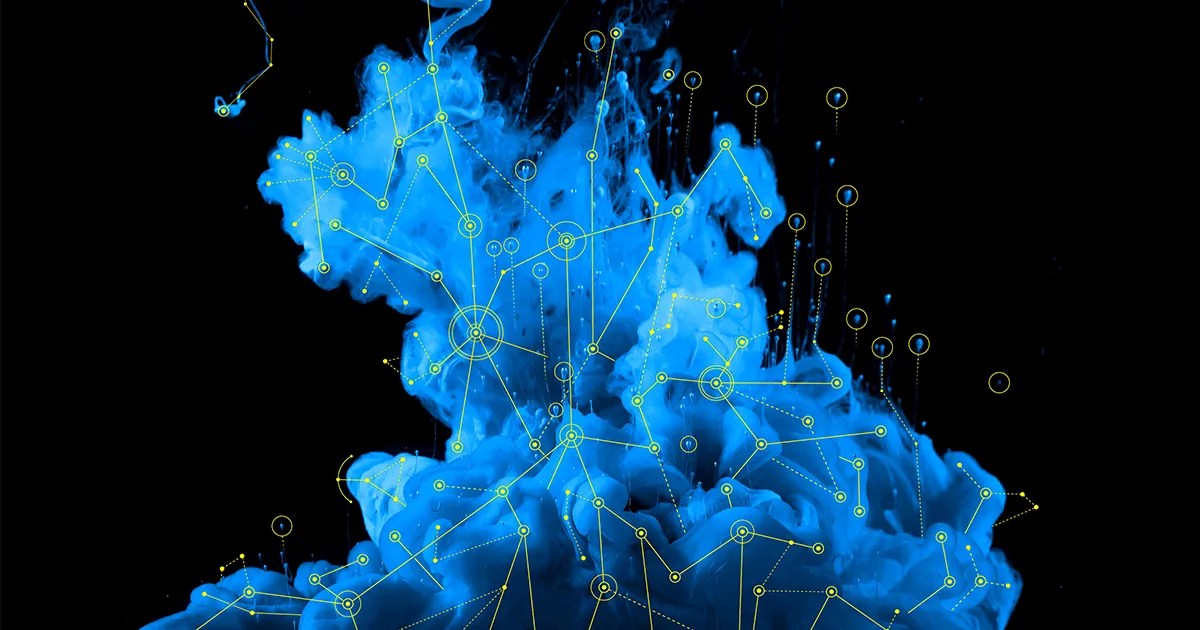

Яскравим прикладом є крапля синього чорнила, що дифундує крізь ємність з водою. Спочатку вона утворює темну пляму в одному місці. На цьому етапі, якщо ви хочете обчислити ймовірність знаходження молекули чорнила в деякому невеликому об’ємі контейнера, вам потрібен розподіл ймовірностей, який точно моделює початковий стан, перш ніж чорнило почне розтікатися. Але цей розподіл є складним, і тому його важко взяти на вибірку.

Однак згодом чорнило розливається по воді, роблячи її блідо-блакитною. Це призводить до набагато простішого, більш рівномірного розподілу ймовірностей молекул, який можна описати простим математичним виразом. Нерівноважна термодинаміка описує розподіл ймовірностей на кожному етапі процесу дифузії. Важливо те, що кожен крок є оборотним — за допомогою невеликих кроків ви можете повернутися від простого розподілу до складного.

Вступ

Сол-Дікштайн використовував принципи дифузії для розробки алгоритму генеративного моделювання. Ідея проста: алгоритм спочатку перетворює складні зображення в наборі навчальних даних у простий шум — схожий на перехід від чорнильної плями до розсіяної світло-блакитної води — а потім навчає систему, як змінити процес, перетворюючи шум на зображення.

Ось як це працює. Спочатку алгоритм бере зображення з навчального набору. Як і раніше, припустимо, що кожен з мільйона пікселів має певну цінність, і ми можемо побудувати зображення як точку в мільйоновимірному просторі. Алгоритм додає трохи шуму до кожного пікселя на кожному кроці часу, що еквівалентно дифузії чорнила після одного невеликого кроку часу. У міру того, як цей процес триває, значення пікселів мають менший відношення до своїх значень у вихідному зображенні, і пікселі виглядають більше як простий розподіл шуму. (Алгоритм також трохи зміщує кожне значення пікселя до початку координат, нульового значення на всіх цих осях, на кожному кроці часу. Це зрушення запобігає зростанню піксельних значень, щоб комп’ютерам було легко працювати з ними.)

Зробіть це для всіх зображень у наборі даних, і початковий складний розподіл точок у мільйоновимірному просторі (який неможливо легко описати та взяти з нього вибірку) перетвориться на простий нормальний розподіл точок навколо початку координат.

«Послідовність перетворень дуже повільно перетворює ваш розподіл даних просто на велику шумову кулю», — сказав Сол-Дікштайн. Цей «попередній процес» залишає вас із дистрибутивом, з якого ви можете легко взяти вибірку.

Далі йде частина машинного навчання: дайте нейронній мережі зашумлені зображення, отримані від проходу вперед, і навчіть її передбачати менш зашумлені зображення, які з’явилися на крок раніше. Спочатку він буде робити помилки, тому ви налаштуєте параметри мережі, щоб він працював краще. Зрештою, нейронна мережа може надійно перетворити зашумлене зображення, яке репрезентує вибірку з простого розподілу, на зображення, що репрезентує вибірку зі складного розподілу.

Навчена мережа є повномасштабною генеративною моделлю. Тепер вам навіть не потрібне оригінальне зображення для проходу вперед: у вас є повний математичний опис простого розподілу, тож ви можете брати вибірку безпосередньо з нього. Нейронна мережа може перетворити цей зразок — по суті просто статичний — на остаточне зображення, яке нагадує зображення в наборі навчальних даних.

Сол-Дікштайн згадує перші результати своєї моделі дифузії. «Ви б примружилися і сказали: «Мені здається, ця кольорова крапля схожа на вантажівку», — сказав він. «Я провів стільки місяців свого життя, дивлячись на різні візерунки пікселів і намагаючись побачити структуру, що подумав: «Це набагато структурованіше, ніж я коли-небудь отримував». Я був дуже схвильований».

Уявлення про майбутнє

Сол-Дікштайн опублікував його алгоритм дифузійної моделі у 2015 році, але це все ще було далеко позаду того, що могли зробити GAN. У той час як дифузійні моделі могли проводити вибірку по всьому розподілу і ніколи не застрягали, виділяючи лише підмножину зображень, зображення виглядали гірше, а процес був надто повільним. "Я не думаю, що в той час це вважалося захоплюючим", - сказав Сол-Дікштайн.

Знадобилося двоє студентів, жоден із яких не знав ні Сол-Дікштейна, ні один одного, щоб з’єднати крапки цієї початкової роботи з сучасними дифузійними моделями, такими як DALL·E 2. Першим був Сонг, докторант Стенфордського університету в той час. У 2019 році він і його радник опублікував новий метод для побудови генеративних моделей, які не оцінювали розподіл ймовірностей даних (високомірна поверхня). Замість цього він оцінив градієнт розподілу (подумайте про це як про нахил високорозмірної поверхні).

Сонг виявив, що його техніка працює найкраще, якщо він спочатку спотворить кожне зображення в наборі навчальних даних із збільшенням рівня шуму, а потім попросить свою нейронну мережу передбачити вихідне зображення, використовуючи градієнти розподілу, ефективно приглушаючи його. Після навчання його нейронна мережа могла взяти зашумлене зображення, взяте з простого розподілу, і поступово перетворити його назад на зображення, що представляє набір навчальних даних. Якість зображення була чудовою, але його модель машинного навчання була дуже повільною для вибірки. І він зробив це, не знаючи роботи Сол-Дікштайна. «Я взагалі не знав про моделі дифузії, — сказав Сонг. «Після публікації нашої статті за 2019 рік я отримав електронний лист від Яші. Він зазначив мені, що [наші моделі] мають дуже сильні зв’язки».

У 2020 році другий студент побачив ці зв’язки та зрозумів, що робота Сонга може покращити моделі дифузії Сола-Дікштейна. Джонатан Хо нещодавно закінчив свою докторську роботу з генеративного моделювання в Каліфорнійському університеті в Берклі, але продовжував працювати над нею. «Я вважав, що це найкрасивіша з математичної точки зору субдисципліна машинного навчання», — сказав він.

Хо переробив і оновив дифузійну модель Сола-Дікштайна з деякими ідеями Сонга та іншими досягненнями зі світу нейронних мереж. «Я знав, що для того, щоб привернути увагу спільноти, мені потрібно змусити модель створювати чудові зразки», — сказав він. «Я був переконаний, що це найважливіше, що я міг зробити на той момент».

Його інтуїція була на місці. Хо та його колеги оголосили про цю нову та вдосконалену модель дифузії у 2020 році в статті під назвою «Знешумлення дифузійних імовірнісних моделей.” Він швидко став таким орієнтиром, що дослідники тепер називають його просто DDPM. Згідно з одним тестом якості зображення, який порівнює розподіл згенерованих зображень із розподілом навчальних зображень, ці моделі збіглися або перевершили всі конкуруючі генеративні моделі, включаючи GAN. Невдовзі великі гравці помітили це. Тепер усі DALL·E 2, Stable Diffusion, Imagen та інші комерційні моделі використовують деякі варіанти DDPM.

Сучасні дифузійні моделі мають ще один ключовий інгредієнт: великі мовні моделі (LLM), такі як GPT-3. Це генеративні моделі, навчені на основі тексту з Інтернету для вивчення розподілу ймовірностей за словами замість зображень. У 2021 році Хо — тепер дослідник у стелс-компанії — та його колега Тім Саліманс у Google Research, разом з іншими командами в інших місцях, показали, як поєднати інформацію з LLM і моделі дифузії, що генерує зображення, щоб використовувати текст (скажімо, «золота рибка п’є кока-колу на пляжі») для керування процесом дифузії, а отже, генерація зображення. Цей процес «керованого поширення» лежить в основі успіху моделей перетворення тексту в зображення, таких як DALL·E 2.

«Вони перевершують мої найсміливіші очікування», — сказав Хо. «Я не збираюся вдавати, що бачив усе це».

Створення проблем

Незважаючи на успіх цих моделей, зображення з DALL·E 2 і йому подібних все ще далекі від досконалості. Великі мовні моделі можуть відображати культурні та суспільні упередження, такі як расизм і сексизм, у тексті, який вони створюють. Це тому, що вони навчаються на тексті, взятому з Інтернету, і часто такі тексти містять расистські та сексистські висловлювання. LLM, які вивчають розподіл ймовірностей над таким текстом, стають просякнутими такими ж упередженнями. Дифузійні моделі також навчаються на непідібраних зображеннях, взятих з Інтернету, які можуть містити так само упереджені дані. Не дивно, що поєднання LLM із сучасними дифузійними моделями іноді може призвести до образів, які відображають проблеми суспільства.

Анандкумар має власний досвід. Коли вона спробувала створити стилізовані свої аватари за допомогою програми на основі дифузійної моделі, вона була шокована. «Багато [багато] зображень були дуже сексуалізованими, – сказала вона, – тоді як речі, які вони представляли чоловікам, ні». Вона не сам.

Ці упередження можна зменшити шляхом курування та фільтрації даних (надзвичайно складне завдання, враховуючи величезний набір даних) або перевіряючи як вхідні підказки, так і вихідні дані цих моделей. «Звичайно, ніщо не може замінити ретельного та широкого тестування безпеки» моделі, сказав Хо. «Це важливий виклик для галузі».

Незважаючи на такі побоювання, Анандкумар вірить у силу генеративного моделювання. «Мені дуже подобається цитата Річарда Фейнмана: «Того, що я не можу створити, я не розумію», — сказала вона. Поглиблене розуміння дало змогу її команді розробити генеративні моделі для створення, наприклад, синтетичних навчальних даних для недостатньо представлених класів для прогнозних завдань, таких як темні тони шкіри для розпізнавання обличчя, що допомагає покращити справедливість. Генеративні моделі також можуть дати нам уявлення про те, як наш мозок справляється з шумовими вхідними сигналами або як вони створюють уявні образи та обмірковують майбутні дії. А створення складніших моделей могло б надати штучному інтелекту такі ж можливості.

«Я думаю, що ми лише на початку можливостей того, що ми можемо зробити з генеративним ШІ», — сказав Анандкумар.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. Доступ тут.

- джерело: https://www.quantamagazine.org/the-physics-principle-that-inspired-modern-ai-art-20230105/

- 2014

- 2019

- 2020

- 2021

- 2D

- a

- МЕНЮ

- вище

- За

- дію

- Додає

- аванси

- змагальність

- після

- AI

- ai мистецтво

- алгоритм

- ВСІ

- аналіз

- та

- тварини

- оголошений

- додаток

- підхід

- навколо

- Art

- штучний

- штучний інтелект

- Спроби

- увагу

- аватари

- Оси

- назад

- заснований

- Пляж

- пляжі

- ведмідь

- красивий

- оскільки

- ставати

- перед тим

- початок

- за

- буття

- вважає,

- еталонний тест

- Берклі

- КРАЩЕ

- Краще

- За

- Великий

- Black

- синій

- мізки

- Філія

- прориви

- приніс

- Створюємо

- Каліфорнія

- званий

- Може отримати

- не може

- можливості

- захвати

- обережно

- певний

- виклик

- Перевірки

- класів

- Coca-Cola

- колега

- колеги

- об'єднувати

- об'єднання

- майбутній

- комерційний

- компанія

- порівнянний

- конкурують

- конкурентів

- повністю

- комплекс

- складний

- складається

- комп'ютер

- комп'ютери

- поняття

- Турбота

- З'єднуватися

- Зв'язки

- складати

- Контейнер

- триває

- триває

- Відповідний

- відповідає

- може

- курс

- створювати

- створений

- створення

- вирішальною мірою

- культурний

- кураторство

- темно

- дані

- точки даних

- набір даних

- день

- угода

- продемонстрований

- описувати

- описаний

- description

- розвивати

- DID

- різний

- важкий

- безпосередньо

- Директор

- розподіл

- Розподілу

- собаки

- Не знаю

- DOT

- Падіння

- під час

- кожен

- Раніше

- легко

- фактично

- в іншому місці

- включений

- енергія

- досить

- Весь

- повністю

- Навколишнє середовище

- Рівновага

- Еквівалент

- по суті

- оцінити

- оцінка

- Навіть

- врешті-решт

- НІКОЛИ

- точно

- приклад

- обмін

- збуджений

- Збудження

- захоплюючий

- очікування

- досвід

- обширний

- надзвичайно

- лицьової

- розпізнавання осіб

- справедливість

- кілька

- поле

- фільтрація

- остаточний

- знайти

- виявлення

- Перший

- форми

- Вперед

- знайдений

- часто

- від

- Повний

- повністю

- майбутнє

- ГАН

- породжувати

- генерується

- покоління

- генеративний

- Генеративний ШІ

- генеративна модель

- отримати

- отримання

- Давати

- даний

- Go

- буде

- керує

- градієнти

- випускник

- Відтінки сірого

- великий

- Зростання

- керівництво

- Жорсткий

- сильно

- висота

- допомогу

- найвищий

- дуже

- тримає

- Як

- How To

- Однак

- HTTPS

- ідея

- ідеї

- зображення

- генерація зображень

- зображень

- важливо

- удосконалювати

- поліпшений

- in

- У тому числі

- збільшений

- зростаючий

- індивідуальний

- промисловість

- інформація

- початковий

- спочатку

- вхід

- розуміння

- розуміння

- натхненний

- замість

- Інститут

- Інтелект

- інтерес

- інтернет

- інтуїція

- Винайдений

- IT

- подорож

- ключ

- знання

- відомий

- орієнтир

- мова

- великий

- шарів

- Веде за собою

- УЧИТЬСЯ

- вивчення

- зменшився

- рівні

- життя

- світло

- Ймовірно

- замкнений

- Довго

- подивитися

- виглядає як

- подивився

- ВИГЛЯДИ

- серія

- машина

- навчання за допомогою машини

- made

- зробити

- РОБОТИ

- Робить

- багато

- карти

- матч

- математичний

- математично

- Матерія

- Між тим

- люди

- психічний

- може бути

- мільйона

- помилки

- модель

- моделювання

- Моделі

- сучасний

- молекули

- місяців

- більше

- найбільш

- множинний

- Необхідність

- необхідний

- ні

- мережу

- мереж

- Нейронний

- нейронної мережі

- нейронні мережі

- Нейрони

- Нові

- шум

- нормальний

- роман

- Nvidia

- отриманий

- ONE

- OpenAI

- порядок

- Походження

- оригінал

- Інше

- інші

- фарбувати

- Папір

- параметри

- частина

- пристрасть

- моделі

- ідеальний

- Фізика

- картина

- фотографії

- піксель

- plato

- Інформація про дані Платона

- PlatoData

- гравці

- точка

- точок

- можливостей

- це можливо

- влада

- потужний

- передбачати

- принцип

- Принципи

- друк

- проблеми

- процес

- виробляти

- програма

- поступово

- гордий

- доведений

- забезпечувати

- опублікований

- Поклавши

- якість

- Квантамагазин

- швидко

- расизм

- реалістичний

- зрозумів,

- отримано

- нещодавно

- визнання

- відображати

- відносини

- представник

- Вимагається

- дослідження

- дослідник

- Дослідники

- походить

- обмеження

- результат

- зворотний

- Річард

- міцний

- потрясла

- Зазначений

- то ж

- сценарії

- вчений

- другий

- старший

- Послідовність

- комплект

- приголомшений

- аналогічний

- Аналогічно

- простий

- просто

- Шкіра

- Схил

- сповільнювати

- Повільно

- невеликий

- So

- соціальна

- суспільний

- деякі

- що в сім'ї щось

- складний

- Простір

- відпрацьований

- Spot

- поширення

- Поширення

- стабільний

- Станфорд

- Стенфордський університет

- старт

- стан

- Хитрість

- Крок

- заходи

- Як і раніше

- просто

- сильний

- структура

- структурований

- студент

- Студентам

- Дослідження

- успіх

- успішний

- такі

- поверхню

- перевершив

- синтетичний

- система

- Systems

- Приймати

- приймає

- Завдання

- завдання

- команда

- команди

- технічний

- методи

- Технологія

- terms

- Команда

- світ

- їх

- теплової

- річ

- речі

- думка

- три

- через

- по всьому

- час

- під назвою

- до

- сьогоднішній

- разом

- занадто

- до

- поїзд

- навчений

- Навчання

- перетворень

- вантажівка

- ПЕРЕГЛЯД

- Поворот

- Типи

- розуміти

- розуміння

- одиниць

- університет

- Університет Каліфорнії

- оновлений

- us

- використання

- користувачі

- значення

- Цінності

- різноманітність

- обсяг

- вода

- webp

- Що

- який

- в той час як

- білий

- волі

- слова

- Work

- працював

- робочий

- працює

- світ

- б

- вашу

- зефірнет

- нуль