کی طرف سے تصویر انیل شرما on Pexels

چونکہ اہم رہائی of برٹ اکتوبر 2018 میں، مشین لرننگ نے ہوشیار اصلاح اور بڑھے ہوئے کمپیوٹ کے ذریعے پہلے سے زیادہ بلندیاں حاصل کی ہیں۔ BERT، جس کا مطلب ہے Bidirectional Encoder Representations from Transformers، نے نیورل نیٹ ورک فن تعمیر میں ایک نیا نمونہ متعارف کرایا۔ دی ٹرانسفارمر مشین سیکھنے کی صلاحیتوں میں ایک اہم انلاک کے طور پر کام کیا ہے۔

نیچرل لینگویج پروسیسنگ (NLP) کے میدان میں مزید پیشرفت نے غیر ملکی زبان کے ترجمے کو بہتر بنایا ہے، بغیر کوڈ کی ایپلی کیشنز کو بڑھایا ہے، چیٹ بوٹس کی روانی میں اضافہ کیا ہے، اور بہت جلد جدید ترین معیارات کے لیے نئے معیارات قائم کیے ہیں۔

ان نمایاں کامیابیوں کے ساتھ ساتھ، بڑے لینگوئج ماڈلز (LLMs) کی ترقی بھی تنازعات کے بغیر نہیں رہی۔ 2021 میں "اسٹاکسٹک طوطے۔” پیپر، مشین لرننگ انجینئر اور ماہر اخلاق ٹمنیٹ گیبرو سمیت محققین کی ایک ٹیم نے ان ماڈلز پر تنقید کی:

- لعنت لگانا ماحولیاتی لاگت

- پسماندہ آوازوں کو چھوڑ کر تربیتی ڈیٹا سیٹ کی غیر موزوں کیوریشن کے ذریعے

- سرقہ کرنا انٹرنیٹ مواد اور انسانی مصنفین سے چوری

گیبرو کو گوگل کی ایتھیکل آرٹیفیشل انٹیلی جنس ٹیم میں ان کے عہدے سے برطرف کر دیا گیا تھا۔

اس تحریر میں

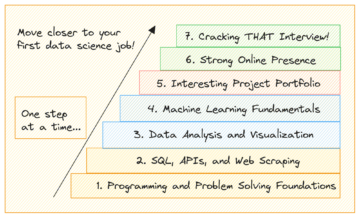

ہم پچھلے سال میں شائع ہونے والے چار NLP پیپرز کو دریافت کرتے ہیں جو تازہ ترین پیشرفت کی نمائندگی کرتے ہیں۔ ان پیشرفتوں کو سمجھنا ایک ڈیٹا سائنسدان کے طور پر آپ کی صلاحیتوں کو بہتر بنائے گا اور آپ کو اس متحرک تحقیقی جگہ میں سب سے آگے رکھے گا۔

یہ مقالہ ٹرانسفارمر آرکیٹیکچر کا استعمال کرتے ہوئے لینگویج ماڈل کے لیے مثالی ماڈل سائز اور ٹوکن کی گنتی کا جائزہ لیتا ہے۔ اس کا مقصد اس سوال کا جواب دینا ہے کہ پہلے سے طے شدہ کمپیوٹ بجٹ کے تحت تربیت یافتہ ماڈل کے لیے پیرامیٹرز کی مثالی تعداد اور ڈیٹا سیٹ کا سائز کیا ہوتا ہے۔

محققین نے پایا کہ پہلے کے معاملات میں، ایسا لگتا ہے کہ ایل ایل ایم کو سخت تربیت دی گئی ہے۔ مصنفین ان ٹیموں پر تنقید کرتے ہیں کہ وہ کمپیوٹ وسائل کی پیمائش پر زیادہ زور دیتے ہیں جبکہ تربیتی ڈیٹا کے حجم کی اہمیت کو کم کرتے ہیں۔

مصنفین نے یہ نتیجہ اخذ کیا کہ کمپیوٹ کی بہترین تربیت کے لیے، ماڈل کا سائز اور ٹریننگ ٹوکن کی تعداد کو برابر کیا جانا چاہیے۔ دوسرے الفاظ میں،

ماڈل سائز کے ہر دوگنا ہونے کے لیے، ٹریننگ ٹوکن کی تعداد کو بھی دوگنا کیا جانا چاہیے۔

تحقیق سے پتہ چلتا ہے کہ 70 گنا زیادہ تربیتی ڈیٹا پر تربیت یافتہ نسبتاً چھوٹا ماڈل (4B پیرامیٹرز) جدید ترین بینچ مارک ٹیسٹ جیسے کہ ملٹی ٹاسک لینگویج انڈرسٹینڈنگ میں بڑے ماڈلز (530B پیرامیٹرز تک) کو مسلسل شکست دے سکتا ہے۔ایم ایم ایل یو).

بہتر تربیتی ڈیٹا چھوٹے ماڈل کو اندازہ لگانے اور ٹھیک ٹیوننگ کے لیے نمایاں طور پر کم کمپیوٹ وسائل استعمال کرنے کی اجازت دیتا ہے۔ یہ نیچے دھارے کے استعمال کے لیے اچھی بات ہے۔

TL؛ ڈاکٹر - اس مقالے سے پتہ چلتا ہے کہ اسکیلنگ کے قوانین کی پیشگی سمجھ غلط تھی۔ درحقیقت، جب مناسب طریقے سے وسیع ٹوکن گنتی کے ساتھ تربیت دی جاتی ہے، تو چھوٹے نیٹ ورک بڑے نیٹ ورکس سے نمایاں طور پر بہتر ہو سکتے ہیں۔

LLMs کو فراہم کردہ کمپیوٹ کو بڑھانے سے صارف کے ارادے کی ترجمانی کرنے کی ان کی صلاحیت خود بخود بہتر نہیں ہوتی ہے۔ اس حقیقت کے پریشان کن نتیجے کے طور پر، LLMs ایسے نتائج فراہم کر سکتے ہیں جو غلط یا نقصان دہ ہوں۔

یہ مقالہ مختلف قسم کے کاموں میں صارف کے ارادے کے ساتھ آؤٹ پٹ کو بہتر طریقے سے سیدھ میں کرنے کے لیے انسانی تاثرات کا استعمال کرتے ہوئے زبان کے ماڈلز کو ٹھیک کرنے کے لیے ایک نئے طریقہ پر روشنی ڈالتا ہے۔

محققین نے OpenAI API پرامپٹس کے مجموعے سے شروع ہونے والا ڈیٹاسیٹ اکٹھا کیا۔ اس کے بعد وہ زیر نگرانی سیکھنے کے ذریعے GPT-3 کو ٹھیک کرنے کے لیے ڈیٹا کا استعمال کرتے ہیں۔ پھر، صارف کے ان پٹ کی بنیاد پر کمک سیکھنے کا استعمال کرتے ہوئے، انہوں نے ایک نیا ڈیٹاسیٹ درجہ بندی ماڈل آؤٹ پٹ تیار کیا۔ اس کے بعد محققین نے اس ڈیٹا کو زیر نگرانی ماڈل کو مزید بہتر بنانے کے لیے استعمال کیا، جس کے نتیجے میں وہ ایک ماڈل بنتا ہے جسے وہ InstructGPT کہتے ہیں۔

اصل GPT-3 کے مقابلے، InstructGPT کے پاس 100 گنا کم پیرامیٹر ہیں، اور پھر بھی یہ انسانی تشخیص میں GPT-3 کو پیچھے چھوڑنے کے قابل ہے۔

ٹیسٹ کے اعداد و شمار پر، InstructGPT ماڈل کا ایمانداری سے جواب دینے کا زیادہ امکان ہے اور نقصان دہ مواد تخلیق کرنے کا امکان کم ہے۔ اگرچہ InstructGPT اب بھی کبھی کبھار بنیادی غلطیاں کرتا ہے، لیکن یہ نتائج ظاہر کرتے ہیں کہ انسانی ارادے کے ساتھ لینگویج ماڈلز کو ملانے کے لیے ہیومن-ان-دی-لوپ کے ساتھ فائن ٹیوننگ ایک قابل عمل راستے کے طور پر کام کرتی ہے۔

TL؛ ڈاکٹر — یہ مقالہ ظاہر کرتا ہے کہ انسانی تاثرات کے ساتھ کمک سیکھنا موجودہ ماڈلز کو مزید کارآمد بنانے کا ایک انتہائی مددگار، کم وسائل والا طریقہ ہے۔

اس مقالے میں بہتریوں کی کھوج کی گئی ہے جس کے نتیجے میں ایک ماڈل اٹاری چلانے، تصویروں کی سرخی لگانے، متن بنانے، روبوٹ بازو کا استعمال کرتے ہوئے جسمانی بلاکس کو اسٹیک کرنے اور بہت کچھ کرنے کے قابل ہے۔

ماڈل، گیٹو، ایک واحد نیورل نیٹ ورک پر مشتمل ہے جس میں مختلف کاموں میں کوئی تبدیلی نہیں کی گئی ہے۔

گیٹو کا نتیجہ سکیل اپ رویے کی کلوننگ سے ہوا، جو ترتیب ماڈلنگ چیلنج کی ایک شکل ہے۔ ٹوکنز کے ایک واحد ویکٹر اسپیس میں بہت سے طریقوں کو انکوڈنگ کرنے کا چیلنج محققین کو اپنی کوششوں میں درپیش سب سے اہم رکاوٹ ہے۔ یہ مطالعہ معیاری وژن اور زبان کے ڈیٹاسیٹس کے ٹوکنائزیشن میں متعدد پیشرفت کرتا ہے۔ اس کے علاوہ، محققین نے سیاق و سباق کی کھڑکی کی لمبائی کا تعین کرنے کے مخصوص ترتیب ماڈل کے مسئلے کا نیا حل تلاش کیا۔

TL؛ ڈاکٹر - اس مقالے سے پتہ چلتا ہے کہ ملٹی موڈل ماڈل بہت اچھی طرح سے ہوسکتے ہیں اور ممکنہ طور پر ماڈلنگ پیراڈائم کا مستقبل ہیں۔ پچھلے جدید ترین ماڈلز کے برعکس جو صرف ایک تنگ علاقے میں کارکردگی کا مظاہرہ کرنے کے قابل تھے، گیٹو ایک عمومی پالیسی پر عمل درآمد کرتا ہے جو مختلف کاموں اور متعدد طریقوں کی اہلیت رکھتا ہے۔

LLMs قابل ذکر چند شاٹ سیکھنے والے ہیں جو تنگ، کام کے لیے مخصوص مثالیں استعمال کرتے ہیں۔ یہ تحقیقی مقالہ یہ ظاہر کرتا ہے کہ LLMs بھی قابل زیرو شاٹ ریجنرز ہیں، خاص طور پر جب اس جملے کے ساتھ اشارہ کیا جائے، "آئیے قدم بہ قدم سوچیں۔"

جی ہاں، آپ کو اس کا حق پڑھ.

LLM کو "قدم قدم سوچنے" کی ہدایت دینا دراصل کسی کاغذ کو درست ثابت کرنے کے لیے نتائج کو کافی بہتر بناتا ہے۔

مصنفین کوجیما ایٹ ال کے ذریعہ تخلیق کردہ ماڈل۔ استدلال کے کاموں پر موجودہ معیارات کو پیچھے چھوڑ دیا، جیسے ریاضی (مثلاً، ملٹی آرتھ، GSM8K، AQUA-RAT، SVAMP)، علامتی استدلال (مثال کے طور پر، آخری خط، سکے کا پلٹنا)، اور منطقی استدلال (مثلاً، تاریخ کو سمجھنا، شفل شدہ اشیاء کا سراغ لگانا)۔

استدلال کے کاموں کی ایک وسیع رینج پر اس واحد پرامپٹ کی موافقت، "قدم قدم سوچو" سے پتہ چلتا ہے کہ صفر شاٹ کی مہارتوں کو پہلے نمایاں طور پر کم استعمال کیا گیا تھا۔ قابل ذکر طور پر اعلیٰ سطحی، کثیر کام کی صلاحیتوں کو صرف اس مسئلے کی لسانی ڈھانچہ استعمال کرکے حاصل کیا جاسکتا ہے جو زیادہ علمی بوجھ کی درخواست کرتا ہے۔

میرا دماغ اڑا ہوا ہے۔

TL؛ DR - یہ کاغذ ظاہر کرتا ہے کہ ایل ایل ایم کے جواب کا معیار زیادہ تر پرامپٹ کے الفاظ پر منحصر ہوتا ہے۔

خلاصہ

پچھلے چار سالوں میں مشین لرننگ میں نمایاں ترقی ہوئی ہے۔ وقت ہی بتائے گا کہ کیا ترقی کی یہ رفتار برقرار رہ سکتی ہے۔

یہ مقالے NLP میں تازہ ترین بہتریوں پر بحث کرتے ہیں، جس سے تربیتی عمل میں مسلسل بہتری کے لیے کافی گنجائش موجود ہے تاکہ بڑے ڈیٹا سیٹس اور ہیومن ان دی لوپ کمک سیکھنے کو شامل کیا جا سکے۔

حالیہ تحقیق ماڈل کے ان پٹ پرامپٹس میں سادہ تبدیلیوں کے ذریعے ملٹی موڈل پیراڈائمز کی تخلیق اور صفر شاٹ استدلال کی صلاحیتوں کو بھی دریافت کرتی ہے۔

نکول جین وے بلز تجارتی اور وفاقی مشاورت کا تجربہ رکھنے والا ڈیٹا سائنسدان ہے۔ وہ تنظیموں کو اپنے اعلیٰ اثاثے سے فائدہ اٹھانے میں مدد کرتی ہے: ایک سادہ اور مضبوط ڈیٹا حکمت عملی۔

حقیقی. اجازت کے ساتھ دوبارہ پوسٹ کیا۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو بلاک چین۔ Web3 Metaverse Intelligence. علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.kdnuggets.com/2023/03/must-read-nlp-papers-last-12-months.html?utm_source=rss&utm_medium=rss&utm_campaign=must-read-nlp-papers-from-the-last-12-months

- 100

- 12 ماہ

- 2018

- 2021

- a

- کی صلاحیت

- کامیابیاں

- حاصل کیا

- ACM

- کے پار

- اصل میں

- اس کے علاوہ

- اعلی درجے کی

- ترقی

- مقصد ہے

- کی اجازت دیتا ہے

- اور

- جواب

- اے پی آئی

- ایپلی کیشنز

- فن تعمیر

- رقبہ

- بازو

- لڑی

- فن

- مصنوعی

- مصنوعی ذہانت

- جائزوں

- اثاثے

- اٹاری

- اضافہ

- مصنفین

- خود کار طریقے سے

- رکاوٹ

- کی بنیاد پر

- بنیادی

- معیار

- معیارات

- بہتر

- بلاکس

- بجٹ

- کہا جاتا ہے

- صلاحیتوں

- صلاحیت رکھتا

- مقدمات

- چیلنج

- چیٹ بٹس

- سنجیدگی سے

- سکے

- مجموعہ

- تجارتی

- competent,en

- پر مشتمل

- کمپیوٹنگ

- یہ نتیجہ اخذ کیا

- کافی

- مشاورت

- مواد

- سیاق و سباق

- جاری رہی

- اس کے برعکس

- تنازعات

- سکتا ہے

- تخلیق

- بنائی

- مخلوق

- کیپشن

- اعداد و شمار

- ڈیٹا سائنسدان

- ڈیٹا سیٹ

- ڈیٹا کی حکمت عملی

- ڈیٹاسیٹس

- تاریخ

- مظاہرہ

- ثبوت

- انحصار

- کا تعین کرنے

- ترقی

- رفت

- بات چیت

- کر

- دگنی

- دگنا کرنے

- متحرک

- کوششوں

- انجینئر

- بہتر

- کافی

- ماحولیاتی

- یکساں طور پر

- نقائص

- Ether (ETH)

- اخلاقی

- کبھی نہیں

- ہر کوئی

- امتحانات

- مثال کے طور پر

- پھانسی

- موجودہ

- تجربہ

- تلاش

- وسیع

- انتہائی

- سامنا

- وفاقی

- آراء

- میدان

- پلٹائیں

- سب سے اوپر

- غیر ملکی

- فارم

- ملا

- سے

- مزید

- مستقبل

- پیدا

- پیدا کرنے والے

- گوگل

- زیادہ سے زیادہ

- نقصان دہ

- اونچائی

- مدد گار

- مدد کرتا ہے

- اعلی سطحی

- اعلی

- پر روشنی ڈالی گئی

- ہنسی

- HTTPS

- انسانی

- مثالی

- اہمیت

- کو بہتر بنانے کے

- بہتر

- بہتری

- بہتری

- بہتر ہے

- in

- دیگر میں

- سمیت

- اضافہ

- ان پٹ

- انٹیلی جنس

- ارادے

- انٹرنیٹ

- متعارف

- شامل

- IT

- KDnuggets

- کوجیما

- زبان

- بڑے

- بڑے پیمانے پر

- بڑے

- آخری

- تازہ ترین

- قوانین

- سیکھنے

- لمبائی

- خط

- لیوریج

- امکان

- لنکڈ

- لوڈ

- منطقی

- مشین

- مشین لرننگ

- بنا

- بناتا ہے

- بہت سے

- کے ملاپ

- طریقہ

- برا

- ماڈل

- ماڈلنگ

- ماڈل

- ماہ

- زیادہ

- سب سے زیادہ

- ایک سے زیادہ

- ضرور پڑھنا

- قدرتی

- قدرتی زبان

- قدرتی زبان عملیات

- نیٹ ورک

- نیٹ ورک

- عصبی

- عصبی نیٹ ورک

- نئی

- ویزا

- ناول

- تعداد

- اشیاء

- کبھی کبھار

- اکتوبر

- اوپنائی

- اصلاح کے

- تنظیمیں

- اصل

- دیگر

- باہر نکلنا

- امن

- کاغذ.

- کاغذات

- پیرا میٹر

- پیرامیٹرز

- خاص طور پر

- گزشتہ

- کارکردگی کا مظاہرہ

- اجازت

- جسمانی

- تصاویر

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- کھیل

- پالیسی

- پوزیشن

- پچھلا

- پہلے

- پہلے

- مسئلہ

- عمل

- پروسیسنگ

- مناسب طریقے سے

- فراہم

- فراہم

- شائع

- ڈال

- معیار

- سوال

- جلدی سے

- رینج

- رینکنگ

- پڑھیں

- قابو پانے کی تعلیم

- نسبتا

- قابل ذکر

- کی نمائندگی

- درخواستوں

- تحقیق

- محققین

- وسائل

- جواب

- نتیجے

- نتائج کی نمائش

- انکشاف

- میں روبوٹ

- روبوٹ بازو

- مضبوط

- کمرہ

- روٹ

- سکیلنگ

- سائنسدان

- تسلسل

- کام کرتا ہے

- مقرر

- ہونا چاہئے

- شوز

- اہم

- نمایاں طور پر

- سادہ

- صرف

- ایک

- سائز

- مہارت

- چھوٹے

- چھوٹے

- حل

- خلا

- اسٹیکنگ

- معیار

- معیار

- کھڑا ہے

- شروع

- ریاستی آرٹ

- مرحلہ

- ابھی تک

- حکمت عملی

- مطالعہ

- اس طرح

- پتہ چلتا ہے

- زیر نگرانی سیکھنے

- حد تک

- مسلسل

- کاموں

- ٹیم

- ٹیموں

- ٹیسٹ

- ٹیسٹ

- ۔

- مستقبل

- ان

- سوچو

- کے ذریعے

- وقت

- اوقات

- کرنے کے لئے

- ٹوکن

- ٹوکن بنانا

- ٹوکن

- سب سے اوپر

- ٹریکنگ

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمرز

- ترجمہ

- پریشانی

- ٹھیٹھ

- کے تحت

- افہام و تفہیم

- انلاک

- رکن کا

- استعمال

- مختلف اقسام کے

- کی طرف سے

- قابل عمل

- نقطہ نظر

- حجم

- کیا

- جس

- جبکہ

- وسیع

- وسیع رینج

- گے

- بغیر

- الفاظ

- الفاظ

- سال

- سال

- اور

- زیفیرنیٹ