Введение

Mixtral 8x22B — новейшая открытая модель, выпущенная Mistral AI, устанавливающая новый стандарт производительности и эффективности в отрасли. сообщество ИИ. Это специализированная модель, в которой используется подход «Смешение экспертов», использующий только 39 миллиардов активных параметров из 141 миллиарда, что обеспечивает исключительную экономическую эффективность для ее размера. Модель демонстрирует многоязычный свободное владение английским, французским, итальянским, немецким и испанским языками. Он демонстрирует высокие показатели в понимании языка, рассуждениях и знаниях, превосходя другие открытые модели в различных задачах здравого смысла, рассуждений и оценки знаний. Кроме того, Mixtral 8x22B оптимизирован для кодирование и математические задачи, что делает его мощным сочетанием языковых, рассуждений и возможностей кода.

Непревзойденная производительность во всех тестах

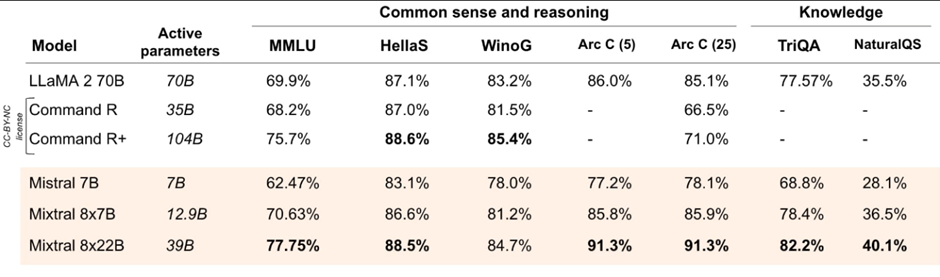

Mixtral 8x22B, новейшая открытая модель от Mistral AI, демонстрирует непревзойденную производительность в различных тестах. Вот как он устанавливает новый стандарт эффективности и возможностей ИИ.

Рассуждение и владение знаниями

Mixtral 8x22B оптимизирован для рассуждений и усвоения знаний, превосходя другие открытые модели в задачах критического мышления. Его разреженная модель Mixture-of-Experts (SMoE) с 39B активных параметров из 141B обеспечивает эффективную обработку и превосходную производительность на основе широко распространенного здравого смысла, рассуждениеи критерии знаний. Способность модели точно извлекать информацию из больших документов с помощью контекстного окна из 64 XNUMX токенов еще раз демонстрирует ее мастерство в рассуждениях и интеллектуальных задачах.

Многоязычный блеск

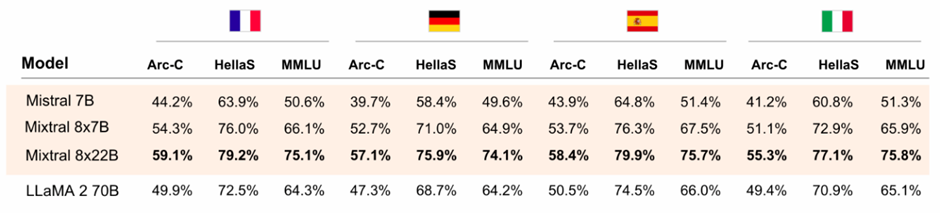

Благодаря встроенным многоязычным возможностям Mixtral 8x22B отлично работает на нескольких языках, включая английский, французский, итальянский, немецкий и испанский. Производительность модели в тестах на французском, немецком, испанском и итальянском языках превосходит показатели других открытых моделей. Это демонстрирует его доминирование в многоязычном понимании и обработке. Эта возможность делает Mixtral 8x22B универсальным и мощным инструментом для приложений, требующих многоязычной поддержки.

Мастер математики и программирования

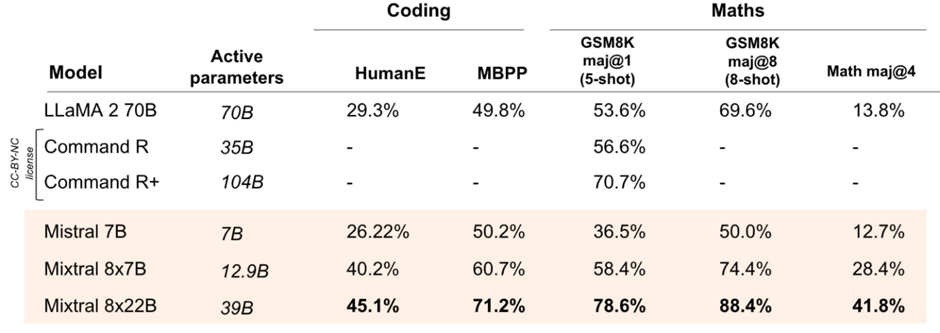

Mixtral 8x22B демонстрирует исключительные навыки в технических областях, таких как математика и программирование. Его производительность в популярных тестах кодирования и математических вычислений, включая GSM8K и Math, превосходит показатели ведущих открытых моделей. Постоянное улучшение математических показателей модели (78.6% по GSM8K maj8 и 4% по Math maj41.8) укрепляет ее позиции как гения в математике и кодировании. Такое качество делает Mixtral 8x22B идеальным выбором для приложений, требующих расширенных математических возможностей и возможностей кодирования.

Почему Mixtral 8x22B имеет значение

Mixtral 8x22B — важная разработка в области искусственного интеллекта. Его природа с открытым исходным кодом предлагает значительные преимущества разработчикам и организациям. Лицензия Apache 2.0, под которой он выпущен, допускает неограниченное использование и модификацию. Это делает его ценным ресурсом для инноваций и сотрудничества в сообществе ИИ. Эта лицензия гарантирует разработчикам свободу использовать Mixtral 8x22B в широком спектре приложений без каких-либо ограничений, тем самым поощряя творчество и прогресс в технологиях искусственного интеллекта во всех отраслях.

Находка для разработчиков и организаций

Выпуск Mixtral 8x22B под лицензией Apache 2.0 является значительным благом как для разработчиков, так и для организаций. Благодаря непревзойденной экономической эффективности и высокой производительности Mixtral 8x22B предоставляет разработчикам уникальную возможность использовать расширенные возможности искусственного интеллекта в своих приложениях. Его знание нескольких языков, высокие результаты в математических задачах и задачах кодирования, а также оптимизированные возможности рассуждения делают его полезным инструментом для разработчиков, стремящихся улучшить функциональность своих решений на основе искусственного интеллекта. Кроме того, организации могут воспользоваться преимуществами открытого исходного кода Mixtral 8x22B, включив его в свой технологический стек. Это поможет им обновить свои приложения и откроет новые возможности для развития на основе ИИ.

Заключение

Последняя модель Mistral AI устанавливает новый стандарт производительности и эффективности в сообществе ИИ. Его разреженная модель Mixture-of-Experts (SMoE) использует только 39 миллиардов активных параметров из 141 миллиарда. Это обеспечивает беспрецедентную экономическую эффективность для своего размера. Многоязычные возможности модели, а также ее сильные математические возможности и возможности кодирования делают ее универсальным инструментом для разработчиков. Mixtral 8x22B превосходит другие открытые модели в программировании и математических задачах, демонстрируя свой потенциал совершить революцию в разработке искусственного интеллекта. Выпуск Mixtral 8x22B под лицензией с открытым исходным кодом Apache 2.0 еще больше способствует инновациям и сотрудничеству в области искусственного интеллекта. Ее эффективность, многоязычная поддержка и превосходная производительность делают эту модель значительным достижением в области искусственного интеллекта.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.analyticsvidhya.com/blog/2024/04/mixtral-8x22b-by-mistral-ai/

- :является

- 2%

- 39

- 41

- a

- способность

- через

- активный

- Дополнительно

- продвинутый

- продвижение

- достижения

- плюс

- Преимущества

- AI

- Стремясь

- одинаково

- позволяет

- вдоль

- an

- и

- любой

- апаш

- Приложения

- подхода

- AS

- оценки;

- тесты

- миллиард

- Бленд

- by

- CAN

- возможности

- возможности

- выбор

- код

- Кодирование

- сотрудничество

- Общий

- здравый смысл

- сообщество

- контекст

- (CIJ)

- Цена

- креативность

- критической

- демонстрирует

- демонстрирующий

- застройщиков

- Развитие

- Документация

- доменов

- Господство

- затрат

- эффективный

- работает

- включить

- позволяет

- поощрение

- Английский

- обеспечивает

- Эфир (ETH)

- выделяется

- исключительный

- Экспонаты

- поле

- Что касается

- Freedom

- Французский

- от

- функциональность

- далее

- Немецкий

- Есть

- помощь

- High

- Как

- HTTPS

- идеальный

- важную

- улучшать

- улучшение

- in

- В том числе

- включения

- промышленности

- информация

- Инновации

- в

- IT

- Итальянский

- ЕГО

- JPG

- знания

- язык

- Языки

- большой

- последний

- ведущий

- Кредитное плечо

- Лицензия

- недостатки

- сделать

- ДЕЛАЕТ

- Создание

- математике

- математический

- математика

- модель

- Модели

- с разными

- родной

- природа

- Новые

- of

- Предложения

- on

- только

- открытый

- с открытым исходным кодом

- операционный

- Возможности

- Возможность

- оптимизированный

- организации

- Другое

- внешний

- превосходя

- Превосходит

- параметры

- производительность

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Популярное

- должность

- потенциал

- мощный

- Точно

- разрабатывает

- обработка

- Прогресс

- способствует

- обеспечение

- ассортимент

- рассуждение

- освободить

- выпустил

- ресурс

- революционизировать

- s

- Гол

- смысл

- Наборы

- установка

- Витрины

- значительный

- Размер

- затвердевает

- Решения

- Испанский

- редкий

- специализированный

- стек

- стандарт

- сильный

- такие

- топ

- поддержка

- превосходит

- превосходящие

- взять

- задачи

- Технический

- Технологии

- который

- Ассоциация

- их

- Их

- тем самым

- мышление

- этой

- в

- Лексемы

- инструментом

- под

- понимание

- созданного

- бесподобный

- беспрецедентный

- неограниченный

- Обновление ПО

- Применение

- использование

- полезный

- использования

- Использующий

- ценный

- различный

- разносторонний

- который

- широкий

- Широкий диапазон

- широко распространена

- окно

- в

- без

- бы

- зефирнет