Amazon EU Design and Construction (Amazon D&C) -tiimi on insinööritiimi, joka suunnittelee ja rakentaa Amazon Warehouse -varastoja kaikkialla Euroopassa ja MENA-alueella. Projektien suunnittelu- ja käyttöönottoprosessit sisältävät monenlaisia tietopyyntöjä (RFI) Amazonin suunnitteluvaatimuksista ja projektikohtaisista ohjeista. Nämä pyynnöt vaihtelevat yksinkertaisesta suunnittelun perusarvojen hakemisesta arvosuunnitteluehdotusten tarkasteluun, raporttien analysointiin ja vaatimustenmukaisuuden tarkastuksiin. Nykyään niitä käsittelee keskustekninen ryhmä, joka koostuu aiheasiantuntijoista (pk-yrityksistä), jotka voivat vastata tällaisiin erittäin teknisiin erikoiskysymyksiin ja tarjota tätä palvelua kaikille sidosryhmille ja ryhmille koko projektin elinkaaren ajan. Joukkue etsii a generatiivinen tekoäly kysymykseen vastausratkaisu saadaksesi nopeasti tietoa ja jatkaaksesi suunnittelua. Erityisesti nämä käyttötapaukset eivät rajoitu pelkästään Amazon D&C -tiimiin, vaan niitä voidaan soveltaa laajempaan globaalien suunnittelupalveluiden piiriin, jotka osallistuvat projektin käyttöönottoon. Koko projektin elinkaaren aikana mukana olevat sidosryhmät ja tiimit voivat hyötyä generatiivisesta tekoälyn kysymysvastausratkaisusta, sillä se mahdollistaa nopean pääsyn kriittiseen tietoon ja virtaviivaistaa suunnittelu- ja projektinhallintaprosesseja.

Nykyiset generatiiviset tekoälyratkaisut kysymyksiin vastaamiseen perustuvat pääasiassa Haku laajennettu sukupolvi (RÄTTI). RAG etsii asiakirjoja suuri kielimalli (LLM) upotus ja vektorointi, luo kontekstin hakutuloksista klusteroinnin kautta ja käyttää kontekstia lisättynä kehotteena päätelläkseen perusmallin vastauksen saamiseksi. Tämä menetelmä on vähemmän tehokas Amazon D&C:n erittäin teknisille asiakirjoille, jotka sisältävät merkittäviä jäsentämättömiä tietoja, kuten Excel-taulukoita, taulukoita, luetteloita, kuvioita ja kuvia. Tässä tapauksessa kysymykseen vastaustehtävä toimii paremmin hienosäätämällä LLM:ää asiakirjoilla. Hienosäätö säätää ja mukauttaa esikoulutetun LLM:n painoja mallin laadun ja tarkkuuden parantamiseksi.

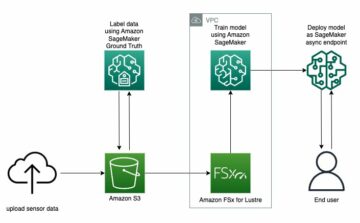

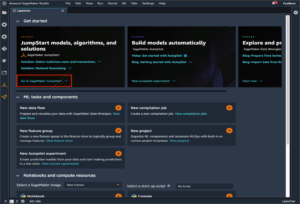

Vastataksemme näihin haasteisiin esittelemme uuden kehyksen RAG:n ja hienosäädetyillä LLM:illä. Ratkaisu käyttää Amazon SageMaker JumpStart mallin hienosäädön ja päättelyn ydinpalveluna. Tässä viestissä emme vain tarjoa ratkaisua, vaan myös keskustelemme opituista kokemuksista ja parhaista käytännöistä, kun otamme ratkaisun käyttöön tosielämän käyttötapauksissa. Vertailemme ja vertailemme eri metodologioiden ja avoimen lähdekoodin LLM:ien toimintaa käyttötapauksessamme ja keskustelemme siitä, kuinka löytää kompromissi mallin suorituskyvyn ja resurssikustannusten laskemisen välillä.

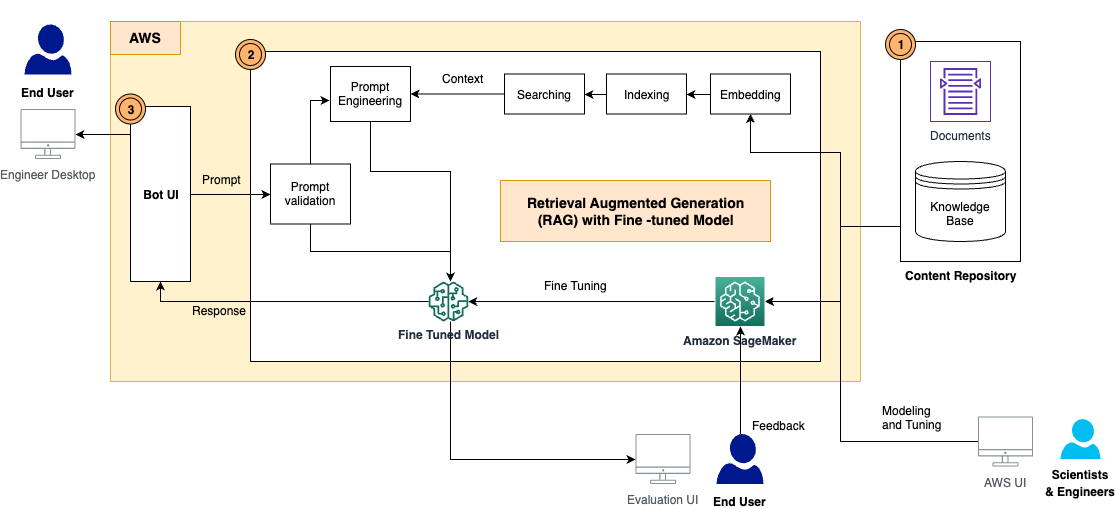

Ratkaisun yleiskatsaus

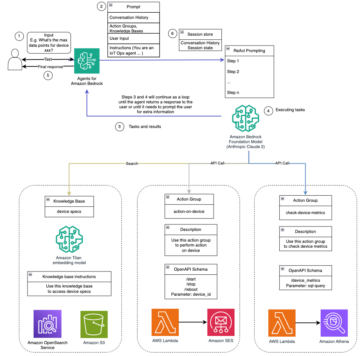

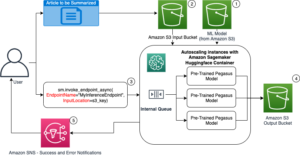

Ratkaisu sisältää seuraavat komponentit, kuten arkkitehtuurikaaviossa näkyy:

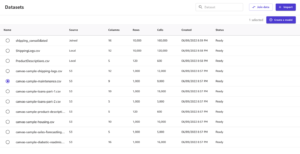

- Sisältövarasto – D&C-sisältö sisältää laajan valikoiman ihmisen luettavia asiakirjoja eri muodoissa, kuten PDF-tiedostoja, Excel-arkkeja, wikisivuja ja paljon muuta. Tässä ratkaisussa olemme tallentaneet nämä sisällöt Amazonin yksinkertainen tallennuspalvelu (Amazon S3) ämpäri ja käytti niitä tietopohjana tiedonhakuun ja päättelyyn. Tulevaisuudessa rakennamme integraatiosovittimia, joilla pääset sisältöön suoraan heidän asuinpaikastaan.

- RAG-kehys hienosäädetyllä LLM:llä – Tämä koostuu seuraavista osakomponenteista:

- RAG-kehys – Tämä hakee asiaankuuluvat tiedot asiakirjoista, täydentää kehotteita lisäämällä haetut tiedot kontekstiin ja välittää ne hienosäädetylle LLM:lle tulosteiden luomiseksi.

- Hienosäädetty LLM – Rakensimme asiakirjoista ja sisällöistä koulutusaineiston ja teimme perusmallin hienosäädön. Virityksen jälkeen malli oppi tiedon D&C-sisällöstä ja voi siten vastata kysymyksiin itsenäisesti.

- Nopea vahvistusmoduuli – Tämä mittaa semanttista vastaavuutta käyttäjän kehotteen ja hienosäädön tietojoukon välillä. Jos LLM on hienosäädetty vastaamaan tähän kysymykseen, voit päätellä hienosäädetyn mallin vastauksen saamiseksi. Jos ei, voit käyttää RAG:ta vastauksen luomiseen.

- LangChain - Käytämme LangChain rakentaa työnkulku vastaamaan saapuviin kysymyksiin.

- Loppukäyttäjän käyttöliittymä – Tämä on chatbotin käyttöliittymä, joka tallentaa käyttäjien kysymykset ja kyselyt ja esittää vastaukset RAG- ja LLM-vastauksista.

Seuraavissa osissa esittelemme, kuinka luodaan RAG-työnkulku ja rakennetaan hienosäädetyt mallit.

SageMaker JumpStartin RAG pohjamalleilla

RAG yhdistää valmiiksi koulutetun tiheän haun ja sekvenssistä sekvenssiin (seq2seq) perustamismallien voimat. Jotta voimme vastata kysymyksiin Amazon D&C -asiakirjoista, meidän on valmisteltava seuraavat asiat etukäteen:

- Asiakirjojen upottaminen ja indeksointi LLM-upotusmallilla – Jaoimme useat asiakirjat pieniksi paloiksi asiakirjan luvun ja osion rakenteen perusteella, testasimme Amazon GPT-J-6B -mallilla SageMaker JumpStartissa indeksien luomiseksi ja tallensimme indeksit FAISS-vektorisäilöön.

- Valmiiksi koulutettu perusmalli, joka tuottaa vastauksia kehotteisiin – Testasimme Flan-T5 XL-, Flan-T5 XXL- ja Falcon-7B-malleilla SageMaker JumpStartissa

Kysymysten vastausprosessin toteuttaa LangChain, joka on puitteet kielimalleilla toimivien sovellusten kehittämiseen. Ketjun työnkulku sisältää seuraavat vaiheet:

- Kysy käyttäjältä.

- Suorita semanttinen haku indeksoiduista asiakirjoista läpi FAISS saadaksesi K tärkeintä asiakirjapalaa.

- Määritä kehotemalli, kuten

- Laajenna haettuja asiakirjan paloja

{context}ja käyttäjän kysymys{question}kehotteessa. - Kehota perustusmallia konstruoidulla zero-shot -kehotteella.

- Palauta mallin tulos käyttäjälle.

Testasimme 125 kysymystä Amazon D&C -vaatimuksista ja -määrityksistä, ja RAG vastasi joihinkin kysymyksiin hyvällä tavalla. Seuraavassa esimerkissä RAG Flan-T5-XXL-mallilla antoi tarkan vastauksen asiakirjojen oikeista osista.

| Kysymys | Mitkä ovat juomasuihkulähteiden ja vedenjäähdyttimien LVI-vaatimukset? (Pääluokka 22 47 00) |

| Odotettu vastaus | Kehittäjä toimittaa vesiannostelijat, lattian seisovat Varaston seinätilaan välittömästi jokaisen varastoa palvelevan wc-lohkon sisäänkäynnin viereen ja vastaavaan paikkaan Pukuhuoneen wc-lohkon viereen. Yksiköiden tulee olla Amazon-standardin mukaisia. Lopulliset numerot ja sijoitus sovittava Amazonin kanssa ennen asennusta. Vähintään kaksi yksikköä, jotka antavat jäähdytettyä ja huoneenlämpöistä vettä jokaiseen paikkaan. Vesijäähdyttimet tai vesipatukat – Kehittäjän on tarjottava juomavettä tarpeen mukaan etävesijäähdyttimille tai vesibaareille kaikkialla laitoksessa. Kehittäjä huolehtii vesipisteistä, viemäröinnistä ja mahdollisista sähköpalveluista, joita vaaditaan vesibaarien taukotiloissa, jotka ateriaurakoitsija toimittaa. |

| RAG-vastaus (GPT-J-6B upotus Flan-T5-XXL:n kanssa) | Kehittäjä toimittaa vesiannostelijat, lattian seisovat Varaston seinätilaan välittömästi jokaisen varastoa palvelevan wc-lohkon sisäänkäynnin viereen ja vastaavaan paikkaan Pukuhuoneen wc-lohkon viereen. Yksiköiden tulee olla Amazon-standardin mukaisia. Lopulliset numerot ja sijoitus sovittava Amazonin kanssa ennen asennusta. Vähintään kaksi yksikköä, jotka antavat jäähdytettyä ja huoneenlämpöistä vettä jokaiseen paikkaan. Vesijäähdyttimet tai vesipatukat – Kehittäjän on tarjottava juomavettä tarpeen mukaan etävesijäähdyttimille tai vesibaareille kaikkialla laitoksessa. Kehittäjä huolehtii vesipisteistä, viemäröinnistä ja mahdollisista sähköpalveluista, joita vaaditaan vesibaarien taukotiloissa, jotka ateriaurakoitsija toimittaa. |

Huomasimme kuitenkin, että RAG ei anna selkeitä ja tarkkoja vastauksia tarkempiin ja erittäin teknisiin kysymyksiin, kuten ohjeisiin, numeroihin ja lukuihin. Kuten seuraavassa esimerkissä näkyy, kun teknisen ulottuvuuden tulos on odotettavissa, RAG ei voi antaa tarkkaa vastausta pääasiassa siksi, että upotus- ja hakuprosessi ei voi palauttaa tiivistä kontekstia.

| Kysymys | Mikä on lattiakorkeusvaatimus P2 First Floor -tason betonille? |

| Odotettu vastaus | 7,50 m AFFL |

| RAG-vastaus (GPT-J-6B upotus Flan-T5-XXL:n kanssa) | P2 Ensimmäinen kerros Betoni |

Tätä on parannettava, koska hallusinaatioita ei suvaita seurausten kriittisyyden vuoksi tässä käyttötapauksessa.

Hienosäädä LLM:itä SageMakerissa

Vastataksemme tähän haasteeseen ja parantaaksemme vastausten laatua otamme uuden lähestymistavan hienosäätääksemme LLM-mallia käyttämällä asiakirjoja kysymykseen vastaustehtävää varten. Malli koulutetaan oppimaan vastaavat tiedot suoraan asiakirjoista. Toisin kuin RAG, se ei riipu siitä, onko asiakirjat upotettu ja indeksoitu oikein ja onko semanttinen hakualgoritmi riittävän tehokas palauttamaan vektoritietokannan olennaisimmat sisällöt.

Valmistellaksemme harjoitustietojoukon hienosäätöä varten poimimme tiedot D&C-asiakirjoista ja rakennamme tiedot seuraavassa muodossa:

- Ohje – Kuvaa tehtävän ja antaa osittaisen kehotteen

- panos – Tarjoaa lisäkontekstia, joka yhdistetään kehotteeseen

- Vastaus – Mallin tulos

Koulutusprosessin aikana lisäämme jokaiseen osaan ohjeavaimen, syöttöavaimen ja vastausavaimen, yhdistämme ne koulutuskehotteeksi ja tokenisimme sen. Sitten tiedot syötetään SageMakerin kouluttajalle hienosäädetyn mallin luomiseksi.

Käytimme koulutusprosessin nopeuttamiseksi ja laskentaresurssien kustannusten vähentämiseksi Parametri Tehokas hienosäätö (PEFT) kanssa Matala-arvoinen sopeutuminen (LoRA) tekniikkaa. PEFT antaa meille mahdollisuuden hienosäätää vain pientä määrää ylimääräisiä malliparametreja, ja LoRA edustaa painopäivitykset kahdella pienemmällä matriisilla matalan arvoisen hajotuksen avulla. PEFT:n ja LoRA:n avulla 8-bittisessä kvantisoinnissa (pakkaustoiminto, joka vähentää mallin muistia entisestään ja nopeuttaa harjoittelua ja päättelyn suorituskykyä), voimme sovittaa 125 kysymys-vastaus-parin koulutuksen g4dn.x-ilmentymään. yhdellä GPU:lla.

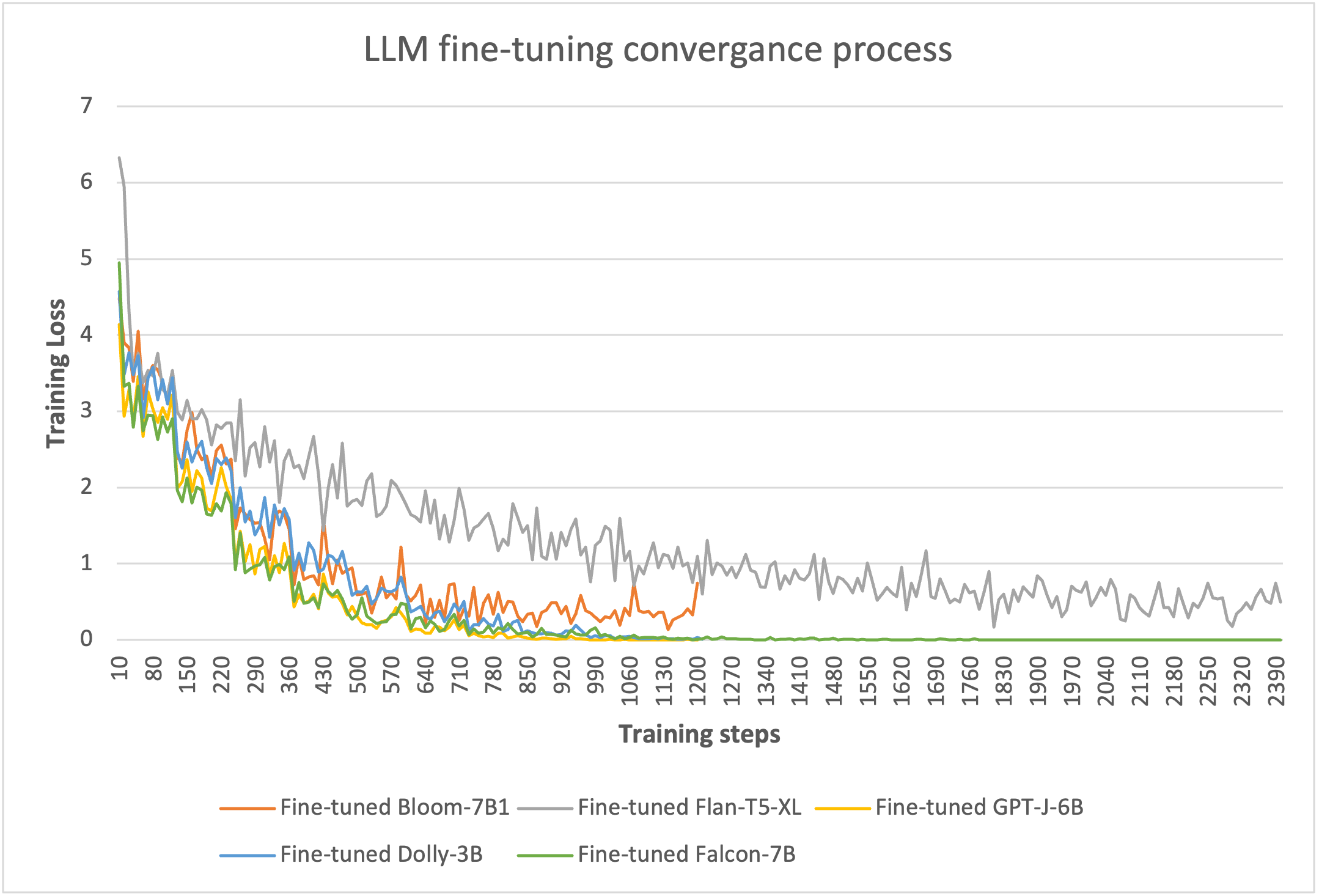

Todistaaksemme hienosäädön tehokkuuden testasimme useiden LLM:ien kanssa SageMakerissa. Valitsimme viisi pientä mallia: Bloom-7B, Flan-T5-XL, GPT-J-6B ja Falcon-7B SageMaker JumpStartista sekä Dolly-3B. Halaaminen kasvot SageMakerissa.

8-bittisen LoRA-pohjaisen koulutuksen avulla pystymme vähentämään koulutettavat parametrit enintään 5 prosenttiin kunkin mallin kokonaispainosta. Harjoittelussa kuluu 10–20 jaksoa konvergoimaan, kuten seuraavasta kuvasta näkyy. Jokaisen mallin hienosäätöprosessit mahtuvat yhteen g4dn.x-esiintymän GPU:hun, mikä optimoi laskentaresurssien kustannukset.

Tee johtopäätös SageMakerissa käyttöön otetusta hienosäädetystä mallista

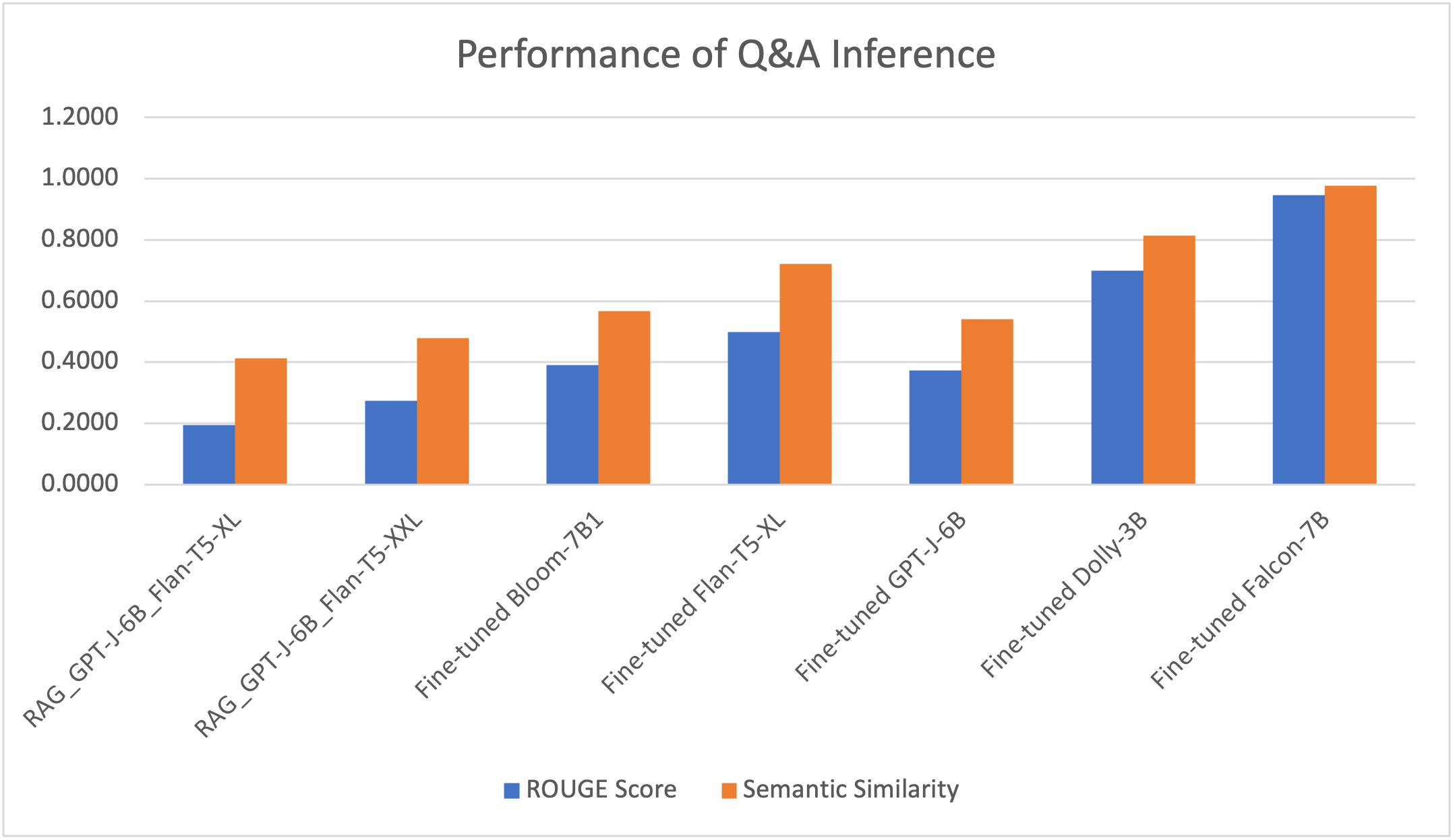

Otimme käyttöön hienosäädetyn mallin yhdessä RAG-kehyksen kanssa yhdessä GPU g4dn.x -solmussa SageMakerissa ja vertailimme 125 kysymyksen päättelytuloksia. Mallin suorituskykyä mitataan kahdella mittarilla. Yksi on RED (Recall-Oriented Understudy for Gisting Evaluation) pisteet, suosittu luonnollinen kielenkäsittely (NLP) mallin arviointimenetelmä, joka laskee osuvien sanojen osamäärän viitelauseen sanojen kokonaismäärästä. Toinen on semanttinen (tekstuaalinen) samankaltaisuus pistemäärä, joka mittaa, kuinka lähellä kahden tekstin merkityksen merkitys on, käyttämällä muuntajamallia lauseiden koodaamiseen saadakseen niiden upotukset ja käyttämällä sitten kosinin samankaltaisuusmetriikkaa niiden samankaltaisuuspisteiden laskemiseen. Kokeiden perusteella voimme nähdä, että nämä kaksi mittaria ovat melko johdonmukaisia esittäessään vastausten laatua kysymyksiin.

Seuraavasta taulukosta ja kuvasta nähdään, että hienosäädetty Falcon-7B-malli tarjoaa parhaan vastauslaadun, ja mallit Flan-T5-XL ja Dolly-3B tuottavat myös tarkkoja vastauksia.

| . | RAG_GPT-J-6B_Flan-T5-XL | RAG_GPT-J-6B_Flan-T5-XXL | Hienosäädetty Bloom-7B1 | Hienosäädetty Flan-T5-XL | Hienosäädetty GPT-J-6B | Hienosäädetty Dolly-3B | Hienosäädetty Falcon-7B |

| ROUGE Pisteet | 0.1938 | 0.2747 | 0.3914 | 0.4977 | 0.3740 | 0.6991 | 0.9459 |

| Semanttinen samankaltaisuuspisteet | 0.4121 | 0.4786 | 0.5666 | 0.7205 | 0.5414 | 0.8147 | 0.9774 |

Seuraavassa on yksi esimerkkivastaus malleista. RAG Flan-T5-XL-mallilla antoi erittäin hallusinoituneen vastauksen, kun taas RAG:n vastaus suuremmalla Flan-T5-XXL-mallilla oli merkityksellisempi, mutta ei silti kyennyt peittämään koko odotettua viestiä. Vertailun vuoksi kaikki hienosäädetyt mallit (Flan-T5-XL, Dolly-3B ja Falcon-7B) pystyivät antamaan odotetun vastauksen tarkimman vastauksen.

| Kysymys | Mitkä ovat jälkihiontatiivisteen/kovettimen vaatimukset? (TS0004 – osio 2.8) |

| Odotettu vastaus | Litiumpohjaista saumausainetta/kovetinta käytetään kaikkien AR-lattialla suoritettujen hionta-/hiontatoimenpiteiden jälkeen. Katso TGC /0007 AR Floor SCA -menettelyt. Vaihtoehtoja harkitaan, mutta Amazonin ja lattiakonsultin on hyväksyttävä ne. |

| Vastaus henkilöltä RAG (GPT-J-6B upotus Flan-T5-XL:n kanssa) | Läpäisevästä betonin kovettimesta on keskusteltava kaatamista edeltävässä kokouksessa, ja lattiakonsultin ja Amazonin on hyväksyttävä se |

| Vastaus henkilöltä RAG (GPT-J-6B upotus Flan-T5-XXL:n kanssa) | Ehdotetusta yhdisteestä on keskusteltava kaatamista edeltävässä kokouksessa, ja lattiakonsultin ja Amazonin on hyväksyttävä se. Vaihtoehtoja harkitaan, mutta Amazonin ja lattiakonsultin on hyväksyttävä ne. |

| Vastaus hienosäädetystä Flan-T5-XL:stä | Litiumpohjaista saumausainetta/kovetinta käytetään kaikkien AR-lattialla suoritettujen hionta-/hiontatoimenpiteiden jälkeen. Katso TGC /0007 AR Floor SCA -menettelyt. Vaihtoehtoja harkitaan, mutta Amazonin ja lattiakonsultin on hyväksyttävä ne. |

| Vastaus hienosäädetyltä Dolly-3B:ltä | Litiumpohjaista saumausainetta/kovetinta käytetään kaikkien AR-lattialla suoritettujen hionta-/hiontatoimenpiteiden jälkeen. Katso TGC /0007 AR Floor SCA -menettelyt. Vaihtoehtoja harkitaan, mutta Amazonin ja lattiakonsultin on hyväksyttävä ne. |

| Vastaus henkilöltä hienosäädetyt Falcon-7B | Litiumpohjaista saumausainetta/kovetinta käytetään kaikkien AR-lattialla suoritettujen hionta-/hiontatoimenpiteiden jälkeen. Katso TGC /0007 AR Floor SCA -menettelyt. Vaihtoehtoja harkitaan, mutta Amazonin ja lattiakonsultin on hyväksyttävä ne. |

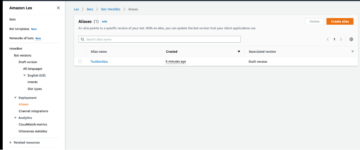

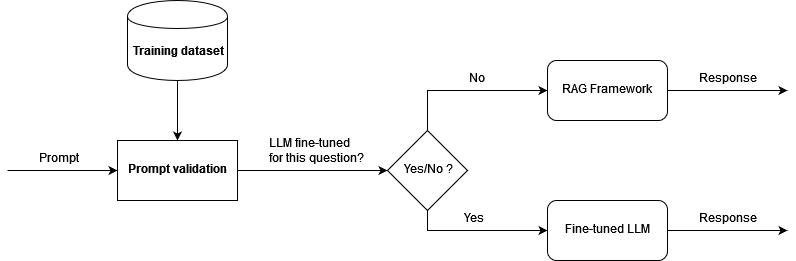

Ratkaisun prototyyppi ja lopputulos

Kehitimme esitellyn arkkitehtuurin pohjalta prototyypin ja suoritimme konseptin todisteen lopputuloksen havainnollistamiseksi. Hyödyntääksemme sekä RAG-kehystä että hienosäädettyä LLM:ää ja myös vähentääksemme hallusinaatioita, vahvistamme ensin tulevan kysymyksen semanttisesti. Jos kysymys on hienosäädön harjoitustietojen joukossa (hienoviritetyllä mallilla on jo tieto korkealaatuisen vastauksen antamiseen), ohjaamme kysymyksen kehotteena päätellä hienosäädetty malli. Muussa tapauksessa kysymys menee LangChainin kautta ja saa vastauksen RAG:lta. Seuraava kaavio havainnollistaa tätä työnkulkua.

Testasimme arkkitehtuuria 166 kysymyksen testitietojoukolla, joka sisältää 125 kysymystä, joita käytettiin mallin hienosäätämiseen, ja 41 lisäkysymystä, joiden kanssa hienosäädettyä mallia ei koulutettu. RAG-kehys upotusmallin ja hienosäädetyn Falcon-7B-mallin kanssa tarjosi korkealaatuisia tuloksia ROUGE-pisteillä 0.7898 ja semanttisella samankaltaisuuspisteellä 0.8781. Kuten seuraavissa esimerkeissä näkyy, kehys pystyy luomaan vastauksia käyttäjien kysymyksiin, jotka sopivat hyvin D&C-asiakirjoihin.

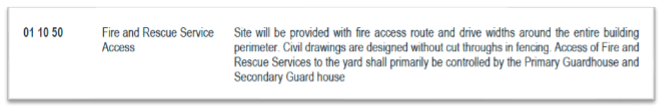

Seuraava kuva on ensimmäinen esimerkkidokumenttimme.

Seuraavassa kuvakaappauksessa näkyy botin tulos.

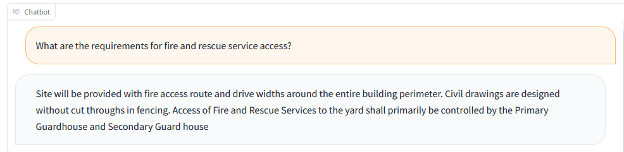

Botti pystyy myös vastaamaan taulukon tai luettelon tiedoilla ja näyttämään lukuja vastaaviin kysymyksiin. Käytämme esimerkiksi seuraavaa asiakirjaa.

Seuraavassa kuvakaappauksessa näkyy botin tulos.

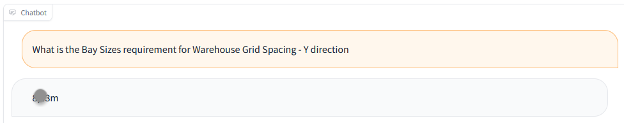

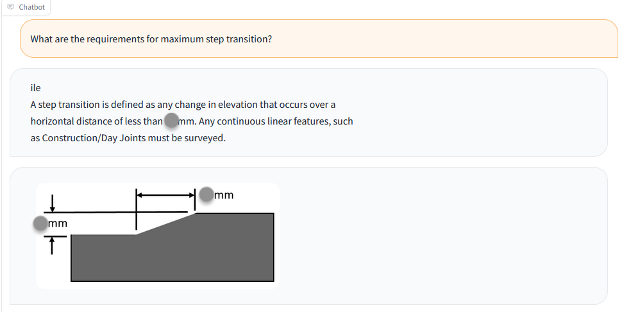

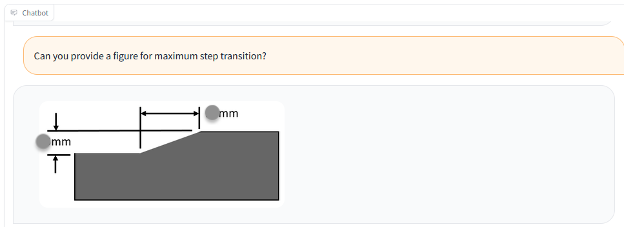

Voimme käyttää myös asiakirjaa, jossa on kuva, kuten seuraavassa esimerkissä.

Seuraavassa kuvakaappauksessa näkyy botin tulos tekstin ja kuvan kanssa.

Seuraavassa kuvakaappauksessa näkyy botin tulos vain kuvalla.

Opitut opetukset ja parhaat käytännöt

Ratkaisusuunnittelun ja useiden LLM-yritysten kanssa tehtyjen kokeilujen avulla opimme varmistamaan laadun ja suorituskyvyn kysymysvastaustehtävälle generatiivisessa tekoälyratkaisussa. Suosittelemme seuraavia parhaita käytäntöjä, kun käytät ratkaisua kysymykseesi vastaamalla käyttötapauksiin:

- RAG tarjoaa järkeviä vastauksia teknisiin kysymyksiin. Suorituskyky riippuu suuresti asiakirjan upottamisesta ja indeksoinnista. Erittäin jäsentelemättömien asiakirjojen kohdalla saatat tarvita manuaalista työtä asiakirjojen oikein jakamiseksi ja lisäämiseksi ennen LLM-upotusta ja indeksointia.

- Hakemistohaku on tärkeä RAG:n lopullisen lähdön määrittämiseksi. Sinun tulee virittää hakualgoritmi oikein saavuttaaksesi hyvän tarkkuustason ja varmistaaksesi, että RAG tuottaa osuvampia vastauksia.

- Hienosäädetyt LLM:t pystyvät oppimaan lisätietoa erittäin teknisistä ja jäsentelemättömistä asiakirjoista, ja heillä on mallin tiedot ilman riippuvuutta asiakirjoista koulutuksen jälkeen. Tämä on erityisen hyödyllistä käyttötapauksissa, joissa hallusinaatioita ei siedä.

- Mallin vasteen laadun varmistamiseksi hienosäädön opetustietojoukon muodon tulisi käyttää oikein määriteltyä tehtäväkohtaista kehotemallia. Päätelmäputken tulee noudattaa samaa mallia, jotta se voi tuottaa ihmisen kaltaisia vastauksia.

- LLM:illä on usein huomattava hintalappu ja ne vaativat huomattavia resursseja ja kohtuuttomia kustannuksia. Voit käyttää PEFT- ja LoRA- ja kvantisointitekniikoita vähentääksesi laskentatehon tarvetta ja välttääksesi korkeat koulutus- ja päättelykustannukset.

- SageMaker JumpStart tarjoaa helposti käytettävät valmiiksi koulutetut LLM:t hienosäätöä, päätelmiä ja käyttöönottoa varten. Se voi merkittävästi nopeuttaa generatiivisen AI-ratkaisusi suunnittelua ja toteutusta.

Yhteenveto

RAG-kehyksen ja SageMakerin hienosäädetyillä LLM:illä pystymme tarjoamaan inhimillisiä vastauksia käyttäjien kysymyksiin ja kehotteisiin, jolloin käyttäjät voivat tehokkaasti hakea tarkkoja tietoja suuresta määrästä erittäin jäsentelemättömiä ja järjestäytymättömiä asiakirjoja. Jatkamme ratkaisun kehittämistä, kuten tarjoamalla korkeamman tason kontekstuaalista vastetta aikaisemmista vuorovaikutuksista ja hienosäätämällä malleja edelleen ihmisten palautteen perusteella.

Palautteesi on aina tervetullutta; jätä ajatuksesi ja kysymyksesi kommenttiosioon.

Tietoja kirjoittajista

Yunfei Bai on AWS:n vanhempi ratkaisuarkkitehti. Tekoälyn/ML:n, datatieteen ja analytiikan taustalla oleva Yunfei auttaa asiakkaita ottamaan käyttöön AWS-palvelut liiketulosten saavuttamiseksi. Hän suunnittelee AI/ML- ja data-analytiikkaratkaisuja, jotka selviytyvät monimutkaisista teknisistä haasteista ja ohjaavat strategisia tavoitteita. Yunfei on elektroniikka- ja sähkötekniikan tohtori. Työn ulkopuolella Yunfei pitää lukemisesta ja musiikista.

Yunfei Bai on AWS:n vanhempi ratkaisuarkkitehti. Tekoälyn/ML:n, datatieteen ja analytiikan taustalla oleva Yunfei auttaa asiakkaita ottamaan käyttöön AWS-palvelut liiketulosten saavuttamiseksi. Hän suunnittelee AI/ML- ja data-analytiikkaratkaisuja, jotka selviytyvät monimutkaisista teknisistä haasteista ja ohjaavat strategisia tavoitteita. Yunfei on elektroniikka- ja sähkötekniikan tohtori. Työn ulkopuolella Yunfei pitää lukemisesta ja musiikista.

Burak Gozluklu on ML Specialist Solutions -arkkitehti, joka sijaitsee Bostonissa, MA. Burakilla on yli 15 vuoden kokemus simulaatiomallinnuksesta, datatieteestä ja ML-tekniikasta. Hän auttaa globaaleja asiakkaita ottamaan käyttöön AWS-teknologioita ja erityisesti AI/ML-ratkaisuja saavuttaakseen liiketoimintatavoitteensa. Burakilla on tohtorintutkinto ilmailutekniikasta METU:sta, MS-tutkinto järjestelmätekniikasta ja post-doc järjestelmädynamiikasta MIT:stä Cambridgessa, MA. Burak on intohimoinen joogasta ja meditaatiosta.

Burak Gozluklu on ML Specialist Solutions -arkkitehti, joka sijaitsee Bostonissa, MA. Burakilla on yli 15 vuoden kokemus simulaatiomallinnuksesta, datatieteestä ja ML-tekniikasta. Hän auttaa globaaleja asiakkaita ottamaan käyttöön AWS-teknologioita ja erityisesti AI/ML-ratkaisuja saavuttaakseen liiketoimintatavoitteensa. Burakilla on tohtorintutkinto ilmailutekniikasta METU:sta, MS-tutkinto järjestelmätekniikasta ja post-doc järjestelmädynamiikasta MIT:stä Cambridgessa, MA. Burak on intohimoinen joogasta ja meditaatiosta.

Elad Dwek on Amazonin rakennusteknologiapäällikkö. Rakentamisen ja projektinhallinnan taustalla oleva Elad auttaa tiimejä ottamaan käyttöön uusia teknologioita ja tietopohjaisia prosesseja rakennusprojektien toteuttamisessa. Hän tunnistaa tarpeet ja ratkaisut sekä helpottaa räätälöityjen ominaisuuksien kehittämistä. Eladilla on MBA- ja BSc-tutkinto rakennetekniikasta. Työn ulkopuolella Elad nauttii joogasta, puuntyöstyksestä ja matkustamisesta perheensä kanssa.

Elad Dwek on Amazonin rakennusteknologiapäällikkö. Rakentamisen ja projektinhallinnan taustalla oleva Elad auttaa tiimejä ottamaan käyttöön uusia teknologioita ja tietopohjaisia prosesseja rakennusprojektien toteuttamisessa. Hän tunnistaa tarpeet ja ratkaisut sekä helpottaa räätälöityjen ominaisuuksien kehittämistä. Eladilla on MBA- ja BSc-tutkinto rakennetekniikasta. Työn ulkopuolella Elad nauttii joogasta, puuntyöstyksestä ja matkustamisesta perheensä kanssa.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/a-generative-ai-powered-solution-on-amazon-sagemaker-to-help-amazon-eu-design-and-construction/

- :on

- :On

- :ei

- :missä

- 1

- 100

- 125

- 15 vuotta

- 15%

- 152

- 17

- 22

- 41

- 50

- 7

- 8

- 80

- 9

- a

- pystyy

- Meistä

- kiihdyttää

- kiihdyttää

- pääsy

- mukaisesti

- tarkkuus

- tarkka

- Saavuttaa

- poikki

- mukautuu

- lisätä

- lisää

- lisä-

- osoite

- osoitettu

- vierekkäinen

- hyväksyä

- edistää

- Etu

- Aerospace

- ilmailualan tekniikka

- Jälkeen

- sovittu

- AI

- AI-käyttöinen

- AI / ML

- algoritmi

- Kaikki

- mahdollistaa

- yksin

- pitkin

- jo

- Myös

- vaihtoehdot

- aina

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- keskuudessa

- an

- analyysi

- Analytics

- ja

- vastaus

- vastauksia

- Kaikki

- sovelletaan

- sovellukset

- käyttää

- lähestymistapa

- hyväksytty

- AR

- arkkitehtuuri

- OVAT

- AS

- At

- attribuutteja

- täydennetty

- välttää

- AWS

- tausta

- baarit

- pohja

- perustua

- Lähtötilanne

- BE

- koska

- ennen

- hyödyttää

- tilaustyönä

- PARAS

- parhaat käytännöt

- Paremmin

- välillä

- Tukkia

- boston

- Bot

- sekä

- Tauko

- laajempaa

- BSC

- rakentaa

- liiketoiminta

- mutta

- by

- laskee

- Cambridge

- CAN

- kaapata

- tapaus

- tapauksissa

- keskeinen

- ketju

- haaste

- haasteet

- Luku

- chatbot

- Tarkastukset

- selkeä

- lähellä

- klustereiden

- yhdistää

- yhdistää

- Tulla

- kommentit

- verrattain

- verrata

- verrattuna

- monimutkainen

- noudattaminen

- osat

- Yhdiste

- Sisältää

- Laskea

- käsite

- suppea

- tehty

- Seuraukset

- huomattava

- harkittu

- johdonmukainen

- muodostuu

- rakentaa

- rakentamalla

- rakentaminen

- konsultti

- sisältää

- sisältö

- tausta

- asiayhteyteen

- jatkaa

- Urakoitsija

- kontrasti

- suppenee

- Ydin

- vastaava

- Hinta

- kustannukset

- kattaa

- luoda

- luo

- TERÄVÄ

- kriittinen

- kriittisyys

- Asiakkaat

- tiedot

- Data Analytics

- tietojenkäsittely

- tietokanta

- määritelty

- toimittaa

- Kysyntä

- osoittaa

- tiheä

- riippuvuus

- riippuvainen

- käyttöön

- käyttöönotto

- Malli

- suunnittelu

- mallit

- Määrittää

- kehittää

- kehitetty

- Kehittäjä

- kehittämällä

- Kehitys

- eri

- Ulottuvuus

- ohjata

- suoraan

- pohtia

- keskusteltiin

- näyttö

- asiakirja

- asiakirjat

- ei

- ajaa

- kaksi

- dynamiikka

- kukin

- Tehokas

- tehokkuuden

- tehokas

- tehokkaasti

- Sähkötekniikka

- Elektroninen

- upotettu

- upottamisen

- Työllisiä

- mahdollistaa

- mahdollistaa

- kihloissa

- Tekniikka

- tarpeeksi

- varmistaa

- Koko

- sisäänkäynti

- aikakausia

- Vastaava

- erityisesti

- Eetteri (ETH)

- EU

- Eurooppa

- arviointi

- esimerkki

- Esimerkit

- kunnostautua

- olemassa

- odotettu

- experience

- kokeiluja

- asiantuntijat

- lisää

- uute

- Helpottaa

- Laitos

- melko

- perhe

- Fed

- palaute

- Kuva

- luvut

- Asiakirjat

- lopullinen

- Löytää

- Etunimi

- sovittaa

- viisi

- Lattia

- seurata

- jälkeen

- Jalanjälki

- varten

- muoto

- formaatit

- perusta

- Puitteet

- alkaen

- koko

- edelleen

- tulevaisuutta

- tuottaa

- synnyttää

- generatiivinen

- Generatiivinen AI

- saada

- Global

- Goes

- hyvä

- GPU

- hionta

- suuntaviivat

- he

- raskaasti

- korkeudet

- auttaa

- auttaa

- Korkea

- korkealaatuisia

- korkeampi

- erittäin

- hänen

- Miten

- Miten

- HTML

- HTTPS

- ihmisen

- luettavaan

- tunnistaa

- if

- havainnollistaa

- kuva

- kuvien

- heti

- täytäntöönpano

- täytäntöön

- täytäntöönpanosta

- tärkeä

- parantaa

- parani

- in

- sisältää

- Saapuva

- itsenäisesti

- indeksi

- indeksoitu

- indeksit

- teollisuus

- tiedot

- panos

- asennus

- esimerkki

- integraatio

- vuorovaikutukset

- tulee

- aiheuttaa

- osallistuva

- IT

- jpg

- vain

- avain

- tuntemus

- Kieli

- suuri

- suurempi

- OPPIA

- oppinut

- jättää

- vähemmän

- Lessons

- Lessons Learned

- Taso

- elinkaari

- rajallinen

- Lista

- Listat

- litium

- elää

- sijaitsevat

- sijainti

- näköinen

- pääasiallisesti

- johto

- johtaja

- manuaalinen

- ruumiillinen työ

- monet

- ottelu

- Hyväksytty

- matching

- asia

- Saattaa..

- MBA

- merkitys

- merkityksiä

- mitattu

- toimenpiteet

- Meditaatio

- kokous

- Muisti

- MENA

- MENA-alue

- viesti

- menetelmä

- menetelmiä

- metrinen

- Metrics

- minimi

- MIT

- ML

- malli

- mallintaminen

- mallit

- lisää

- eniten

- MS

- moninkertainen

- Musiikki

- täytyy

- Tarve

- tarpeet

- Uusi

- Uudet teknologiat

- seuraava

- NLP

- Nro

- solmu

- etenkin

- numero

- numerot

- tavoitteet

- Havaittu

- of

- usein

- on

- ONE

- vain

- avoimen lähdekoodin

- toiminta

- optimoitu

- or

- tilata

- Muut

- muuten

- meidän

- Tulos

- ulostulo

- ulkopuolella

- yli

- Voittaa

- sivut

- paria

- parametrit

- osa

- kulkee

- intohimoinen

- suorituskyky

- suoritettu

- phd

- kappaletta

- putki

- sijoitus

- Platon

- Platonin tietotieto

- PlatonData

- Ole hyvä

- Putkityöt

- pistettä

- Suosittu

- omistaa

- Kirje

- teho

- powered

- valtuudet

- käytännöt

- pre

- Valmistella

- esittää

- esitetty

- edellinen

- hinta

- Pääasiallinen

- Aikaisempi

- menettelyt

- jatkaa

- prosessi

- Prosessit

- projekti

- Projektinhallinta

- hankkeet

- todiste

- todiste käsitteestä

- asianmukaisesti

- ehdotukset

- ehdotettu

- prototyyppi

- todistaa

- toimittaa

- mikäli

- tarjoaa

- tarjoamalla

- laatu

- kyselyt

- kysymys

- kysymykset

- nopea

- nopeasti

- osamäärä

- alue

- Lukeminen

- todellinen maailma

- kohtuullinen

- suositella

- vähentää

- vähentää

- katso

- viite

- suhteen

- alue

- merkityksellinen

- kaukosäädin

- Raportit

- edustaa

- pyynnöt

- tarvitaan

- vaatimus

- vaatimukset

- resurssi

- Esittelymateriaalit

- Vastata

- vastaus

- vasteet

- tulokset

- palata

- arviot

- oikein

- Huone

- Huoneet

- sagemaker

- sama

- tiede

- laajuus

- pisteet

- Haku

- haut

- haku

- Osa

- osiot

- nähdä

- valittu

- vanhempi

- tuomita

- palvelu

- Palvelut

- palvelevat

- shouldnt

- esitetty

- Näytä

- merkittävä

- merkittävästi

- Yksinkertainen

- simulointi

- single

- pieni

- pienempiä

- Pk-yritysten

- ratkaisu

- Ratkaisumme

- jonkin verran

- Tila

- asiantuntija

- erikoistunut

- erityinen

- erityisesti

- tekniset tiedot

- jakaa

- sidosryhmien

- standardi

- Askeleet

- Yhä

- Levytila

- tallennettu

- Strateginen

- virtaviivaistaminen

- rakenteellinen

- rakenne

- aihe

- merkittävä

- niin

- järjestelmä

- järjestelmät

- taulukko

- TAG

- ottaa

- vie

- Tehtävä

- joukkue-

- tiimit

- Tekninen

- tekniikat

- Technologies

- Elektroniikka

- sapluuna

- testi

- testattu

- teksti

- teksti-

- kuin

- että

- -

- Tulevaisuus

- tiedot

- heidän

- Niitä

- sitten

- siten

- siksi

- Nämä

- ne

- tätä

- Kautta

- kauttaaltaan

- että

- tänään

- WC

- merkitä

- siedetty

- ylin

- Yhteensä

- koulutettu

- koulutus

- muuntaja

- Matkustaminen

- kaksi

- tyypit

- ui

- varten

- yksiköt

- toisin kuin

- Päivitykset

- us

- käyttää

- käyttölaukku

- käytetty

- hyödyllinen

- käyttäjä

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- käyttää

- VAHVISTA

- validointi

- arvo

- arvot

- eri

- tilavuus

- Seinä

- Varasto

- oli

- vesi

- we

- verkko

- verkkopalvelut

- paino

- tervetuloa

- HYVIN

- olivat

- kun

- taas

- onko

- joka

- KUKA

- leveä

- Laaja valikoima

- wikipedia

- tulee

- with

- sisällä

- sanoja

- Referenssit

- työnkulku

- toimii

- X

- vuotta

- Jooga

- te

- Sinun

- zephyrnet